1.總結

GR-3 是一個大規模的視覺 - 語言 - 動作(VLA)模型。它對新物體、新環境以及含抽象概念的新指令展現出較好的泛化能力。此外,GR-3 支持少量人類軌跡數據的高效微調,可快速且經濟地適應新任務。GR-3 在處理長周期和靈巧性任務(包括需要雙手操作和底盤移動的任務)上也展現出穩健且可靠的性能。

這些能力源自—種多樣的訓練方法,具體包括:利用大規模的視覺 - 語言數據聯合訓練、負責實驗室采集的同學基于 VR 設備構建了人類軌跡數據進行有效地模仿學習。此外,我們還推出了一款雙臂移動機器人 ByteMini。ByteMini 兼具靈巧性和可靠性,集成了 GR-3 后,能完成各式各樣的復雜任務。

本報告介紹 GR-3——一種大規模視覺-語言-動作模型,具備以下特性: ?

- 嚴格遵循語言指令,并對新穎物體、環境及指令具有良好泛化能力; ?

- 僅需少量人類軌跡即可高效微調,實現快速場景遷移; ?

- 在長跨度、靈巧任務中保持高魯棒性與高可靠性。 ?

技術報告:字節跳動Seed

-

-

2. 簡介

打造能夠協助人類完成日常任務的智能通用機器人,是機器人研究中長期追求的愿景。真正的難題在于現實世界的巨大多樣性:機器人策略必須具備強大的泛化能力,才能應對層出不窮的新場景。此外,許多日常任務天然具有長跨度、高復雜度的靈巧操作要求,這對策略的魯棒性與可靠性提出了極高標準。

GR-3 以自然語言指令、環境觀測和機器人狀態為輸入,端到端輸出動作序列,控制雙臂移動機器人。模型基于預訓練 VLM,并通過流匹配預測動作。作者對網絡架構進行了系統研究,提出一系列關鍵設計,顯著提升了指令跟隨與長跨度任務表現。為強化泛化能力,作者將機器人軌跡數據與覆蓋多種視覺-語言任務的大規模數據協同訓練,使 GR-3 不僅能處理全新類別的物體,還可理解尺寸、空間關系、常識知識等在機器人數據中缺失的抽象概念。

此外,GR-3 僅需通過 VR 設備收集的少量人類軌跡即可高效微調,實現低成本快速適配。作者同步推出 ByteMini——一款靈活可靠的雙臂移動機器人,與 GR-3 結合后可在現實世界中完成多樣復雜任務。

在三大挑戰性場景的廣泛實驗中——可泛化抓取放置、長跨度桌面整理、靈巧布料操作——GR-3 全面超越當前最佳基線 π0。它對新類別物體和復雜語義展現優異泛化能力,僅用每條物體 10 條人類軌跡即可快速適配新物體;在長跨度與靈巧任務中亦表現穩健,桌面整理與布料操作均取得高平均任務進度。作者期望 GR-3 成為邁向日常生活通用機器人的關鍵一步。

-

-

3.模型結構

GR-3 是一個端到端的視覺-語言-動作(VLA)模型 πθ,用于控制帶有移動底盤的雙臂機器人。模型以自然語言指令 l、當前觀測 和機器人狀態

為條件,一次性生成長度為 k 的動作片段

,即

。

GR-3 采用混合 Transformer 架構。

- 首先,作者使用預訓練的視覺-語言模型 Qwen2.5-VL-3B-Instruct 處理來自多臺攝像頭的圖像觀測與語言指令;

- 隨后,由動作擴散 Transformer(DiT)預測動作片段。具體而言,GR-3 利用流匹配實現動作預測:流估計以當前機器人狀態 st 以及 VLM 主干輸出的 KV 緩存為條件。

?- 長度為 k 的動作片段被表示為 k 個 token,并與機器人狀態 token 拼接,構成動作 DiT 的輸入序列。

? - 流匹配的時間步通過自適應層歸一化(AdaLN)注入。為了建模動作片段內部的時間依賴,動作 DiT 使用因果注意力掩碼。

- 長度為 k 的動作片段被表示為 k 個 token,并與機器人狀態 token 拼接,構成動作 DiT 的輸入序列。

為保證推理速度,動作 DiT 的層數僅為 VLM 主干的一半,且僅復用主干后一半層級的 KV 緩存。整體模型參數量為 4 B。

在初期實驗中,作者觀察到訓練過程經常出現不穩定。受 QK Norm 啟發,作者在動作 DiT 的注意力與 FFN 內的線性層后額外引入 RMSNorm。該設計顯著提升了整個訓練的穩定性,并在下游實驗中大幅增強了語言遵循能力,詳見第 5 節。

-

-

4.訓練策略

作者采用多種數據源混合訓練 GR-3:機器人軌跡數據用于模仿學習,網頁級視覺-語言數據用于協同訓練,少量人類軌跡數據用于小樣本泛化。

該訓練方案使 GR-3 能夠 1) 泛化到全新物體、環境與指令,2) 以低成本高效適配未見場景,3) 穩健地完成長跨度與靈巧任務。

4.1 基于機器人軌跡數據的模仿學習

作者采用模仿學習目標來訓練 GR-3,通過最大化策略在一組專家演示 D?上的對數似然:

具體而言,訓練時利用流匹配損失來監督動作預測:

其中 為流匹配時間步,t?表示回合中的時間戳;

為帶噪動作塊,

為隨機噪聲;

為流匹配的真實值。

作者將流匹配標簽用于流預測。為了加速訓練,作者在 VLM 主干的一次前向傳播中,對多個采樣的流匹配時間步同時計算流匹配損失。

-

在推理階段,動作片段初始化為隨機噪聲 ,并用歐拉方法從

積分到

,即?

,實驗中設

。

-

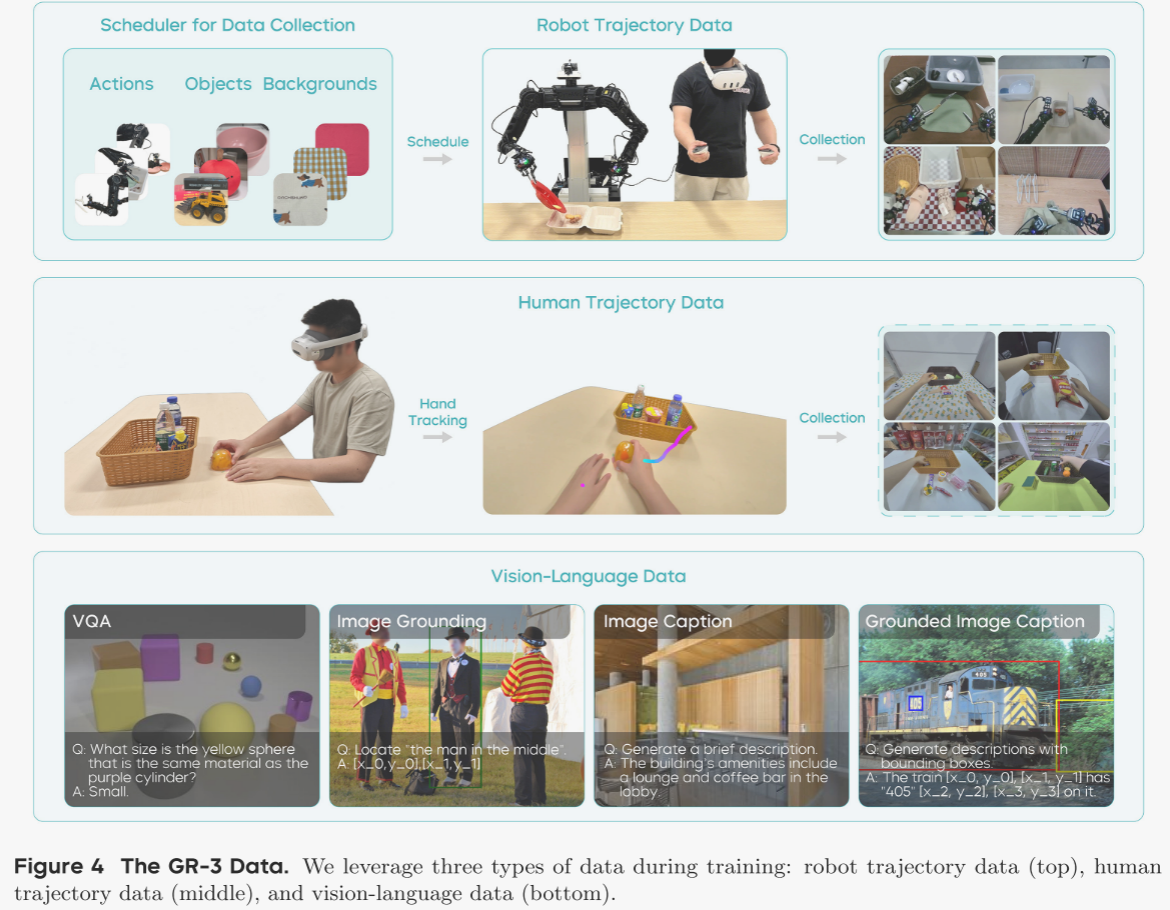

作者通過遙控操作采集真實機器人軌跡。為使采集過程更易控制并最大化數據多樣性,作者開發了一套數據采集調度器(見圖 4),在每次采集開始前向操作員提示:1)需執行的動作,2)物體組合,3)背景設置。系統生成新的配置后,操作員據此布置環境。該調度器的實現幫助作者有效管理整體數據分布,充分隨機化采集數據,極大提升了數據集的豐富性與多樣性。此外,采集后還會進行質量檢查,剔除無效或低質量數據。

先前研究指出,策略可能利用多視角的偽相關來預測動作,而非真正關注語言條件。為緩解這一問題,作者在動作維度中引入“任務狀態”作為輔助監督。任務狀態可取以下值:進行中(0)、已完成(1)、無效(-1)。“進行中”表示機器人正在執行任務;“已完成”表示任務成功結束;“無效”表示當前觀測下指令不可行。例如,桌上沒有刀時,“把刀放進編織籃”即為無效指令。

訓練時,作者隨機將語言指令替換為無效指令,并要求模型僅預測“無效”狀態,而不監督動作片段的其他維度。此設計迫使動作 DiT 必須關注語言指令并判斷任務狀態,顯著提升了語言遵循能力。

-

4.2?協同訓練視覺-語言數據 ?

為使 GR-3 具備遵循分布外(OOD)指令的泛化能力,作者將機器人軌跡數據與視覺-語言數據聯合訓練(見圖 3)。機器人軌跡數據同時訓練 VLM 主干與動作 DiT,采用流匹配損失;視覺-語言數據僅訓練 VLM 主干,使用下一詞預測損失。為簡化實現,作者在 mini-batch 中以等權重動態混合兩類數據,因此協同訓練的總目標為下一詞預測損失與流匹配損失之和。

通過視覺-語言協同訓練,GR-3 能在零樣本情況下有效泛化至未見物體,并理解復雜概念的新穎語義。作者從多個數據源精心構建了一套大規模視覺-語言數據集,涵蓋圖像描述、視覺問答、圖像定位及交錯式圖像描述等任務(見圖 4)。作者還設計了過濾與再標注流水線,以提升數據集質量,確保協同訓練效果。

協同訓練不僅幫助 GR-3 保留了預訓練 VLM 的強視覺-語言能力,還使動作 DiT 能在動作預測中直接利用這些能力,從而顯著提升下游操作任務的泛化表現。

-

4.3小樣本泛化:基于人類軌跡數據 ?

GR-3 作為通用視覺-語言-動作模型,可通過輕量微調迅速適配全新場景。然而,采集真實機器人軌跡既費時又昂貴。近年來,VR 設備與手部追蹤技術的進步為直接從人類軌跡學習動作提供了契機。本報告中,作者將 GR-3 的高效微調能力延伸至更具挑戰性的“極少人類軌跡小樣本學習”場景。

具體而言,面對一個新場景,作者僅需利用 PICO 4 Ultra Enterprise 采集少量人類軌跡。借助 VR,人類軌跡的采集速度可達約 450 條/小時,遠高于遙操作機器人軌跡的 250 條/小時,從而以更低成本實現快速遷移。

采集到的人類軌跡包含第一視角視頻與手部軌跡。作者沿用機器人軌跡的標注流程,為人類軌跡補充語言指令。完成視覺-語言數據與機器人軌跡的第一階段訓練后,作者將人類軌跡納入,并對三類數據共同訓練。

與機器人軌跡不同,人類軌跡僅提供第一視角和手部軌跡,缺少腕部視角、關節狀態與夾爪狀態。對此,作者用空白圖像填充缺失的腕部視角,并僅依據手部軌跡對人類數據進行訓練。

?-

-

5.硬件和系統

5.1 ByteMini機器人

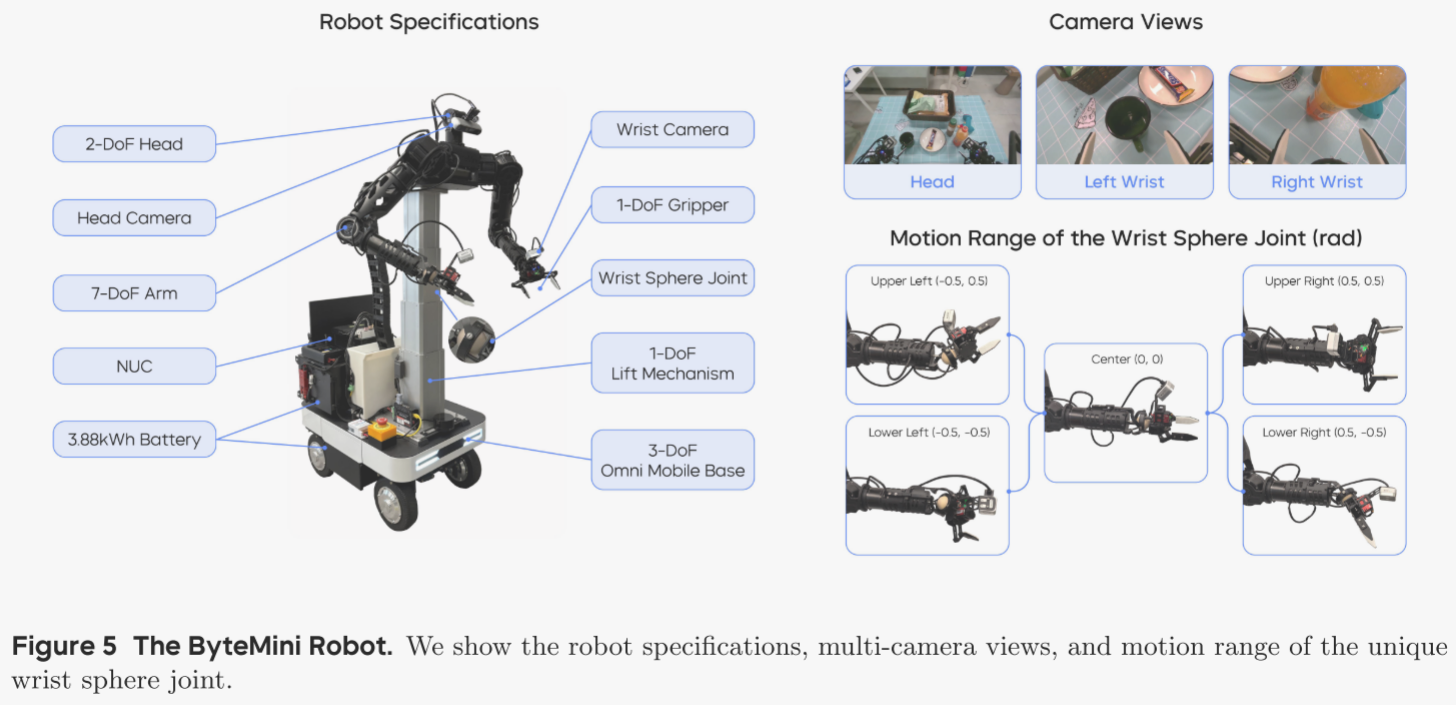

ByteMini 機器人(見圖 5)被用于數據采集與策略部署。這臺 22 自由度的雙臂移動機器人圍繞三大核心目標設計:靈活操作、高可靠性與人機友好。

靈活操作 ?

兩條 7 自由度的機械臂采用無偏置構型,并在腕部引入獨特的球形關節,實現接近人手的靈巧度。緊湊的球形腕部突破了傳統 SRS 構型腕部體積過大、在狹窄空間內操作受限的瓶頸。肘關節經過專門設計,可實現 2.53 rad 的大范圍內收,使雙臂能夠在機器人胸前的有限空間內完成精細作業。

高可靠性 ?

數據采集與策略部署的高負荷運行要求 ByteMini 具備極高的穩定性與一致性。作者采用集成升降機構的萬向移動底盤,確保空間機動與垂直高度調節的平穩可靠。為進一步提升可靠性并保證動作一致性,臂部執行器基于準直驅(QDD)原理設計,兼具高透明度與穩定性。

人機友好 ?

為提升易用性,作者在機器人上集成了便攜屏幕與 NUC 計算單元,并由雙鋰電池供電,在多種場景下可連續運行超過 10 小時。ByteMini 還配備無線急停按鈕,可在緊急情況下迅速切斷動作。頭部與雙腕均安裝 RGB-D 相機,腕部相機可在精細操作時提供近距離視野。

-

5.2 系統與控制 ?

全身柔順控制 ?

作者采用全身柔順控制框架,將所有自由度視作一個整體,把任意遙操作的人體運動重映射為機器人可行運動。可操作度優化、奇異點規避以及關節物理限位被統一納入實時最優控制問題,以最大化機器人的靈巧性。該框架能在廣闊工作空間內為多種長跨度操作任務生成流暢、連續的運動,從而為策略訓練提供高質量的示范軌跡。柔順力控制器支持高動態運動及與環境的物理交互,既提升了安全性,也提高了數據采集效率。

全身遙操作 ?

在遙操作采集階段,作者通過 Meta VR Quest 實現全身重映射,使操作者直觀、友好地將人體動作直接映射到機器人末端執行器。操作者可以同時控制機械臂、升降機構、夾爪和移動底盤,從而在現實世界中為復雜長跨度任務提供無縫的數據采集體驗。

策略部署的軌跡優化 ?

在策略部署階段,作者使用 GR-3 預測的動作片段控制機器人 19 個自由度(不含升降機構與頭部的 3 個自由度)。作者引入純跟蹤算法并結合軌跡優化,以提升 GR-3 生成軌跡的穩定性與平滑度。實時參數化優化最小化加加速度,確保各航點之間以及整條軌跡之間的無縫銜接。

-

-

6. 實驗

作者在真實世界中開展了大量實驗,以全面評估 GR-3 的表現,并圍繞四個核心問題展開: ?

1. GR-3 能否嚴格遵循包括訓練階段未見在內的所有指令? ?

2. GR-3 是否具備泛化到分布外場景(新物體、新環境、新指令)的能力? ?

3. GR-3 能否基于極少的人類軌跡完成小樣本學習,并遷移到機器人本體? ?

4. GR-3 是否能學習到穩健策略,從而勝任長跨度且靈巧的復雜任務? ?

實驗選取三項任務:可泛化抓取-放置、長跨度桌面整理、靈巧布料懸掛。更多視頻演示請見項目主頁。作者將 GR-3 與當前最佳方法 π0 對比,按照 π0 官方 GitHub 倉庫的指引,對其在三大任務上分別進行微調。

6.1 可泛化抓取-放置 ?

為評估 GR-3 在分布外場景的泛化能力,作者設置了聚焦泛化的抓取-放置任務。共采集 3.5 萬條機器人軌跡,涵蓋 101 種物體,總時長 69 小時。軌跡以“將 A 放入 B”形式標注,A 為物體類別,B 為容器。基線模型僅用這些機器人軌跡進行微調;GR-3 則同時用機器人軌跡與視覺-語言數據協同訓練。訓練期間,作者對機器人軌跡圖像施加光度增強,以提升對變化環境的魯棒性。作者還對比了“GR-3 無協同訓練”這一變體,僅用機器人軌跡訓練,以評估協同訓練的具體貢獻。

評估設置 ?

作者在四種場景中進行評測: ?

1) 基礎場景:環境與物體均在訓練中見過,共 54 種物體,用于檢驗基本指令遵循能力。 ?

2) 未見環境:使用與基礎場景相同的 54 種物體,但置于四個訓練時未見的環境(收銀臺、會議室、辦公桌、休息室)中,物體擺放保持一致。 ?

3) 未見指令:給出需要復雜概念理解的指令,如“把左邊的可樂放進紙盒”“把帶觸手的動物放進紙盒”。 ?

4) 未見物體:使用 45 種在機器人軌跡中未出現的新物體。

評測指標 ?

作者采用指令遵循率(IF)與成功率兩個指標。 ?

- 指令遵循率:若機器人正確接近指令指定的物體,則視為成功。 ?

- 成功率:若機器人最終把目標物體放入容器,則視為成功。 ?

兩者得分越高,代表相應能力越強。

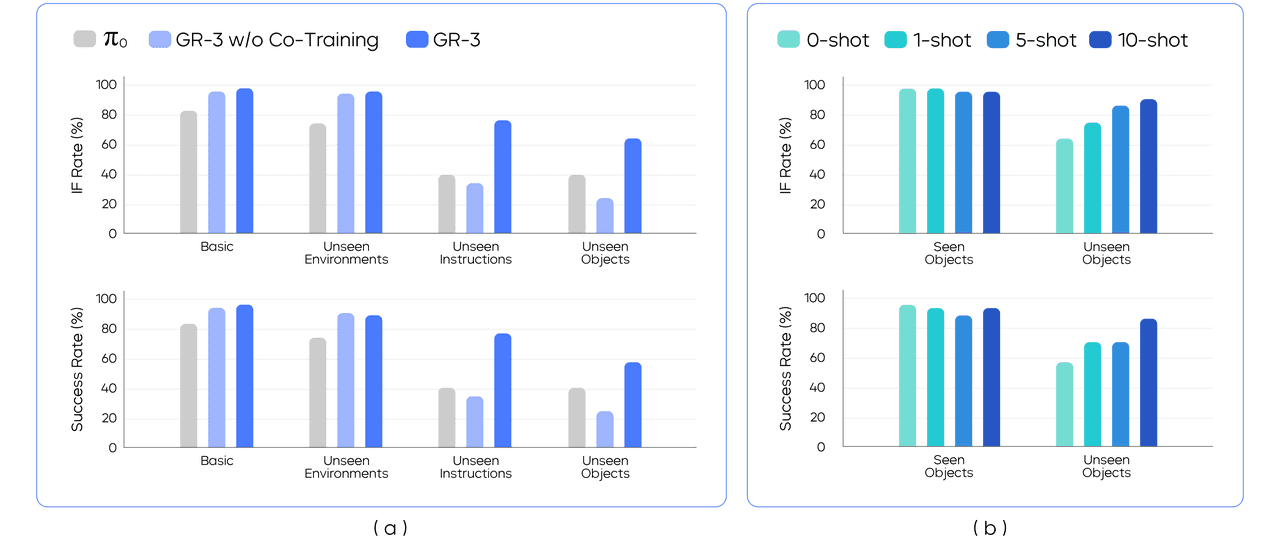

基礎指令遵循 ?

在“基礎”與“未見環境”兩種設定中,作者將 54 個已見物體劃分為 9 個 mini-batch,每批 6 個物體。在每次 rollout 時,依據給定指令讓模型從 6 個候選中挑選 1 個物體。為保證不同模型結果可比,作者使用預捕獲的擺放模板固定物體位置,確保同一 mini-batch 的物體布局在評測期間完全一致。圖 7(a) 顯示,GR-3 在兩種設定下的指令遵循率和成功率均超越 π0;基礎與未見環境間的性能差異很小,表明 GR-3 對環境變化具備魯棒性。此外,GR-3 與“無協同訓練”版本在這兩設定下差異不顯著,說明協同訓練對已知物體表現無負面影響。

可泛化指令遵循 ?

在“未見指令”設定中,作者測試模型對尺寸、空間關系、常識等抽象概念的理解能力。示例指令包括“把可樂旁邊的那罐雪碧放進紙盒”“把最大的物體放進紙盒”“把海洋動物放進紙盒”等,這些指令在機器人軌跡數據中從未出現,需要模型進行復雜語義推理。 ?

在“未見物體”設定中,作者將 45 個未見物體劃分為 9 個 mini-batch,每批 5 個物體,即每次 rollout 需從 5 個候選中選 1 個。該設定尤為苛刻:45 個物體中超過 70 % 屬于訓練時未見的類別。圖 7(a) 顯示,GR-3 在這兩項設定中大幅領先 π0,成功率分別由 40 % 提升至 77.1 %(未見指令)和 57.8 %(未見物體)。與“無協同訓練”版本相比,GR-3 亦顯著提升,表明視覺-語言協同訓練為泛化能力帶來關鍵增益。VLA 模型將大規模視覺-語言知識有效遷移到策略學習,實現對新場景的零樣本泛化。僅使用機器人軌跡訓練的 GR-3 甚至低于 π0 基線,作者推測 π0 的優勢源于其大規模跨本體預訓練。

基于人類軌跡的小樣本泛化 ?

作者進一步利用 VR 采集的人類軌跡評估小樣本泛化能力,挑戰在于:1) 需跨本體學習;2) 數據極度稀缺。具體而言,作者在“未見物體”設定中,為 45 個新物體各采集 10 條以內人類軌跡,總計 450 條,總時長約 30 分鐘。作者以已訓練于機器人軌跡和視覺-語言數據的檢查點為起點,增量訓練 GR-3:在保留原有數據的同時加入人類軌跡,再協同訓練 20 k 步。 ?

作者在 1-shot、5-shot、10-shot 三種小樣本設定下,分別評測已知與未知物體(圖 7(b))。與零樣本基線相比,隨著人類軌跡增多,未見物體的指令遵循率和成功率持續提升;僅 10 條人類軌跡即可將成功率從 57.8 % 提高到 86.7 %。同時,已知物體性能無明顯下降,表明這一微調策略兼具樣本高效與成本低廉,為將預訓練 VLA 模型遷移至下游新場景提供了可行路徑。

-

6.2?長期工作臺總線

長跨度桌面整理 ?

作者通過桌面整理任務檢驗 GR-3 在長跨度操作中的魯棒性(圖 8)。在該任務中,機器人需清理布滿餐具、食物、外帶盒及塑料整理箱的餐桌。為完成整項作業,機器人必須:1) 將食物打包進外帶盒;2) 將所有餐具投入整理箱;3) 把垃圾全部扔進垃圾桶。由于操作區域廣闊,機器人需驅動底盤在餐桌、外帶盒與整理箱之間往返(圖 8(a))。作者在“平鋪任務”與“指令跟隨”兩種設定下進行評測。

平鋪任務設定 ?

機器人僅收到一條概括指令——“清理餐桌”——即需在單次運行中自主完成全部子任務(圖 8(a))。該設定用于評估模型在長跨度任務中的魯棒性。作者以“平均任務進度”作為指標,計算成功完成的子任務數占總子任務數的比例;數值為 1.0 表示完全成功,中間值表示部分完成。作者在此設定下共測試了五組不同物體配置。

指令跟隨(IF)設定 ?

為了進一步檢驗模型對子指令的遵循能力,作者依次給出多條子任務描述,例如“將紙杯扔進垃圾桶”。每次子任務均從機器人“原位”開始。作者以“平均子任務成功率”作為指標。IF 設定共含六類測試場景(圖 8(b)):

- 基礎:物體布局與訓練數據幾乎一致。 ?

- 多實例:在場景中加入某類物體的多個實例,并指令機器人將該類全部實例投入整理箱或垃圾桶。 ?

- 多目的地:額外放置一個編織籃,要求機器人把餐具投入籃子或整理箱。 ?

- 多實例 & 多目的地:綜合前兩設定,讓機器人把某類全部實例移至兩個目的地之一。 ?

- 新目的地:要求把物體移至訓練時未與之配對的目的地,例如“把叉子扔進垃圾桶”。 ?

- 無效任務:現實應用中,機器人可能收到無法完成的復雜指令。若桌上無藍碗,則“把藍碗放入塑料盒”即為無效。作者期望策略能拒絕執行此類錯誤指令。在該測試中,若模型在 10 秒內不操作任何物體即判為成功。

實現細節 ?

作者共采集約 101 小時的機器人軌跡。基線模型 π0 僅在這些軌跡上微調。GR-3 則同時利用機器人軌跡與視覺-語言數據協同訓練。作者還測試兩個消融版本: ?

- GR-3 w/o Norm:移除 DiT 塊注意力與 FFN 中的 RMSNorm。 ?

- GR-3 w/o TS:訓練時不引入任務狀態。 ?

兩種設定分別訓練“平鋪版”與“IF 版”。平鋪版在訓練時隨機使用整體任務或子任務作為語言指令;IF 版僅使用子任務指令。

結果 ?

圖 8(d) 顯示,GR-3 在兩項設定下均優于 π0,尤其在 IF 設定中成功率從 53.8 % 提升至 97.5 %。π0 雖能完成長跨度整理,但指令遵循薄弱,在分布外情境下尤為明顯:無法區分刀叉,在新目的地測試中將物體投入訓練時常見容器,而非按指令操作。相反,GR-3 在六類測試場景中均能嚴格遵循指令,可泛化到多實例與多目的地場景,并在無效任務中正確拒絕執行。

移除 RMSNorm 會顯著削弱性能,尤其在 IF 設定下:GR-3 w/o Norm 指令遵循能力大幅下降,無法泛化到新目的地,凸顯 RMSNorm 在提升指令遵循中的關鍵作用。去除任務狀態同樣導致 IF 性能下降,表明任務狀態能有效幫助 VLA 模型執行指令。

-

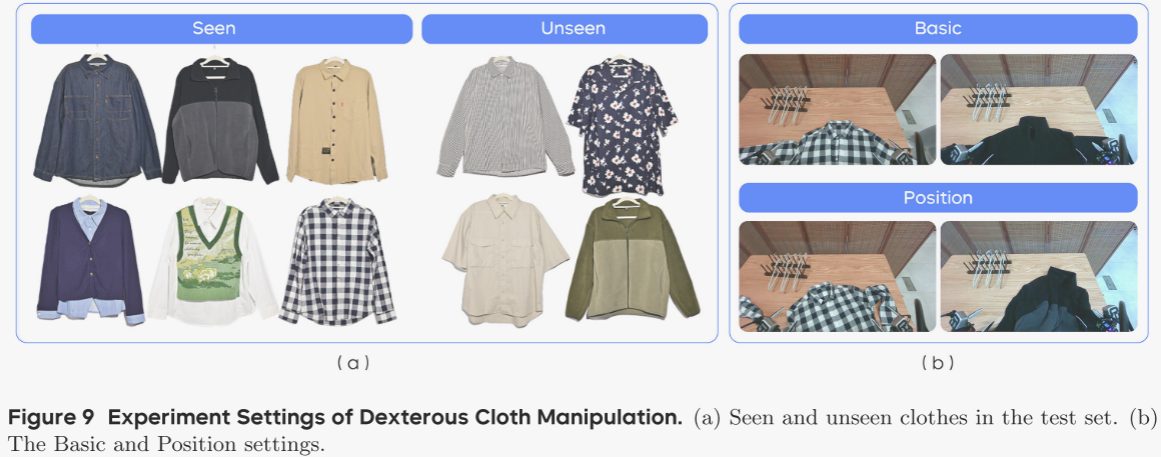

6.3 靈巧布料操作 ?

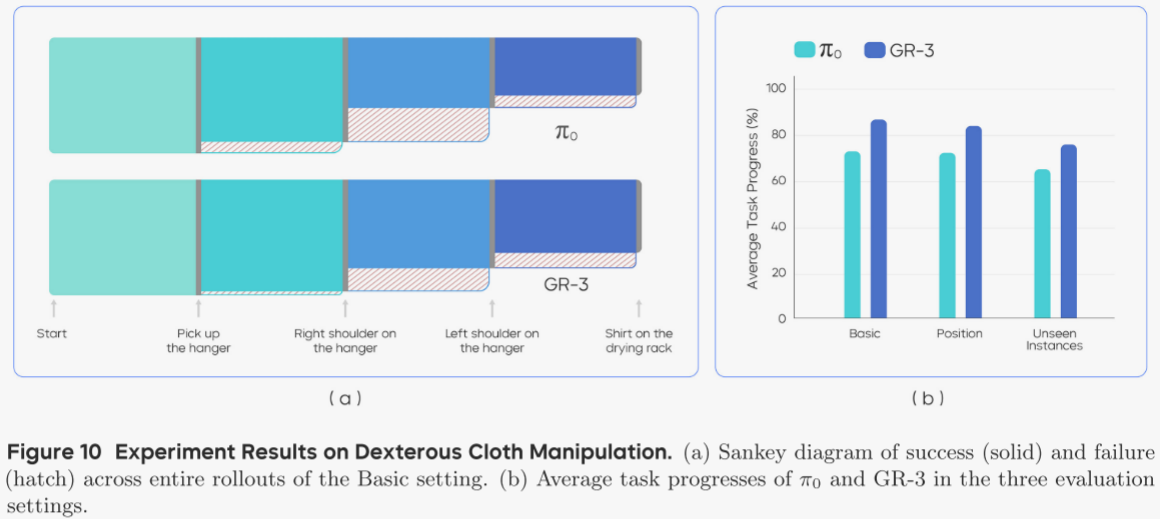

本實驗評估 GR-3 對可變形物體的靈巧操控能力,具體任務為:使用衣夾把衣服掛到晾衣架上(圖 2)。機器人需依次完成:1) 抓取衣夾;2) 將衣服套上衣夾;3) 把衣服連同衣夾掛到晾衣架。最后一步中,機器人需旋轉底盤,從桌面前移到晾衣架旁完成掛衣。作者共采集 116 小時機器人軌跡訓練 π0;GR-3 則在此基礎上與視覺-語言數據協同訓練。作者在三種設定下評測:基礎(Basic)、位置擾動(Position)、未見實例(Unseen Instances)。

設定 ?

- 基礎:使用訓練中見過的 6 件衣服,擺放方式與訓練數據一致。 ?

- 位置擾動:將衣服旋轉并揉皺(圖 9(b)),評估模型對復雜布料布局的魯棒性。 ?

- 未見實例:使用訓練中未見的 4 件衣服(圖 9(a))。訓練時均為長袖,測試集中兩件為短袖,考驗模型對新穎款式與袖長的泛化能力。

評測指標 ?

作者以“平均任務進度”為指標。完整掛衣成功得 1.0,任務被細分為 4 個關鍵里程碑: ?

1) 抓取衣夾; ?

2) 右肩套上衣夾; ?

3) 左肩套上衣夾; ?

4) 把衣服掛到晾衣架(圖 10(a))。 ?

每個里程碑貢獻相應分數,累加得到總進度。

結果 ?

圖 10 顯示,GR-3 在三種設定下均優于 π0: ?

- 基礎:86.7 % ?

- 位置擾動:83.9 % ?????????表明其擅長復雜靈巧任務,且對布料位置變化魯棒。 ?

- 未見實例:75.8 % ?????????表明模型可泛化至未見款式與袖長。

進一步分析 rollout 流程,圖 10(a) 給出基礎設定下 4 個里程碑的桑基圖。左右模型共同的最難點是“左肩套上衣夾”:機器人需先拉出在衣夾后方的左領口,再完成抓取,且需同時握住衣夾。另一常見失敗模式是衣夾在左肩操作過程中滑落,導致最后一步失敗。

-

-

7. 總結

局限與未來工作 ?

盡管 GR-3 在挑戰性任務中表現強勁,仍存在不足:面對包含全新概念或物體的未見指令時,模型會出錯;對于形狀前所未見的物體,抓取亦顯吃力。作者計劃通過擴大模型規模與訓練數據量,持續提升模型對新場景的適應能力。此外,與所有模仿學習方法類似,GR-3 在 rollout 時可能陷入分布外狀態且無法自行恢復。未來,作者擬引入強化學習(RL),以進一步提高復雜與靈巧任務的魯棒性,突破模仿學習的性能上限。

結論 ?

本報告介紹了 GR-3——一個強大的視覺-語言-動作(VLA)模型,可輸出動作控制雙臂移動機器人。作者系統研究了網絡架構,并構建了涵蓋以下要素的綜合訓練方案:與大規模視覺-語言數據協同訓練、基于少量人類軌跡的高效小樣本學習,以及基于機器人軌跡的有效模仿學習。在三大挑戰性任務上的大量真實世界實驗表明,GR-3 能夠理解包含抽象概念的復雜指令,有效泛化至全新物體與環境,僅需極少人類軌跡即可快速適應,并在長跨度與靈巧任務中表現出卓越的穩健性與可靠性。作者希望 GR-3 能成為邁向通用機器人的重要一步,使其能夠在現實世界中協助人類完成多樣化任務。

和迭代器詳解:常見面試陷阱與深入理解)

)

的兩種高效方法)