圖神經網絡、大模型優化方向系列文章目錄

為了方便大家根據自己的興趣查看自己的研究方向論文,在這里進行了細分。如果有對其中的論文感興趣的,可以查看對應的文章在論文相應的代碼,方便快速上手學習,也可以借助這些代碼的學習快速的寫出屬于自己的一篇論文。

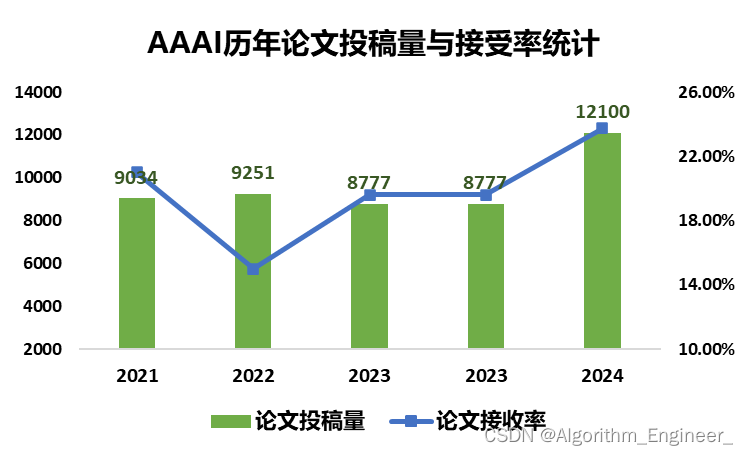

第38屆AAAI人工智能年度會議在2024年2月加拿大溫哥華舉行。今年的AAAI 會議投稿量突破了歷史記錄,共有12100篇投稿(主賽道),最終僅僅錄用2342篇,錄用率為23.75%。

今天主要分享若干篇收錄有代碼的CCF-A類AAAI會議論文,簡單的概述相關的內容分享給大家,后續有什么問題,歡迎大家一起交流。(有些論文還未看,需要時間整理)

AAAI是由國際人工智能促進協會主辦的年會,是人工智能領域中歷史最悠久、涵蓋內容最廣泛的國際頂級學術會議之一,也是中國計算機學會(CCF)推薦的A類國際學術會議。更多NLP國際頂級學術會議列表介紹可以參考這篇文章:https://mp.weixin.qq.com/s/7JkKpSON8JYsH4I7XzDVZQ

一、圖神經網絡

1.Fine-tuning Graph Neural Networks by Preserving Graph Generative Patterns

2.Continuous-time Graph Representation with Sequential Survival Process

3.Rethinking Causal Relationships Learning in Graph Neural Networks

4.Chasing Fairness in Graphs: A GNN Architecture Perspective

5.Emotion Rendering for Conversational Speech Synthesis with Heterogeneous Graph-Based Context Modeling

6.Rethinking Dimensional Rationale in Graph Contrastive Learning from Causal Perspective

7.Fair Federated Graph Neural Networks for Personalized Recommendation

8.SAT-Based Algorithms for Regular Graph Pattern Matching

9.Learning to Optimize Permutation Flow Shop Scheduling via Graph-based Imitation Learning

二、大語言模型

1.Benchmarking Large Language Models in Retrieval-Augmented Generation

2.An Ever-Updating Benchmark for Holistic Domain Knowledge Evaluation

摘要:為了適應大型語言模型(LLM)的快速發展,迫切需要新的自然語言處理(NLP)基準。對此,我們推出了最全面的評估套件Xiezhi(獬豸),旨在評估整體領域知識。Xiezhi由516個不同學科的選擇題組成,共包含249,587道題目,并附有“Xiezhi-專業”和 “Xiezhi-跨學科”兩個領域特色數據集,均有15k題。通過對解題網上47個最新的LLM進行評估,結果表明最強的LLM在科學、工程學、農學、醫學和藝術方面的表現有了超過人類的平均水平,但在經濟學、法學、教育學、文學、歷史學和管理學方面則有所欠缺。我們期待Xiezhi能幫助分析人類和LLM之間的差距,并能有助于分析LLM的重要優勢和不足。

3.Can Large Language Models Understand Real-World Complex Instructions

摘要:大規模語言模型(LLMs)能夠理解人類豐富的指令,其應用場景不再局限于傳統自然語言處理任務。然而,LLMs在處理真實使用場景中的復雜指令時仍然面臨挑戰。這些復雜指令可能包含需要執行的多個任務或者需要遵循的多個約束條件,也可能包含長篇幅、噪聲、異構信息和多輪對話格式的復雜輸入。大模型的很多錯誤可以歸因于無法理解復雜指令:LLMs通常會忽略任務描述中的語義約束、格式約束、數據約束等,從而無法忠實于給定的輸入內容進行回答等。目前的基準測試無法全面評估LLMs理解復雜指令的能力,因為它們涵蓋的指令通常是封閉且簡單的。為了彌補這一不足,我們提出了CELLO,一個用于系統評估LLMs理解復雜指令能力的基準測試集,歸納了復雜指令的八個特征,并從真實場景中搜集數據從而構建了評估數據集。此外,鑒于現有評估指標存在不適用、含有偏見或者粗粒度等問題,我們建立了四個評估LLMs理解復雜指令能力的標準并將其量化為自動化指標。通過廣泛的實驗對比了具有代表性的中英文大模型對復雜指令理解的能力。

4.SECap: Speech Emotion Captioning with Large Language Model

5.Data-Efficient Alignment of Large Language Models with Human Feedback Through Natural Language

三、時間序列預測

四、知識圖譜

1.Knowledge Graph Error Detection with Contrastive Confidence Adaption

2.Knowledge Graph Error Detection with Contrastive Confidence Adaption

3.Knowledge Graphs Meet Multi-Modal Learning: A Comprehensive Survey

這一論文并非AAAI的論文,但是可以通過這篇論文了解知識圖譜的很多論文。

4.Editing Language Model-based Knowledge Graph Embeddings

五、多模態

1.LAMM: Label Alignment for Multi-Modal Prompt Learning

2.Generative-based Fusion Mechanism for Multi-Modal Tracking

摘要:盡管生成模型在眾多研究任務中已經展現了較強的綜合理解能力,它在多模態目標跟蹤中的應用仍未被探索。因此,在此文中我們嘗試使用生成式范式去解決多模態任務的核心問題-多模態信息融合。我們深入對比了兩種常見的生成模型,條件生成對抗網絡以及擴散模型。與傳統融合范式將各個模態特征直接輸入到融合網絡不同,在生成式融合范式中我們將模態特征與隨機噪聲相結合,有效地將原始相對簡單的樣本對轉換為困難樣本對,提高了網絡對噪聲(無效信息)的感知能力,因此能夠獲得更好地跟蹤性能。為了驗證方法的有效性及魯棒性,我們在2個不同的跟蹤任務、3個不同的跟蹤框架、4個不同的跟蹤基準測試集上進行了驗證實驗,體現了算法較好的魯棒性,同時在GTOT、LasHeR和RGBD1K測試集上達到了當前的最優性能。

3.Structure-CLIP: Towards Scene Graph Knowledge to Enhance Multi-modal Structured Representations

4.T-SciQ: Teaching Multimodal Chain-of-Thought Reasoning via Mixed Large Language Model Signals for Science Question Answering

六、推薦系統

1.Temporally and Distributionally Robust Optimization for Cold-Start Recommendation

七、強化學習

1.BadRL: Sparse Targeted Backdoor Attack Against Reinforcement Learning

2.Explaining Reinforcement Learning Agents Through Counterfactual Action Outcomes

3.ReCePS: Reward Certification for Policy Smoothed Reinforcement Learning

4.Contextual Pre-planning on Reward Machine Abstractions for Enhanced Transfer in Deep Reinforcement Learning

八、擴散模型

1.Brush Your Text: Synthesize Any Scene Text on Images via Diffusion Mode

2.SPD-DDPM: Denoising Diffusion Probabilistic Models in the Symmetric Positive Definite Space

3.DiAD: A Diffusion-based Framework for Multi-class Anomaly Detection

4.ArtBank: Artistic Style Transfer with Pre-trained Diffusion Model and Implicit Style Prompt Bank

5.AnomalyDiffusion: Few-Shot Anomaly Image Generation with Diffusion Model

6.Audio Generation with Multiple Conditional Diffusion Model

7.Compositional Text-to-Image Synthesis with Attention Map Control of Diffusion Models

8.LDMVFI: Video Frame Interpolation with Latent Diffusion Models

九、其它有趣的研究

1.DeepCalliFont: Few-shot Chinese Calligraphy Font Synthesis by Integrating

2.Text2Analysis: A Benchmark of Table Question Answering withAdvanced Data Analysis and Unclear Queries

3.Coreference Graph Guidance for Mind-Map Generation

4.Zero-1-to-3:Domain-level Zero-shot Cognitive Diagnosis via One Batch of Early-bird Students towards Three Diagnostic Obiectives

5.Enhance Sketch Recognition’s Explainability via Semantic Component-Level Parsing

6.Toward Robustness in Multi-label Classification: A Data Augmentation Strategy against Imbalance and Noise

7.Towards Automatic Boundary Detection for Human-AI Collaborative Hybrid Essay in Education

8.Model Reprogramming: Resource-Efficient Cross-Domain Machine Learning

C. Min Max Sort(遞歸、思維、dp))

-儀表)

![[Flutter]shared_preferences基本用法以及可視化管理存儲的key和value類型](http://pic.xiahunao.cn/[Flutter]shared_preferences基本用法以及可視化管理存儲的key和value類型)

)