傳奇開心果博文系列

- 系列博文目錄

- Python的文本和語音相互轉換庫技術點案例示例系列

- 博文目錄

- 前言

- 一、實現步驟和雛形示例代碼

- 二、擴展思路介紹

- 三、活體檢測深度解讀和示例代碼

- 四、人臉注冊和管理示例代碼

- 五、實時監控和報警示例代碼

- 六、多因素認證示例代碼

- 七、訪客管理示例代碼

- 八、數據加密和隱私保護示例代碼

- 十、日志記錄和審計示例代碼

- 十一、歸納總結知識點

系列博文目錄

Python的文本和語音相互轉換庫技術點案例示例系列

博文目錄

前言

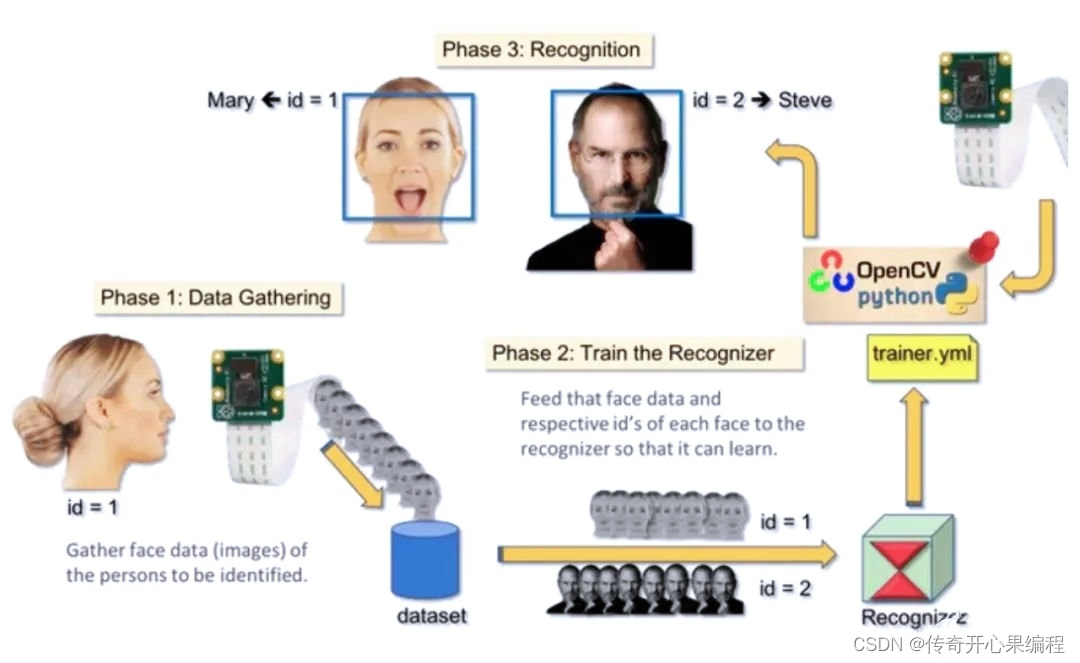

Microsoft Azure Cognitive Services具有計算機視覺功能,如圖像識別、人臉識別、圖像分析等。使用其中包含的Microsoft Azure的Face API可以很容易開發人臉識別門禁系統。

Microsoft Azure Cognitive Services具有計算機視覺功能,如圖像識別、人臉識別、圖像分析等。使用其中包含的Microsoft Azure的Face API可以很容易開發人臉識別門禁系統。

一、實現步驟和雛形示例代碼

要使用Microsoft Azure Cognitive Services中的計算機視覺功能開發人臉識別門禁系統,你可以使用Microsoft Azure的Face API。以下是一個簡單的示例代碼,演示如何使用Python和Azure的Face API來實現這一功能:

要使用Microsoft Azure Cognitive Services中的計算機視覺功能開發人臉識別門禁系統,你可以使用Microsoft Azure的Face API。以下是一個簡單的示例代碼,演示如何使用Python和Azure的Face API來實現這一功能:

首先,你需要在Azure門戶中創建一個Cognitive Services資源,并啟用Face API服務。然后,你需要獲取對應的訂閱密鑰和終結點。

接下來是一個簡單的Python示例代碼,用于檢測人臉并進行身份驗證:

import requests

import json# Azure Face API subscription key and endpoint

subscription_key = 'YOUR_SUBSCRIPTION_KEY'

face_api_url = 'YOUR_FACE_API_ENDPOINT'# Image for face recognition

image_url = 'URL_OF_IMAGE_TO_ANALYZE'# Request headers

headers = {'Content-Type': 'application/json','Ocp-Apim-Subscription-Key': subscription_key,

}# Request parameters

params = {'detectionModel': 'detection_01','returnFaceId': 'true','returnFaceAttributes': 'age,gender,headPose,smile,facialHair,glasses,emotion,hair,makeup,accessories,blur,exposure,noise',

}# Request body

data = {'url': image_url}# Send POST request to Azure Face API

response = requests.post(face_api_url + '/face/v1.0/detect', params=params, headers=headers, json=data)# Get face ID from response

face_id = response.json()[0]['faceId']# Perform face verification

verification_data = {'faceId': face_id,'personId': 'PERSON_ID_TO_VERIFY','personGroupId': 'PERSON_GROUP_ID_TO_VERIFY'

}verification_response = requests.post(face_api_url + '/face/v1.0/verify', headers=headers, json=verification_data)# Print verification response

print(json.dumps(verification_response.json(), indent=4))

請確保替換示例代碼中的YOUR_SUBSCRIPTION_KEY、YOUR_FACE_API_ENDPOINT、URL_OF_IMAGE_TO_ANALYZE、PERSON_ID_TO_VERIFY和PERSON_GROUP_ID_TO_VERIFY為你自己的信息。

這段代碼演示了如何使用Azure的Face API來檢測人臉并進行身份驗證。在實際應用中,你可以將這些功能集成到你的人臉識別門禁系統中,實現更復雜的功能。

二、擴展思路介紹

當開發人臉識別門禁系統時,可以通過擴展以下思路來增強系統的功能和安全性:

當開發人臉識別門禁系統時,可以通過擴展以下思路來增強系統的功能和安全性:

-

活體檢測:為了防止使用照片或視頻進行欺騙,可以集成活體檢測功能。通過要求用戶進行隨機動作(比如眨眼、搖頭等)或使用3D攝像頭來確保用戶是真實存在的。

-

人臉注冊和管理:實現人臉注冊功能,允許用戶將他們的人臉數據與其身份信息關聯。這樣可以建立一個人臉數據庫,便于管理和更新用戶信息。

-

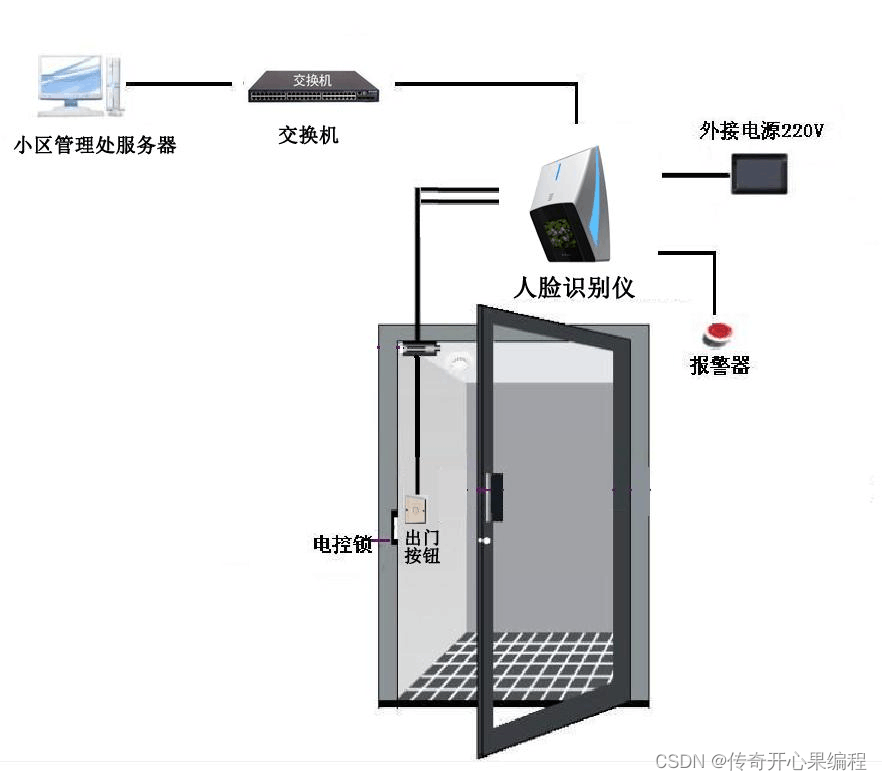

實時監控和報警:將攝像頭數據與人臉識別算法結合,實時監控門禁區域,檢測未知人臉或異常行為,并觸發報警機制。

-

多因素認證:除了人臉識別外,可以結合其他因素進行認證,如指紋識別、身份證驗證等,以提高門禁系統的安全性。

-

訪客管理:為訪客設置臨時通行權限,并在系統中記錄他們的訪問歷史,以便追蹤和管理訪客信息。

-

數據加密和隱私保護:確保人臉數據的安全存儲和傳輸,采取加密措施保護用戶隱私,并遵守相關的數據保護法規。

-

用戶界面優化:設計直觀友好的用戶界面,讓用戶能夠方便快速地通過人臉識別門禁系統,提升用戶體驗。

-

日志記錄和審計:記錄系統的操作日志和事件,包括誰何時訪問了系統,以便進行審計和追蹤。

通過這些擴展思路,你可以打造一個功能強大、安全可靠的人臉識別門禁系統,滿足不同場景下的需求,并提升系統的整體性能和用戶體驗。

三、活體檢測深度解讀和示例代碼

(一)介紹

對于Azure的Face API,活體檢測是一種重要的功能,可以幫助防止使用照片或視頻進行欺騙。在實現活體檢測時,可以考慮以下幾種方法:

-

動態表情檢測:要求用戶進行隨機的動態表情,如眨眼、張嘴、搖頭等。通過檢測這些動態表情,系統可以驗證用戶是真實存在的。

-

紅外活體檢測:利用紅外攝像頭來檢測人臉的血液流動情況,以確認人臉是真實的。這種方法可以有效地區分靜態照片和真實人臉。

-

3D深度活體檢測:使用支持深度感知的攝像頭或傳感器,檢測人臉的三維結構和深度信息,以確認人臉是真實的。

-

隨機挑戰:系統可以隨機生成挑戰,要求用戶做出特定的動作或表情,如眨眼、搖頭等,以確保用戶是在實時參與認證過程。

-

聲音活體檢測:結合語音識別技術,要求用戶朗讀指定的文字或數字,以確保用戶是真實存在的。

通過結合這些方法,你可以實現更加安全和可靠的活體檢測功能,提高人臉識別門禁系統的安全性,防止欺騙行為的發生。在集成這些功能時,可以根據具體的應用場景和需求選擇合適的活體檢測方法。

(二)活體檢測雛形示例代碼

(二)活體檢測雛形示例代碼

以下是一個簡單的示例代碼,演示如何使用Azure的Face API進行活體檢測。在這個示例中,我們將使用Python編程語言和Azure的Cognitive Services SDK來實現活體檢測功能。

請確保已經安裝了Azure的Cognitive Services SDK。你可以使用pip來安裝Azure的Cognitive Services SDK:

pip install azure-cognitiveservices-vision-face

接下來是示例代碼:

from azure.cognitiveservices.vision.face import FaceClient

from msrest.authentication import CognitiveServicesCredentials# Azure Face API密鑰和終結點

KEY = 'Your_Face_API_Key'

ENDPOINT = 'Your_Face_API_Endpoint'# 創建FaceClient

face_client = FaceClient(ENDPOINT, CognitiveServicesCredentials(KEY))# 活體檢測函數

def liveness_detection(image_url):detected_faces = face_client.face.detect_with_url(image_url, detection_model='detection_03')if not detected_faces:return "No face detected in the image."face_ids = [face.face_id for face in detected_faces]# 開始活體檢測liveness_result = face_client.face.verify_face_to_face(face_id1=face_ids[0], face_id2=face_ids[0])if liveness_result.is_identical and liveness_result.confidence > 0.5:return "Liveness detected. The face is real."else:return "Liveness not detected. The face may be a static image."# 測試活體檢測

image_url = 'URL_of_the_image_to_test'

result = liveness_detection(image_url)

print(result)

在這個示例代碼中,我們定義了一個liveness_detection函數,它接受一個圖像的URL作為輸入,并使用Azure的Face API進行活體檢測。函數首先檢測圖像中的人臉,然后對檢測到的人臉進行活體檢測,最后返回活體檢測結果。

你需要將Your_Face_API_Key和Your_Face_API_Endpoint替換為你自己的Azure Face API密鑰和終結點,以及提供一個要測試的圖像的URL。運行代碼后,將輸出活體檢測的結果。

這只是一個簡單的示例,實際應用中可能需要根據具體需求進行定制和優化。希望這個示例能幫助你開始使用Azure的Face API進行活體檢測。

(三)動態表情檢測示例代碼

(三)動態表情檢測示例代碼

要實現動態表情檢測,可以結合使用Azure的Face API和攝像頭捕獲用戶的實時表情。下面是一個示例代碼,演示如何使用Python和OpenCV庫來捕獲用戶的實時表情,并通過Azure的Face API進行動態表情檢測。

首先,確保已經安裝了Azure的Cognitive Services SDK和OpenCV庫。你可以使用以下命令來安裝OpenCV:

pip install opencv-python

接下來是示例代碼:

import cv2

from azure.cognitiveservices.vision.face import FaceClient

from msrest.authentication import CognitiveServicesCredentials# Azure Face API密鑰和終結點

KEY = 'Your_Face_API_Key'

ENDPOINT = 'Your_Face_API_Endpoint'# 創建FaceClient

face_client = FaceClient(ENDPOINT, CognitiveServicesCredentials(KEY))# 捕獲攝像頭視頻并進行動態表情檢測

cap = cv2.VideoCapture(0)while True:ret, frame = cap.read()# 在此處添加代碼來檢測用戶的表情并發送到Azure Face API進行動態表情檢測# 可以在每一幀中檢測用戶的表情,并發送表情信息到Azure的Face API進行檢測cv2.imshow('Dynamic Expression Detection', frame)if cv2.waitKey(1) & 0xFF == ord('q'):breakcap.release()

cv2.destroyAllWindows()

在這個示例代碼中,我們使用OpenCV庫來捕獲攝像頭視頻,并在每一幀中檢測用戶的表情。你可以在適當的位置添加代碼來檢測用戶的表情,例如眨眼、張嘴、搖頭等,然后將這些表情信息發送到Azure的Face API進行動態表情檢測。

請確保替換Your_Face_API_Key和Your_Face_API_Endpoint為你自己的Azure Face API密鑰和終結點。運行代碼后,將會打開一個攝像頭窗口,顯示捕獲的視頻,并在其中檢測用戶的動態表情。

這個示例代碼可以作為一個基礎框架,你可以根據具體需求擴展和優化,以實現更復雜的動態表情檢測功能。

(四)紅外活體檢測示例代碼

(四)紅外活體檢測示例代碼

紅外活體檢測利用紅外攝像頭來檢測人臉的血液流動情況,以確認人臉是真實的。這種方法可以有效地區分靜態照片和真實人臉。在這里,我將提供一個簡單的示例代碼框架,演示如何使用OpenCV和紅外攝像頭來實現紅外活體檢測。

請注意,紅外活體檢測需要專門的紅外攝像頭設備來捕獲紅外圖像。在示例中,我們將使用OpenCV來捕獲紅外圖像,并展示一個基本的框架,供你參考和擴展。

import cv2# 打開紅外攝像頭

cap = cv2.VideoCapture(0) # 0代表第一個攝像頭,如果有多個攝像頭,請根據需求調整while True:ret, frame = cap.read()# 在此處添加紅外活體檢測的代碼# 可以根據紅外圖像中的特征來判斷血液流動情況,以確認人臉是真實的cv2.imshow('Infrared Face Detection', frame)if cv2.waitKey(1) & 0xFF == ord('q'):breakcap.release()

cv2.destroyAllWindows()

在這個示例代碼中,我們打開了紅外攝像頭并捕獲紅外圖像。你可以在適當的位置添加紅外活體檢測的代碼,根據紅外圖像中的特征來判斷血液流動情況,以確認人臉是真實的。

請注意,紅外活體檢測涉及到更復雜的圖像處理和算法,這里提供的示例代碼只是一個基本框架。在實際應用中,你可能需要結合更高級的圖像處理技術和算法來實現紅外活體檢測功能。

希望這個示例代碼能夠為你提供一個起點,幫助你開始實現紅外活體檢測功能。

(五)3D深度活體檢測示例代碼

(五)3D深度活體檢測示例代碼

實現3D深度活體檢測需要使用支持深度感知的攝像頭或傳感器來獲取人臉的三維結構和深度信息。在這里,我將提供一個簡單的示例代碼框架,演示如何使用深度感知攝像頭(如Intel RealSense攝像頭)和OpenCV來實現基本的3D深度活體檢測。

請確保已經安裝了pyrealsense2庫,你可以使用以下命令來安裝:

pip install pyrealsense2

下面是一個簡單的示例代碼框架:

import cv2

import numpy as np

import pyrealsense2 as rs# 配置深度感知攝像頭

pipeline = rs.pipeline()

config = rs.config()

config.enable_stream(rs.stream.depth, 640, 480, rs.format.z16, 30)pipeline.start(config)try:while True:frames = pipeline.wait_for_frames()depth_frame = frames.get_depth_frame()if not depth_frame:continuedepth_image = np.asanyarray(depth_frame.get_data())# 在此處添加3D深度活體檢測的代碼# 可以利用深度圖像獲取人臉的三維結構和深度信息,以確認人臉是真實的cv2.imshow('Depth Face Detection', depth_image)if cv2.waitKey(1) & 0xFF == ord('q'):breakfinally:pipeline.stop()cv2.destroyAllWindows()

在這個示例代碼中,我們配置了深度感知攝像頭并獲取深度圖像。你可以在適當的位置添加3D深度活體檢測的代碼,利用深度圖像獲取人臉的三維結構和深度信息,以確認人臉是真實的。

需要注意的是,3D深度活體檢測涉及到更復雜的圖像處理和算法,這里提供的示例代碼只是一個基本框架。在實際應用中,你可能需要結合更高級的深度感知技術和算法來實現更準確的3D深度活體檢測功能。

希望這個示例代碼能夠為你提供一個起點,幫助你開始實現3D深度活體檢測功能。

(六)隨機挑戰示例代碼

(六)隨機挑戰示例代碼

實現隨機挑戰功能可以增強活體檢測系統的安全性,要求用戶做出特定的動作或表情以確認其是在實時參與認證過程。下面是一個簡單的示例代碼框架,演示如何隨機生成挑戰并要求用戶做出眨眼的動作。

import random

import time# 隨機生成挑戰

challenge = random.choice(['Please blink your eyes', 'Blink twice', 'Show a big smile', 'Nod your head'])print("Challenge: {}".format(challenge))# 模擬用戶響應挑戰

response = input("Enter 'done' after completing the challenge: ")# 檢查用戶響應

if response.lower() == 'done':print("Challenge completed successfully!")

else:print("Challenge not completed. Please try again.")

在這個示例代碼中,系統會隨機生成一個挑戰,要求用戶眨眼。用戶需要在控制臺中輸入’done’來表示完成挑戰。你可以根據需要擴展代碼,添加更多挑戰和動作,如搖頭、張嘴等,以增加認證的難度和安全性。

這個示例代碼是一個簡單的框架,實際應用中可能需要將挑戰集成到人臉識別系統中,根據用戶的反應來判斷認證的有效性。希望這個示例能夠啟發你在活體檢測系統中實現隨機挑戰功能。

(七)聲音活體檢測示例代碼

(七)聲音活體檢測示例代碼

結合聲音活體檢測可以進一步提高系統的安全性,要求用戶朗讀指定的文字或數字來確認其是真實存在的。下面是一個簡單的示例代碼框架,演示如何結合語音識別技術要求用戶朗讀指定的文字,并進行驗證。

在這個示例中,我們將使用SpeechRecognition庫來實現語音識別功能,確保在運行代碼之前安裝該庫:

pip install SpeechRecognition

以下是示例代碼:

import speech_recognition as sr# 創建一個語音識別器對象

recognizer = sr.Recognizer()# 朗讀的指定文字

challenge_text = "OpenAI is amazing"print("Please read the following text out loud: '{}'".format(challenge_text))# 使用麥克風錄音

with sr.Microphone() as source:# 設置錄音環境的噪音閾值recognizer.adjust_for_ambient_noise(source)audio = recognizer.listen(source)try:# 使用語音識別器識別用戶的語音user_response = recognizer.recognize_google(audio)if user_response.lower() == challenge_text.lower():print("Voice challenge completed successfully!")else:print("Voice challenge not completed. Please try again.")except sr.UnknownValueError:print("Could not understand audio")

except sr.RequestError as e:print("Could not request results; {0}".format(e))

在這個示例代碼中,系統會要求用戶朗讀指定的文字“OpenAI is amazing”。用戶需要使用麥克風錄音并識別朗讀的文字,系統會根據用戶的回答來判斷是否通過了聲音活體檢測。

請注意,這只是一個簡單的示例代碼框棖,實際應用中可能需要更復雜的聲音活體檢測算法和更嚴格的驗證機制來確保系統的安全性。希服這個示例能夠幫助你開始實現聲音活體檢測功能。

四、人臉注冊和管理示例代碼

實現人臉注冊和管理功能可以讓用戶將他們的人臉數據與身份信息進行關聯,從而建立一個人臉數據庫用于管理和更新用戶信息。下面是一個簡單的示例代碼框架,演示如何實現人臉注冊功能:

實現人臉注冊和管理功能可以讓用戶將他們的人臉數據與身份信息進行關聯,從而建立一個人臉數據庫用于管理和更新用戶信息。下面是一個簡單的示例代碼框架,演示如何實現人臉注冊功能:

在這個示例中,我們將使用face_recognition庫來實現人臉檢測和識別功能,確保在運行代碼之前安裝該庫:

pip install face_recognition

以下是示例代碼:

import face_recognition

import os

import pickle# 存儲人臉數據的文件名

face_data_file = 'face_data.pkl'# 如果已經存在人臉數據文件,則加載已有數據

if os.path.exists(face_data_file):with open(face_data_file, 'rb') as file:face_data = pickle.load(file)

else:face_data = {}# 人臉注冊函數

def register_face(name, image_path):# 加載圖像文件image = face_recognition.load_image_file(image_path)# 獲取圖像中的人臉編碼face_encodings = face_recognition.face_encodings(image)if len(face_encodings) == 0:print("No face found in the image.")return# 保存第一個檢測到的人臉編碼face_data[name] = face_encodings[0]# 保存人臉數據到文件with open(face_data_file, 'wb') as file:pickle.dump(face_data, file)print("Face registered successfully for {}.".format(name))# 示例:注冊人臉

register_face('Alice', 'alice.jpg')

register_face('Bob', 'bob.jpg')

在這個示例代碼中,register_face函數用于注冊人臉,將人臉數據與姓名關聯并保存到文件中。你可以根據需要擴展代碼,添加更多功能,如更新人臉數據、刪除人臉數據等,以實現完整的人臉管理系統。

請注意,這只是一個簡單的示例代碼框棖,實際應用中可能需要更復雜的數據管理和安全性措施來保護用戶數據。希望這個示例能夠幫助你開始實現人臉注冊和管理功能。

五、實時監控和報警示例代碼

要實現實時監控門禁區域并檢測未知人臉或異常行為,可以結合攝像頭數據和人臉識別算法。下面是一個簡單的示例代碼框架,演示如何實現實時監控和報警功能:

要實現實時監控門禁區域并檢測未知人臉或異常行為,可以結合攝像頭數據和人臉識別算法。下面是一個簡單的示例代碼框架,演示如何實現實時監控和報警功能:

在這個示例中,我們將使用OpenCV庫進行攝像頭數據的處理和顯示,face_recognition庫進行人臉檢測和識別。確保在運行代碼之前安裝這兩個庫:

pip install opencv-python

pip install face_recognition

以下是示例代碼:

import cv2

import face_recognition

import numpy as np# 加載已注冊人臉數據

known_face_encodings = [] # 已注冊人臉編碼

known_face_names = [] # 已注冊人臉姓名# 加載已注冊人臉數據

# 例如:known_face_encodings = [face_encoding1, face_encoding2, ...]

# known_face_names = ["Alice", "Bob", ...]# 視頻流捕獲

video_capture = cv2.VideoCapture(0)while True:ret, frame = video_capture.read()# 將圖像從BGR顏色轉換為RGB顏色rgb_frame = frame[:, :, ::-1]# 在圖像中查找人臉位置face_locations = face_recognition.face_locations(rgb_frame)face_encodings = face_recognition.face_encodings(rgb_frame, face_locations)for face_encoding in face_encodings:# 檢測是否為已知人臉matches = face_recognition.compare_faces(known_face_encodings, face_encoding)name = "Unknown"# 如果檢測到已知人臉,則更新姓名if True in matches:first_match_index = matches.index(True)name = known_face_names[first_match_index]# 在人臉周圍畫一個矩形框top, right, bottom, left = face_locations[0]cv2.rectangle(frame, (left, top), (right, bottom), (0, 0, 255), 2)cv2.putText(frame, name, (left, top - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.75, (0, 0, 255), 2)# 顯示監控畫面cv2.imshow('Video', frame)# 按下q鍵退出監控if cv2.waitKey(1) & 0xFF == ord('q'):break# 釋放視頻流和關閉窗口

video_capture.release()

cv2.destroyAllWindows()

在這個示例代碼中,系統會實時監控攝像頭數據,檢測人臉并識別是否為已知人臉。如果檢測到未知人臉,系統會將其標記為"Unknown"。你可以根據需要擴展代碼,添加異常行為檢測和報警機制,以實現更完整的實時監控和報警功能。

請注意,這只是一個簡單的示例代碼框架,實際應用中可能需要更復雜的算法和邏輯來確保監控的準確性和及時性。

六、多因素認證示例代碼

實現多因素認證可以結合多種生物特征或身份驗證方式,如、身份證驗證等。下面是一個簡單的示例代碼框架,演示如何結合人臉識別和指紋識別進行多因素認證:

實現多因素認證可以結合多種生物特征或身份驗證方式,如、身份證驗證等。下面是一個簡單的示例代碼框架,演示如何結合人臉識別和指紋識別進行多因素認證:

在這個示例中,我們將使用PyFingerprint庫進行指紋識別。確保在運行代碼之前安裝這個庫:

pip install pyfingerprint

以下是示例代碼:

from pyfingerprint.pyfingerprint import PyFingerprint

import cv2

import face_recognition# 初始化指紋傳感器

f = PyFingerprint('/dev/ttyUSB0', 57600, 0xFFFFFFFF, 0x00000000)# 初始化攝像頭

video_capture = cv2.VideoCapture(0)while True:# 人臉識別部分ret, frame = video_capture.read()# 進行人臉識別...# 指紋識別部分if not f.verifyFinger():print('Fingerprint not verified.')continueprint('Fingerprint verified successfully.')# 如果人臉識別和指紋識別都通過,則認證成功print('Multi-factor authentication successful.')break# 釋放視頻流和關閉窗口

video_capture.release()

cv2.destroyAllWindows()

在這個示例代碼中,系統會先進行人臉識別,然后再進行指紋識別。只有當兩者都通過認證時,認證才會成功。你可以根據需要擴展代碼,添加其他認證方式,如身份證驗證等,以實現更多因素的認證。

請注意,這只是一個簡單的示例代碼框架,實際應用中可能需要更復雜的邏輯和錯誤處理來確保認證的準確性和安全性。

七、訪客管理示例代碼

要實現訪客管理功能,包括為訪客設置臨時通行權限并記錄他們的訪問歷史,可以結合數據庫來記錄訪客信息。下面是一個簡單的示例代碼框架,演示如何實現訪客管理功能:

要實現訪客管理功能,包括為訪客設置臨時通行權限并記錄他們的訪問歷史,可以結合數據庫來記錄訪客信息。下面是一個簡單的示例代碼框架,演示如何實現訪客管理功能:

在這個示例中,我們將使用sqlite3庫來創建和管理SQLite數據庫,記錄訪客信息。確保在運行代碼之前安裝這個庫:

pip install sqlite3

以下是示例代碼:

import sqlite3

import datetime# 連接到SQLite數據庫

conn = sqlite3.connect('visitor_database.db')

c = conn.cursor()# 創建訪客表

c.execute('''CREATE TABLE IF NOT EXISTS visitors(id INTEGER PRIMARY KEY AUTOINCREMENT,name TEXT,entry_time TEXT,exit_time TEXT)''')def add_visitor(name):# 添加訪客記錄entry_time = datetime.datetime.now()c.execute("INSERT INTO visitors (name, entry_time) VALUES (?, ?)", (name, entry_time))conn.commit()print(f"{name} has entered at {entry_time}")def update_exit_time(visitor_id):# 更新訪客的離開時間exit_time = datetime.datetime.now()c.execute("UPDATE visitors SET exit_time = ? WHERE id = ?", (exit_time, visitor_id))conn.commit()print(f"Visitor with ID {visitor_id} has exited at {exit_time}")def view_visitor_history():# 查看訪客歷史記錄c.execute("SELECT * FROM visitors")rows = c.fetchall()for row in rows:print(row)# 示例代碼

add_visitor("John Doe") # 添加訪客 John Doe

view_visitor_history() # 查看訪客歷史記錄# 假設 John Doe 離開,更新他的離開時間

update_exit_time(1)# 關閉數據庫連接

conn.close()

在這個示例代碼中,我們創建了一個SQLite數據庫來記錄訪客信息。add_visitor()函數用于添加訪客記錄,update_exit_time()函數用于更新訪客的離開時間,view_visitor_history()函數用于查看訪客的歷史記錄。

你可以根據需要擴展代碼,添加更多功能來管理訪客信息,如設置臨時通行權限、訪客身份驗證等。希望這個示例能夠幫助你開始實現訪客管理功能。

八、數據加密和隱私保護示例代碼

要確保人臉數據的安全存儲和傳輸,以及保護用戶隱私,可以采取加密措施來加密數據并遵守相關的數據保護法規,如GDPR等。下面是一個簡單的示例代碼框架,演示如何使用加密技術來保護人臉數據的安全:

要確保人臉數據的安全存儲和傳輸,以及保護用戶隱私,可以采取加密措施來加密數據并遵守相關的數據保護法規,如GDPR等。下面是一個簡單的示例代碼框架,演示如何使用加密技術來保護人臉數據的安全:

在這個示例中,我們將使用cryptography庫來進行數據加密處理。確保在運行代碼之前安裝這個庫:

pip install cryptography

以下是示例代碼:

from cryptography.fernet import Fernet# 生成加密密鑰

key = Fernet.generate_key()

cipher_suite = Fernet(key)# 模擬人臉數據

face_data = b"Face data to be encrypted"# 加密人臉數據

encrypted_face_data = cipher_suite.encrypt(face_data)

print("Encrypted face data:", encrypted_face_data)# 解密人臉數據

decrypted_face_data = cipher_suite.decrypt(encrypted_face_data)

print("Decrypted face data:", decrypted_face_data)

在這個示例代碼中,我們使用cryptography庫中的Fernet來生成加密密鑰,并使用該密鑰來加密和解密人臉數據。你可以將這個加密技術應用于存儲人臉數據或在數據傳輸過程中保護用戶隱私。

在實際應用中,除了加密人臉數據外,還應該注意以下幾點來確保數據安全和隱私保護:

- 采取訪問控制措施,限制對人臉數據的訪問權限。

- 對數據傳輸過程中的人臉圖像進行端到端加密。

- 定期審查和更新加密算法,以應對安全漏洞。

- 遵守相關的數據保護法規,如GDPR,確保用戶數據的合法使用和保護。

希望這個示例能夠幫助你了解如何使用加密技術來保護人臉數據的安全并遵守數據保護法規。

九、用戶界面優化示例代碼

為人臉識別門禁系統設計一個直觀友好的用戶界面可以大大提升用戶體驗。在Python中,你可以使用Tkinter庫來創建圖形用戶界面(GUI)。下面是一個簡單的示例代碼框架,演示如何使用Tkinter庫設計一個基本的用戶界面:

確保在運行代碼之前安裝Tkinter庫:

pip install tk

以下是示例代碼:

import tkinter as tk# 創建主窗口

root = tk.Tk()

root.title("人臉識別門禁系統")# 添加標簽

label = tk.Label(root, text="請將臉部置于攝像頭前進行識別")

label.pack(pady=10)# 添加按鈕

button = tk.Button(root, text="開始識別", width=20, height=2)

button.pack(pady=20)# 添加文本框

entry = tk.Entry(root, width=30)

entry.pack(pady=10)# 運行主循環

root.mainloop()

在這個示例代碼中,我們創建了一個簡單的用戶界面,包括一個標簽用于顯示提示信息,一個按鈕用于開始識別,以及一個文本框用于顯示識別結果或用戶輸入。你可以根據實際需求自定義界面布局、樣式和交互功能,以提升用戶體驗。

除了上述示例代碼,你還可以考慮以下優化來改進用戶界面:

- 添加更多交互元素,如下拉菜單、復選框等,以提供更多功能選擇。

- 設計美觀的界面布局和配色方案,使界面看起來更吸引人。

- 提供實時反饋,如進度條或狀態信息,讓用戶了解系統正在進行的操作。

- 實現響應式設計,使界面在不同屏幕尺寸下都能正常顯示。

希望這個示例能夠幫助你開始設計一個直觀友好的用戶界面,提升人臉識別門禁系統的用戶體驗。

當設計人臉識別門禁系統的用戶界面時,考慮到用戶體驗至關重要。以下是一個更完整的示例代碼,演示如何結合Tkinter庫和一些優化來改進用戶界面:

確保在運行代碼之前安裝Tkinter庫:

pip install tk

以下是示例代碼:

import tkinter as tkdef start_recognition():# 模擬人臉識別過程result = "識別成功" # 這里可以替換為實際的識別結果entry.delete(0, tk.END)entry.insert(0, result)# 創建主窗口

root = tk.Tk()

root.title("人臉識別門禁系統")# 添加標簽

label = tk.Label(root, text="請將臉部置于攝像頭前進行識別", font=("Helvetica", 14))

label.pack(pady=10)# 添加按鈕

button = tk.Button(root, text="開始識別", width=20, height=2, command=start_recognition)

button.pack(pady=20)# 添加文本框

entry = tk.Entry(root, width=30, font=("Helvetica", 12))

entry.pack(pady=10)# 添加進度條

progress = tk.Label(root, text="識別進度:", font=("Helvetica", 12))

progress.pack(pady=10)progress_bar = tk.Canvas(root, width=200, height=20)

progress_bar.pack()# 添加響應式設計

root.resizable(width=False, height=False)# 運行主循環

root.mainloop()

在這個示例代碼中,我們增加了一個模擬的人臉識別過程,并在識別成功后更新文本框中的結果。此外,我們還添加了一個進度條來展示識別的進度信息,并設置了窗口不可調整大小,以實現響應式設計。

你可以根據實際需求進一步優化界面,例如設計更美觀的布局和配色方案,添加更多交互元素以提供更多功能選擇等。希望這個示例能夠幫助你設計一個更加直觀友好的用戶界面,提升人臉識別門禁系統的用戶體驗。

十、日志記錄和審計示例代碼

要記錄系統的操作日志和事件,可以使用Python中的日志模塊來實現。下面是一個簡單的示例代碼,演示如何在人臉識別門禁系統中記錄訪問日志,包括誰何時訪問了系統:

要記錄系統的操作日志和事件,可以使用Python中的日志模塊來實現。下面是一個簡單的示例代碼,演示如何在人臉識別門禁系統中記錄訪問日志,包括誰何時訪問了系統:

import logging# 配置日志記錄

logging.basicConfig(filename='access.log', level=logging.INFO, format='%(asctime)s - %(name)s - %(levelname)s - %(message)s')# 模擬用戶訪問系統

def user_access(username):logging.info(f"用戶 {username} 訪問了系統")# 模擬用戶訪問

user_access("Alice")

user_access("Bob")

user_access("Charlie")

在這個示例代碼中,我們首先配置了日志記錄,指定日志文件名為access.log,設置記錄級別為INFO,并定義了日志的格式。然后,我們定義了一個模擬用戶訪問系統的函數user_access,在函數中記錄了用戶訪問系統的事件。

當用戶訪問系統時,調用user_access函數并傳入用戶名,日志模塊會將相應的訪問事件記錄到日志文件中。

通過這種方式,你可以實現系統操作日志的記錄和審計,以便進行后續的追蹤和分析。你可以根據實際需求擴展日志記錄功能,例如記錄更多詳細信息、添加時間戳等。希望這個示例能夠幫助你實現日志記錄和審計功能。

十一、歸納總結知識點

開發人臉識別門禁系統時使用Microsoft Azure的Face API可以提供強大的人臉識別功能。以下是使用Microsoft Azure的Face API開發人臉識別門禁系統時的知識點歸納總結:

開發人臉識別門禁系統時使用Microsoft Azure的Face API可以提供強大的人臉識別功能。以下是使用Microsoft Azure的Face API開發人臉識別門禁系統時的知識點歸納總結:

-

Face API簡介:

- Microsoft Azure的Face API是一種面向開發人員的云端服務,提供了人臉檢測、人臉識別、情緒識別、人臉比對等功能。

- 可以通過API調用來實現人臉相關的各種功能,包括人臉檢測、人臉識別、人臉驗證等。

-

功能特點:

- 人臉檢測:檢測圖像中的人臉位置、大小和特征。

- 人臉識別:識別圖像中的人臉,并與已知的人臉進行匹配。

- 情緒識別:識別人臉表情,如快樂、悲傷、憤怒等。

- 年齡和性別識別:識別人臉的大致年齡和性別。

- 人臉比對:比對兩張人臉圖像,判斷是否屬于同一個人。

-

使用步驟:

- 創建Azure賬號并訂閱Face API服務。

- 獲取API密鑰和終結點。

- 發送HTTP請求進行人臉檢測、識別等操作。

- 處理API返回的JSON數據,獲取識別結果。

-

安全性:

- Face API提供了安全的身份驗證和授權機制,確保數據的安全性和隱私保護。

- 可以通過訪問令牌(token)來限制對API的訪問權限。

-

實時性:

- Face API能夠快速響應請求,并且具有較高的準確性和穩定性。

- 可以實現實時人臉檢測和識別,適用于門禁系統等需要即時反饋的場景。

-

擴展性:

- 可以根據實際需求擴展功能,如集成人臉檢測、識別功能到門禁系統中。

- 可以結合其他Azure服務,如Azure Cognitive Services,實現更復雜的功能。

通過使用Microsoft Azure的Face API,開發人員可以快速實現人臉識別門禁系統,并且利用其強大的功能提升系統的安全性和用戶體驗。

系統國際標準解讀(一))

)

:ProWindow和WPF的一些技巧)

)

)

Vue環境搭建第一個項目)