Spark 的核心是建立在統一的抽象彈性分布式數據集(Resiliennt Distributed Datasets,RDD)之上的,這使得 Spark 的各個組件可以無縫地進行集成,能夠在同一個應用程序中完成大數據處理。

一、RDD概念

RDD 是 Spark 提供的最重要的抽象概念,它是一種有容錯機制的特殊數據集合,可以分布在集群的結點上,以函數式操作集合的方式進行各種并行操作。

通俗點來講,可以將 RDD 理解為一個分布式對象集合,本質上是一個只讀的分區記錄集合。每個 RDD 可以分成多個分區,每個分區就是一個數據集片段。一個 RDD 的不同分區可以保存到集群中的不同結點上,從而可以在集群中的不同結點上進行并行計算。

設計背景,迭代式算法,若采用MapReduce則會重用中間結果;MapReduce不斷在磁盤中讀寫數據,會帶來很大開銷。

二、RDD的典型執行過程

1)讀入外部數據源進行創建,分區

2)RDD經過一系列的轉化操作,每一次都會產生不同的RDD供給下一個轉化擦操作使用

3)最后一個RDD經過一個動作操作進行計算并輸出到外部數據源

優點:惰性調用、調用、管道化、避免同步等待,不需要保存中間結果

三、高效的原因

1)容錯性:現有方式是用日志記錄的方式。而RDD具有天生的容錯,任何一個RDD出錯,都可以去找父親節點,代價低。RDD的每次轉換都會生成一個新的RDD,所以RDD之間就會形成類似于流水線一樣的前后依賴關系。在部分分區數據丟失時,Spark可以通過這個依賴關系重新計算丟失的分區數據,而不是對RDD的所有分區進行重新計算。

2)中間結果保存到內存,避免了不必要的內存開銷

3)存放的數據可以是java對象,避免了對象的序列化和反序列化。

四、RDD的依賴關系:窄依賴和寬依賴

窄依賴:(narrow dependency)是指每個父RDD的一個Partition最多被子RDD的一個Partition所使用,例如map、filter、union等操作都會產生窄依賴;(獨生子女)即rdd中的每個partition僅僅對應父rdd中的一個partition。父rdd里面的partition只去向子rdd****里的某一個partition!這叫窄依賴,如果父rdd里面的某個partition會去子rdd里面的多個partition,那它就一定是寬依賴!**

寬依賴(shuffle dependency):是指一個父RDD的Partition會被多個子RDD的Partition所使用,例如groupByKey、reduceByKey、sortByKey等操作都會產生寬依賴;(超生)每一個父rdd的partition數據都有可能傳輸一部分數據到子rdd的每一個partition中,即子rdd的多個partition依賴于父rdd。寬依賴劃分成一個stage!!!

作用:完成Stage的劃分

Stage的劃分:

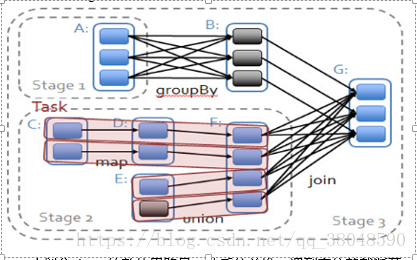

spark劃分stage的整體思路是:從后往前推,遇到寬依賴就斷開,劃分為一個stage;遇到窄依賴就將這個RDD加入該stage中。因此在上圖中RDD C,RDD D,RDD E,RDDF被構建在一個stage中,RDD A被構建在一個單獨的Stage中,而RDD B和RDD G又被構建在同一個stage中。

ShuffleMapStage和ResultStage:

簡單來說,DAG的最后一個階段會為每個結果的partition生成一個ResultTask,即每個Stage里面的Task的數量是由該Stage中最后一個RDD的Partition的數量所決定的!而其余所有階段都會生成ShuffleMapTask;之所以稱之為ShuffleMapTask是因為它需要將自己的計算結果通過shuffle到下一個stage中;也就是說上圖中的stage1和stage2相當于mapreduce中的Mapper,而ResultTask所代表的stage3就相當于mapreduce中的reducer。

*、本文參考

Spark RDD是什么?

spark原理:概念與架構、工作機制