學習caffe中踩了不少坑,這里我參考了此博主的文章,并體會到了如何訓練自己的模型:http://www.cnblogs.com/denny402/p/5083300.html

學習caffe的目的,不是簡單的做幾個練習,最終還是要用到自己的實際項目或科研中。因此,本文介紹一下,從自己的原始圖片到lmdb數據,再到訓練和測試模型的整個流程。

一、準備數據

有條件的同學,可以去imagenet的官網http://www.image-net.org/download-images,下載imagenet圖片來訓練。但是我沒有下載,一個原因是注冊賬號的時候,驗證碼始終出不來(聽說是google網站的驗證碼,而我是上不了google的)。第二個原因是數據太大了。。。

我去網上找了一些其它的圖片來代替,共有500張圖片,分為大巴車、恐龍、大象、鮮花和馬五個類,每個類100張。需要的同學,可到我的網盤下載:http://pan.baidu.com/s/1nuqlTnN

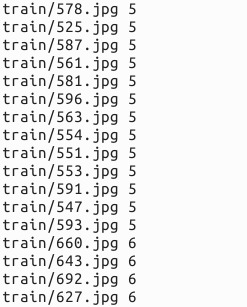

編號分別以3,4,5,6,7開頭,各為一類。我從其中每類選出20張作為測試,其余80張作為訓練。因此最終訓練圖片400張,測試圖片100張,共5類。我將圖片放在caffe根目錄下的data文件夾下面。即訓練圖片目錄:data/re/train/ ,測試圖片目錄: data/re/test/

二、轉換為lmdb格式

具體的轉換過程,可參見我的前一篇博文:Caffe學習系列(11):圖像數據轉換成db(leveldb/lmdb)文件

首先,在examples下面創建一個myfile的文件夾,來用存放配置文件和腳本文件。然后編寫一個腳本create_filelist.sh,用來生成train.txt和test.txt清單文件

# sudo mkdir examples/myfile # sudo vi examples/myfile/create_filelist.sh

編輯此文件,寫入如下代碼,并保存

按 Ctrl+C 復制代碼

?

按 Ctrl+C 復制代碼

然后,運行此腳本

# sudo sh examples/myfile/create_filelist.sh

成功的話,就會在examples/myfile/ 文件夾下生成train.txt和test.txt兩個文本文件,里面就是圖片的列表清單。

接著再編寫一個腳本文件,調用convert_imageset命令來轉換數據格式。

# sudo vi examples/myfile/create_lmdb.sh

插入:

按 Ctrl+C 復制代碼

?

按 Ctrl+C 復制代碼

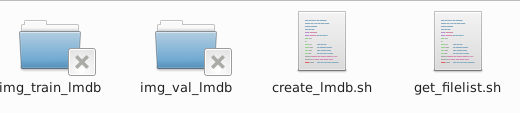

因為圖片大小不一,因此我統一轉換成256*256大小。運行成功后,會在 examples/myfile下面生成兩個文件夾img_train_lmdb和img_test_lmdb,分別用于保存圖片轉換后的lmdb文件。

三、計算均值并保存

圖片減去均值再訓練,會提高訓練速度和精度。因此,一般都會有這個操作。

caffe程序提供了一個計算均值的文件compute_image_mean.cpp,我們直接使用就可以了

# sudo build/tools/compute_image_mean examples/myfile/img_train_lmdb examples/myfile/mean.binaryproto

compute_image_mean帶兩個參數,第一個參數是lmdb訓練數據位置,第二個參數設定均值文件的名字及保存路徑。 運行成功后,會在 examples/myfile/ 下面生成一個mean.binaryproto的均值文件。

四、創建模型并編寫配置文件

模型就用程序自帶的caffenet模型,位置在?models/bvlc_reference_caffenet/文件夾下, 將需要的兩個配置文件,復制到myfile文件夾內

# sudo cp models/bvlc_reference_caffenet/solver.prototxt examples/myfile/ # sudo cp models/bvlc_reference_caffenet/train_val.prototxt examples/myfile/

修改其中的solver.prototxt

# sudo vi examples/myfile/solver.prototxt

net: "examples/myfile/train_val.prototxt" test_iter: 2 test_interval: 50 base_lr: 0.001 lr_policy: "step" gamma: 0.1 stepsize: 100 display: 20 max_iter: 500 momentum: 0.9 weight_decay: 0.005 solver_mode: GPU

100個測試數據,batch_size為50,因此test_iter設置為2,就能全cover了。在訓練過程中,調整學習率,逐步變小。

修改train_val.protxt,只需要修改兩個階段的data層就可以了,其它可以不用管。

name: "CaffeNet"

layer {name: "data"type: "Data"top: "data"top: "label"include {phase: TRAIN}transform_param {mirror: truecrop_size: 227mean_file: "examples/myfile/mean.binaryproto"}data_param {source: "examples/myfile/img_train_lmdb"batch_size: 256backend: LMDB}

}

layer {name: "data"type: "Data"top: "data"top: "label"include {phase: TEST}transform_param {mirror: falsecrop_size: 227mean_file: "examples/myfile/mean.binaryproto"}data_param {source: "examples/myfile/img_test_lmdb"batch_size: 50backend: LMDB}

}

實際上就是修改兩個data layer的mean_file和source這兩個地方,其它都沒有變化 。

五、訓練和測試

如果前面都沒有問題,數據準備好了,配置文件也配置好了,這一步就比較簡單了。

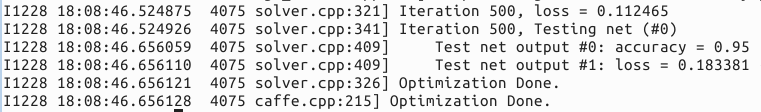

# sudo build/tools/caffe train -solver examples/myfile/solver.prototxt

運行時間和最后的精確度,會根據機器配置,參數設置的不同而不同。我的是gpu+cudnn運行500次,大約8分鐘,精度為95%。

?

分類:?caffe

-diff)

:柱面投影+模板匹配+漸入漸出融合)

:OpenCV同時打開兩個攝像頭捕獲視頻)

-merge)

-cherry-pick、reset、rebase)

-stash, reflog)

的創建及CV_8UC1,CV_8UC2等參數詳解)

-模型相關基礎概念)