一、目標

Kettle9.2.0在Linux上安裝好后,需要與Hive3.1.2數據庫建立連接

之前已經在本地上用kettle9.2.0連上Hive3.1.2

二、各工具版本

(一)kettle9.2.0? ?

kettle9.2.0安裝包網盤鏈接

鏈接:https://pan.baidu.com/s/15Zq9wNDwyMnc3qFVxYOMXw?pwd=zwae?

提取碼:zwae

(二)Hive3.1.2?

(三)Hadoop3.1.3

三、前提準備

(一)Kettle9.2.0已在Linux上安裝好

(二)注意Kettle9.2里MySQL驅動包的版本以及Hive312里MySQL驅動包的版本

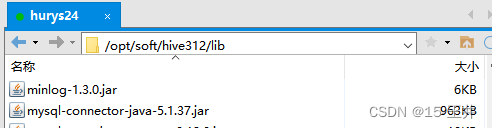

1、Hive312的lib里面MySQL驅動包的版本是mysql-connector-java-5.1.37.jar

2、Kettle9.2里MySQL驅動包的版本

mysql-connector-java-5.1.37.jar? ? ? ?;? ?mysql-connector-java-8.0.30.jar

?四、安裝步驟

(一)根據Hadoop版本在選擇對應的文件(千萬不要隨便選!)

?1、文件路徑

/opt/install/kettle9.2/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations

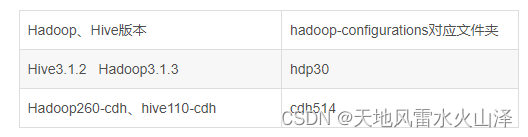

2、Hadoop版本與文件夾對應規則??

3、選擇文件,復制文件名(Hadoop版本與文件夾一定要匹配!)

因為我的Hadoop版本是Hadoop3.1.3,所以我選擇的文件夾是hdp30

(二)修改kettle里pentaho-big-data-plugin文件夾里的源文件plugin.properties

?1、文件路徑

/opt/install/kettle9.2/data-integration/plugins/pentaho-big-data-plugin

?2、??只要設置? ? ? ?active.hadoop.configuration=hdp30

?(三)從我們安裝的Hadoop、Hive里拉取需要的文件復制到hdp30的文件夾下(如需要HBase則拉取HBase的?hbase-site.xml)

1、文件路徑

/opt/install/kettle9.2/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp30

2、主要替換5個文件

Hadoop4個文件:? ? yarn-site.xml、mapred-site.xml、hdfs-site.xml、core-site.xml

Hive1個文件: ? ? ? ? hive-site.xml

結果如下所示

?(四)復制需要的jar包

1、從Hive安裝路徑的lib目錄復制以hive開頭的jar包,復制到hdp30\lib文件夾

文件路徑:/opt/install/kettle9.2/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp30/lib

?2、復制Hadoop安裝目錄下的?hadoop-common-3.1.3.jar到hdp30\lib里

文件路徑:/opt/install/kettle9.2/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp30/lib

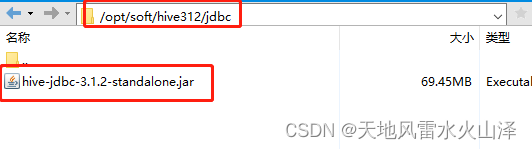

3、把hive的安裝路徑hive312/jdbc里的驅動包復制到 kettle9.2的data-integration\lib文件下

(1)hive312/jdbc里的驅動包文件路徑

?(2)目標文件路徑:/opt/install/kettle9.2/data-integration/lib

?

?

(五)啟動Hadoop和Hive服務,打開kettle9.2,連接Hive數據庫

kettle9.2連接hive312,連接成功!?

(六)執行從Hive到ClickHouse的kettle任務,測試一下

kettle任務運行成功!?

(七)注意Hive數據庫的中文亂碼問題?

解決方法:kettle9.2在配置Hive數據庫時在高級模塊添加set names utf8;? ? ? ? ? ?配置好后測試一下

?

到這里,Linux上安裝的Kettle9.2.0連接Hive3.1.2數據庫就結束了!

樂于奉獻共享,幫助你我他!!!

3.3 BSW的通信功能)

)