參考

5.1 二維卷積層

卷積神經網絡(convolutional neural network)是含有卷積層(convolutional layer)的神經網絡。本章介紹的卷積神經網絡均使用最常見的二維卷積層。它有高和寬兩個空間維度,常用來處理圖像數據。本節中,我們將介紹簡單形式的二維卷積層的工作原理。

5.1.1 二維互相關運算

![[外鏈圖片轉存失敗,源站可能有防盜鏈機制,建議將圖片保存下來直接上傳(img-R6BW7Hcg-1594090508304)(attachment:image.png)]](https://img-blog.csdnimg.cn/20200707105601961.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3BpYW5vOTQyNQ==,size_16,color_FFFFFF,t_70)

# 將上述過程實現在 corr2d 函數里.它接受輸入數組 X 與核數組 K,并輸出數組 Y

import torch

from torch import nndef corr2d(X, K): # 本函數已保存在d2lzh_pytorch包中方便以后使用h, w = K.shapeY = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))for i in range(Y.shape[0]):for j in range(Y.shape[1]):Y[i, j] = (X[i: i + h, j: j + w] * K).sum()return Y

X = torch.tensor([[0, 1, 2], [3, 4, 5], [6, 7, 8]])

K = torch.tensor([[0, 1], [2, 3]])

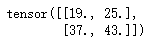

corr2d(X, K)

5.1.2 二維卷積層

二維卷積層將輸入和卷積核做互相運算,并加上一個標量偏差來得到輸出。卷積層的模型參數包括了卷積核和標量偏差。在訓練模型的時候,通常我們先對卷積核進行隨機初始化,然后不斷迭代卷積核和偏差。

下面基于corr2d函數實現一個自定義的二維卷積層。在構造函數__init__里,我們聲明了weight和bias這兩個模型參數。前向計算函數forward則是直接調用corr2d函數在加上偏差

class Conv2D(nn.Module):def __init__(self, kernel_size):super(Conv2D, self).__init__()self.weight = nn.Parameter(torch.randn(kernel_size))self.bias = nn.Parameter(torch.randn(1))def forward(self, x):return corr2d(x, self.weight) + self.bias

5.1.3 圖像中物體邊緣檢測

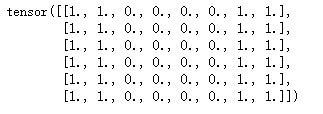

下面我們來看一個卷積的簡單應用: 檢測圖像物體的邊緣,即找到像素變化的位置。首先我們構造一張 6 * 8 的圖像。它中間4列為黑(0),其余為白(1)

X = torch.ones(6, 8)

X[:, 2:6] = 0.

X

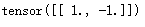

然后我們構造一個高和寬分別為1和2的卷積核K。當它與輸入做相關運行時,如果橫向相鄰元素相同,輸出為0; 否則輸出為非0.

K = torch.tensor([[1., -1.]])

K

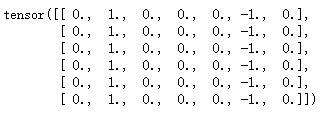

下面將輸入X和我們設計的卷積核K做相關運算。可以看出,我們將從白到黑和從黑到白的邊緣分別檢測成了1和-1。其余部分的輸出全是0

Y = corr2d(X, K)

Y

5.1.4 通過數據學習核數組

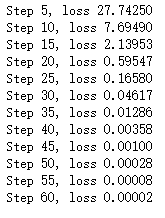

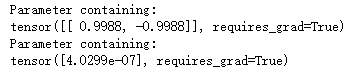

最后我們來看一個例子,它使用物體邊緣檢測中的輸入數據X和輸出數據Y來學習我們構造的核數組K。我們首先構造一個卷積層,其卷積核將被初始化成隨機數組。接下來在每一次迭代中,我們使用平方誤差來比較Y和卷積層的輸出,然后計算梯度來更新權重。

# 構造一個核數組

conv2d = Conv2D(kernel_size=(1, 2))step ,lr = 60 , 0.01for i in range(step):Y_hat = conv2d(X)l = ((Y_hat - Y) ** 2).sum()l.backward()# 梯度下降conv2d.weight.data -= lr * conv2d.weight.gradconv2d.bias.data -= lr * conv2d.bias.grad# 梯度清0conv2d.weight.grad.fill_(0)conv2d.bias.grad.fill_(0)if(i + 1) % 5 == 0:print("Step %d, loss %.5f "% (i+1, l.item()))

print(conv2d.weight)

print(conv2d.bias)

![[51CTO]給您介紹Windows10各大版本之間區別](http://pic.xiahunao.cn/[51CTO]給您介紹Windows10各大版本之間區別)

-NSData轉換成int)

)

![[pytorch、學習] - 5.2 填充和步幅](http://pic.xiahunao.cn/[pytorch、學習] - 5.2 填充和步幅)

![[pytorch、學習] - 5.3 多輸入通道和多輸出通道](http://pic.xiahunao.cn/[pytorch、學習] - 5.3 多輸入通道和多輸出通道)

![[pytorch、學習] - 5.4 池化層](http://pic.xiahunao.cn/[pytorch、學習] - 5.4 池化層)

![[pytorch、學習] - 5.5 卷積神經網絡(LeNet)](http://pic.xiahunao.cn/[pytorch、學習] - 5.5 卷積神經網絡(LeNet))

![[pytorch、學習] - 5.6 深度卷積神經網絡(AlexNet)](http://pic.xiahunao.cn/[pytorch、學習] - 5.6 深度卷積神經網絡(AlexNet))

UVA - 519)