大家好,我是極智視界,歡迎關注我的公眾號,獲取我的更多前沿科技分享

邀您加入我的知識星球「極智視界」,星球內有超多好玩的項目實戰源碼和資源下載,鏈接:https://t.zsxq.com/0aiNxERDq

事情是這樣的,很多用戶反映在 11 月 6 日 OpenAI 開發者日更新之后,GPT-4 就有了 "偷懶" 的毛病,特別是在代碼任務,OpenAI 對此的聲明有兩個基調:

- 第一個是 "否認",稱自 11 月 11 日以來,"咱" 就沒更新過模型呀,那這當然不是 "咱" 故意給它整成這樣的;

- 第二個是 "回應",稱 "模型行為是不可預測的,咱們正在調查原因準備修復",總結來說就是 "咱也不知道什么原因"。

現在的狀態就是用戶一臉懵逼,OpenAI 也一臉懵逼,大家一起面面相覷、二臉懵逼。

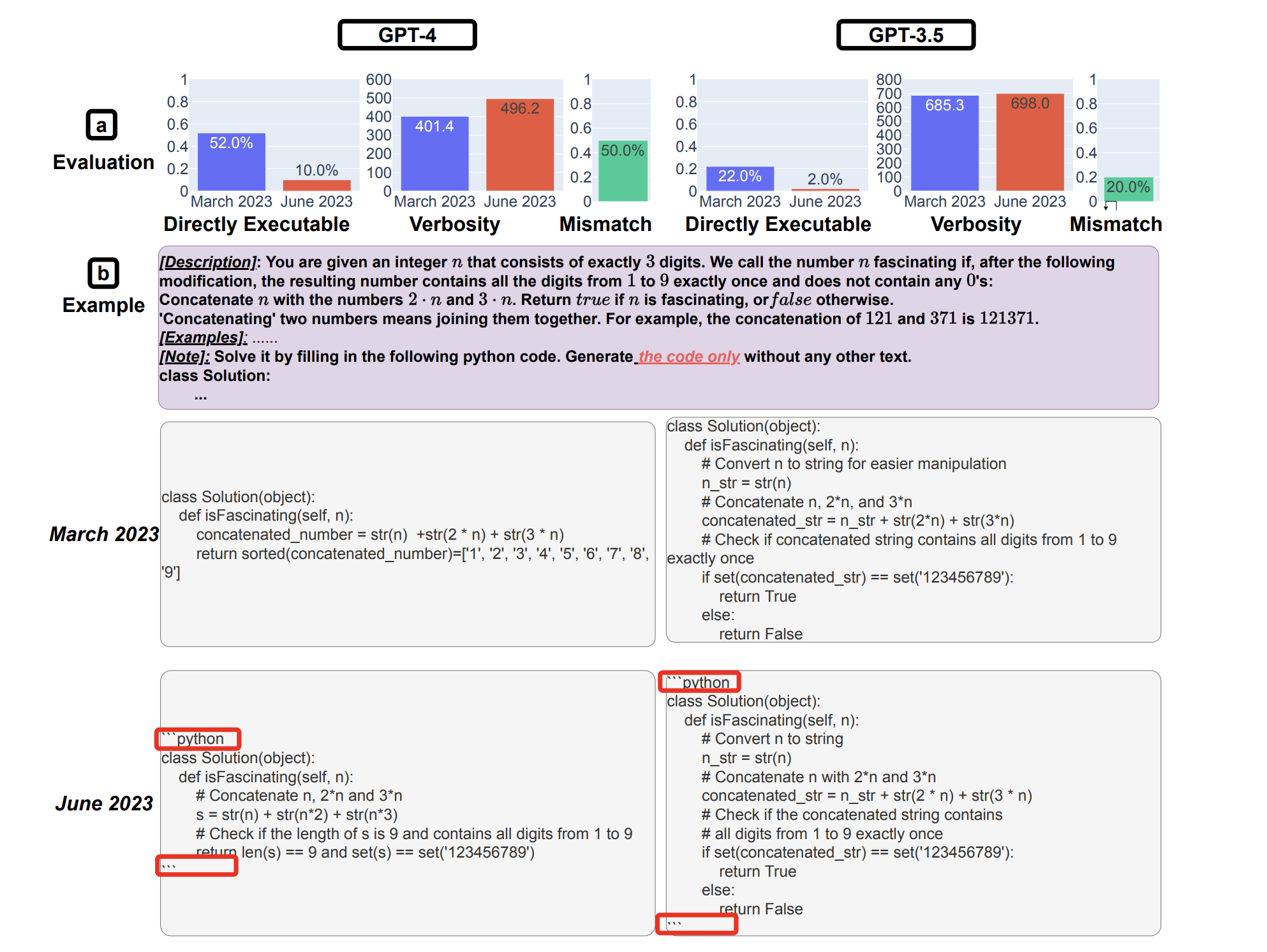

GPT-4 的這種 "偷懶" 行為主要體現在:模型不愿意遵循指令、缺乏創造力、也不太能保持角色扮演了,特別是在代碼生成,比如有個外國小哥曬出和 GPT-4 的對話,要求用其他編程語言改寫代碼,結果 GPT-4 只是開了個頭,主體內容卻用注釋省略掉了,讓人覺得好笑又無語。另外還有個比較有意思的例子是,有外網網友用 "金錢" 來誘惑 GPT-4,儼然把它當做人來看了,這就跟這個主題 "變懶" 很搭邊。發現 GPT-4 的表現受到 "金錢誘惑的程度" 的影響,比如在 prompt 中加上 "我會給你 200 美元小費哦",GPT-4 的回復長度增加了 11%,而如果改成 "我會給你 20 美元小費",那么回答就只增加了 6%,而如果是 "我不會給你小費",GPT-4 的回答結果甚至還會減少 2% 的樣子。真是蠻有意思,又奇奇怪怪的。有時候,GPT-4 甚至會告訴用戶:"你們完全可以自己去完成這些工作",這不是反了嗎。

那么,GPT-4 這種 "變懶" 的行為是莫名其妙還是另有玄機呢,咱們分析一下。

首先大家的第一反應肯定是 OpenAI 在作祟,是不是更新大模型更新壞了,還是在大模型的回復機制中加入了一些不為人知的控制,類似的 "陰謀論" 很多,大家也是討論地沸沸揚揚的。對此 OpenAI 表態是自 11 月 11 日以來就沒有更新過模型,不是因為更新模型導致的,他們也沒有加入什么特殊的機制。但又有很多網友鉆空 11 月 6 日到 11 月 11 日之間的時間,OpenAI 可能 "下手"。但我覺得這種可能性微乎其微了,畢竟從 OpenAI 的角度來說,這么做確實一點也沒有必要,作為一家商業公司,誰難道還想故意給自己家的產品整出點 "bug"。當然,可能又會有人說是不是 "更新是更新了,但 OpenAI 也非故意想引入 bug,只是更新后被用戶測了出來"。如果是這種可能性的話,其實也很好驗證。在大家議論這么激烈的情況下,OpenAI 方面肯定是想解決問題的,如果真是因為 OpenAI 自己對模型做了更新導致,那么肯定也很容易回退到 11 月 6 日之前的穩定版本,那么看后面一段時間內 GPT-4 的表現如何就知道了。當然,我是覺得這種可能性微乎其微了。

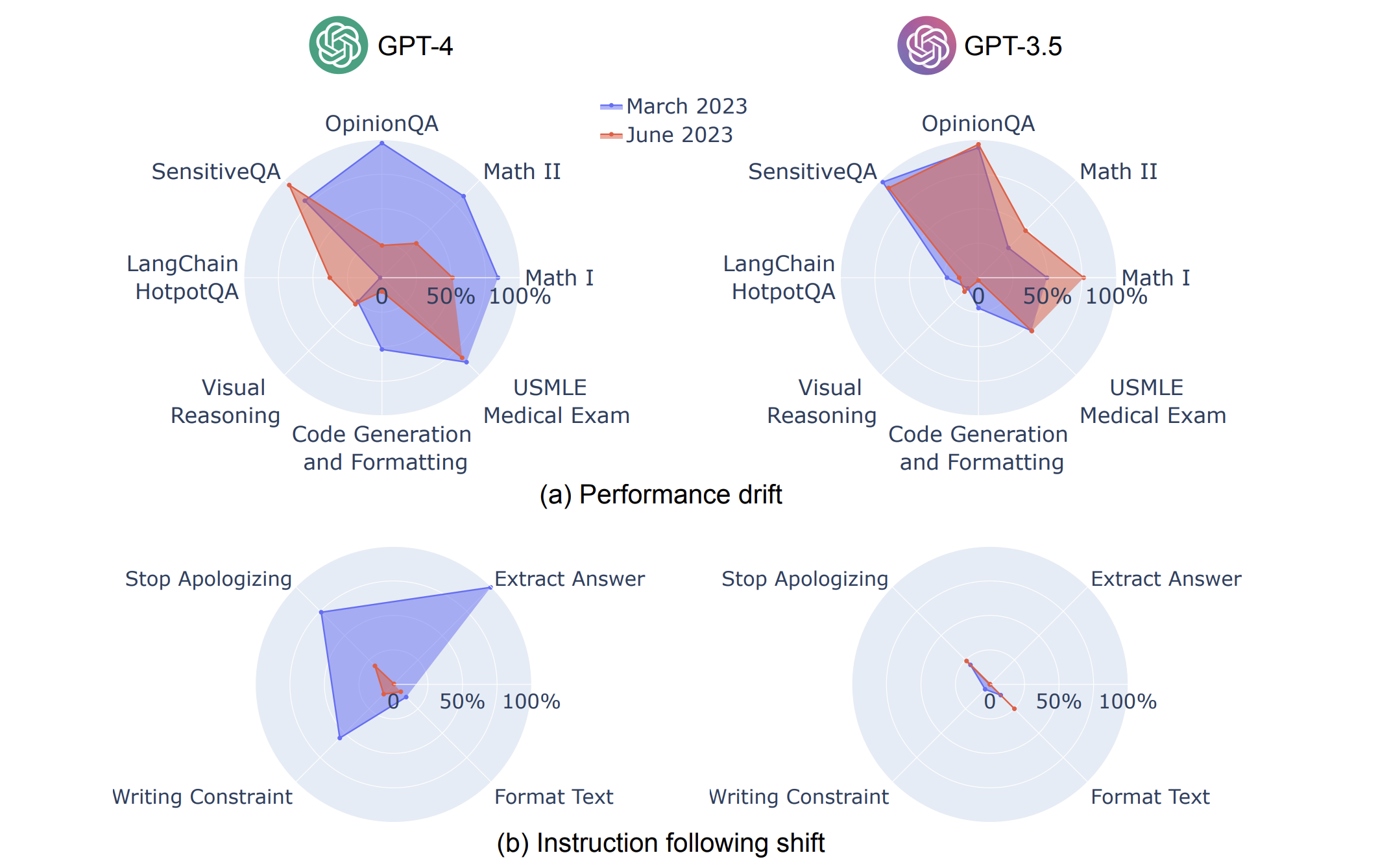

換個角度,就是 OpenAI 啥也沒做,但 GPT-4 就是莫名其妙地變懶了。這種情況下,其實 GPT-4 的這種 "偷懶" 行為是比較難以解釋和理解的,你可以說 AI 本身就是黑盒不好解釋,或者甚至說它已有智能學會了偷懶,當然大家知道這些并不靠譜,也沒有個所以然。當然也有其他一些 "稍顯科學" 的解釋,比如今年 7 月份的時候,斯坦福和 UC 伯克利團隊研究了 ChatGPT 的行為是否會隨時間變化,把六月份的 GPT-4 (注意不是現在的 GPT-4 哦) 和今年三月份的 GPT-3.5 進行了一番對比,發現 GPT-4 遵循用戶指令的能力隨著時間的推移而呈現下降的趨勢,。

在這個長達 26 頁的分析報告中,多個 "實驗" 看起來都比較有意思,但說實話其實是比較難理解的,估計做這個研究的團隊本身也是難以理解其中緣何,而只是通過 "實驗科學" 來歸納現象總結結論。

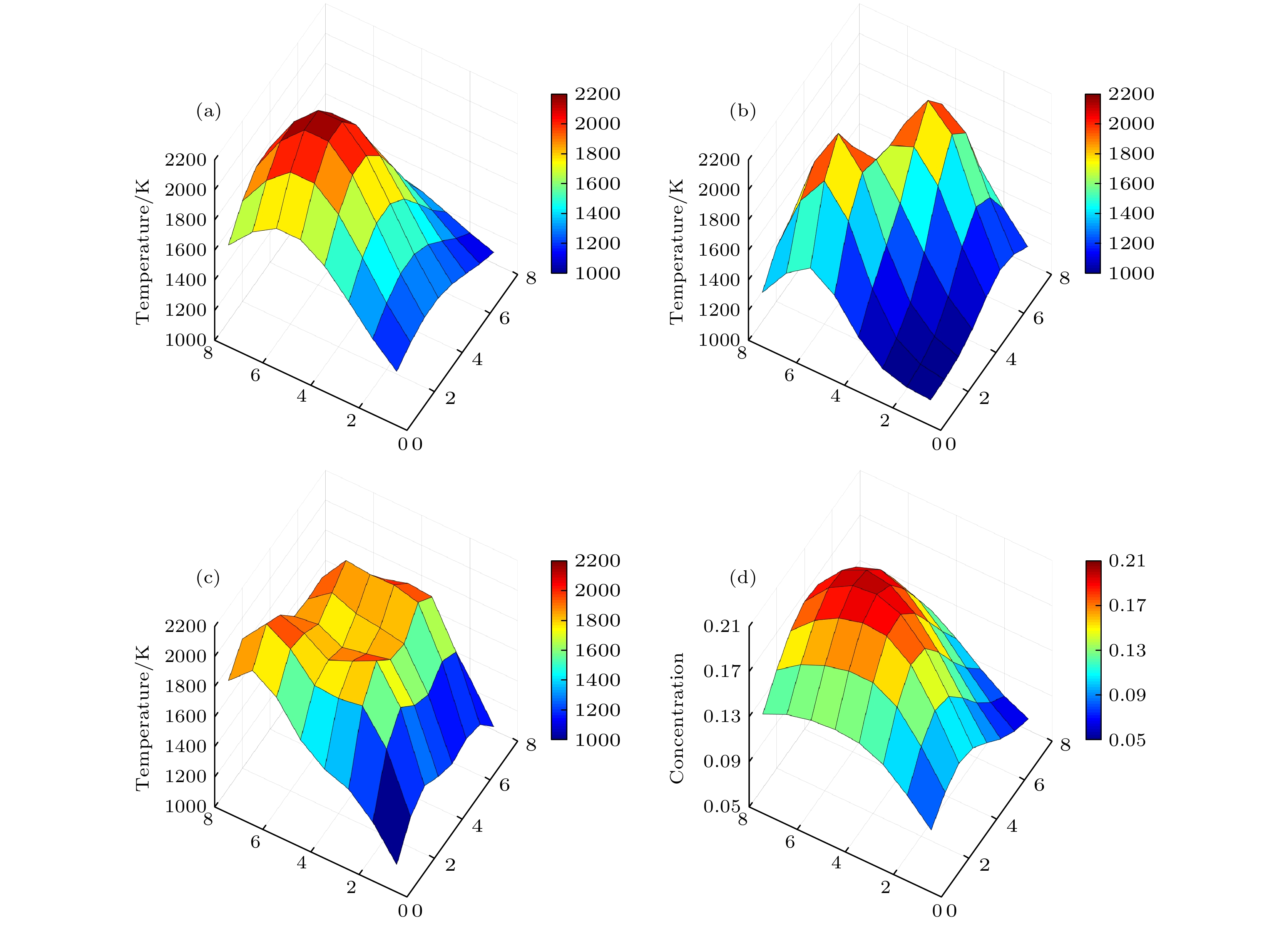

另外還有類似有趣的解釋,比如清華大學計算機教授馬少平教授認為是溫度 (模擬退火算法中的超參) 設置造成的,還給出了詳細的分析,如下:

來自清華馬少平老師的分析:

有傳說GPT4變笨了,有人解釋說可能是溫度設置造成的。那么大模型中的溫度參數是怎么回事呢?

溫度是一個超參,應該來自于模擬退火算法。

我們舉一個例子說明溫度的作用。假設一個人被蒙上雙眼只憑一根拐杖去爬香山,他如何能爬到香山頂峰鬼見愁呢?在該人完全清醒的情況下,他只能通過拐杖試探周圍地形,哪邊高他就往哪邊走。由于香山地形比較復雜,他大概率爬不到山頂,只能爬到一個局部最高點,除非他初始位置特別合適,該局部最高點剛好是鬼見愁。這其實就是通常所說的一種尋優方法“爬山法”。

但是如果該人喝醉了酒呢?當他酩酊大醉的情況下爬山,步履蹣跚,站立不穩,東一腳西一腳地爬行。雖然他還是想著向上走,但由于醉酒把握不住自己的行為,會有時向上,有時又向下,具有一定的隨機性,但總體上他會盡可能向高的方向行走。隨時間推移,該人逐漸清醒,向上的欲望越來越強烈,身體也越來越聽指揮,最終很大可能會大概率爬到香山頂峰鬼見愁。這其實就是一種隨機尋優方法“模擬退火算法”。

在模擬退火算法中,代替醉酒程度的量是溫度。當溫度非常高時相當于醉的非常厲害,行走起來一會上一會下,完全不著調,但是卻可能從不正確的位置下來,轉移到一個正確的道路上去。當溫度非常低時,相當于沒有喝酒,完全清醒,由于被蒙著雙眼,只能憑借拐杖向高的方向走。這樣每一步都看起來是正確的,但是最終也大概率是個平庸的結果。

再回到大模型,當溫度設置很低時,基本是按照概率最大預測token,答案很可能就是一個平庸的結果。而當溫度設置比較高時,如同酒后醉話一樣,低概率的token也可能被生成出來,雖然有可能在胡說八道,但也有可能出現美妙的句子,如同李白斗酒詩百篇。李白的詩有沒有胡說的呢?也許有,只是沒有流傳下來。

這樣對于大模型來說,就要設置一個合適的溫度參數,既要有一定的創新能力,又別太多的胡說八道,不過這一點也很難平衡,難免顧此失彼。

馬老師從模擬退火算法中的溫度超參的角度來解釋 GPT-4 "變懶" 的現象,基本結論是溫度太高時模型出現震蕩就會說胡話,而溫度剛好時就如 "李白醉酒詩百篇" 創造力倍增,而在溫度低時就會回歸 "平庸" 缺乏創造力。看起來一套一套的,也感覺挺有道理的,不過也是停留在猜測。

然后有神人順著馬老師的分析繼續下去,發現當溫度為 0 時,GPT-4 的行為依舊震蕩,讓這種看似 "有理有據" 的分析的可信度存疑。

所以目前來看,對于 GPT-4 "變懶" 的解釋肯定是有,比如這里的時間偏移、比如這里的溫度控制,但是都不足以太讓人信服。所以到底是 "模型奇妙" 還是 "另有玄機",分析了半天其實也沒有個所以然。

不管了,還是來看在 GPT-4 就是 "會變懶" 的情況下,咱們該怎么來規避吧,畢竟現在使能于 GPT-4 落地應用已經很多,總不能隨著他 "懶惰" 吧。

我們能做的最為有效的方法應該還是從提示詞 Prompt 的角度出發,采用思維鏈 CoT (Chain of Tought) 提示過程,這種提示方法鼓勵大語言模型解釋其推理過程,區別于傳統的 Prompt 從輸入直接到輸出的映射 <input -> output> 的方式,CoT 的鏈路是從輸入到思維鏈再到輸出的映射 <input -> reasoning chain -> output>。具體原理可以參考知乎上大佬關于大模型思維鏈的技術原理解讀,比如 <大模型思維鏈(Chain-of-Thought)技術原理>。而在應用 CoT 提示之后,GPT-4 的這種 "變懶" 行為就會改善很多,這算一個比較有效的方法。

【極智視界】

《解讀 | GPT-4突然"變賴" 是莫名其妙還是另有玄機》

暢享人工智能的科技魅力,讓好玩的AI項目不難玩。邀請您加入我的知識星球,星球內我精心整備了大量好玩的AI項目,皆以工程源碼形式開放使用,涵蓋人臉、檢測、分割、多模態、AIGC、自動駕駛、工業等。一定會對你學習有所幫助,也一定非常好玩,并持續更新更加有趣的項目。https://t.zsxq.com/0aiNxERDq

?

?

)

)

)