參考:

Apache openNLP 簡介 - 鏈滴 (ld246.com)

opennlp 模型下載地址:Index of /apache/opennlp/models/ud-models-1.0/ (tencent.com)

OpenNLP是一個流行的開源自然語言處理工具包,它提供了一系列的NLP模型和算法。然而,OpenNLP的官方發布版本并沒有直接支持中文語言模型。但你可以通過以下步驟使用OpenNLP來處理中文文本: 1. 分詞(Tokenization):由于OpenNLP沒有中文分詞模型,你可以考慮使用其他中文分詞工具,如jieba或HanLP,來進行中文分詞。 2. 詞性標注(Part-of-Speech Tagging):OpenNLP提供了通用的詞性標注模型,可以用于標注英文文本的詞性。如果你需要對中文文本進行詞性標注,可以嘗試使用其他中文NLP工具,如HanLP。 3. 命名實體識別(Named Entity Recognition):OpenNLP提供了命名實體識別模型,可以用于英文文本。如果你需要對中文文本進行命名實體識別,可以考慮使用其他中文NLP工具,如HanLP。 需要注意的是,雖然OpenNLP是一個強大的NLP工具包,但它的官方版本并沒有直接支持中文語言模型。因此,在處理中文文本時,建議選擇專門針對中文的NLP工具,以獲得更好的效果和準確性。

好吧,考慮下中文的NLP工具包

?參考:【精選】HanLP 自然語言處理使用總結-CSDN博客

添加依賴

<!--hanlp 依賴--><dependency><groupId>com.hankcs</groupId><artifactId>hanlp</artifactId><version>portable-1.8.4</version></dependency>此時即可使用基本功能(除由字構詞、依存句法分析外的全部功能)。如果需要使用全部功能還需下載詞典和模型,下載地址:

http://nlp.hankcs.com/download.php?file=data

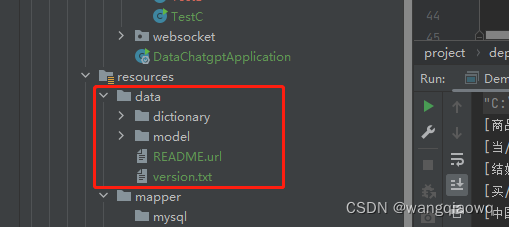

將下載后的data目錄,拷貝至項目的?resources?目錄下:

其中數據分為詞典和模型,其中詞典是詞法分析必需的,模型是句法分析必需的,用戶可以自行增刪替換,如果不需要句法分析等功能的話,隨時可以刪除model文件夾。

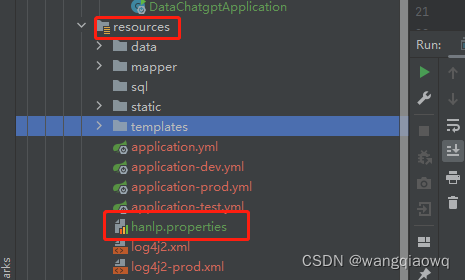

下面還需要進行?HanLP?的配置,可以下載官方的配置模板:

http://nlp.hankcs.com/download.php?file=jar

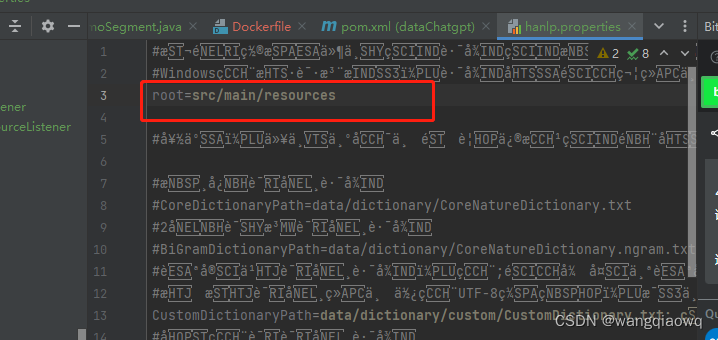

解壓后將?hanlp.properties文件拷貝至?resources?目錄下,并修改下面配置:

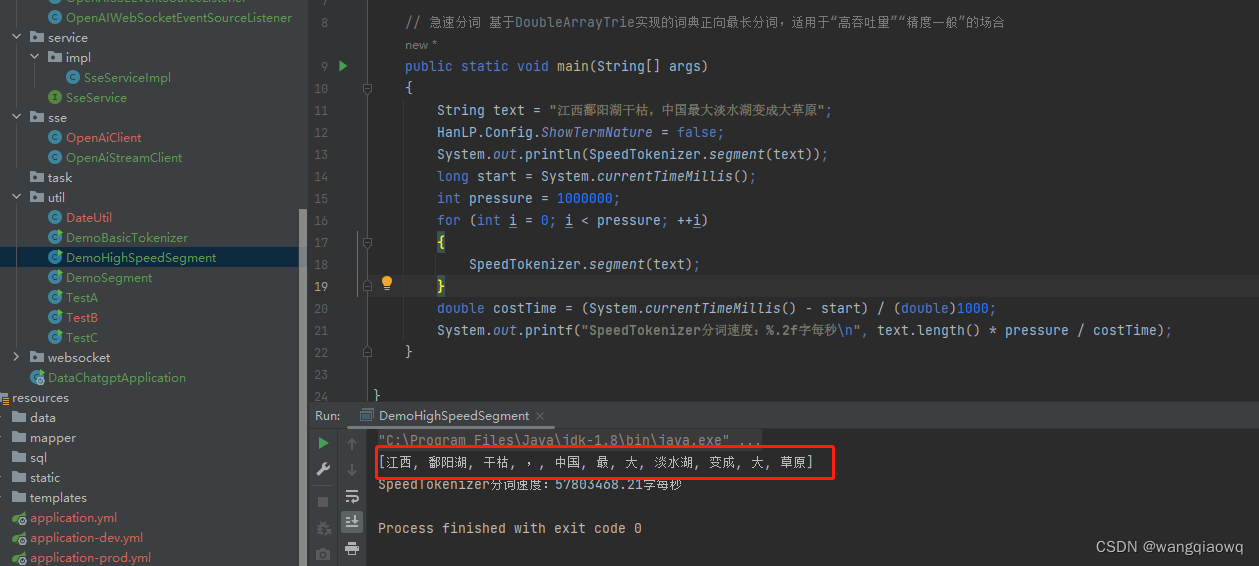

測試例子:

其他例子還在學習中。。

嵌入(Embedding)是一種將高維向量映射到低維向量空間的技術,它在自然語言處理(NLP)中得到了廣泛的應用。嵌入可以將詞語或短語表示為低維向量,這些向量可以用于許多NLP任務,如文本分類、情感分析、命名實體識別等。

在NLP中,嵌入通常是通過訓練神經網絡來學習的。訓練過程中,神經網絡會將每個詞語或短語表示為一個向量,并且這些向量應該能夠捕捉到它們在語義空間中的相似性。例如,嵌入模型應該能夠將“貓”和“狗”表示為相似的向量,因為它們在語義上具有相似之處。

常見的嵌入模型有Word2Vec、GloVe和FastText等。這些模型使用不同的算法和技術來生成詞嵌入。Word2Vec和GloVe是兩種流行的詞嵌入模型,它們都是基于矩陣分解的方法。FastText是一種基于子詞的詞嵌入模型,它可以處理未登錄詞(Out-of-Vocabulary)問題。

在使用嵌入時,可以使用預訓練的嵌入模型,也可以使用自己的數據集來訓練嵌入模型。預訓練的嵌入模型通常在大型語料庫上訓練,可以直接用于許多NLP任務。如果你的數據集與預訓練模型的領域不同,你可以使用自己的數據集來訓練嵌入模型,以生成更適合你的任務的嵌入。

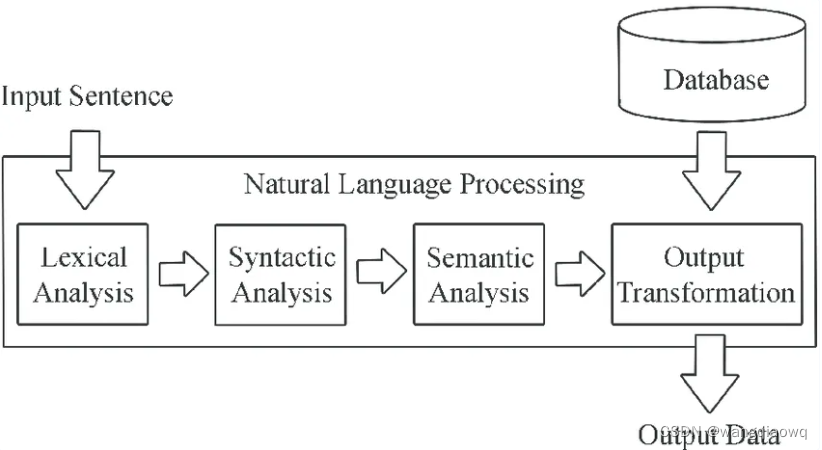

NLP如何工作?

一般來說,NLP技術包括4個主要步驟:

- 詞匯分析: 將一個句子分割成被稱為 “標記” 的詞或小單元的過程,以確定它的含義和它與整個句子的關系。

- 句法分析: 識別一個句子中不同的詞和短語之間的關系,規范它們的結構,并以層次結構來表達這些關系的過程。

- 語義分析: 將句法結構,從短語、分句、句子和段落的層次到整個寫作的層次,與它們的語言無關的含義聯系起來的過程。

- 輸出轉換: 在對文本或語音進行語義分析的基礎上,生成符合應用目標的輸出的過程。

根據NLP的應用,輸出將是一個翻譯或完成一個句子,一個語法糾正,或基于規則或訓練數據生成的反應。

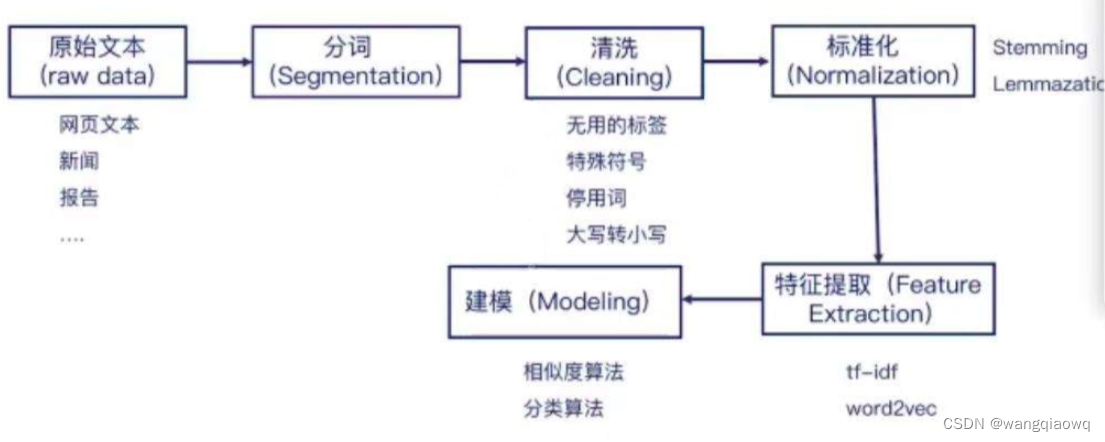

自然語言實現一般都通過以下幾個階段:文本讀取、分詞、清洗、標準化、特征提取、建模。首先通過文本、新聞信息、網絡爬蟲等渠道獲取大量的文字信息。然后利用分詞工具對文本進行處理,把語句分成若干個常用的單詞、短語,由于各國的語言特征有所區別,所以NLP也會有不同的庫支撐。對分好的詞庫進行篩選,排除掉無用的符號、停用詞等。再對詞庫進行標準化處理,比如英文單詞的大小寫、過去式、進行式等都需要進行標準化轉換。然后進行特征提取,利用 tf-idf、word2vec 等工具包把數據轉換成詞向量。最后建模,利用機器學習、深度學習等成熟框架進行計算。

參考:【精選】NLP 自然語言處理實戰_nlp項目實戰_風塵浪子的博客-CSDN博客

求解微電網多目標優化調度(MATLAB代碼))

:函數遞歸與迭代,二者有什么區別)

)

)

——算術運算符)