學習TTS遇到的問題2 什么是TCN模型

- 什么是TCN模型

- 怎么理解 TCN中的 dilation?

- 什么是 Dilation

- 具體例子

- 數學表達

- 作用

- 例子

- 代碼示例

什么是TCN模型

https://juejin.cn/post/7262269863343079479

https://blog.csdn.net/weixin_57726558/article/details/132163074

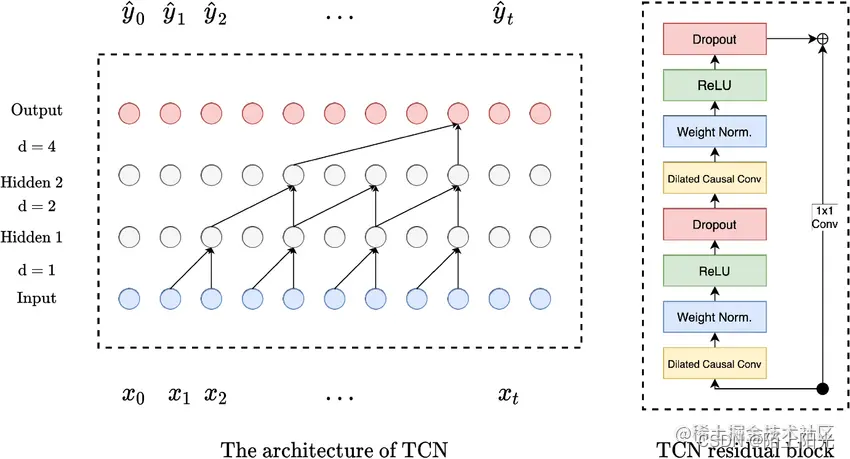

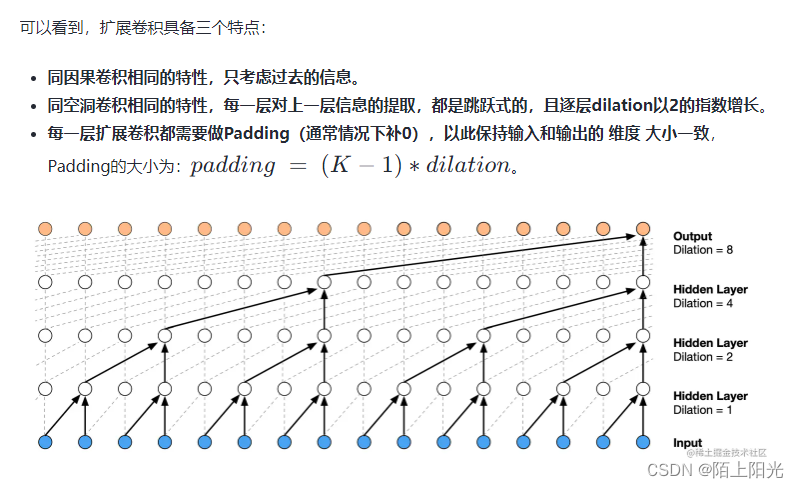

由下圖箭頭可知,TCN第一層,每相鄰兩個單元輸出到一個單元,下一層網絡間隔一個單元輸出到下一層網絡,第三層網絡間隔2的指數 兩個單元輸出到下一層網絡, 一直繼續下去網絡的頂層能看到底層所有單元的信息。

怎么理解 TCN中的 dilation?

dilation=1, 可以看到 2 ? 1 2*1 2?1的輸入單元–信息

dilation=2, 可以看到 2 ? 2 2*2 2?2的輸入單元–信息

dilation=4, 可以看到 2 ? 4 2*4 2?4的輸入單元–信息

dilation=8, 可以看到 2 ? 8 2*8 2?8的輸入單元–信息

TCN(Temporal Convolutional Network)中的 dilation(膨脹)是用于在卷積操作中擴展感受野的一種技術。它通過在卷積核之間引入空洞來實現。以下是 dilation 的詳細解釋:

什么是 Dilation

dilation(膨脹)在卷積操作中引入了空洞,使得卷積核的感受野更大,而不需要增加卷積核的大小。具體來說,在應用 dilation 時,卷積核的每兩個相鄰元素之間會有一些間隔。這些間隔的數量由 dilation rate(膨脹率)決定。

具體例子

假設你有一個1維的卷積核 [w0, w1, w2],dilation rate 為 2,則這個卷積核在應用 dilation 后變為 [w0, 0, w1, 0, w2]。這里的 0 表示引入的空洞。

數學表達

在沒有 dilation 的情況下,一個1維卷積操作的輸出可以表示為:

y ( t ) = ∑ k = 0 K ? 1 x ( t ? k ) ? w ( k ) y(t) = \sum_{k=0}^{K-1} x(t-k) \cdot w(k) y(t)=∑k=0K?1?x(t?k)?w(k)

其中:

- y ( t ) y(t) y(t) 是輸出。

- x ( t ) x(t) x(t) 是輸入。

- w ( k ) w(k) w(k) 是卷積核。

- K K K 是卷積核的大小。

當引入 dilation 后,卷積操作的輸出變為:

y ( t ) = ∑ k = 0 K ? 1 x ( t ? d ? k ) ? w ( k ) y(t) = \sum_{k=0}^{K-1} x(t-d \cdot k) \cdot w(k) y(t)=∑k=0K?1?x(t?d?k)?w(k)

其中 d d d 是 dilation rate。這樣,卷積核中的每個元素在輸入序列中間隔 d d d 個元素進行卷積。

作用

- 擴展感受野:dilation 擴展了卷積核的感受野,可以在不增加計算量的情況下捕捉更大范圍的上下文信息。

- 保留分辨率:與池化操作不同,dilation 不會丟失數據的分辨率。

- 有效處理長序列:對于時間序列或序列數據,dilation 有助于捕捉遠距離的依賴關系。

例子

假設有一個長度為 10 的輸入序列 x = [x0, x1, x2, x3, x4, x5, x6, x7, x8, x9],一個卷積核 w = [w0, w1, w2],dilation rate 為 2。卷積操作的過程如下:

y(t) = x(t) * w0 + x(t-2) * w1 + x(t-4) * w2

這個操作會在卷積核的每個元素之間跳過 2 個輸入元素。

代碼示例

以下是 PyTorch 中實現 TCN 的一個簡單示例,展示了如何使用 dilation:

import torch

import torch.nn as nnclass TCN(nn.Module):def __init__(self, input_size, output_size, num_channels, kernel_size=2, dropout=0.2):super(TCN, self).__init__()layers = []num_levels = len(num_channels)for i in range(num_levels):dilation_size = 2 ** iin_channels = input_size if i == 0 else num_channels[i-1]out_channels = num_channels[i]layers += [nn.Conv1d(in_channels, out_channels, kernel_size, stride=1, padding=(kernel_size-1)*dilation_size, dilation=dilation_size),nn.ReLU(),nn.Dropout(dropout)]self.network = nn.Sequential(*layers)self.linear = nn.Linear(num_channels[-1], output_size)def forward(self, x):y1 = self.network(x)y2 = self.linear(y1[:, :, -1])return y2# Example usage

tcn = TCN(input_size=1, output_size=10, num_channels=[25, 50])

input_data = torch.randn(32, 1, 100) # (batch_size, num_channels, sequence_length)

output = tcn(input_data)

print(output.shape) # (batch_size, output_size)

在這個示例中,每一層卷積都會以2的指數倍方式增加 dilation,從而在每一層中逐步擴展感受野。

詳解)

)

】ControlNet 和 IP-Adapter 之間的區別有哪些?)

進程間通信IPC)

:數據傾斜優化)