bug出現背景

集群產生的日志要求traceId不重復,使用雪花算法生成traceId

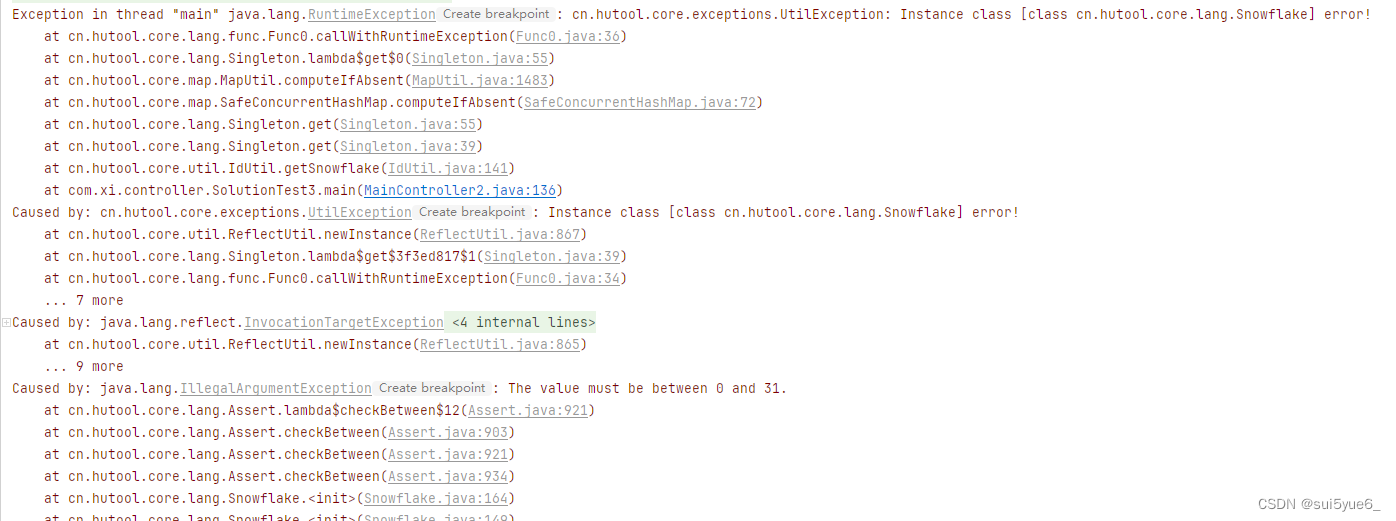

報錯形式如下

為什么本地無法復現測試環境的bug

因為bug的出現本身就是概率性的事件

代碼如下

public static Long workId = Long.parseLong(String.valueOf(NetUtil.getLocalhostStr().hashCode() + new Random().nextInt(99999))) % 31;這里取hashCode后的數字加上99999數字,可能會越界變成負數,因為這里的workId需要在0到31之間就不被滿足

測試復現

public static void main(String[] args) {for (int i = 0; i < 100000; i++) {Long workId = Long.parseLong(String.valueOf(new Random().nextInt(Integer.MAX_VALUE) + new Random().nextInt(99999))) % 31;if (workId < 0) {System.out.println(workId);}}}

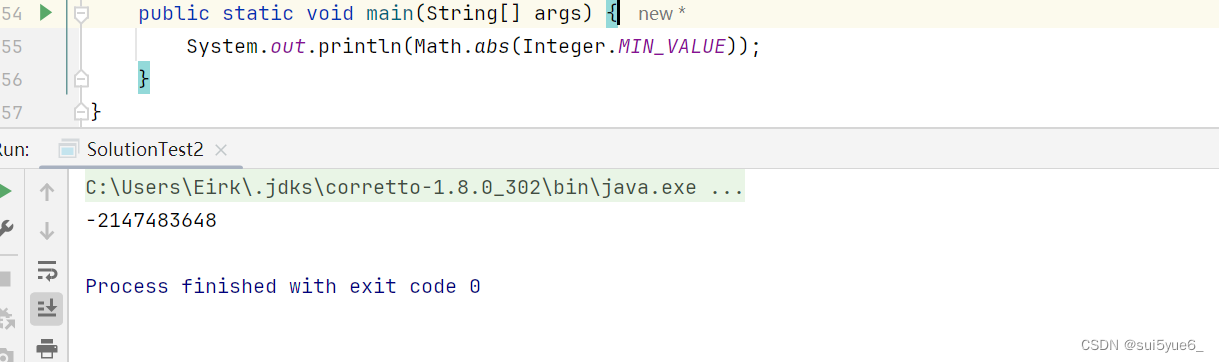

如果有人想到用abs做解決方案的話,會有一種極端情況如下

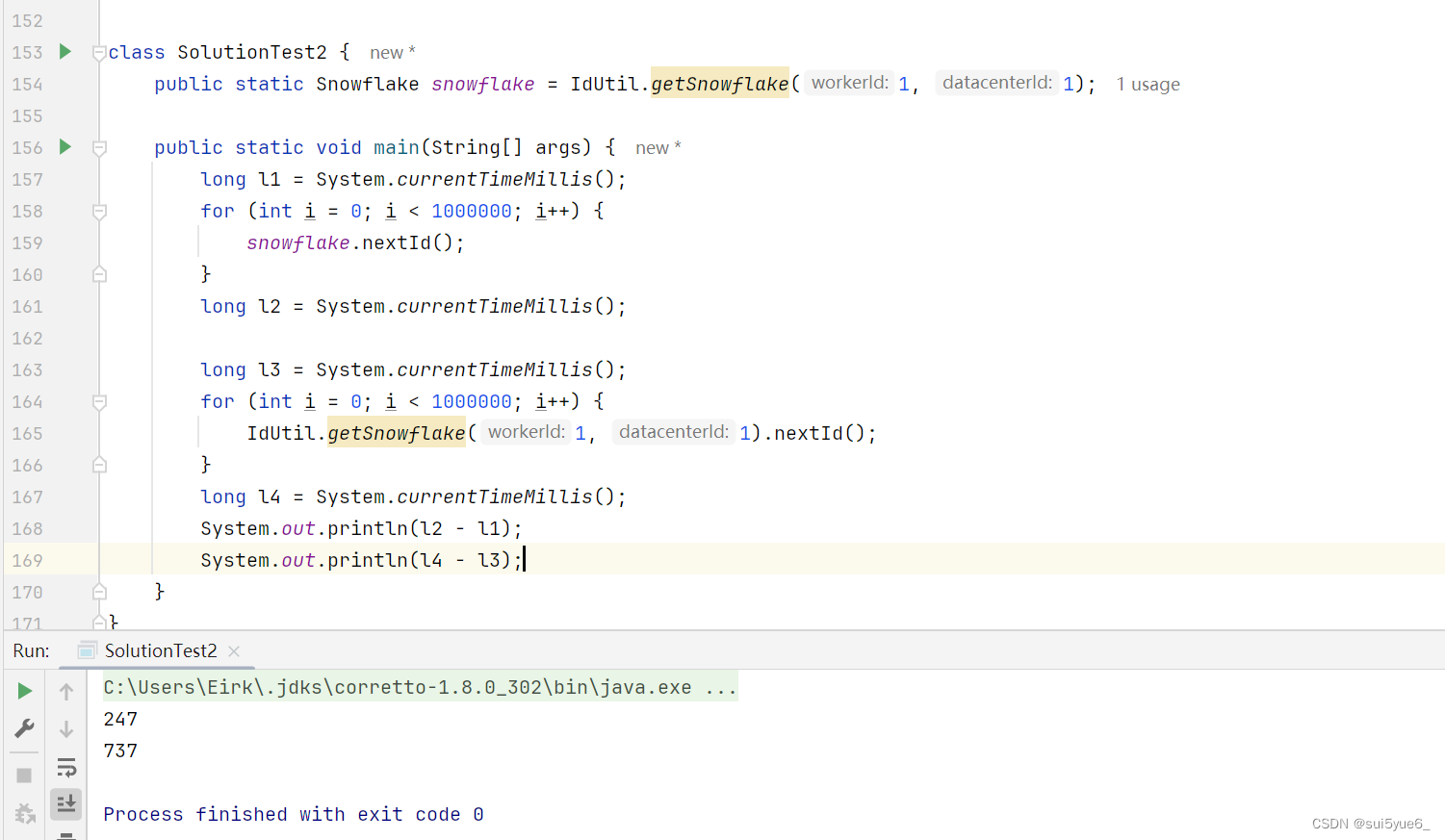

雪花算法的用法

第一種

每次都用工具創建實例,再去生成

return IdUtil.getSnowflake(workId, centerId).nextIdStr();第二種

用工具創建snowflake單例,id每次用單例中生成

// 靜態變量public static Snowflake snowflake = IdUtil.getSnowflake(workId, centerId);return snowflake.nextIdStr();

第一反應,第一種創建的方式是錯誤的。兩個實例對于雪花id的創建是不會有加鎖限制的。

源碼分析

這里是使用Singleton創建public static Snowflake getSnowflake(long workerId, long datacenterId) {return (Snowflake)Singleton.get(Snowflake.class, new Object[]{workerId, datacenterId});}

使用到這里先去get,如果get到直接返回,沒有get到,就反射創建對象public static <T> T get(Class<T> clazz, Object... params) {Assert.notNull(clazz, "Class must be not null !", new Object[0]);String key = buildKey(clazz.getName(), params);return get(key, () -> {return ReflectUtil.newInstance(clazz, params);});}// 存儲實例的地方private static final SafeConcurrentHashMap<String, Object> POOL = new SafeConcurrentHashMap();public static <T> T get(String key, Func0<T> supplier) {return POOL.computeIfAbsent(key, (k) -> {return supplier.callWithRuntimeException();});}

也就是說,hutool工具snowflake開發的時候已經考慮到有 水平不怎么高的程序員使用,而進行了代碼上的兜底。上面的單例對象也可以借鑒學習

性能上也沒有實質性的差距

上面hutool如何保證兩個線程都初始創建對象的時候的絕對單例

SafeConcurrentHashMap 這個map是自己封裝的

重寫了 computeIfAbsent為啥封裝一個靜態的mapUtilpublic V computeIfAbsent(K key, Function<? super K, ? extends V> mappingFunction) {return MapUtil.computeIfAbsent(this, key, mappingFunction);}

沒有找到類似雙重檢查鎖的代碼。。。。到這里結束吧

)

![[C#][opencvsharp]C#使用opencvsharp進行年齡和性別預測支持視頻圖片檢測](http://pic.xiahunao.cn/[C#][opencvsharp]C#使用opencvsharp進行年齡和性別預測支持視頻圖片檢測)

-探索圖像生成基礎模型的最新進展探索多模態代理的最新進展:從視頻理解到可操作代理)