FedCache 2.0引領聯邦邊緣學習性能與通信效率革新

在今天的數字化時代,邊緣計算正迅速成為推動終端設備智能化的核心技術之一;如何在保證數據隱私的同時提高數據在網絡邊緣的處理效率和效果,已成為業界面臨的一大挑戰。最近,《FedCache 2.0: Exploiting the Potential of Distilled Data in Knowledge Cache-driven Federated Learning》一文中提出了一種全新的知識緩存驅動的聯邦學習架構FedCache 2.0,預示著聯邦學習與邊緣智能結合的一大進步。

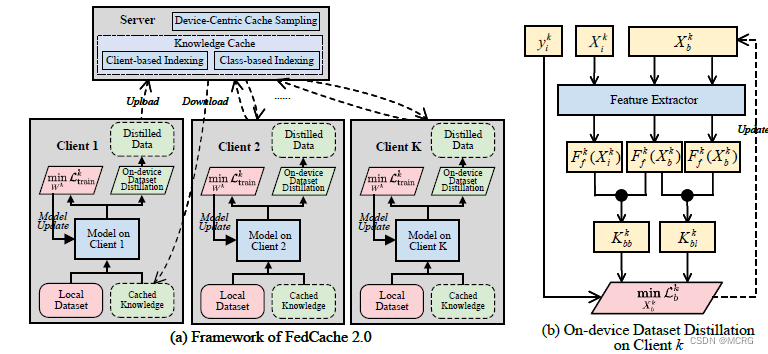

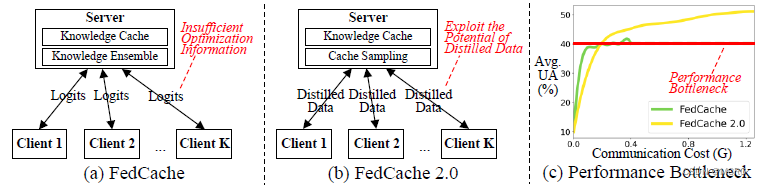

FedCache 2.0架構是在其第一代架構FedCache的基礎上,結合邊緣計算的需求特點進行優化的結果。FedCache 2.0通過引入“知識緩存”(knowledge cache)和“數據蒸餾”技術,突破了第一代FedCache架構的訓練瓶頸,顯著提升了模型的訓練效率和準確性。在這一架構下,服務器不僅存儲原始數據的精簡、脫敏版本,即“蒸餾數據”,而且通過精確控制這些數據的組織、存儲與分發,確保每個設備都能在通信帶寬限制下接收到最適合自己的訓練數據。這種方法不僅減少了數據傳輸量,還提高了數據利用的效率和模型個性化性能。

通過在五個不同的數據集上進行廣泛的實驗,涵蓋圖像識別、音頻理解和移動傳感器數據挖掘任務,FedCache 2.0在所有考慮的設置中都顯著優于現有的最先進方法。實驗結果顯示,與基準方法相比,FedCache 2.0在通信效率上至少提高了28.6倍,大大降低了邊緣設備在實際部署中的帶寬需求。

論文鏈接:https://arxiv.org/abs/2405.13378

開源代碼:https://github.com/poppanda/FedCache2.0

使用統計學方法進行變量有效性測試(43道選擇題))

:順序表集合類ArrayList)

)

)

)