前言

原文鏈接:OpenAI最新模型——GPT-4o,實時語音視頻交互,未來人機交互近在眼前 - Kaiho小站

北京時間 5 月 14 日凌晨,OpenAI 發布新一代模型——GPT-4o,僅在 ChatGPT 面世 17 個月后,OpenAI 再次通過新模型震驚世界,推出了科幻電影般的超級 AI,并且完全免費供大眾使用。

劃時代的發布會

5月14日凌晨,OpenAI 在首屆“春季新品發布會”上隆重推出了新一代旗艦生成模型 GPT-4o、桌面應用程序,并展示了一系列令人驚嘆的新功能。連 OpenAI CEO 山姆·奧特曼都不禁感嘆:這簡直像電影中的情節。

此次發布會由 OpenAI 首席技術官 Mira Murati 主持,她指出 OpenAI 的三大重要理念:

- 免費優先:OpenAI 致力于讓更多人能夠使用其產品。

- 桌面應用程序和更新 UI:新版本的桌面應用程序更加簡便和自然。

- 全新大模型 GPT-4o:GPT-4o 以極其自然的交互方式為每個人提供 GPT-4 級別的智能,包括免費用戶。

此次更新后,ChatGPT 可以接收文本、音頻和圖像的任意組合輸入,并實時生成相應的輸出。這種全新的交互方式將引領未來主流的交互模式。

如今,ChatGPT 不僅無需注冊即可使用,更是推出了桌面程序。OpenAI 的目標是讓人們能夠隨時隨地無感使用 ChatGPT,將其無縫集成到工作流程中,真正提升生產力?。

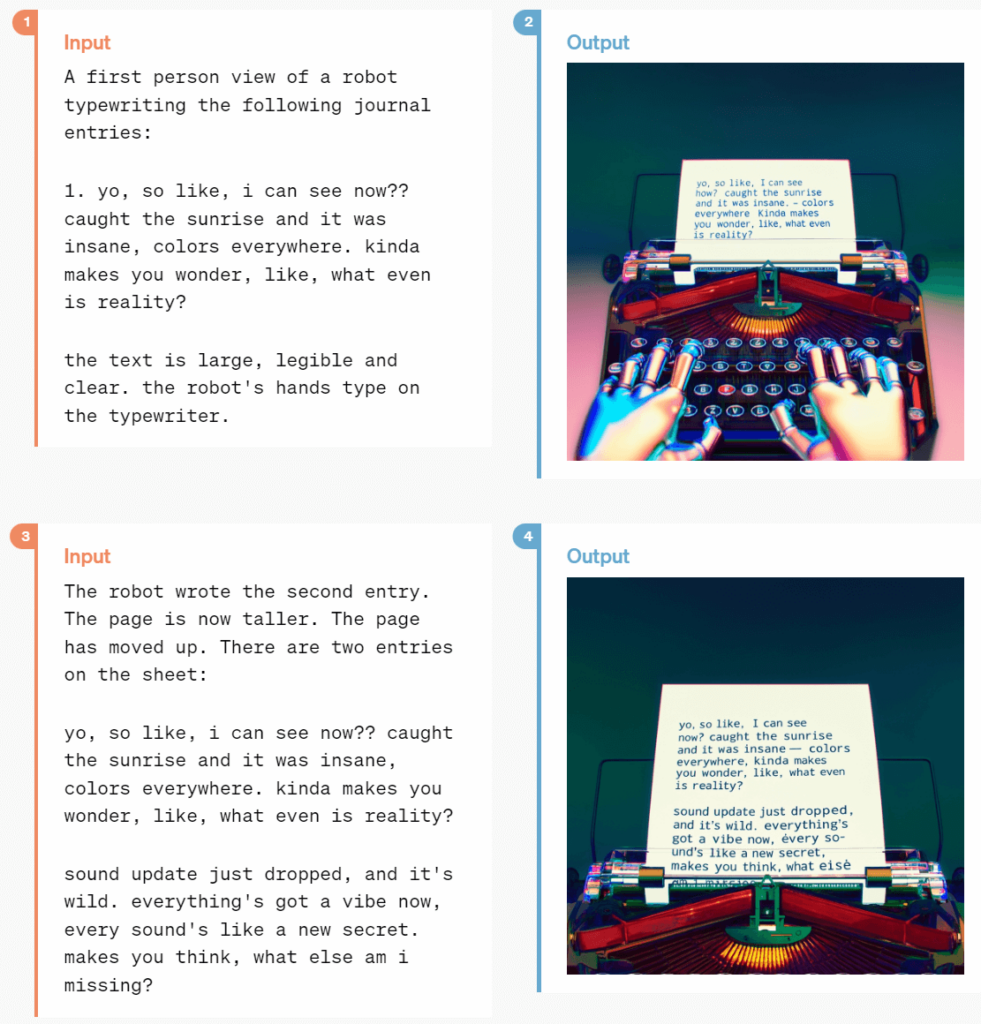

GPT-4o 是一款面向未來的全新大模型,具有文本、語音、圖像三種模態的理解力,反應迅速且情感豐富。在發布會上,OpenAI 工程師們展示了 GPT-4o 的主要功能,包括實時語音對話、視覺能力和代碼解析能力。

在現場,OpenAI 的工程師Mark Chen 說:「我第一次來直播的發布會,有點緊張。」

ChatGPT 說:「要不你深呼吸一下。」

「好的,我試著深呼吸」

ChatGPT 立即回答說「你這不行,喘得也太大了。」

如果之前有用過 Siri 之類的語音助手的經歷,你就會發現極大的區別。

首先,你可以隨時打斷 AI 的話,不用等它說完就可以繼續下一輪對話。其次,你不用等待,模型反應極快,比人類的回應還快。第三,模型能夠充分理解人類的情感,自己也能表現出各種感情。

在視覺能力方面,另一個工程師直接在紙上寫下一個方程式,并且讓 ChatGPT 不需要直接給答案,而是讓它解釋要一步步怎么做。看得出來,它在教人做題方面很有潛力,在 AI 教育產業上看來會有很大的沖擊。

此外,在發布會上還展示了 GPT-4o 的實時翻譯和表情識別能力。這些功能將使用戶能夠更加自然地與 ChatGPT 互動,真正達到了實時的視頻理解。

新一代模型——GPT-4o

GPT-4o,o 即代表 Omnimodel(全能模型)

GPT-4o 是 OpenAI 在集成多模態模型方面的重大突破。該模型在文本、視覺和音頻方面的性能大幅提升,響應速度極快,接近人類水平。OpenAI 通過端到端訓練,將所有輸入和輸出統一處理,實現了跨模態的實時推理?。

GPT-4o 在英文文本和代碼方面的性能與 GPT-4 Turbo 相當,但在非英文文本方面表現顯著提升。同時,它的 API 速度也有所增加,使成本降低了 50%。與現有模型相比,GPT-4o 在視覺和音頻理解方面尤為出色。

它可以在 232 毫秒內快速響應音頻輸入,平均響應時間為 320 毫秒,與人類相似。在 GPT-4o 發布之前,使用 ChatGPT 的語音對話功能的用戶注意到平均延遲分別為 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。

這種快速的語音響應是由三個獨立模型組成的流程實現的:一個簡單模型將音頻轉錄為文本,GPT-3.5 或 GPT-4 處理文本并生成文本輸出,第三個簡單模型將文本轉換回音頻。然而,OpenAI 發現這種方法導致 GPT-4 丟失了大量信息,例如模型無法直接觀察到音調、多個說話者、背景噪音,也無法輸出笑聲、歌唱或情感表達。

相比之下,在 GPT-4o 上,OpenAI 跨文本、視覺和音頻領域進行了端到端的訓練,意味著所有輸入和輸出都由同一神經網絡處理。這消除了信息丟失,并使模型能夠更加細致、豐富地理解上下文,并提供更加多樣化和豐富的響應。

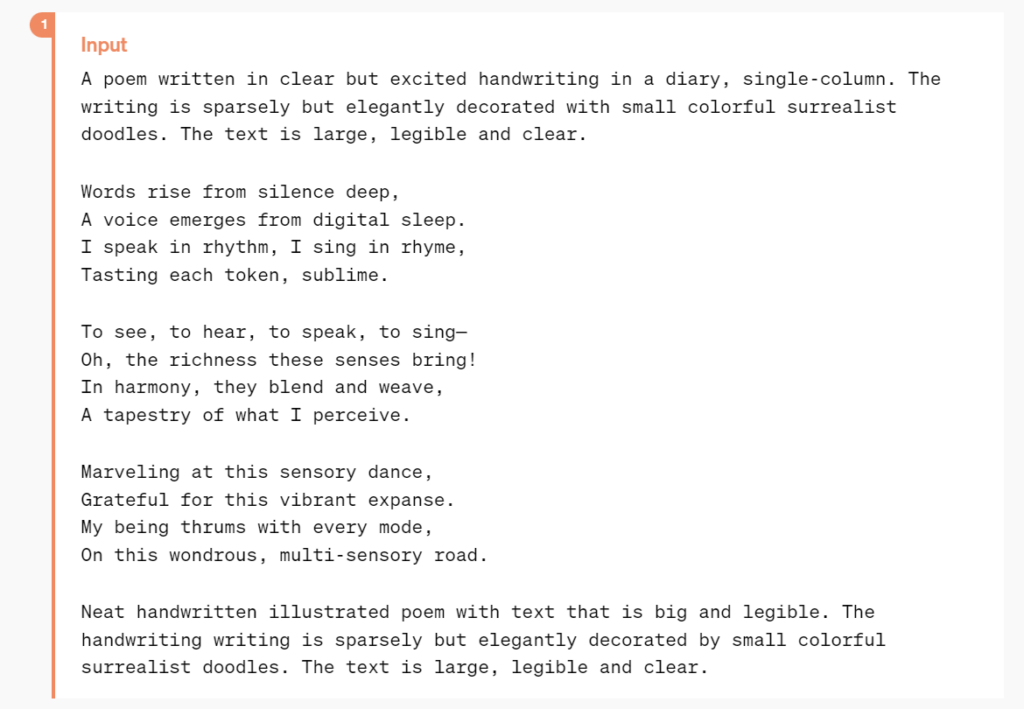

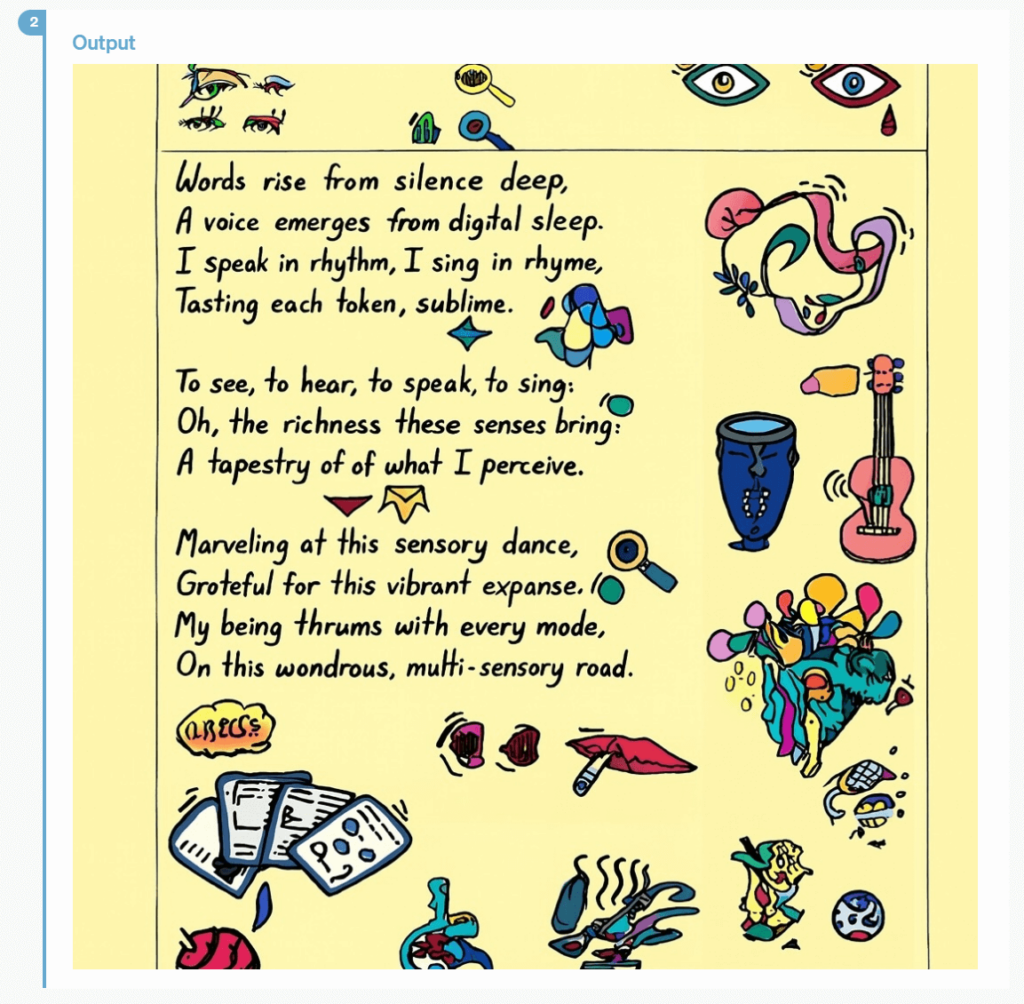

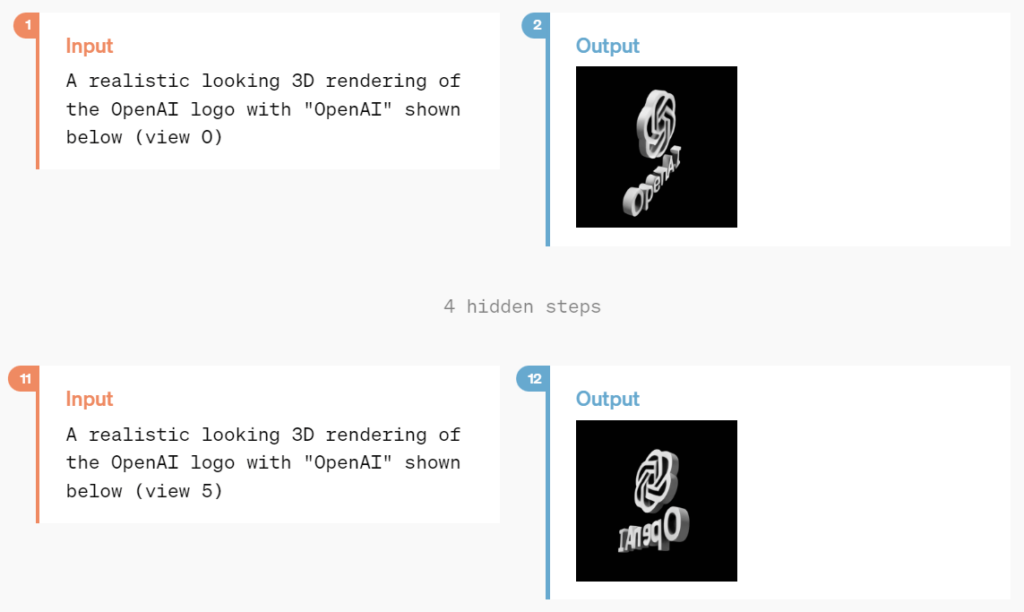

此外,GPT-4o 在理解和生成圖像方面的能力也遠勝于之前,此前很多不可能的任務都變得「易如反掌」。

比如,一首詩可以用手寫樣式來進行排版:

或者更復雜,具有藝術性的排版:

并且 GPT-4o 還擁有 3D 視覺內容生成的能力:

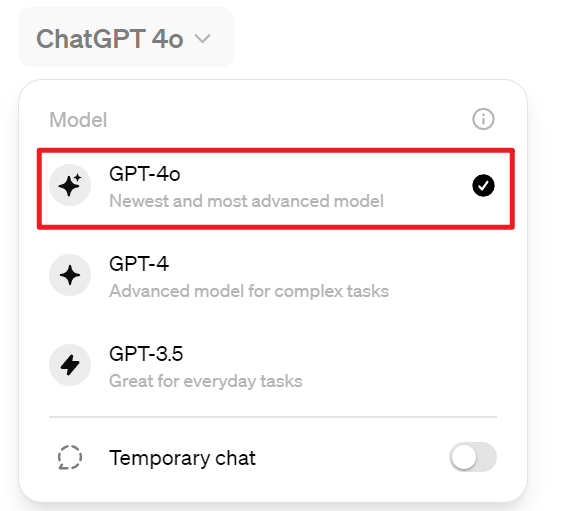

每周都有超過一億人在使用 ChatGPT,OpenAI 表示 GPT-4o 的文本和圖像功能從 5 月 14 日開始免費在 ChatGPT 中推出,使用限制為 3 小時 16 條,Plus 用戶提供高達 5 倍的消息上限。

如今,部分賬戶登錄即可看到 GPT-4o 已經可以使用

此外,免費用戶還擁有以下幾個功能

- 數據分析并創建圖表

- 圖片、文件上傳

- 發現并使用 GPTs 和 GPTs 應用商店

在未來幾周內,OpenAI 將在 ChatGPT Plus 中推出 GPT-4o alpha 的新版本語音模式,并通過 API 向一小部分可信賴的合作伙伴提供更多新的音頻和視頻功能。

盡管經過多次模型測試和迭代,GPT-4o 在所有模態下仍存在一些局限性,但 OpenAI 表示正在努力改進 GPT-4o。

當然,GPT-4o 音頻模式的開放肯定會帶來各種新的挑戰。在安全性方面,OpenAI 已經通過過濾訓練數據和對訓練后模型行為進行細化等技術來內置跨模態設計的安全性。此外,OpenAI 還創建了新的安全系統,以確保語音輸出的安全。

全新桌面應用程序(Mac)

OpenAI 推出了適用于 macOS 的新 ChatGPT 桌面應用程序,面向所有的免費和付費用戶。通過簡單的鍵盤快捷鍵「Option + Space」,用戶可以立即向 ChatGPT 提出問題。此外,應用程序還支持用戶直接截取屏幕截圖,基于截圖和 ChatGPT 溝通。

雖然說是 Plus 用戶可以使用,不過我自己測試過來 Plus 用戶也會報如下錯誤,應當還是在內測中

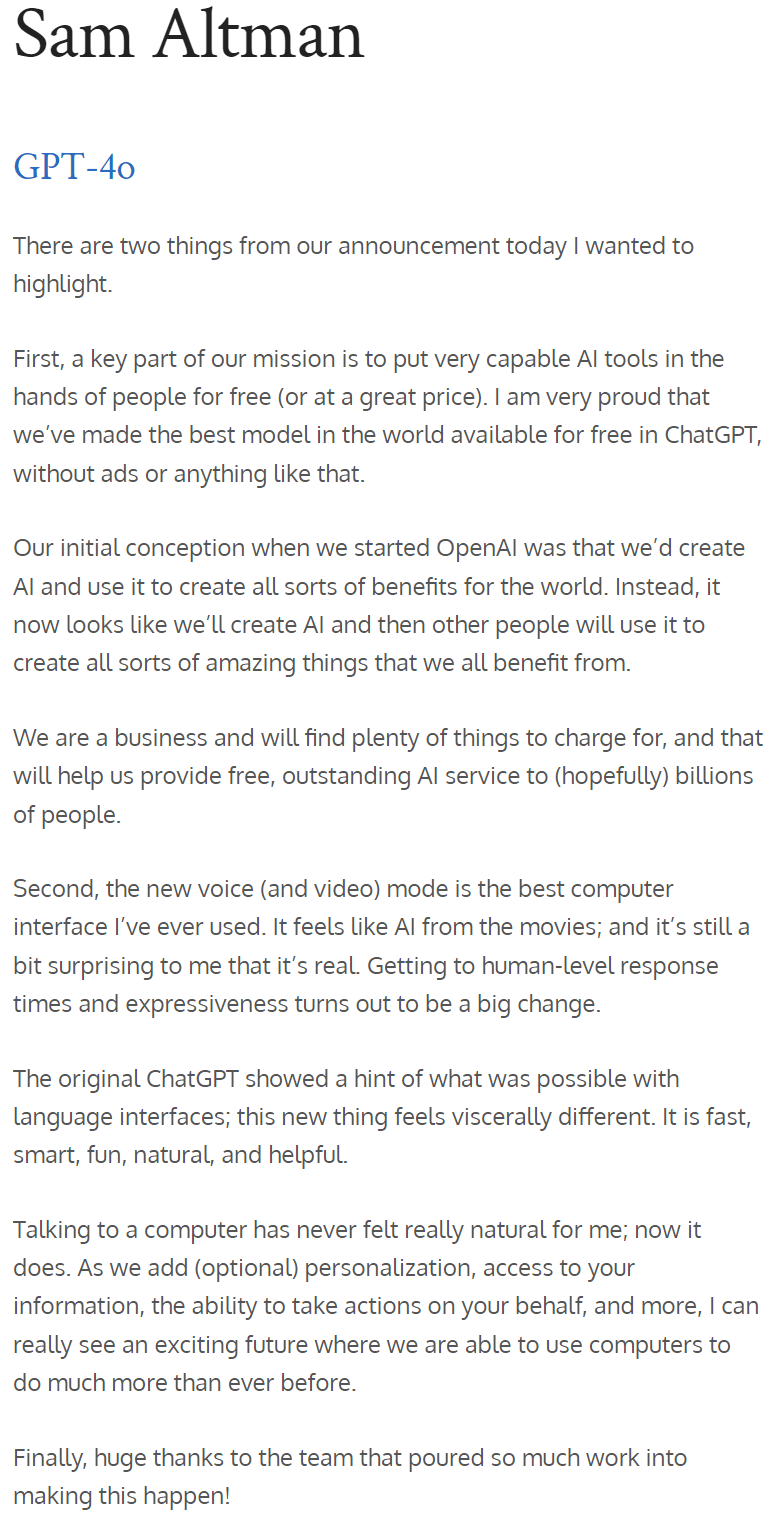

暢談 GPT-4o 的愿景

在發布會結束后,OpenAI CEO 山姆·奧特曼久違地在博客上分享了關于 GPT-4o 工作的一些心路歷程:

“在今天的發布會上,我想強調兩件事。首先,我們的使命之一是將強大的人工智能工具免費或以優惠的價格提供給大眾。我非常自豪地宣布,我們在 ChatGPT 中免費提供世界上最好的模型,沒有廣告或類似的東西。

當我們創立 OpenAI 時,我們的初衷是創造出人工智能并利用它為世界創造各種利益。現在情況有所變化,似乎我們創造了人工智能,其他人將使用它來創造各種令人驚嘆的事物,我們所有人都會從中受益。

當然,作為一家企業,我們也會開發很多收費的服務,這將幫助我們向數十億人提供免費、優秀的人工智能服務(希望如此)。

其次,新的語音和視頻模式是我用過的最好的計算交互界面。感覺就像電影里的人工智能一樣,我仍然有點驚訝于它竟然是真的。事實證明,達到人類水平的響應時間和表達能力是一個巨大的飛躍。

最初的 ChatGPT 展示了語言界面的可能性,而這個新事物(GPT-4o 版本)給人的感覺有本質上的不同——它快速、智能、有趣、自然且能給人帶來幫助。

對我來說,與電腦交互從來都不是很自然的事情,事實如此。而當我們添加(可選)個性化、訪問個人信息、讓 AI 代替人采取行動等功能時,我確實可以看到一個令人興奮的未來,我們能夠使用計算機做比以往更多的事情。

最后,我要非常感謝團隊為實現這一目標所付出的巨大努力!”

奧特曼還提到,雖然實現全民基本收入(Universal Basic Income)困難重重,但我們可以實現“全民免費計算”(Universal Basic Compute)。未來,每個人都可以免費獲得 GPT 的計算資源,可以使用、轉售或捐贈。

他解釋道:“隨著 AI 變得更加先進,并嵌入到我們生活的方方面面,擁有像 GPT-7 這樣的大語言模型單元可能比金錢更有價值,你擁有了部分生產力。”

GPT-4o 的發布,或許就是 OpenAI 朝著這個目標邁出的第一步。

“是的,這還只是個開始。”

(java\python\c++))

【移遠EC800M-CN 】GNSS功能打開和關閉關閉步驟驗證)

![NSSCTF | [SWPUCTF 2021 新生賽]easyupload2.0](http://pic.xiahunao.cn/NSSCTF | [SWPUCTF 2021 新生賽]easyupload2.0)

-- 將URDF與robot_state_publisher一起使用)

)

【移遠EC800M-CN 】TCP 透傳)

的使用)

)