摘要: 本文將詳細介紹如何利用先進的深度學習目標檢測算法 YOLOv11 結合 OpenCV 計算機視覺庫,構建一個高效、實時的人員跌倒識別系統。跌倒檢測在智慧養老、安防監控、工業安全等領域至關重要。我們將從環境搭建、數據準備、模型訓練到跌倒行為判斷邏輯,完整地實現這一智能監控應用。

關鍵詞: YOLOv11, OpenCV, 人員跌倒識別, 行為分析, 深度學習, 人體姿態估計, Python, 智能監控

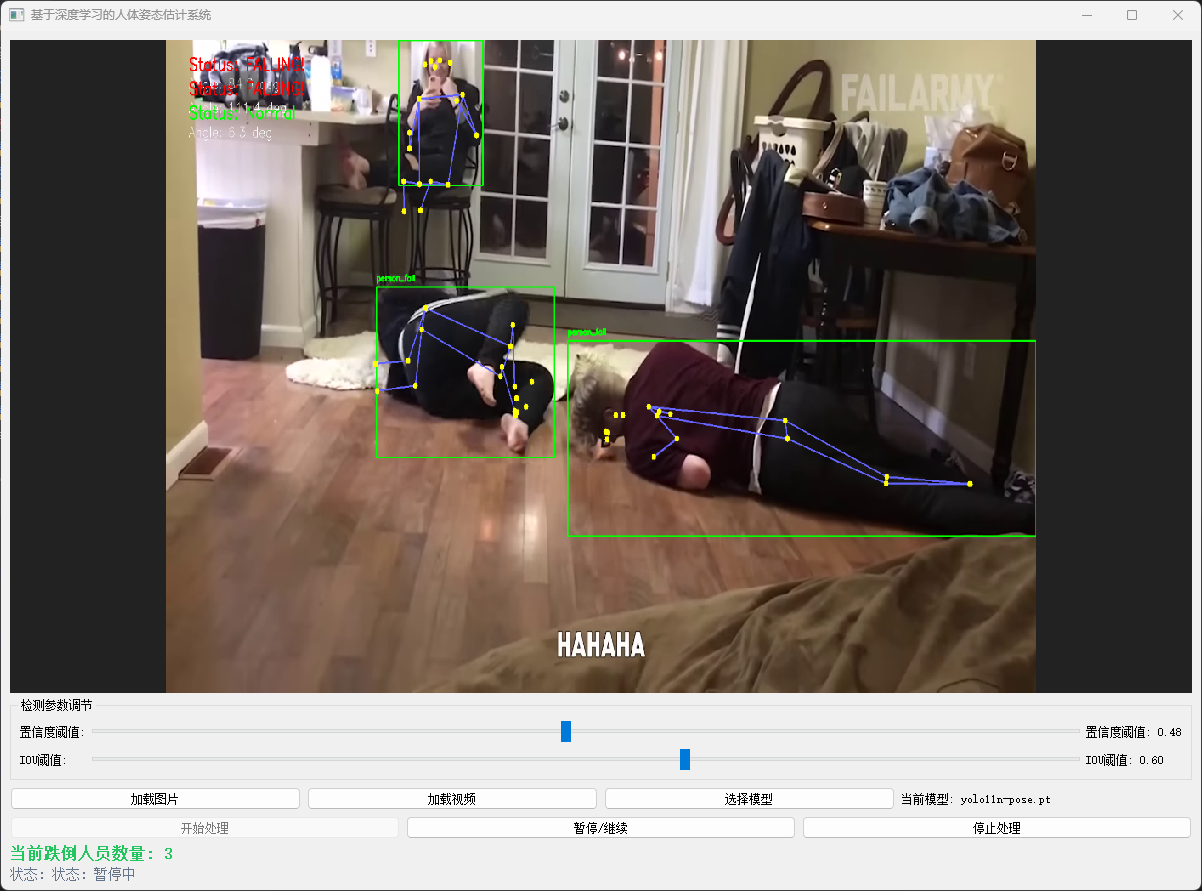

【圖像算法 - 25】基于深度學習 YOLOv11 與 OpenCV 實現人員跌倒識別系統(人體姿態估計版本)

1. 引言

人員跌倒是一種常見的意外事件,尤其對老年人或在特定工作環境中(如工地、工廠)的人員構成嚴重威脅。及時發現跌倒并進行救助至關重要。傳統的監控依賴人工值守,效率低且易遺漏。利用計算機視覺技術實現自動化的跌倒識別,可以大大提高響應速度和安全性。

YOLOv11 以其卓越的速度和精度,非常適合實時視頻流中的目標檢測任務。OpenCV 提供了強大的圖像處理和視頻分析功能。本文將結合兩者,通過檢測人體姿態或運動特征來判斷跌倒行為。

2. 技術方案選擇

跌倒識別主要有三種思路:

- 基于目標檢測 + 規則判斷: 使用 YOLOv11 檢測出人體,然后根據人體邊界框的寬高比、位置變化等特征,結合簡單規則判斷是否跌倒。

- 基于姿態估計: 使用 YOLOv11 的姿態估計模型(

yolov11n-pose.pt等)檢測人體關鍵點(如頭、肩、髖、膝、踝),通過分析關鍵點的相對位置和角度來判斷姿態,從而更精確地識別跌倒。 - 基于目標檢測:將跌倒視為一個需要檢測的獨立目標類別。我們不再先檢測“人”,再判斷其狀態,而是訓練一個模型,使其能夠直接輸出“跌倒”檢測結果。

【圖像算法 - 06】YOLO 全家桶人體姿態識別完全指南:從 YOLOv8 到 YOLO12 核心原理 + 代碼實戰,新手入門保姆級教程(附視頻詳解)

【圖像算法 - 24】基于深度學習與 OpenCV 實現人員跌倒識別系統(目標檢測方案 - 跌倒即目標)

本文將采用 姿態估計 方案,因為它能提供更豐富的姿態信息,判斷更準確。

3. 環境準備

3.1 軟件依賴

# 安裝 PyTorch (根據你的CUDA版本選擇)

pip install torch torchvision torchaudio# 安裝 YOLOv11 (包含姿態估計功能)

pip install ultralytics# 安裝 OpenCV

pip install opencv-python# 其他

pip install numpy

4. 原理分析:如何通過姿態判斷跌倒

跌倒時,人體姿態通常呈現以下特征:

- 身體傾斜角過大: 身體主軸(如從頭到髖)與垂直方向的夾角接近或超過90度。

- 關鍵點相對位置異常: 例如,頭部關鍵點位置遠低于髖部或膝蓋。

- 運動速度突變: (可選,結合光流或幀間差分)從站立到跌倒瞬間速度變化劇烈。

本文主要利用 身體傾斜角 作為核心判斷依據。

5. 核心代碼實現

5.1 加載模型

from ultralytics import YOLO

import cv2

import math

import numpy as np# 加載 YOLO11 姿態估計模型

model = YOLO('yolo11n-pose.pt') # 或 yolo11s-pose.pt, 更大模型精度更高

5.2 計算身體傾斜角

def calculate_fall_angle(keypoints):"""根據關鍵點計算身體傾斜角keypoints: 模型輸出的關鍵點數組,格式為 [x, y, confidence]假設關鍵點索引:0-鼻子, 5-左肩, 6-右肩, 11-左髖, 12-右髖"""# 選擇肩部和髖部關鍵點計算身體中軸# 取左右肩和左右髖的平均值作為肩中點和髖中點left_shoulder = keypoints[5][:2] # [x, y]right_shoulder = keypoints[6][:2]left_hip = keypoints[11][:2]right_hip = keypoints[12][:2]# 計算中點shoulder_mid = ((left_shoulder[0] + right_shoulder[0]) / 2,(left_shoulder[1] + right_shoulder[1]) / 2)hip_mid = ((left_hip[0] + right_hip[0]) / 2,(left_hip[1] + right_hip[1]) / 2)# 計算向量 (從髖到肩)vector = (shoulder_mid[0] - hip_mid[0], shoulder_mid[1] - hip_mid[1])# 計算與垂直方向(0, -1)的夾角 (使用點積)vertical = (0, -1) # 垂直向上dot_product = vector[0] * vertical[0] + vector[1] * vertical[1]vector_magnitude = math.sqrt(vector[0]**2 + vector[1]**2)vertical_magnitude = 1.0# 避免除零if vector_magnitude == 0:return 90.0 # 默認值cos_angle = dot_product / (vector_magnitude * vertical_magnitude)# 限制在 [-1, 1] 防止數值誤差cos_angle = max(min(cos_angle, 1.0), -1.0)angle_rad = math.acos(cos_angle)angle_deg = math.degrees(angle_rad)return angle_deg

5.3 判斷跌倒

def is_falling(angle, threshold=60.0):"""根據角度判斷是否跌倒angle: 身體傾斜角 (度)threshold: 判斷跌倒的閾值 (度),例如60度表示身體傾斜超過60度認為是跌倒"""return angle < threshold # 角度越小,身體越接近水平

5.4 視頻流處理與識別

cap = cv2.VideoCapture(0) # 0 表示默認攝像頭,或替換為視頻文件路徑while cap.isOpened():success, frame = cap.read()if not success:print("無法讀取視頻流")break# 使用 YOLO11 進行姿態估計results = model(frame, stream=True) # stream=True for generatorfor r in results:# 獲取關鍵點keypoints = r.keypointsif keypoints is not None and len(keypoints) > 0:# 遍歷檢測到的每個人for i, person_kps in enumerate(keypoints.xy.cpu().numpy()): # xy: [x, y]# 計算身體傾斜角angle = calculate_fall_angle(person_kps)# 判斷是否跌倒falling = is_falling(angle, threshold=60.0)# 在圖像上繪制結果# 繪制關鍵點和骨架 (使用YOLO11自帶的plot方法或手動繪制)# 這里簡化,只繪制框和標簽# 獲取邊界框 (可選)# box = r.boxes.xyxy[i].cpu().numpy().astype(int)# x1, y1, x2, y2 = box# 在圖像上顯示角度和狀態status = "FALLING!" if falling else "Normal"color = (0, 0, 255) if falling else (0, 255, 0) # 紅色表示跌倒cv2.putText(frame, f'Status: {status}', (50, 50 + i*40),cv2.FONT_HERSHEY_SIMPLEX, 1, color, 2)cv2.putText(frame, f'Angle: {angle:.1f} deg', (50, 80 + i*40),cv2.FONT_HERSHEY_SIMPLEX, 0.8, (255, 255, 255), 1)# (可選) 繪制身體中軸線# shoulder_mid, hip_mid = ... (從calculate_fall_angle獲取或重新計算)# cv2.line(frame, tuple(map(int, shoulder_mid)), tuple(map(int, hip_mid)), color, 2)# 顯示視頻幀cv2.imshow('Person Fall Detection', frame)if cv2.waitKey(1) & 0xFF == ord('q'):breakcap.release()

cv2.destroyAllWindows()

6. 優化與挑戰

-

閾值選擇:

threshold參數需要根據實際場景(攝像頭角度、距離)進行調整和測試。 -

誤報:

彎腰、下蹲等動作可能被誤判為跌倒。可結合:

- 運動速度: 計算連續幀間關鍵點的移動速度,跌倒通常伴隨快速下落。

- 持續時間: 跌倒狀態需要持續一定時間(如多幀)才報警,避免瞬時誤判。

- 頭部高度: 結合頭部關鍵點離地面的高度。

-

遮擋: 部分身體被遮擋時,關鍵點檢測可能不全或不準。

-

多角度: 攝像頭角度對判斷影響大,需要針對性調整算法或收集多角度數據訓練。

-

實時性: YOLOv11-pose 的推理速度需要滿足實時要求,可選擇更小的模型(如

yolov11n-pose)或優化硬件。

7. 總結

本文利用 YOLO11 的姿態估計能力,結合簡單的幾何計算,實現了一個基礎的人員跌倒識別系統。該方案思路清晰,實現相對簡單,并具有一定的實用性。通過調整判斷邏輯和引入更多特征(如速度、持續時間),可以進一步提升系統的準確性和魯棒性。此技術可廣泛應用于智慧養老院、家庭看護、工地安全監控等場景,為人員安全提供智能化保障。

隊列(Queue))

)

![【線性代數基礎 | 那忘算9】基爾霍夫(拉普拉斯)矩陣 矩陣—樹定理證明 [詳細推導]](http://pic.xiahunao.cn/【線性代數基礎 | 那忘算9】基爾霍夫(拉普拉斯)矩陣 矩陣—樹定理證明 [詳細推導])

)

)