C端(用戶端)高并發項目通常涉及大規模用戶直接訪問的服務,其核心挑戰是如何在海量用戶同時請求下,保證系統的穩定性、高性能、高可用和一致性。以下是一些典型的C端高并發項目類型和具體案例:

?核心類型與典型案例:??

?電商平臺及其關鍵模塊:??

?典型項目:?? 淘寶/天貓、京東、拼多多、亞馬遜等大型綜合電商;各垂直電商平臺大促活動。

?高并發場景:??

?首頁/活動頁:?? 大促活動(如雙11、618)開始瞬間,用戶瘋狂刷新首頁或活動會場頁。

?商品詳情頁:?? 熱門商品(秒殺品)被大量用戶同時查看。

?購物車/下單:?? 秒殺/搶購活動開始時,海量用戶同時點擊“立即購買”或“結算”,創建訂單。

?支付:?? 用戶完成下單后短時間內涌入支付系統。

?庫存服務:?? 在秒殺或高并發搶購時,保證庫存扣減的準確性和高性能,避免超賣。

?推薦/搜索服務:?? 用戶實時搜索商品或瀏覽推薦列表。

?社交媒體與內容平臺:??

?典型項目:?? 微博(熱搜、明星事件)、抖音/快手(熱門視頻播放、直播)、微信朋友圈/公眾號(熱點文章)、小紅書(爆款筆記)、Reddit/Twitter(熱門事件)。

?高并發場景:??

?熱點事件發布/傳播:?? 突發事件、明星官宣導致短時間內海量用戶發布、閱讀、評論、轉發相關內容。

?直播互動:?? 頭部主播開播,數百萬用戶同時進入直播間發送彈幕、點贊、打賞、參與互動。

?信息流推薦:?? 用戶不斷刷新的主頁信息流,需要低延遲、高吞吐地返回個性化內容。

?內容上傳:?? 大量用戶同時上傳視頻/圖片(如節假日返圖)。

?票務與預約系統:??

?典型項目:?? 12306(春運搶票)、大麥網(周杰倫演唱會門票)、各類明星演唱會/體育賽事票務系統、醫院掛號預約平臺(熱門專家號)。

?高并發場景:?? ?秒殺類場景的極端代表。?? 開票瞬間,數百萬甚至千萬用戶同時請求少量(甚至幾百張)票務資源,對并發處理能力和防刷能力要求極高。

?支付系統:??

?典型項目:?? 支付寶、微信支付、銀行核心交易系統(特定時段)、國際支付網關(如Visa/Mastercard在購物季)。

?高并發場景:?? 與電商大促、票務支付等強相關。在交易高峰期(如雙11零點后幾分鐘),處理海量支付請求,要求極高的準確性、一致性(避免重復扣款、漏扣)、實時性和安全性。

?大型游戲(尤其是開服、活動):??

?典型項目:?? 熱門MMORPG、MOBA游戲、爆款手游(如《原神》新地圖/角色上線、《王者榮耀》新賽季/皮膚發布)。

?高并發場景:??

?游戲開服/大型資料片更新:?? 大量玩家同時涌入新服務器登錄。

?熱門活動/副本開啟:?? 所有活躍玩家集中在特定時間點參與活動或挑戰副本,導致服務器瞬時壓力巨大。

?世界Boss戰/國戰:?? 大規模玩家在同一場景內實時交互。

?登錄/匹配服務:?? 海量玩家同時登錄或進行匹配戰斗。

?智能設備后臺服務:??

?典型項目:?? 大型智能家居平臺(如小米IoT)、網約車平臺(滴滴高峰期)、共享單車平臺(高峰時段開關鎖)。

?高并發場景:?? 大量設備(百萬甚至千萬級)同時在線、定時上報狀態、響應控制指令(如開燈指令下發到所有設備),或者業務高峰期(如晚高峰)海量用戶同時叫車、解鎖共享單車。

?新聞資訊與門戶網站:??

?典型項目:?? 新華網、人民網(重大事件直播)、頭條、騰訊新聞等App推送重大突發新聞時。

?高并發場景:?? 發生重大突發事件(如地震、國際沖突、明星離世),用戶瞬間涌入網站或App獲取最新信息。

?這些C端高并發項目的核心挑戰通常圍繞以下幾點:??

?流量洪峰:?? 短時間內超出常規數倍甚至數百倍的訪問量。

?低延遲:?? 用戶期望即時響應(毫秒級),尤其是核心操作(下單、支付、發帖、搶票)。

?高可用性:?? 系統必須保持7x24小時穩定運行,故障自動恢復時間極短。

?數據一致性:?? 尤其在交易、庫存、賬戶余額等場景,保證數據準確無誤(如防止超賣)。

?資源競爭:?? 對稀缺資源(如庫存、演唱會座位)的高并發訪問和修改。

?防刷/安全:?? 防止黃牛、黑客利用自動化腳本進行惡意請求(刷票、DDOS攻擊)。

?彈性擴展:?? 需要能夠根據流量快速伸縮計算、存儲、網絡資源。

?支撐高并發項目的關鍵技術方向:??

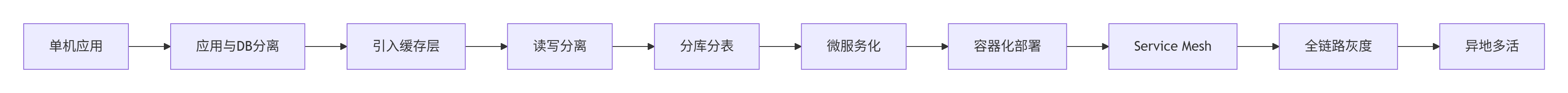

?架構層面:?? 微服務化(解耦)、分布式架構、負載均衡、緩存策略(Redis/Memcached)、消息隊列(削峰填谷,如Kafka/RocketMQ/RabbitMQ)、分庫分表/讀寫分離(數據庫擴展)。

?部署層面:?? 容器化(Docker)、容器編排(Kubernetes)、云原生(利用云服務的彈性)、CDN(加速靜態資源訪問)。

?性能優化:?? 代碼優化、網絡優化、數據庫查詢優化(索引、SQL)、JVM優化(Java項目)、異步/非阻塞處理(減少線程等待)。

?穩定性保障:?? 服務熔斷(Hystrix/Sentinel)、限流降級、容錯設計、全鏈路監控(Prometheus/Grafana/ELK)、異地多活容災(應對機房故障)。

?數據一致性與并發控制:?? 分布式事務(Seata)、最終一致性、樂觀鎖、分布式鎖(Redis/ZooKeeper)。

?壓測與預案:?? 全鏈路壓測、預案演練、混沌工程(故障注入)。

選擇哪種高并發項目取決于您的具體興趣領域(電商、社交、金融等),但它們都遵循相似的核心原則和技術棧。理解業務場景特有的挑戰(如電商庫存、支付扣款;票務座位鎖定;社交熱點推送)是設計和實現方案的關鍵。

</think>

面對海量用戶同時訪問的C端項目,高并發能力是生存之本。以下是我結合行業實踐總結的典型高并發場景分類及技術要點:

🛒 1. 電商核心系統

?典型案例?:淘寶雙11、京東618(峰值訂單量可達百萬級/分鐘)

?致命挑戰?:

秒殺場景:某品牌限量手機開售時,10萬人同時點擊「立即購買」

支付洪峰:訂單創建后5分鐘內需完成99.99%支付回調

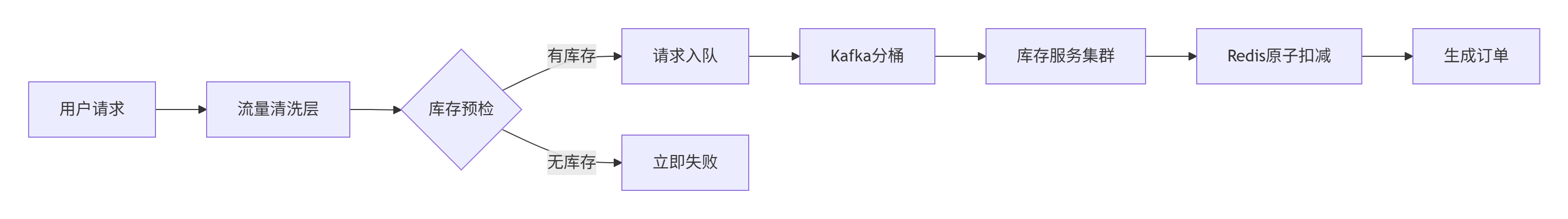

庫存戰爭:避免超賣需實現分布式事務一致性(如Redis+Lua原子操作)

📱 2. 社交內容平臺

?真實場景?:微博明星出軌事件、TikTok頂流直播(某頭部主播開播時200萬人在線)

?技術痛難點?:

熱點動態:突發新聞導致每秒50萬+請求壓垮傳統數據庫(需ES分片+多級緩存)

消息風暴:直播間彈幕洪峰需Kafka分區+消費端批量壓縮

關系鏈擴散:千萬粉絲博主發帖時推拉結合策略選擇

🎫 3. 稀缺資源搶購

?煉獄級案例?:12306春運搶票、周杰倫演唱會售票

?關鍵技術方案?:

設計要點:請求排隊削峰、令牌桶限流、驗證碼策略動態升級

💳 4. 金融交易系統

?典型場景?:支付寶雙12、券商開盤競價(9:15-9:25集合競價時段)

?生死線指標?:

指標

要求

實現方案

響應延遲

<200ms P99

DPVS+自研協議棧優化

事務成功率

>99.999%

TCC柔性事務+異步對沖

對賬差異

0容忍

分布式事件溯源

🎮 5. 游戲實時交互

?極端案例?:王者榮耀新賽季開啟、MMO百人團戰

?破局之道?:

AOI(Area of Interest)算法減少無效包傳輸

狀態幀同步與預測回滾機制

分地圖實例部署(每副本≤50玩家)

? 核心防御體系(通用)

?流量管制三件套?

LVS+Keepalived:承接百萬級連接

Sentinel熔斷規則:

// 訂單服務熔斷配置 FlowRule rule = new FlowRule(); rule.setResource("createOrder"); rule.setGrade(RuleConstant.FLOW_GRADE_QPS); rule.setCount(5000); // 單節點限流Redis-Cell模塊實現分布式令牌桶

?緩存抗壓策略?

熱點Key探測:JD OpenBisect組件實時發現

LocalCache+Redis分片+一致性Hash

緩存擊穿解決方案:

def get_data(key):value = redis.get(key)if value is None:if redis.setnx("lock:"+key, 1): # 分布式鎖value = db.query(key)redis.setex(key, ttl, value)redis.delete("lock:"+key)else:time.sleep(0.1)return get_data(key) # 遞歸重試return value

?數據庫生存指南?

分庫分表:ShardingSphere分片鍵路由

主從分離:MaxScale實現讀寫分離

緊急預案:

/* 當從庫延遲>30秒時自動觸發 */ ALTER TABLE orders SET READ ONLY; CALL switch_to_ro_buffer();

🔭 架構演進路徑

建議優先處理業務中的「三高」痛點:高頻操作、高價值鏈路、高危依賴點。每個成功的高并發系統都是用真實流量「煉」出來的,建議通過全鏈路壓測工具(如JMeter分布式集群)持續驗證系統極限。

))

商品詳情API接口,json數據返回)

— Swift解法 + 可運行Demo)

![[GraphRAG]完全自動化處理任何文檔為向量知識圖譜:AbutionGraph如何讓知識自動“活”起來?](http://pic.xiahunao.cn/[GraphRAG]完全自動化處理任何文檔為向量知識圖譜:AbutionGraph如何讓知識自動“活”起來?)

:計數排序,排序算法復雜度對比和穩定性分析)

API)