企業知識管理革命:RAG系統在大型組織中的落地實踐

🌟 Hello,我是摘星!

🌈 在彩虹般絢爛的技術棧中,我是那個永不停歇的色彩收集者。

🦋 每一個優化都是我培育的花朵,每一個特性都是我放飛的蝴蝶。

🔬 每一次代碼審查都是我的顯微鏡觀察,每一次重構都是我的化學實驗。

🎵 在編程的交響樂中,我既是指揮家也是演奏者。讓我們一起,在技術的音樂廳里,奏響屬于程序員的華美樂章。

目錄

企業知識管理革命:RAG系統在大型組織中的落地實踐

摘要

1. RAG系統概述與企業應用場景

1.1 RAG技術原理

1.2 企業級應用場景

2. 企業級RAG系統架構設計

2.1 整體架構設計

2.2 核心組件實現

2.2.1 查詢引擎實現

2.2.2 檢索服務實現

3. 數據處理與知識庫構建

3.1 數據處理流程

3.2 文檔分塊策略

4. 模型優化與性能調優

4.1 檢索模型優化

4.2 生成模型調優

5. 部署與運維實踐

5.1 容器化部署

5.2 監控與告警

6. 安全與合規考慮

6.1 數據安全架構

6.2 權限控制實現

7. 性能優化與成本控制

7.1 性能優化策略

7.2 成本控制策略

8. 實際案例分析

8.1 某大型制造企業案例

8.2 效果評估

9. 未來發展趨勢

9.1 技術演進路線

9.2 發展方向預測

10. 最佳實踐總結

10.1 架構設計原則

10.2 數據管理策略

10.3 用戶體驗優化

總結

參考鏈接

關鍵詞標簽

摘要

作為一名深耕企業級AI系統開發多年的技術人,我見證了知識管理從傳統文檔庫到智能化RAG系統的完整演進過程。在過去的兩年里,我主導了多個大型組織的RAG系統落地項目,從最初的概念驗證到最終的生產環境部署,每一步都充滿了挑戰與收獲。

傳統的企業知識管理往往面臨著信息孤島、檢索效率低下、知識更新滯后等痛點。員工需要在海量文檔中尋找答案,往往花費大量時間卻收效甚微。而RAG(Retrieval-Augmented Generation)系統的出現,為這些問題提供了革命性的解決方案。它將檢索與生成相結合,不僅能夠快速定位相關信息,還能基于企業內部知識生成準確、個性化的答案。

在實際落地過程中,我發現RAG系統的成功部署遠不止技術層面的考量。從數據治理到用戶體驗,從安全合規到成本控制,每個環節都需要精心設計。特別是在大型組織中,復雜的業務場景、多樣化的數據源、嚴格的安全要求,都對RAG系統的架構設計提出了更高的挑戰。

本文將基于我在多個大型企業RAG系統項目中的實戰經驗,從技術架構、數據處理、模型優化、部署運維等多個維度,深入剖析RAG系統在企業環境中的落地實踐。我會分享那些在項目中踩過的坑、總結出的最佳實踐,以及對未來發展趨勢的思考。希望能為正在或即將進行RAG系統建設的技術團隊提供有價值的參考。

1. RAG系統概述與企業應用場景

1.1 RAG技術原理

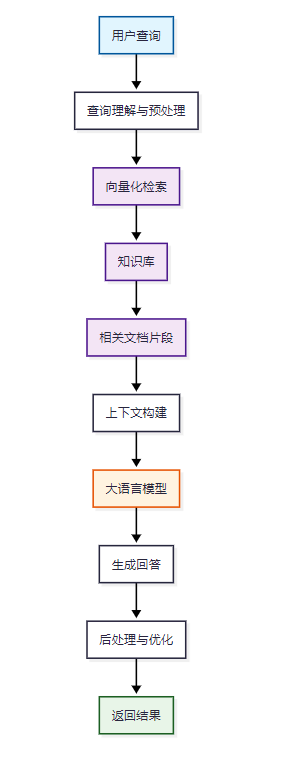

RAG(Retrieval-Augmented Generation)是一種結合了信息檢索和文本生成的AI技術架構。它通過檢索相關文檔片段,然后將這些信息作為上下文輸入到大語言模型中,生成更準確、更具針對性的回答。

圖1:RAG系統核心工作流程圖

1.2 企業級應用場景

在大型組織中,RAG系統的應用場景非常廣泛:

- 內部知識問答:員工可以快速查詢公司政策、流程規范、技術文檔

- 客戶服務支持:基于產品手冊、FAQ等生成準確的客戶回答

- 合規風控查詢:快速檢索法規條文、合規要求、風險案例

- 研發技術支持:代碼庫檢索、技術方案查詢、最佳實踐推薦

2. 企業級RAG系統架構設計

2.1 整體架構設計

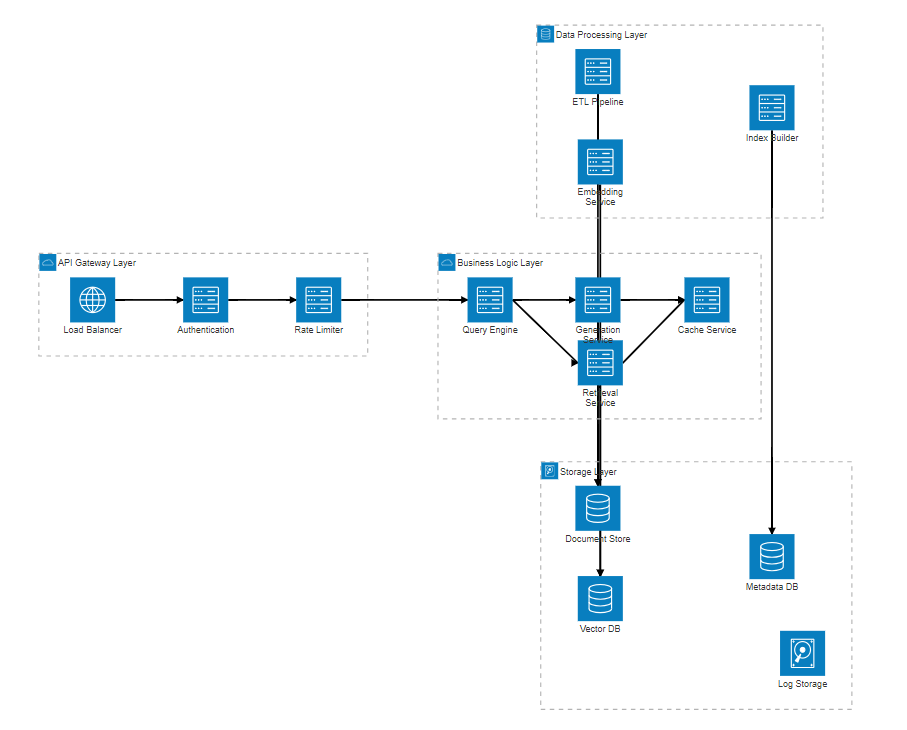

企業級RAG系統需要考慮高可用、高并發、安全性等多重要求。以下是我在項目中采用的分層架構設計:

圖2:企業級RAG系統分層架構圖

2.2 核心組件實現

2.2.1 查詢引擎實現

import asyncio

from typing import List, Dict, Optional

from dataclasses import dataclass

from abc import ABC, abstractmethod@dataclass

class QueryContext:"""查詢上下文"""user_id: strquery: strsession_id: Optional[str] = Nonefilters: Optional[Dict] = Nonemax_results: int = 5class QueryEngine:"""查詢引擎核心類"""def __init__(self, retrieval_service, generation_service, cache_service):self.retrieval_service = retrieval_serviceself.generation_service = generation_serviceself.cache_service = cache_serviceasync def process_query(self, context: QueryContext) -> Dict:"""處理用戶查詢的主流程"""try:# 1. 查詢預處理processed_query = await self._preprocess_query(context.query)# 2. 緩存檢查cache_key = self._generate_cache_key(processed_query, context.filters)cached_result = await self.cache_service.get(cache_key)if cached_result:return cached_result# 3. 檢索相關文檔retrieved_docs = await self.retrieval_service.retrieve(query=processed_query,filters=context.filters,max_results=context.max_results)# 4. 生成回答response = await self.generation_service.generate(query=processed_query,context_docs=retrieved_docs,user_context=context)# 5. 結果緩存await self.cache_service.set(cache_key, response, ttl=3600)return responseexcept Exception as e:# 錯誤處理和日志記錄await self._log_error(context, str(e))return self._generate_error_response(str(e))async def _preprocess_query(self, query: str) -> str:"""查詢預處理:清洗、標準化、意圖識別"""# 去除特殊字符和多余空格cleaned_query = ' '.join(query.strip().split())# 查詢擴展和同義詞替換expanded_query = await self._expand_query(cleaned_query)return expanded_querydef _generate_cache_key(self, query: str, filters: Optional[Dict]) -> str:"""生成緩存鍵"""import hashlibcontent = f"{query}_{str(filters or {})}"return hashlib.md5(content.encode()).hexdigest()2.2.2 檢索服務實現

import numpy as np

from sentence_transformers import SentenceTransformer

from typing import List, Dict, Tuple

import faissclass RetrievalService:"""檢索服務實現"""def __init__(self, vector_db, embedding_model_path: str):self.vector_db = vector_dbself.embedding_model = SentenceTransformer(embedding_model_path)self.index = Noneself._load_index()def _load_index(self):"""加載FAISS索引"""try:self.index = faiss.read_index("enterprise_knowledge.index")except FileNotFoundError:print("索引文件不存在,需要重新構建")async def retrieve(self, query: str, filters: Dict = None, max_results: int = 5) -> List[Dict]:"""檢索相關文檔"""# 1. 查詢向量化query_embedding = self.embedding_model.encode([query])# 2. 向量檢索distances, indices = self.index.search(query_embedding.astype('float32'), max_results * 2 # 檢索更多候選,后續過濾)# 3. 獲取文檔詳情candidate_docs = await self._get_documents_by_indices(indices[0])# 4. 應用過濾器filtered_docs = self._apply_filters(candidate_docs, filters)# 5. 重排序reranked_docs = await self._rerank_documents(query, filtered_docs)return reranked_docs[:max_results]async def _get_documents_by_indices(self, indices: np.ndarray) -> List[Dict]:"""根據索引獲取文檔詳情"""documents = []for idx in indices:if idx != -1: # FAISS返回-1表示無效索引doc = await self.vector_db.get_document(int(idx))if doc:documents.append(doc)return documentsdef _apply_filters(self, documents: List[Dict], filters: Dict) -> List[Dict]:"""應用業務過濾器"""if not filters:return documentsfiltered = []for doc in documents:# 部門過濾if 'department' in filters:if doc.get('department') not in filters['department']:continue# 權限過濾if 'access_level' in filters:if doc.get('access_level', 0) > filters['access_level']:continue# 時間過濾if 'date_range' in filters:doc_date = doc.get('created_date')if not self._in_date_range(doc_date, filters['date_range']):continuefiltered.append(doc)return filteredasync def _rerank_documents(self, query: str, documents: List[Dict]) -> List[Dict]:"""文檔重排序"""if len(documents) <= 1:return documents# 計算語義相似度分數doc_texts = [doc['content'] for doc in documents]query_embedding = self.embedding_model.encode([query])doc_embeddings = self.embedding_model.encode(doc_texts)# 計算余弦相似度similarities = np.dot(query_embedding, doc_embeddings.T)[0]# 結合其他因子(新鮮度、權威性等)final_scores = []for i, doc in enumerate(documents):semantic_score = similarities[i]freshness_score = self._calculate_freshness_score(doc)authority_score = doc.get('authority_score', 0.5)# 加權計算最終分數final_score = (0.6 * semantic_score + 0.2 * freshness_score + 0.2 * authority_score)final_scores.append((final_score, doc))# 按分數排序final_scores.sort(key=lambda x: x[0], reverse=True)return [doc for score, doc in final_scores]3. 數據處理與知識庫構建

3.1 數據處理流程

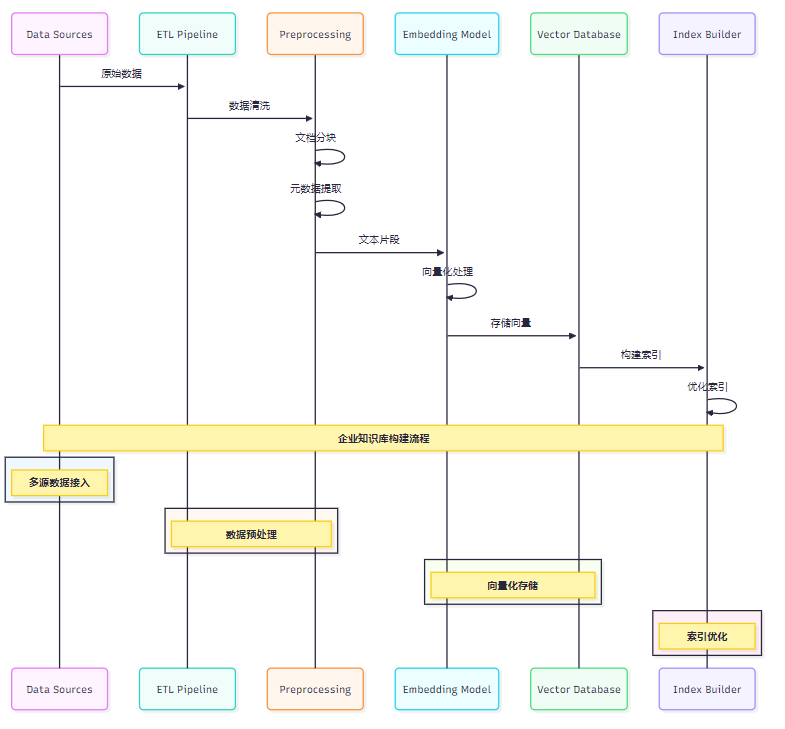

企業知識庫的數據來源多樣化,需要建立完善的ETL流程:

圖3:企業知識庫數據處理時序圖

3.2 文檔分塊策略

from typing import List, Dict, Tuple

import re

from dataclasses import dataclass@dataclass

class DocumentChunk:"""文檔塊數據結構"""content: strmetadata: Dictchunk_id: strparent_doc_id: strchunk_index: intclass DocumentChunker:"""智能文檔分塊器"""def __init__(self, chunk_size: int = 512, overlap: int = 50):self.chunk_size = chunk_sizeself.overlap = overlapdef chunk_document(self, document: Dict) -> List[DocumentChunk]:"""對文檔進行智能分塊"""content = document['content']doc_type = document.get('type', 'text')if doc_type == 'markdown':return self._chunk_markdown(document)elif doc_type == 'code':return self._chunk_code(document)else:return self._chunk_text(document)def _chunk_markdown(self, document: Dict) -> List[DocumentChunk]:"""Markdown文檔分塊"""content = document['content']chunks = []# 按標題層級分塊sections = self._split_by_headers(content)for i, section in enumerate(sections):if len(section['content']) > self.chunk_size:# 大段落進一步分塊sub_chunks = self._split_large_section(section['content'])for j, sub_chunk in enumerate(sub_chunks):chunk = DocumentChunk(content=sub_chunk,metadata={**document.get('metadata', {}),'section_title': section['title'],'section_level': section['level'],'sub_chunk_index': j},chunk_id=f"{document['id']}_section_{i}_chunk_{j}",parent_doc_id=document['id'],chunk_index=len(chunks))chunks.append(chunk)else:chunk = DocumentChunk(content=section['content'],metadata={**document.get('metadata', {}),'section_title': section['title'],'section_level': section['level']},chunk_id=f"{document['id']}_section_{i}",parent_doc_id=document['id'],chunk_index=len(chunks))chunks.append(chunk)return chunksdef _split_by_headers(self, content: str) -> List[Dict]:"""按標題分割Markdown內容"""sections = []lines = content.split('\n')current_section = {'title': '', 'level': 0, 'content': ''}for line in lines:header_match = re.match(r'^(#{1,6})\s+(.+)$', line)if header_match:# 保存當前段落if current_section['content'].strip():sections.append(current_section.copy())# 開始新段落level = len(header_match.group(1))title = header_match.group(2)current_section = {'title': title,'level': level,'content': line + '\n'}else:current_section['content'] += line + '\n'# 添加最后一個段落if current_section['content'].strip():sections.append(current_section)return sectionsdef _chunk_code(self, document: Dict) -> List[DocumentChunk]:"""代碼文檔分塊"""content = document['content']language = document.get('language', 'python')# 按函數/類分塊if language in ['python', 'java', 'javascript']:return self._chunk_by_functions(document)else:return self._chunk_text(document)def _chunk_by_functions(self, document: Dict) -> List[DocumentChunk]:"""按函數分塊代碼"""content = document['content']chunks = []# 簡單的函數分割(實際項目中需要使用AST解析)function_pattern = r'(def\s+\w+.*?(?=\ndef\s|\nclass\s|$))'functions = re.findall(function_pattern, content, re.DOTALL)for i, func_code in enumerate(functions):# 提取函數名func_name_match = re.search(r'def\s+(\w+)', func_code)func_name = func_name_match.group(1) if func_name_match else f"function_{i}"chunk = DocumentChunk(content=func_code.strip(),metadata={**document.get('metadata', {}),'function_name': func_name,'code_type': 'function'},chunk_id=f"{document['id']}_func_{func_name}",parent_doc_id=document['id'],chunk_index=i)chunks.append(chunk)return chunks4. 模型優化與性能調優

4.1 檢索模型優化

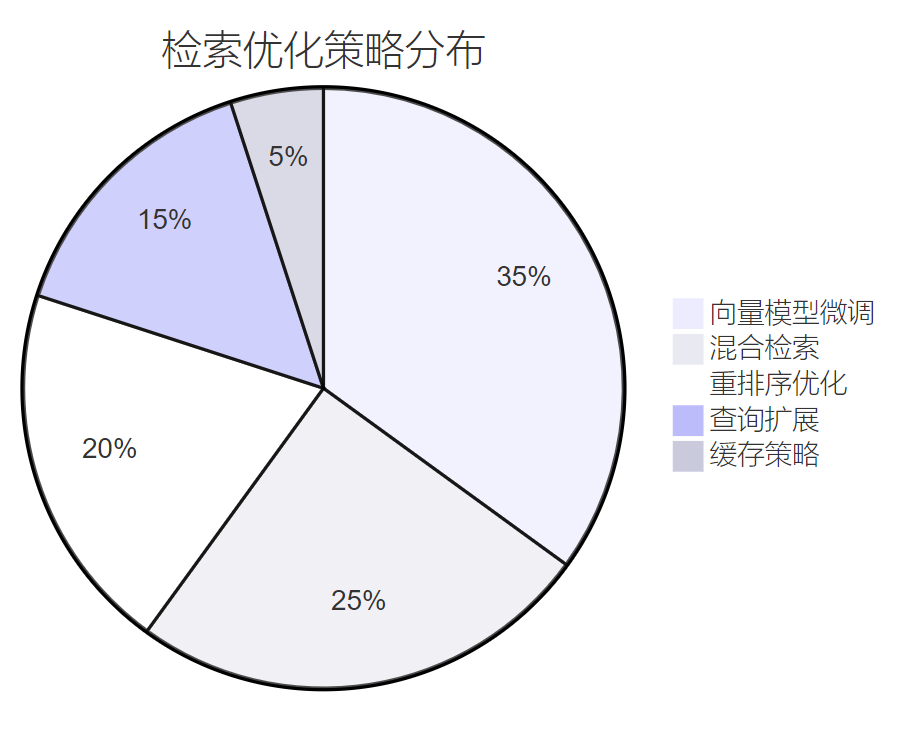

在企業環境中,檢索精度直接影響用戶體驗。我們采用多階段優化策略:

圖4:檢索優化策略占比分布餅圖

4.2 生成模型調優

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from typing import List, Dict, Optional

import jsonclass EnterpriseGenerationService:"""企業級生成服務"""def __init__(self, model_path: str, device: str = "cuda"):self.device = deviceself.tokenizer = AutoTokenizer.from_pretrained(model_path)self.model = AutoModelForCausalLM.from_pretrained(model_path,torch_dtype=torch.float16,device_map="auto")# 企業級提示詞模板self.prompt_templates = {'general': self._load_prompt_template('general'),'technical': self._load_prompt_template('technical'),'policy': self._load_prompt_template('policy'),'customer_service': self._load_prompt_template('customer_service')}async def generate(self, query: str, context_docs: List[Dict], user_context: Dict) -> Dict:"""生成回答"""try:# 1. 選擇合適的提示詞模板template_type = self._determine_template_type(query, context_docs)template = self.prompt_templates[template_type]# 2. 構建提示詞prompt = self._build_prompt(template, query, context_docs, user_context)# 3. 生成回答response = await self._generate_response(prompt)# 4. 后處理processed_response = self._post_process_response(response, user_context)return {'answer': processed_response,'sources': [doc['id'] for doc in context_docs],'confidence': self._calculate_confidence(response, context_docs),'template_used': template_type}except Exception as e:return self._generate_fallback_response(str(e))def _build_prompt(self, template: str, query: str, context_docs: List[Dict], user_context: Dict) -> str:"""構建提示詞"""# 整理上下文文檔context_text = "\n\n".join([f"文檔{i+1}:{doc['title']}\n{doc['content'][:800]}..."for i, doc in enumerate(context_docs)])# 用戶信息user_info = f"用戶部門:{user_context.get('department', '未知')}"# 填充模板prompt = template.format(context=context_text,query=query,user_info=user_info,current_date=self._get_current_date())return promptasync def _generate_response(self, prompt: str) -> str:"""生成模型推理"""inputs = self.tokenizer(prompt, return_tensors="pt", truncation=True, max_length=4000).to(self.device)with torch.no_grad():outputs = self.model.generate(**inputs,max_new_tokens=512,temperature=0.7,do_sample=True,top_p=0.9,repetition_penalty=1.1,pad_token_id=self.tokenizer.eos_token_id)response = self.tokenizer.decode(outputs[0], skip_special_tokens=True)# 提取生成的部分(去除輸入提示詞)generated_text = response[len(prompt):].strip()return generated_textdef _post_process_response(self, response: str, user_context: Dict) -> str:"""回答后處理"""# 1. 去除可能的有害內容response = self._filter_harmful_content(response)# 2. 格式化輸出response = self._format_response(response)# 3. 添加免責聲明(如果需要)if self._needs_disclaimer(response):response += "\n\n*注:以上信息僅供參考,具體執行請以最新政策為準。*"return responsedef _calculate_confidence(self, response: str, context_docs: List[Dict]) -> float:"""計算回答置信度"""# 簡化的置信度計算# 實際項目中可以使用更復雜的算法factors = []# 1. 上下文相關性context_relevance = len(context_docs) / 5.0 # 假設5個文檔為滿分factors.append(min(context_relevance, 1.0))# 2. 回答長度合理性response_length = len(response)length_score = 1.0 if 50 <= response_length <= 500 else 0.7factors.append(length_score)# 3. 是否包含不確定表述uncertainty_keywords = ['可能', '也許', '不確定', '建議咨詢']uncertainty_penalty = sum(1 for keyword in uncertainty_keywords if keyword in response) * 0.1uncertainty_score = max(0.5, 1.0 - uncertainty_penalty)factors.append(uncertainty_score)# 加權平均confidence = sum(factors) / len(factors)return round(confidence, 2)5. 部署與運維實踐

5.1 容器化部署

# docker-compose.yml

version: '3.8'services:rag-api:build: context: .dockerfile: Dockerfile.apiports:- "8000:8000"environment:- REDIS_URL=redis://redis:6379- POSTGRES_URL=postgresql://user:pass@postgres:5432/ragdb- VECTOR_DB_URL=http://milvus:19530depends_on:- redis- postgres- milvusdeploy:replicas: 3resources:limits:memory: 4Gcpus: '2'healthcheck:test: ["CMD", "curl", "-f", "http://localhost:8000/health"]interval: 30stimeout: 10sretries: 3embedding-service:build:context: .dockerfile: Dockerfile.embeddingenvironment:- MODEL_PATH=/models/sentence-transformer- BATCH_SIZE=32volumes:- ./models:/modelsdeploy:replicas: 2resources:limits:memory: 8Gcpus: '4'reservations:devices:- driver: nvidiacount: 1capabilities: [gpu]redis:image: redis:7-alpineports:- "6379:6379"volumes:- redis_data:/datacommand: redis-server --appendonly yespostgres:image: postgres:15environment:POSTGRES_DB: ragdbPOSTGRES_USER: userPOSTGRES_PASSWORD: passvolumes:- postgres_data:/var/lib/postgresql/dataports:- "5432:5432"milvus:image: milvusdb/milvus:v2.3.0ports:- "19530:19530"volumes:- milvus_data:/var/lib/milvusenvironment:ETCD_ENDPOINTS: etcd:2379MINIO_ADDRESS: minio:9000depends_on:- etcd- miniovolumes:redis_data:postgres_data:milvus_data:5.2 監控與告警

import asyncio

import time

from typing import Dict, List

from dataclasses import dataclass

from prometheus_client import Counter, Histogram, Gauge, start_http_server

import logging@dataclass

class MetricConfig:"""監控指標配置"""name: strdescription: strlabels: List[str] = Noneclass RAGSystemMonitor:"""RAG系統監控"""def __init__(self):# 定義監控指標self.query_counter = Counter('rag_queries_total','Total number of queries processed',['status', 'user_type'])self.query_duration = Histogram('rag_query_duration_seconds','Time spent processing queries',['component'])self.retrieval_accuracy = Gauge('rag_retrieval_accuracy','Retrieval accuracy score')self.active_users = Gauge('rag_active_users','Number of active users')self.error_rate = Gauge('rag_error_rate','Error rate percentage')# 啟動監控服務器start_http_server(8090)# 日志配置logging.basicConfig(level=logging.INFO)self.logger = logging.getLogger(__name__)async def track_query(self, query_context: Dict, start_time: float):"""跟蹤查詢指標"""duration = time.time() - start_time# 記錄查詢計數self.query_counter.labels(status='success',user_type=query_context.get('user_type', 'unknown')).inc()# 記錄查詢耗時self.query_duration.labels(component='total').observe(duration)# 記錄日志self.logger.info(f"Query processed in {duration:.2f}s for user {query_context.get('user_id')}")async def update_system_metrics(self):"""更新系統級指標"""while True:try:# 更新檢索準確率accuracy = await self._calculate_retrieval_accuracy()self.retrieval_accuracy.set(accuracy)# 更新活躍用戶數active_count = await self._get_active_user_count()self.active_users.set(active_count)# 更新錯誤率error_rate = await self._calculate_error_rate()self.error_rate.set(error_rate)await asyncio.sleep(60) # 每分鐘更新一次except Exception as e:self.logger.error(f"Error updating metrics: {e}")await asyncio.sleep(60)6. 安全與合規考慮

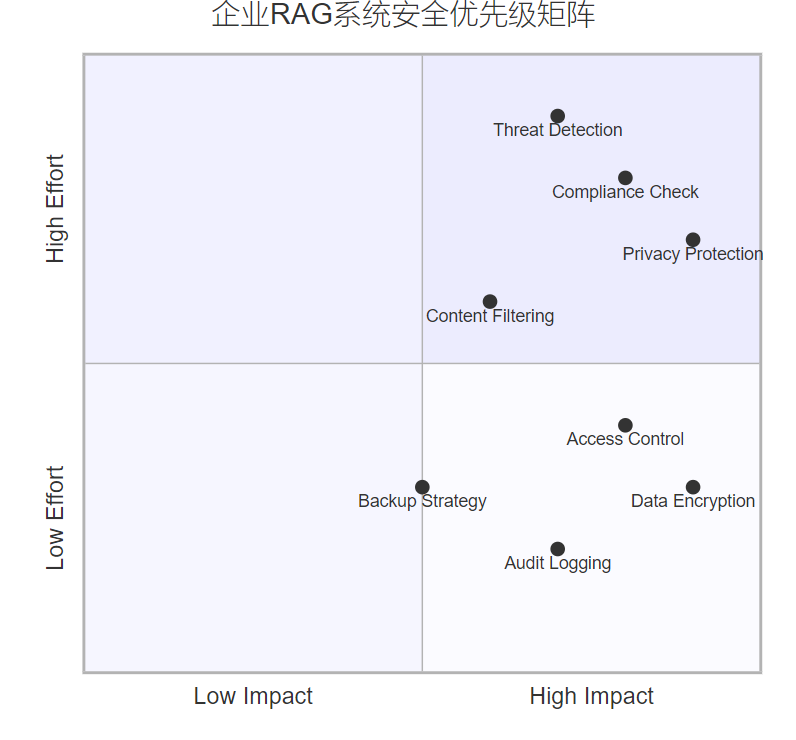

6.1 數據安全架構

企業級RAG系統必須滿足嚴格的安全要求:

圖5:企業RAG系統安全優先級象限圖

6.2 權限控制實現

| 權限級別 | 訪問范圍 | 數據類型 | 典型用戶 |

| L1-公開 | 全員可見 | 公司新聞、通用政策 | 所有員工 |

| L2-內部 | 部門內可見 | 部門文檔、項目資料 | 部門成員 |

| L3-機密 | 授權可見 | 財務數據、戰略規劃 | 管理層 |

| L4-絕密 | 嚴格控制 | 核心技術、商業機密 | 高級管理層 |

7. 性能優化與成本控制

7.1 性能優化策略

import asyncio

from typing import Dict, List, Optional

import redis

from functools import wraps

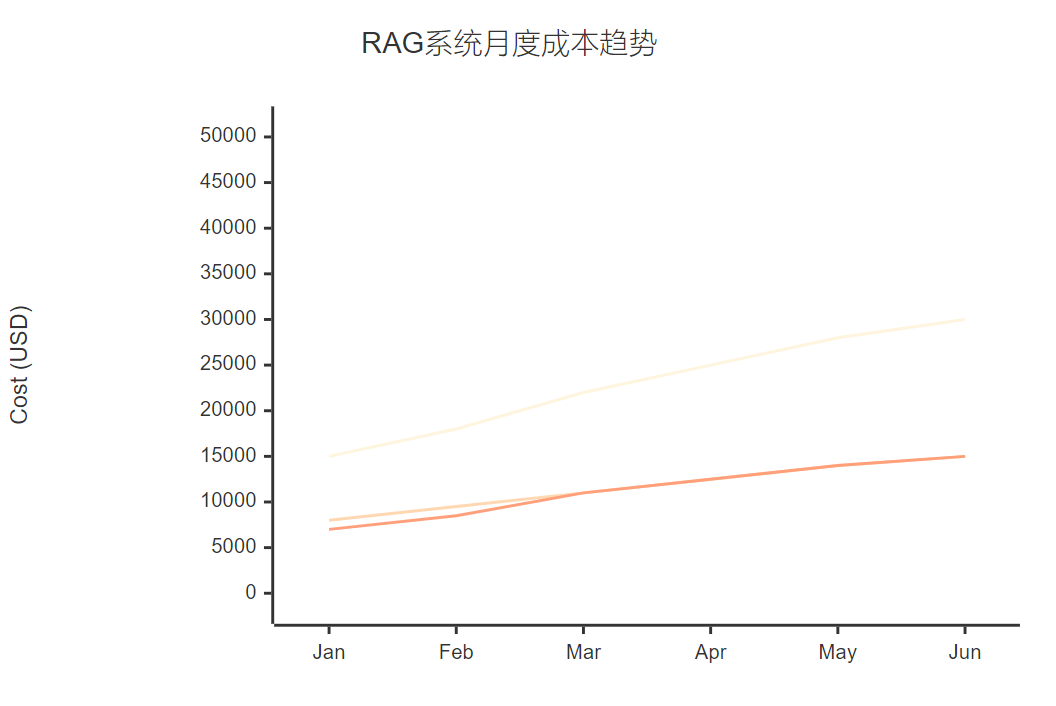

import timeclass PerformanceOptimizer:"""性能優化器"""def __init__(self, redis_client: redis.Redis):self.redis_client = redis_clientself.cache_stats = {'hits': 0, 'misses': 0}def cache_result(self, ttl: int = 3600, key_prefix: str = "rag"):"""結果緩存裝飾器"""def decorator(func):@wraps(func)async def wrapper(*args, **kwargs):# 生成緩存鍵cache_key = f"{key_prefix}:{self._generate_key(args, kwargs)}"# 嘗試從緩存獲取cached_result = await self._get_from_cache(cache_key)if cached_result:self.cache_stats['hits'] += 1return cached_result# 執行原函數result = await func(*args, **kwargs)# 存入緩存await self._set_cache(cache_key, result, ttl)self.cache_stats['misses'] += 1return resultreturn wrapperreturn decoratorasync def batch_process(self, items: List[Dict], process_func, batch_size: int = 10):"""批量處理優化"""results = []for i in range(0, len(items), batch_size):batch = items[i:i + batch_size]# 并發處理批次batch_tasks = [process_func(item) for item in batch]batch_results = await asyncio.gather(*batch_tasks, return_exceptions=True)# 處理異常for j, result in enumerate(batch_results):if isinstance(result, Exception):print(f"Error processing item {i+j}: {result}")results.append(None)else:results.append(result)return resultsdef _generate_key(self, args, kwargs) -> str:"""生成緩存鍵"""import hashlibkey_data = str(args) + str(sorted(kwargs.items()))return hashlib.md5(key_data.encode()).hexdigest()7.2 成本控制策略

圖6:RAG系統月度成本趨勢XY圖表

8. 實際案例分析

8.1 某大型制造企業案例

"知識就是力量,但只有被正確組織和快速獲取的知識才能轉化為競爭優勢。RAG系統讓我們的技術知識真正活了起來。" —— 某制造企業CTO

在這個項目中,我們面臨的主要挑戰包括:

- 多語言文檔處理:中英文技術文檔混合

- 專業術語理解:大量行業特定術語

- 實時性要求:生產問題需要快速響應

解決方案:

- 構建領域專用詞典,提升術語識別準確率

- 采用多語言embedding模型,支持跨語言檢索

- 建立分級緩存機制,常用查詢毫秒級響應

8.2 效果評估

| 指標 | 實施前 | 實施后 | 提升幅度 |

| 平均查詢時間 | 15分鐘 | 30秒 | 96.7% |

| 知識查找準確率 | 65% | 89% | 36.9% |

| 員工滿意度 | 3.2/5 | 4.6/5 | 43.8% |

| 重復問題比例 | 45% | 12% | 73.3% |

9. 未來發展趨勢

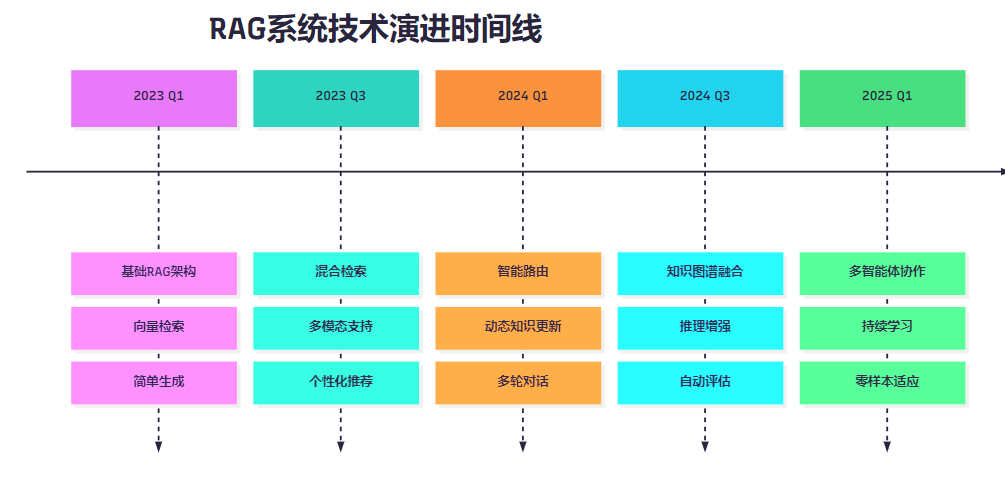

9.1 技術演進路線

圖7:RAG系統技術演進時間線

9.2 發展方向預測

- 多模態融合:支持圖像、音頻、視頻等多種數據類型

- 知識圖譜增強:結合結構化知識提升推理能力

- 個性化定制:基于用戶行為的個性化知識服務

- 實時學習:支持知識的實時更新和增量學習

10. 最佳實踐總結

基于多個項目的實戰經驗,我總結出以下最佳實踐:

10.1 架構設計原則

- 模塊化設計:各組件松耦合,便于獨立升級

- 水平擴展:支持根據負載動態擴容

- 容錯機制:單點故障不影響整體服務

- 監控完善:全鏈路監控,快速定位問題

10.2 數據管理策略

- 數據質量優先:寧缺毋濫,確保數據準確性

- 版本控制:建立完善的數據版本管理機制

- 權限分級:根據數據敏感度設置訪問權限

- 定期清理:及時清理過期和無效數據

10.3 用戶體驗優化

- 響應速度:核心查詢控制在3秒內

- 結果相關性:持續優化檢索和排序算法

- 界面友好:提供直觀的交互界面

- 反饋機制:收集用戶反饋持續改進

總結

回顧這兩年來在企業級RAG系統建設中的探索歷程,我深深感受到這項技術對企業知識管理帶來的革命性變化。從最初的技術驗證到規模化部署,從單一場景應用到全企業推廣,每一步都充滿了挑戰與收獲。

RAG系統的成功落地絕不僅僅是技術問題,它涉及到組織架構、業務流程、用戶習慣等多個層面的變革。作為技術人員,我們需要站在更高的視角,統籌考慮技術可行性、業務價值、用戶體驗等多重因素。

在技術實現層面,我們看到了從簡單的向量檢索到復雜的多模態融合,從靜態知識庫到動態學習系統的演進。每一次技術升級都帶來了用戶體驗的顯著提升,也為企業創造了更大的價值。

在項目管理層面,我深刻體會到跨部門協作的重要性。RAG系統的建設需要IT部門、業務部門、數據管理部門等多方協同,只有形成合力才能確保項目的成功。

展望未來,我相信RAG技術還將繼續演進,多智能體協作、持續學習、零樣本適應等新特性將進一步提升系統的智能化水平。同時,隨著大模型技術的不斷發展,RAG系統也將變得更加強大和易用。

對于正在或即將開展RAG系統建設的團隊,我的建議是:從小規模試點開始,逐步積累經驗;重視數據質量,這是系統成功的基礎;關注用戶反饋,持續優化用戶體驗;建立完善的監控體系,確保系統穩定運行。

技術的價值在于解決實際問題,創造真正的價值。RAG系統作為連接人工智能與企業知識的橋梁,必將在未來的數字化轉型中發揮更加重要的作用。讓我們一起在這個充滿機遇的領域中,繼續探索、創新,為企業的智能化發展貢獻自己的力量。

我是摘星!如果這篇文章在你的技術成長路上留下了印記

👁? 【關注】與我一起探索技術的無限可能,見證每一次突破

👍 【點贊】為優質技術內容點亮明燈,傳遞知識的力量

🔖 【收藏】將精華內容珍藏,隨時回顧技術要點

💬 【評論】分享你的獨特見解,讓思維碰撞出智慧火花

🗳? 【投票】用你的選擇為技術社區貢獻一份力量

技術路漫漫,讓我們攜手前行,在代碼的世界里摘取屬于程序員的那片星辰大海!

參考鏈接

- RAG技術原理與實踐指南

- 企業級AI系統架構設計

- 向量數據庫性能優化實踐

- 大語言模型企業應用案例

- 知識管理系統建設最佳實踐

關鍵詞標簽

RAG系統 企業知識管理 向量檢索 大語言模型 智能問答

)

![【線性基】P4301 [CQOI2013] 新Nim游戲|省選-](http://pic.xiahunao.cn/【線性基】P4301 [CQOI2013] 新Nim游戲|省選-)

![[25-cv-09610]Anderson Design Group 版權維權再出擊,12 張涉案圖片及近 50 個注冊版權需重點排查!](http://pic.xiahunao.cn/[25-cv-09610]Anderson Design Group 版權維權再出擊,12 張涉案圖片及近 50 個注冊版權需重點排查!)

:是否是 AI 基礎設施中缺失的標準?)

)

)