本文面向博物館信息化開發者、智慧場館系統技術建設師及AR 設計工程師,從AR 交互與自動感應技術的邏輯出發,拆解AR虛實融合技術與智能講解自動感應技術的原理,為相關開發者實踐提供可復用的技術路徑。

如需獲取博物館智慧導覽系統解決方案請前往文章最下方獲取,如有項目合作及技術交流歡迎私信作者。

解決問題:

- 如何實現虛擬內容與實體文物的精準疊加

- 如何讓導覽系統自動感應游客位置觸發講解

- 如何用技術打破多語言導覽壁壘

一、AR互動導覽技術原理

AR互動導覽功能核心在于通過圖像識別與SLAM?技術實現虛擬空間與物理空間的精準復刻,主要包括三個技術方向:

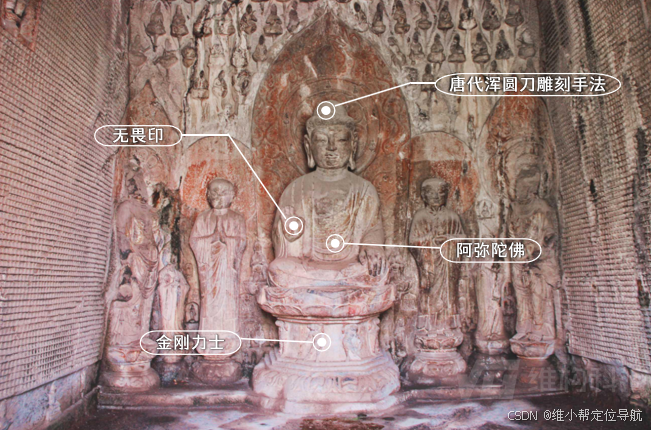

1.1 AR 展品互動:虛實交互的渲染邏輯

當游客用手機掃描實體展品時,系統完成“圖像采集 - 特征提取 - 虛擬模型匹配 - 實時渲染” 的全流程。

- 技術邏輯:通過手機攝像頭采集展品圖像,借助 OpenCV 庫提取展品細節、紋理等特征點,與后端數據庫中預存的3D模型特征庫進行匹配;匹配成功后,調用Unity庫將3D虛擬模型疊加到實景畫面。

- 核心代碼片段(基于Python):

import cv2 import numpy as np# 讀取展品模板圖與實時采集圖 template = cv2.imread('exhibit_template.jpg', 0) frame = cv2.imread('live_capture.jpg', 0)# 初始化ORB特征檢測器 orb = cv2.ORB_create() kp1, des1 = orb.detectAndCompute(template, None) kp2, des2 = orb.detectAndCompute(frame, None)# 暴力匹配特征點 bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True) matches = bf.match(des1, des2) matches = sorted(matches, key=lambda x: x.distance)# 繪制匹配結果(實際應用中需根據匹配結果計算虛擬模型坐標) img_matches = cv2.drawMatches(template, kp1, frame, kp2, matches[:10], None, flags=cv2.DrawMatchesFlags_NOT_DRAW_SINGLE_POINTS) cv2.imwrite('match_result.jpg', img_matches)1.2 AR實景導航:動態路線的實時生成

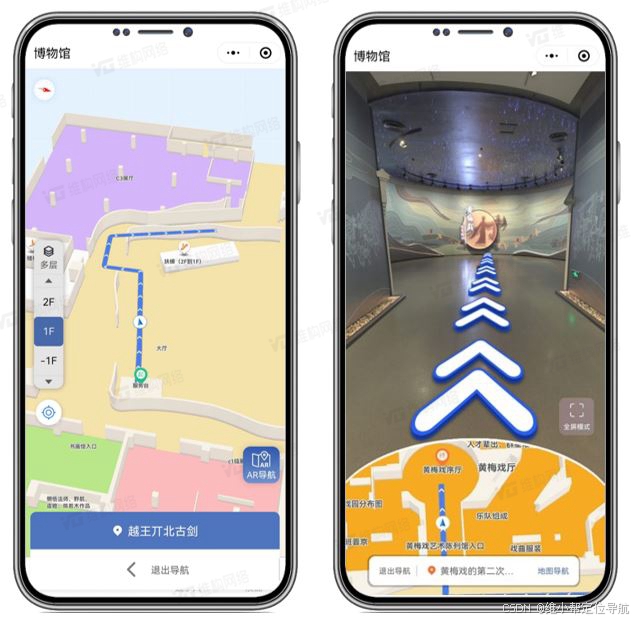

AR 實景導航的核心是空間定位與3D虛擬路線渲染的融合,解決博物館內難以辨別方向的問題。

技術邏輯:根據生成的博物館電子空間,手機傳感器自動感應游客位置;游客輸入目的地,系統規劃路線后在實景畫面中疊加3D導航線,并根據游客實時移動的位置信息更新路線。

1.3 AR趣味活動:游戲化交互的技術實現

AR 集卡、探寶等活動的核心是“空間錨點觸發機制”,通過預設虛擬錨點觸發交互任務。

- 技術邏輯:AR集卡、探寶等活動通過在博物館空間中預設虛擬錨點(基于坐標或特定圖像標記),當游客移動到錨點范圍內,手機AR引擎檢測到錨點后觸發交互任務(如彈出虛擬卡牌、解鎖文創優惠券)。

- 關鍵代碼示例(基于ARKit的錨點檢測):

using UnityEngine; using UnityEngine.XR.ARFoundation;public class ARTreasureTrigger : MonoBehaviour {[SerializeField] private ARRaycastManager raycastManager;[SerializeField] private GameObject treasurePrefab; // 虛擬寶藏模型void Update(){// 檢測是否到達預設虛擬錨點范圍List<ARRaycastHit> hits = new List<ARRaycastHit>();if (raycastManager.Raycast(new Vector2(Screen.width/2, Screen.height/2), hits)){Pose hitPose = hits[0].pose;// 若在錨點范圍內,實例化虛擬寶藏if (Vector3.Distance(hitPose.position, transform.position) < 1.5f){Instantiate(treasurePrefab, hitPose.position, hitPose.rotation);// 同步觸發文創關聯邏輯(如解鎖優惠券)文創數據服務.UnlockCoupon();}}} }二、智能講解技術原理

智能語音講解的核心是近距離感應技術與多語言資源調度,實現游客靠近即講解,多種語言切換。

2.1藍牙 Beacon自動感應觸發

- 技術邏輯:在展柜四周安裝藍牙 Beacon 設備,通過RSSI信號強度判斷游客距離,當RSSI值一定范圍波動時,識別到游客靠近展品,自動調用對應音頻資源,觸發講解播放。

- 核心代碼示例:

// 藍牙Beacon信號檢測 private BluetoothAdapter.LeScanCallback leScanCallback = new BluetoothAdapter.LeScanCallback() {@Overridepublic void onLeScan(BluetoothDevice device, int rssi, byte[] scanRecord) {// 當信號強度足夠(rssi閾值可調整),觸發講解if (rssi > -60) {String exhibitId = parseExhibitId(scanRecord); // 從廣播包解析展品IDstartAudioGuide(exhibitId); // 啟動對應展品講解}} };2.2多語言與多媒體資源調度

- 技術邏輯:系統采用“資源包加載 + 按需調用”模式,將多語言內容與多媒體資源整合為后臺資源庫,終端根據用戶選擇的語言類型及宣傳內容,自動加載對應資源。

- 關鍵代碼示例:

{"exhibitId": "bronze_001","languages": {"zh-CN": {"audio": "audio/bronze_001_zh.mp3","text": "這件青銅器為商代晚期作品...","images": ["img/bronze_001_1.jpg", "img/bronze_001_2.jpg"]},"en": {"audio": "audio/bronze_001_en.mp3","text": "This bronze ware dates back to the late Shang Dynasty...","images": ["img/bronze_001_1.jpg", "img/bronze_001_2.jpg"]}} }三、技術優化方向

- AR 渲染性能優化

??AR場景中3D模型渲染在中低端移動設備上易出現卡頓。

? 將模型輕量化處理,根據用戶與展品的距離動態切換模型精度,如遠距離時使用1000面簡化模型,近距離切換至5000面精細模型。

- 多語言資源效率優化

??多語言音頻、圖文資源體積大,易導致加載緩慢。

? 將資源按展區與語言拆分,用戶進入展區時通過后臺下載對應增量包;同時預判用戶路線(基于SLAM定位),提前預加載下一區資源。

博物館智慧導覽系統用AR 圖像識別打破虛實邊界,用自動感應技術簡化交互門檻,用多語言資源管理消除文化壁壘,為博物館智能化升級提供可復制的技術路徑。

如需獲取智慧景區導覽系統解決方案可點擊文章最下方↓?

![[MarkdownGithub] 使用塊引用高亮顯示“注意“和“警告“和其他注意方式的選項](http://pic.xiahunao.cn/[MarkdownGithub] 使用塊引用高亮顯示“注意“和“警告“和其他注意方式的選項)

)

車牌字符的分割定位)

_軟硬鏈接)

)