文章目錄

- 零 參考資料

- 一 MCP概念

- 二 MCP核心架構和功能

- 三 MCP VS OP(Others Protocol)

- 3.1 函數調用

- 3.2 模型上下文協議

- 3.3 MCP VS Others Protocol

- 3.3.1 MCP與Function Calling的對比優勢

- 3.3.2 MCP與AI Agents的協同關系

- 3.3.3 MCP與A2A協議的互補性

- 3.3.4 MCP與傳統API的技術革新

- 3.3.5 MCP的生態優勢

- 3.3.6 MCP的安全與可控性

- 3.3.7 MCP與其他主流AI協議的詳細對比表格

- 四 MCP的執行流程

- 五 MCP的問題和前景

- 5.1 MCP的問題

- 5.2 MCP未來發展前景

- 5.3 關鍵數據展望

零 參考資料

- 視頻:10分鐘講清楚 Prompt, Agent, MCP 是什么?

- 視頻:MCP是啥?技術原理是什么?一個視頻搞懂MCP的一切

- 一文帶你 “看見” MCP 的過程,徹底理解 MCP 的概念

- 什么是MCP?技術原理是什么?教你15分鐘配置本地MCP服務

一 MCP概念

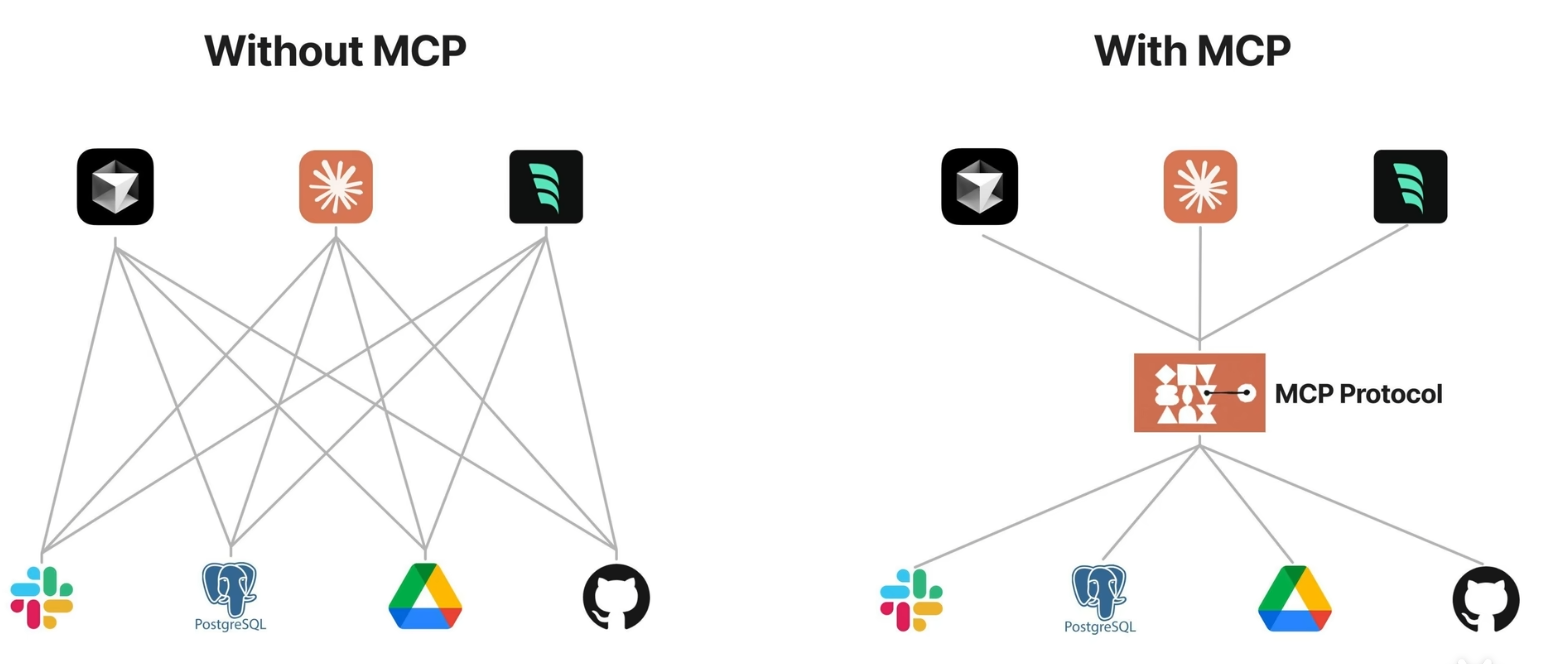

- MCP(Model Context Protocol):模型上下文協議是由Anthropic公司于2024年11月推出的開放標準協議,旨在為大型語言模型(LLM)提供標準化的外部資源連接接口。它被類比為AI領域的"USB-C接口",實現了模型與外部世界的雙向實時交互,解決了AI模型與數據源、工具之間的連接問題。

二 MCP核心架構和功能

- MCP遵循客戶端-服務器架構,包含三個核心組件:MCP主機(如AI應用或IDE)、MCP客戶端(協議客戶端)和MCP服務器(輕量級服務程序)。

- MCP主機:代表任何提供 AI 交互環境的應用程序(如 Claude 桌面版、Cursor),它能訪問工具和數據,并運行 MCP 客戶端。

- MCP 客戶端:在主機內運行,使其能與 MCP 服務器通信。

- MCP服務器:暴露特定功能并提供數據訪問。服務器通過標準協議暴露三類能力:工具(執行外部操作)、資源(提供數據訪問)和提示詞(預定義任務模板)。通信支持兩種傳輸層:stdio(標準輸入通道)用于本地進程通信,SSE(服務推送事件)用于遠程通信。

三 MCP VS OP(Others Protocol)

3.1 函數調用

- 函數調用(Function Calling)的工作原理:LLM 接收用戶的提示詞,LLM 決定它需要的工具,執行方法調用,后端服務執行實際的請求給出處理結果,大語言模型根據處理結果生成最終給用戶的回答。

- 不同的 API 需要封裝成不同的方法,通常需要編寫代碼,很難在不同的平臺靈活復用。

3.2 模型上下文協議

- 模型上下文協議(MCP)是一個開放標準,方便地連接AI助手與數據所在的系統,包括內容存儲庫、業務工具和開發環境。幫助前沿模型產生更好、更相關的響應。

- MCP相當與AI 應用程序的 “USB-C端口”。就像 USB-C 為連接設備與各種外設提供了標準化方式,MCP為 AI 模型連接不同數據源和工具提供了標準化方法。

3.3 MCP VS Others Protocol

3.3.1 MCP與Function Calling的對比優勢

- MCP協議相比Function Calling具有更強大的標準化和通用性。Function Calling是AI平臺特定的函數調用機制,需要為每個模型單獨開發適配代碼,而MCP作為開放協議標準,任何支持MCP的模型都可以直接使用現有服務。Function Calling在處理多輪對話和復雜需求時表現不佳,而MCP通過分層處理能力支持復雜、多步對話和統一上下文管理。

3.3.2 MCP與AI Agents的協同關系

- MCP為AI Agents提供了標準化的基礎設施。傳統AI Agent需要手動編碼集成各種工具,而MCP通過協議標準化使Agent能夠自動發現和使用各種服務。AI Agent可以利用MCP提供的功能描述理解更多上下文,并在各種平臺/服務自動執行任務,形成"Agent使用MCP理解服務,通過Function Calling執行操作"的協作模式。

3.3.3 MCP與A2A協議的互補性

- MCP和Google的A2A協議(Agent to Agent Protocol)形成互補的技術棧。MCP主要解決單個AI模型與外部環境的交互問題,而A2A專注于多智能體間的協作。在實際應用中,這兩種協議可以協同工作,例如智能制造場景中,MCP負責設備數據采集,A2A協調多個Agent的決策流程,共同構建更復雜的AI系統。

3.3.4 MCP與傳統API的技術革新

- 相比傳統API,MCP實現了三大突破:模塊化設計支持即插即用,降低60%以上開發成本;跨框架兼容性消除技術棧差異;二進制通信格式使延遲降低40%,帶寬利用率提升35%。MCP還解決了API的版本兼容性和高耦合性問題,成為AI時代的通信新范式。

- 與傳統API相比,MCP標準化程度高(統一協議替代定制代碼)、支持雙向交互、本地和遠程資源均可訪問、AI優化設計(返回結果更易處理)。如,用API獲取天氣需解析復雜JSON,而MCP天氣服務器直接提供簡潔預報結果。

3.3.5 MCP的生態優勢

- MCP構建了豐富的插件生態,官方和社區提供了涵蓋GitHub、Slack、AWS等領域的現成MCP Server。開發者無需重復造輪子,通過開源項目即可建立強大的AI Agent生態。這種標準化生態池的構建,使得資源整合效率提升300%,遠超過傳統封閉式插件體系。

3.3.6 MCP的安全與可控性

- MCP在安全性上具有獨特優勢:允許敏感數據留在本地,開發者可自行設計接口控制數據傳輸;內置標準化安全實踐,相比傳統API的分散安全方案更可靠;通過嚴格的訪問控制和數據加密措施,有效防止數據泄露和誤操作。這些特性使其特別適合企業級應用。

3.3.7 MCP與其他主流AI協議的詳細對比表格

| 對比維度 | MCP協議 | Function Calling | A2A協議 | 傳統API |

|---|---|---|---|---|

| 協議類型 | 開放標準協議 (Anthropic主導) | 平臺專屬機制 (如OpenAI) | 開源協議 (Google主導) | 廠商自定義接口 |

| 核心功能 | 模型與工具/數據的標準化交互 | 模型調用預定義函數 | 多智能體協作通信 | 系統間數據交換 |

| 架構設計 | 客戶端-服務器三層架構 (Host/Client/Server) | 模型內置函數注冊機制 | P2P點對點架構 | 客戶端-服務端雙向調用 |

| 通信方式 | 支持STDIO/SSE雙通道,JSON-RPC 2.0格式 | 平臺專用JSON格式 | HTTP+JSON-RPC | REST/gRPC等 |

| 擴展性 | ★★★★★ 動態發現工具,即插即用 | ★★☆☆☆ 需硬編碼函數列表 | ★★★★☆ 智能體動態注冊 | ★★☆☆☆ 需版本迭代 |

| 開發效率 | 一次集成支持所有兼容工具 (效率提升70%) | 需為每個平臺單獨開發 (效率低) | 中等,需實現AgentCard規范 | 每個API需獨立開發 (成本最高) |

| 典型延遲 | 本地<50ms,遠程100-300ms | 50-100ms (平臺內調用) | 200-500ms (跨平臺通信) | 100-1000ms (受網絡影響大) |

| 數據安全 | 支持本地化處理,敏感數據可不出域 | 依賴平臺安全策略 | 基于W3C DID的身份認證 | 需自行實現加密/認證 |

| 多輪交互 | 原生支持復雜任務鏈 (如"查天氣→建議穿搭→叫車"自動串聯) | 僅支持單次函數調用 | 通過任務狀態機管理多步協作 | 需手動維護會話狀態 |

| 典型應用 | Claude訪問本地文件/Cursor調用GitHub | ChatGPT插件功能 | 跨企業智能體協作 | 移動App調用云服務 |

| 生態成熟度 | 快速成長 (GitHub 3.5萬星標,8000+注冊Server) | 各平臺割裂 (OpenAI/Claude互不兼容) | 早期階段 (主要Google生態) | 高度成熟但碎片化 |

| 2025市場份額 | 38% (增速最快) | 45% (主流平臺仍依賴) | 12% | 5% (逐漸被替代) |

- MCP在標準化程度和開發效率上顯著領先,特別適合需要頻繁對接新工具的AI應用場景。

- Function Calling仍是平臺內置功能的優選方案,但存在生態封閉的局限性。

- A2A在多Agent協同領域不可替代,與MCP形成互補關系。

- 傳統API正被新型協議替代,僅在存量系統中保留價值。

四 MCP的執行流程

- MCP的工作流程包括連接初始化、消息交換和連接終止三個階段。消息類型分為請求-響應(如獲取工具列表)和通知(單向消息)。協議采用JSON-RPC 2.0標準,確保通信格式統一。例如,當AI需要調用外部工具時,會生成結構化JSON請求,服務器處理后返回標準化響應。

- 首先需要在主機上自動或手動配置 MCP 服務,當用戶輸入問題時, MCP 客戶端讓 大語言模型選擇 MCP 工具,大模型選擇好 MCP 工具以后, MCP 客戶端尋求用戶同意(很多產品支持配置自動同意),MCP 客戶端請求 MCP 服務器, MCP 服務調用工具并將工具的結果返回給 MCP 客戶端, MCP 客戶端將模型調用結果和用戶的查詢發送給大語言模型,大語言模型組織答案給用戶。

五 MCP的問題和前景

5.1 MCP的問題

- 技術成熟度與性能瓶頸:MCP協議在實際部署中仍面臨顯著的延遲問題,特別是在跨云服務調用時平均響應時間達到300-500ms,難以滿足實時性要求高的場景(如高頻交易、工業控制)。協議棧的冗余設計導致小型設備(如邊緣AI盒子)的內存占用超過800MB,限制了在IoT領域的應用。

- 安全與隱私風險:盡管MCP設計了數據不出域機制,但2025年Q1仍曝出三起嚴重漏洞:包括MCPServer的權限繞過漏洞(CVE-2025-0281)、協議中間人攻擊風險(未加密的SSE通道)、以及工具調用鏈污染問題(惡意服務器可注入虛假工具描述)。醫療金融等敏感行業因此暫緩大規模部署。

- 生態碎片化 :雖然OpenAI、Google等巨頭支持MCP,但各廠商實現存在隱性差異:Anthropic的v1.2協議擴展了動態工具注冊,而微軟Azure版本則閹割了本地文件系統訪問功能。這導致開發者需要編寫15-20%的兼容性代碼,違背了"一次編寫處處運行"的初衷。

- 商業模式不清晰:MCPServer市場出現"公地悲劇"現象:GitHub上87%的開源Server缺乏持續維護,而商業化Server又面臨定價難題(按調用次數收費導致成本不可控)。早期明星項目如TextIn OCR服務已因虧損暫停免費額度。

5.2 MCP未來發展前景

- 技術演進路線:MCP工作組已公布2.0路線圖,重點優化:量子加密傳輸(2026Q2)、邊緣計算支持(2025Q4)、以及神經符號系統集成(2027)。測試顯示新協議可使醫療影像分析場景的端到端延遲降低至80ms,滿足手術機器人需求。

- 垂直行業突破 :制造業將成為最大受益領域,通過MCP連接ERP+MES+PLC系統,寶馬工廠試點項目顯示設備故障預測準確率提升40%,工單處理時間縮短65%。另據Gartner預測,到2027年60%的企業AI項目將采用MCP作為核心集成層。

- 新交互范式興起 :“對話即操作”(Conversation as Operation)模式正在普及:阿里云數據顯示,接入MCP的釘釘用戶中,73%的審批/報銷流程已完全通過自然語言指令完成。這種變革可能重構現有企業軟件交互體系。

- 標準戰爭與格局重塑 :雖然當前MCP占據38%市場份額,但Google主導的A2A協議正通過"聯邦學習+多Agent"組合方案爭奪控制權。行業分析師認為,最終可能形成"MCP負責工具連接,A2A管理Agent協作"的二分格局。

5.3 關鍵數據展望

- 2026年全球MCP相關市場規模預計達$82億(CAGR 56%)

- 開發者工具領域滲透率將率先突破75%(VS Code等主流IDE已內置支持)

- 中國"AI新基建"計劃明確將MCP納入關鍵技術清單,預計帶動200億政府投資

)

![[創業之路-377]:企業戰略管理案例分析-戰略制定/設計-市場洞察“五看”:看宏觀之社會發展趨勢:數字化、智能化、個性化的趨勢對初創公司的戰略機會](http://pic.xiahunao.cn/[創業之路-377]:企業戰略管理案例分析-戰略制定/設計-市場洞察“五看”:看宏觀之社會發展趨勢:數字化、智能化、個性化的趨勢對初創公司的戰略機會)

)

)

)