針對深度學習入門新手目標不明確 知識體系雜亂的問題 擬開啟快速入門深度學習系列文章的創作

旨在幫助大家快速的入門深度學習

寫在前面:

本系列按照吳恩達系列課程順序發布(說明一下為什么不直接看原筆記 因為內容太多 沒有大量時間去閱讀 所有作者需要一次梳理清楚 并整理思路 方便后續學習

對于入門的建議就是 在看文章的時候 如果有不懂的概念及時的搜索一下

本人學識有限 以上內容均根據本人理解 如有不對的地方大家多多指正 歡迎交流

本系列吳恩達深度學習入門系列作為起點 可能會穿插代碼或者公式的推導

本系列也是對本人自2月25日以來學習深度學習內容的梳理與總結

希望我們都可以親手殺死曾經那個頹廢的自己!

---------------------------------------------------------------------------------------------------------------------------------

邏輯回歸用于二分類任務 本文也以這個例子進行說明

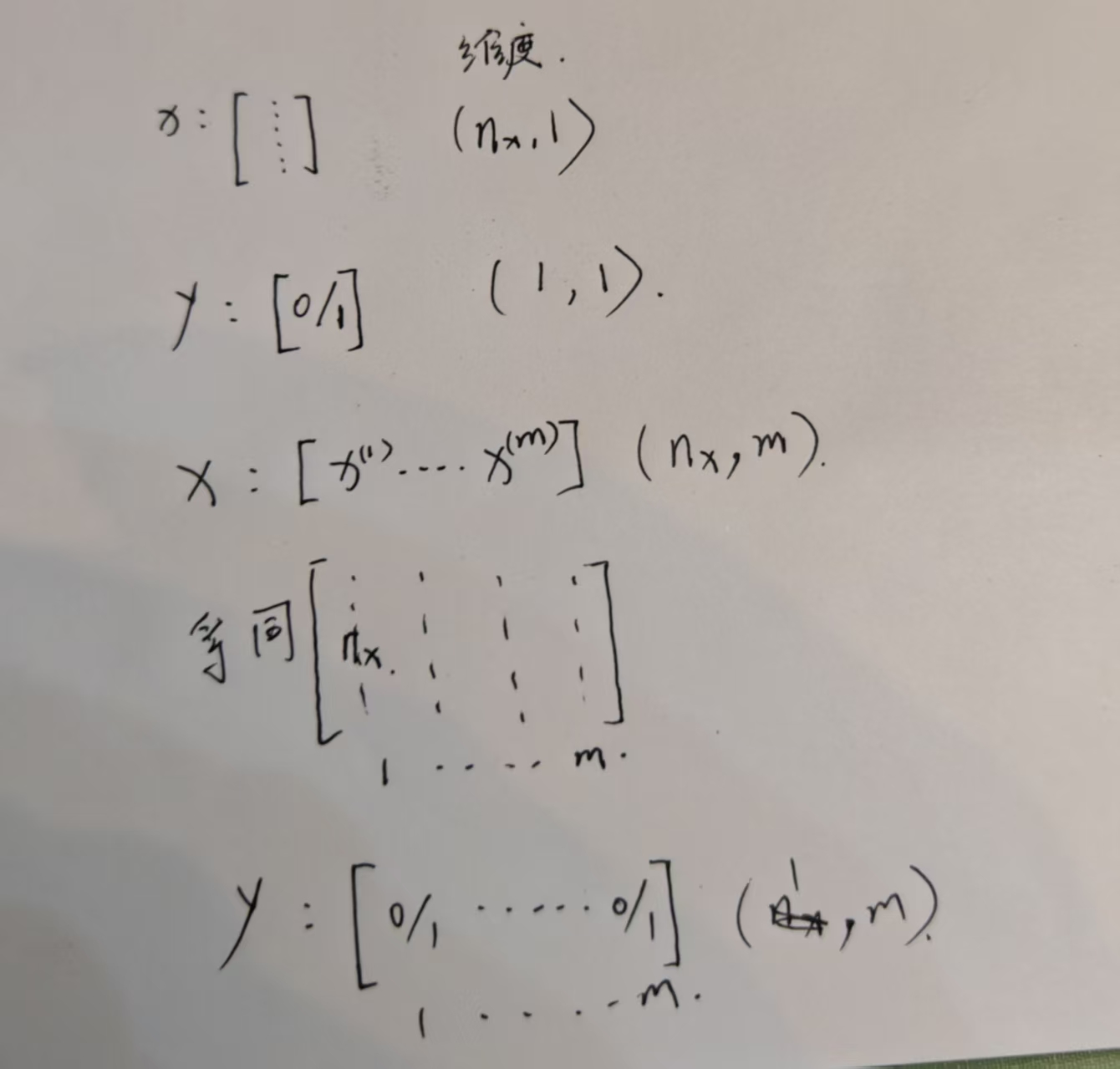

如圖 這是一個二分類任務 1代表貓 0代表狗

在計算機中 圖像的表示形式如下圖所示 這里有三個通道 紅綠藍 這里只是化了5*4個格子 代表像素 實際上 像素可以是64*64 或者更大

?

以64*64像素為例 在輸入之前 我們要把這些像素用特征向量來表示 對于本例 像素的大小就是64*64*3?

這里的維度 大家一定搞清楚 很重要 不理解的看下面的圖

解釋一下這張圖 首先y預測就是對y的估計 表示了y=1是一只貓的可能性 我們需要用w x b表示y預測 但是這樣是不行的 因為我們輸出的是概率 在0-1之間 所以要套上一層sigmoid激活函數

對于激活函數的定義 和曲線已經畫出 順便說一下 訓練的過程就是不斷學習w b的過程 以更好的預測y

損失函數

我們定義一個損失函數 通過讓損失函數更趨近于0來更新w b 來更加靠近真實的y

本例損失函數如下圖 已經解釋的很清楚了

代價函數

注意在表示第i個樣本時 括號在上面

梯度下降法

可以看出 梯度下降就是在不斷尋找J最小的點 并以此確定w b

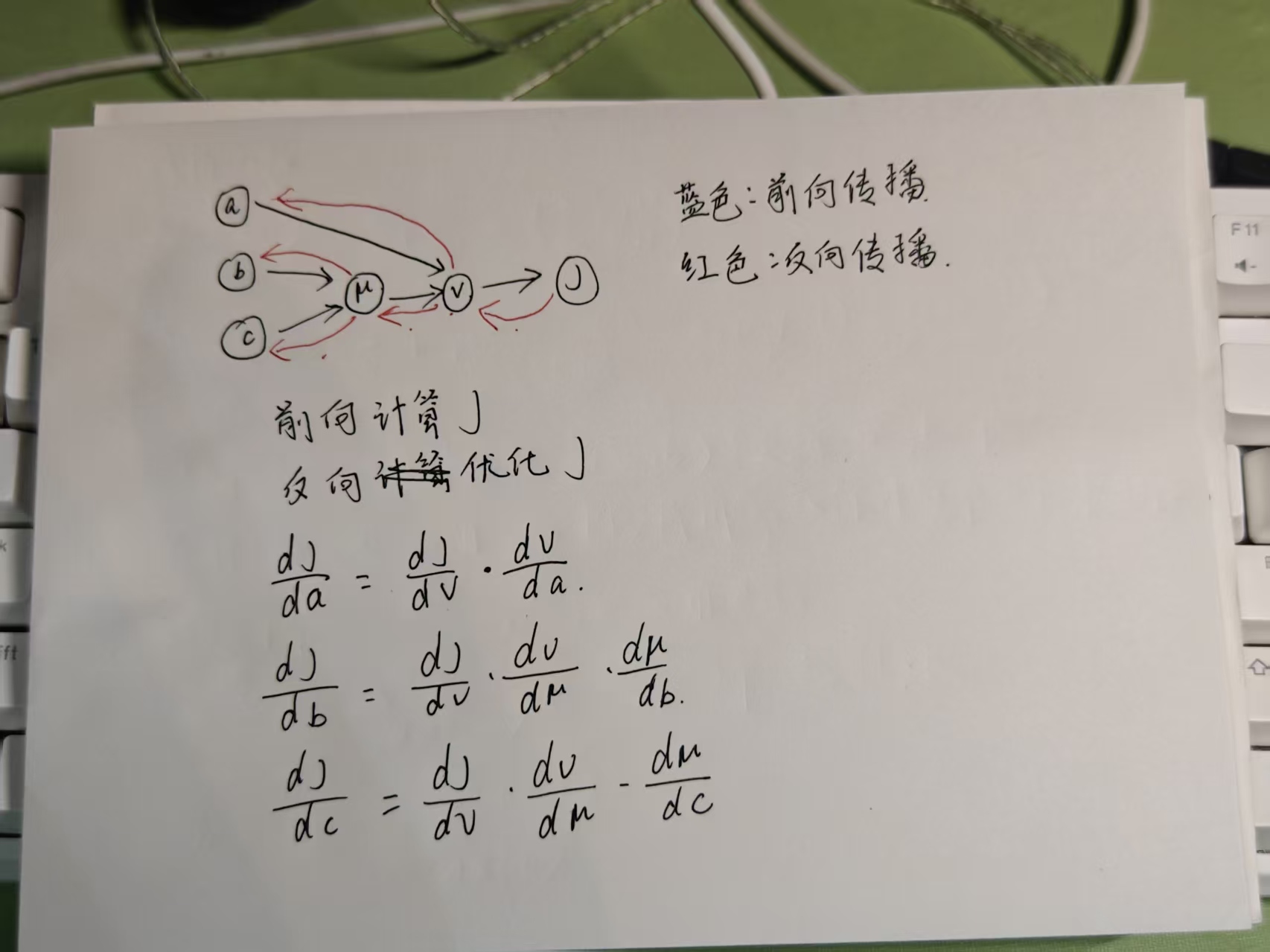

計算圖

邏輯回歸中的梯度下降

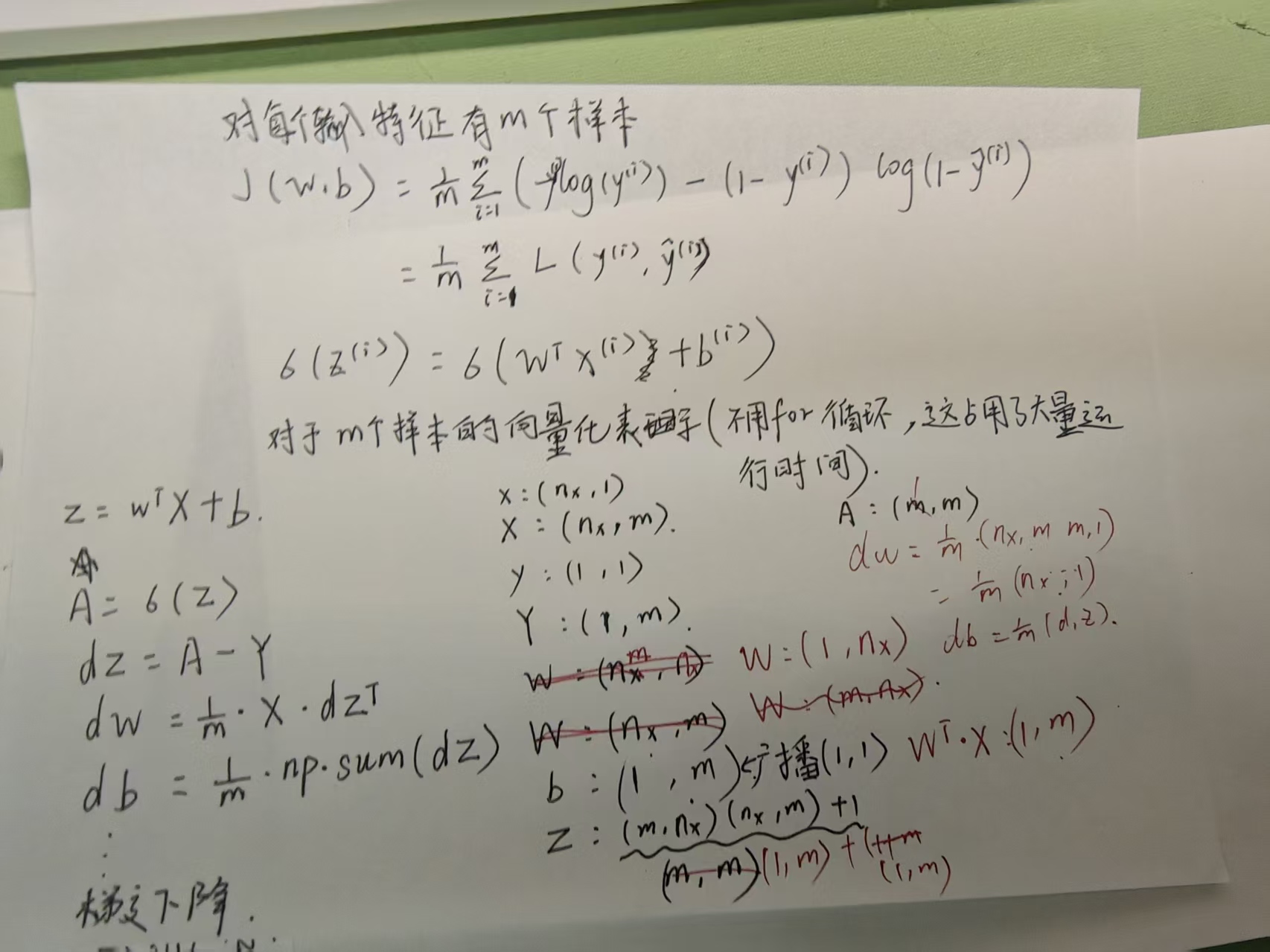

對于M個樣本的邏輯回歸

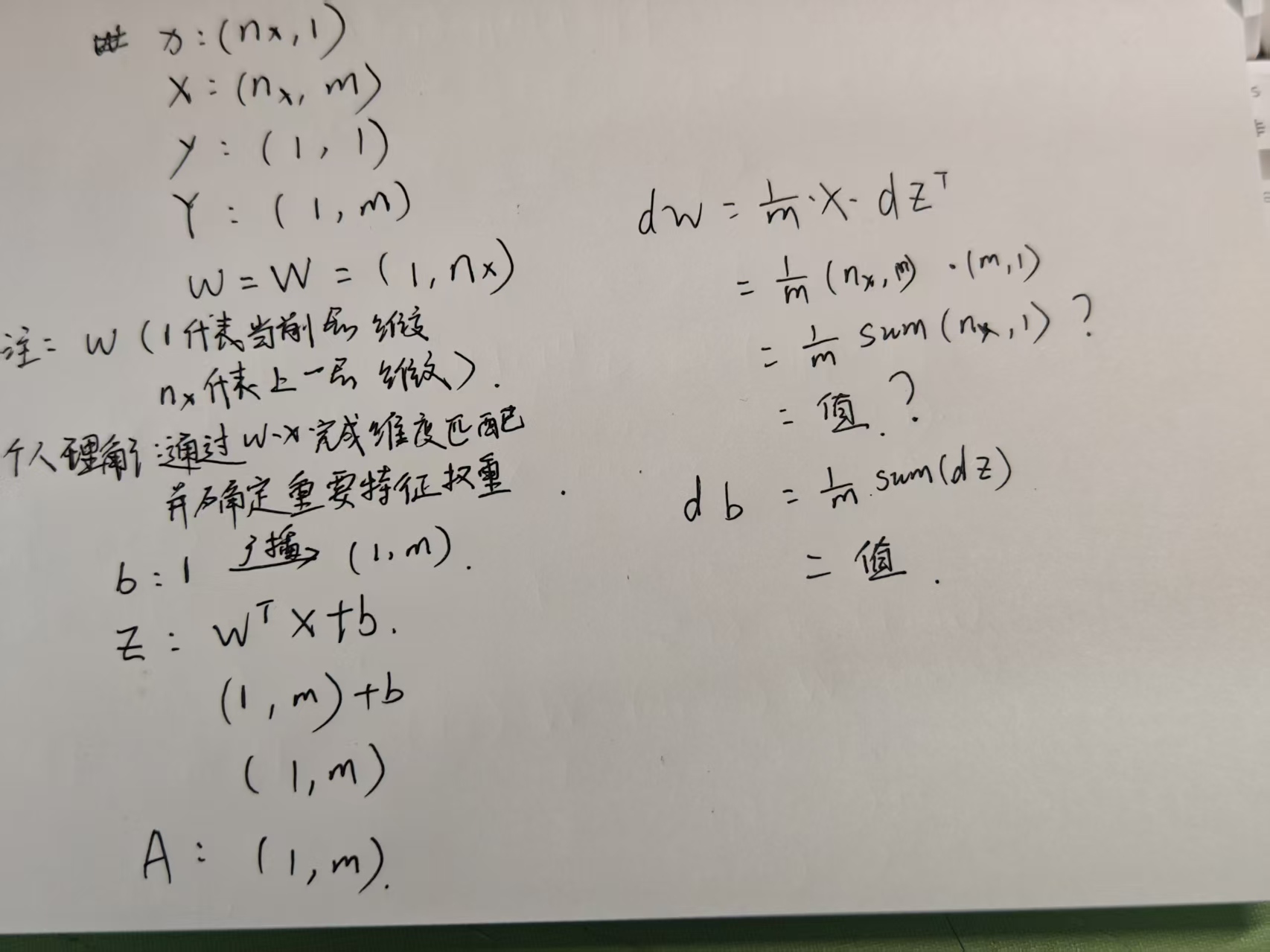

下面寫的有點亂 維度可以看這張 對于W的維度 還是有一些不確定 希望大佬指正

?

)