通常,一個大的復雜的模型的loss會低,但是擬合方面不夠,小的模型在擬合方面更好,但是loss高,我們可以通過深度學習來得到一個有著低loss的小模型

我們之前學過,peacewise linear可以用常數加上一堆這個階梯型函數得到,然后因為peacewise linear可以逼近任何function,所以理論上,用neural network可以實現任何function ?

?

?所以有人說只要neuron足夠多,一層network就可以了,那我們就應該通過矮胖model和高瘦model來對比,看看怎么回事

結果是這樣的,這證明同樣參數量的時候,深的模型會更好,也更有效率

為什么多層會帶來好處?

用邏輯電路是這樣子的

在做程序的時候

剪窗花

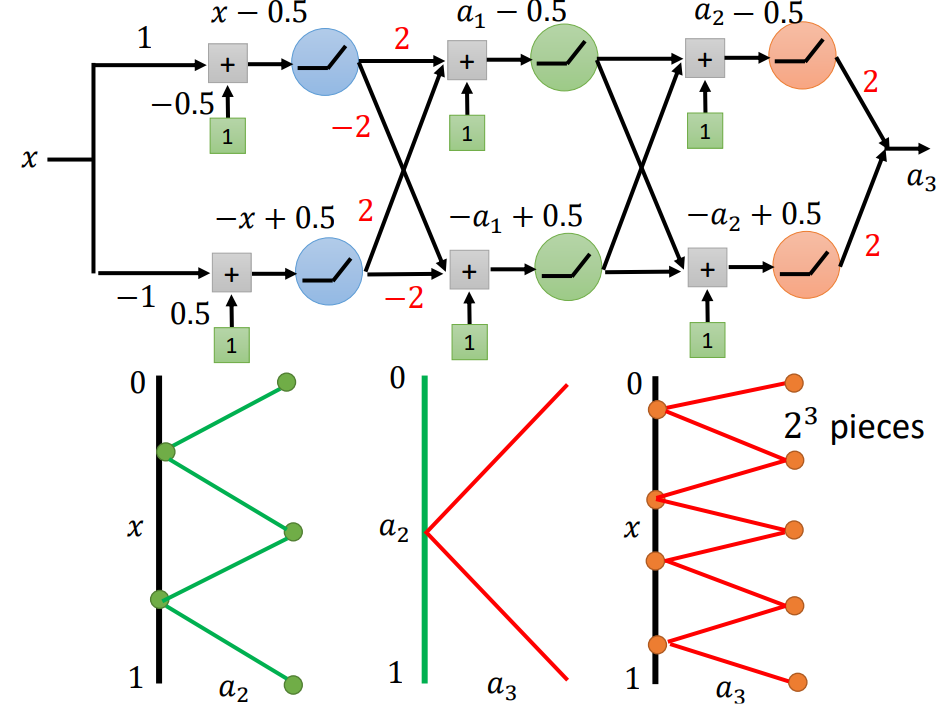

接下來解釋為什么深度比寬度好

第二層是這樣子的一個關系,那么第三層是什么樣的關系呢

于是我們可以發現,這是dimension上的差別,neuron數量之間有極大差距,也可以這么說,實現同一個function,shallow的model更復雜,也就更容易overfitting

所以,深度學習是一個魚與熊掌兼得的方法

)

:移情階段評分體系構建與實戰案例解析)

:[macOS 64bit App開發]: 注意“回車換行“的跨平臺使用.](http://pic.xiahunao.cn/[原創](現代Delphi 12指南):[macOS 64bit App開發]: 注意“回車換行“的跨平臺使用.)