今天,我們將學習如何部署由阿里巴巴最新Qwen 3驅動的Agentic RAG。

這里是我們的工具棧:

-

CrewAI用于代理編排。

-

Firecrawl用于網絡搜索。

-

LightningAI的LitServe用于部署。

頂部的視頻展示了這一過程。

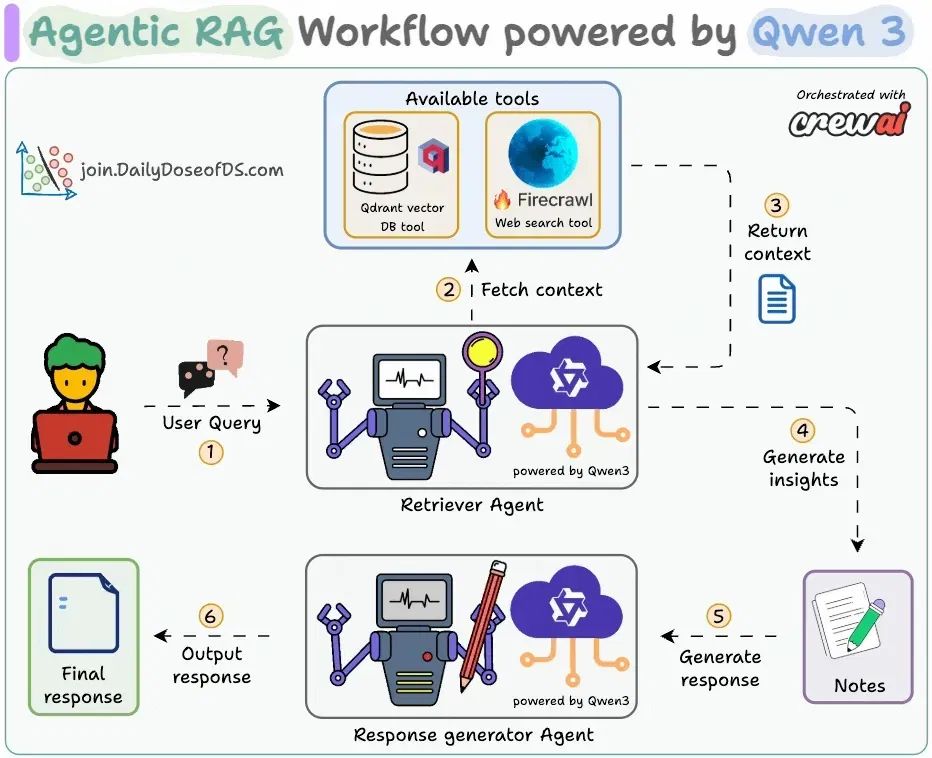

圖表顯示了我們的Agentic RAG流程:

-

檢索代理接受用戶查詢。

-

它調用相關工具(Firecrawl網絡搜索或向量DB工具)以獲取上下文并生成見解。

-

寫作代理生成響應。

接下來,讓我們實現并部署它!

代碼稍后在問題中鏈接。

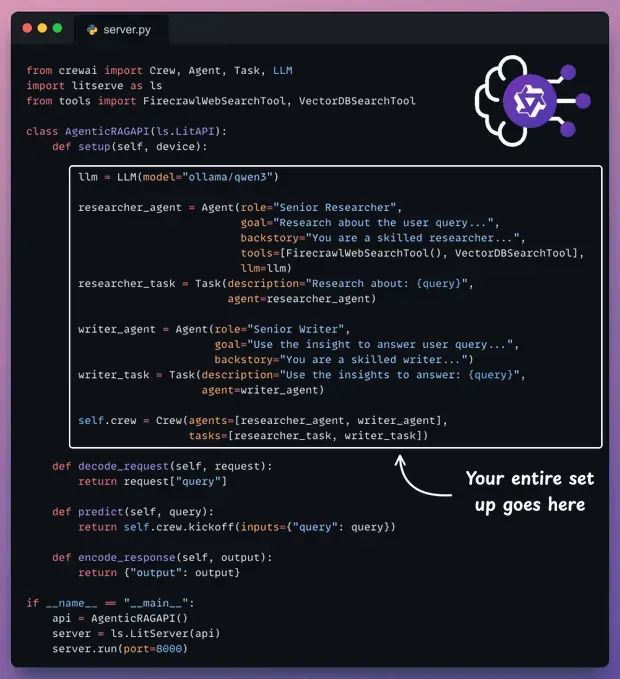

這里是為我們的Agentic RAG服務的完整代碼。

-

setup方法編排代理。 -

decode_request方法準備輸入。 -

predict方法調用Crew。 -

encode_response方法發送響應回來。

讓我們下面一步一步理解它

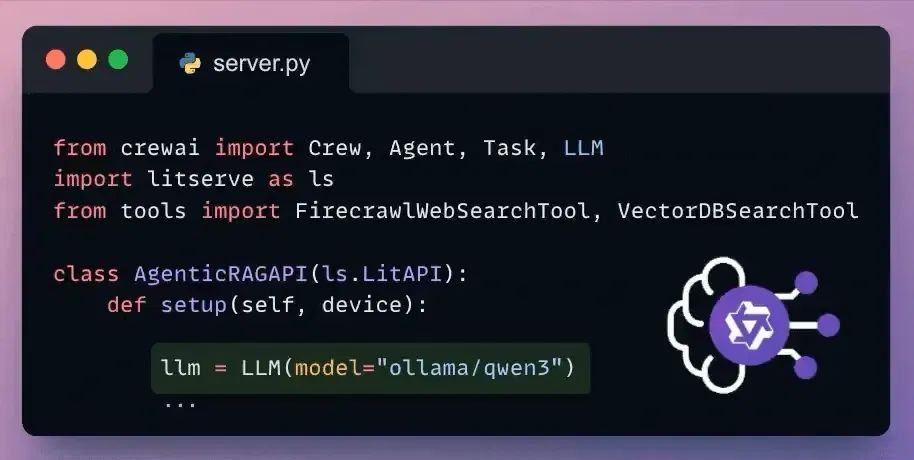

Set up LLM

CrewAI與所有流行的LLMs和提供商無縫集成。

這里是通過Ollama設置本地Qwen 3的方式。

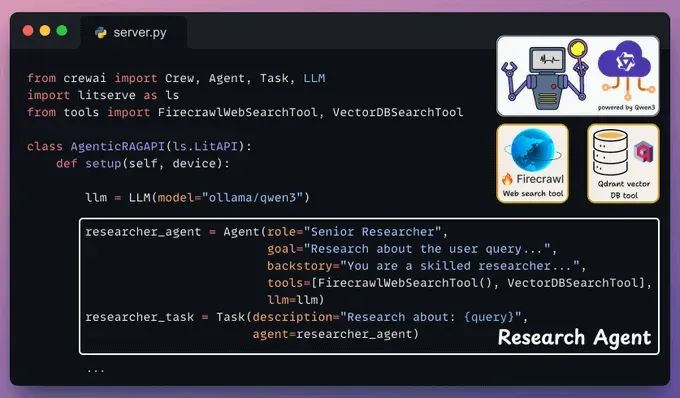

Define Research Agent and Task

這個代理接受用戶查詢,并使用向量DB工具和由Firecrawl驅動的網絡搜索工具檢索相關上下文。

再次,在LitServe的setup()方法中放入這個:

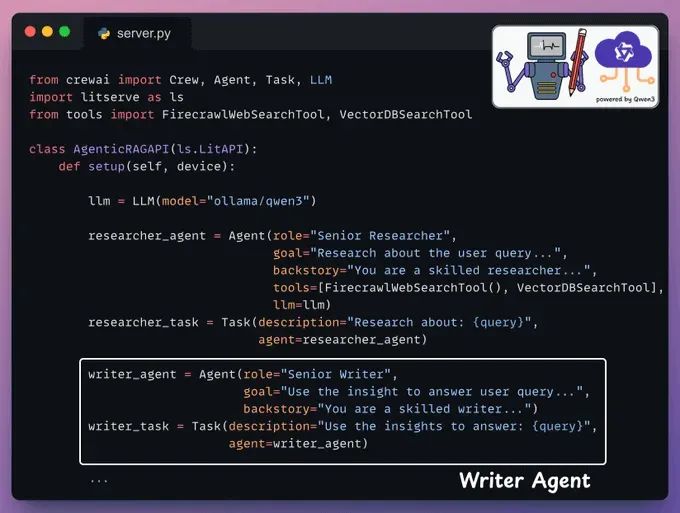

Define Writer Agent and Task

接下來,寫作代理接受研究者代理的見解以生成響應。

我們再次在LitServe的setup方法中添加這個:

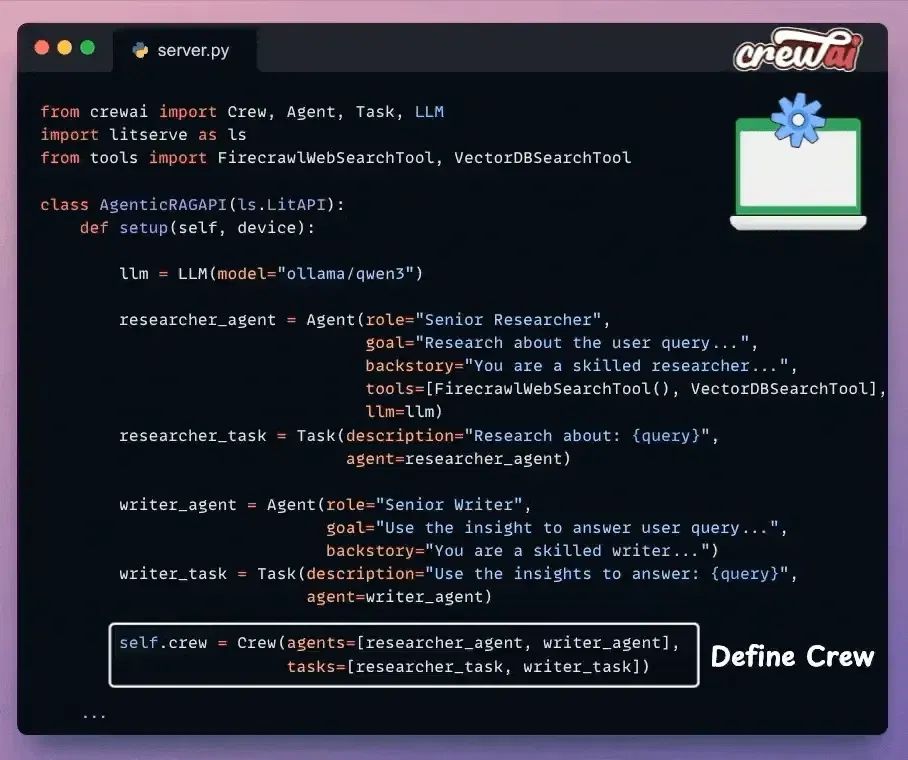

Set up the Crew

一旦我們定義了代理及其任務,我們使用CrewAI將它們編排成一個團隊,并將其放入一個設置方法中。

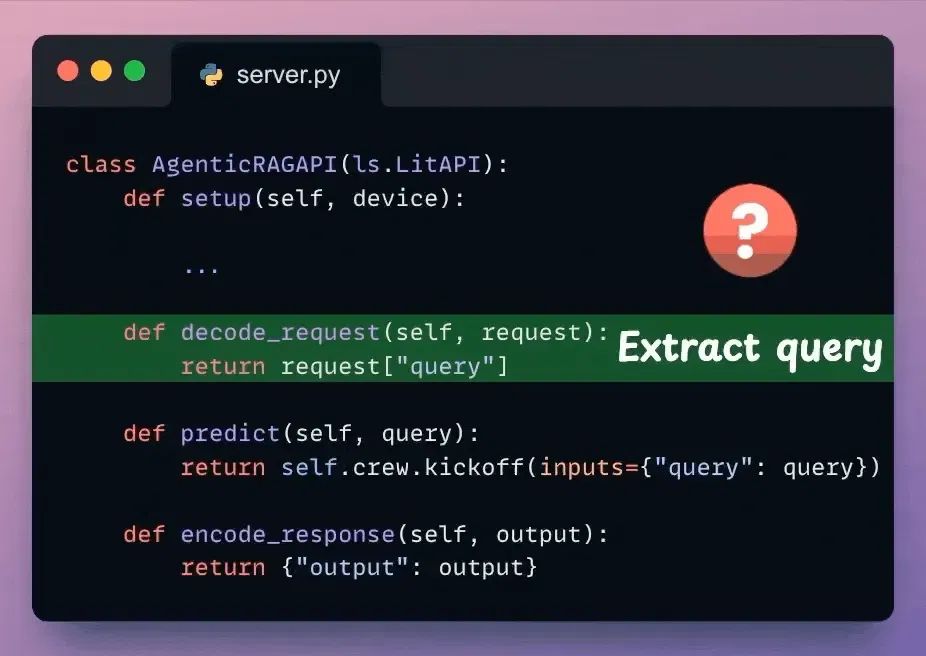

Decode request

我們已經編排了Agentic RAG工作流程,該工作流程將在收到請求時執行。

接下來,從收到的請求體中提取用戶查詢。

檢查下面突出顯示的代碼:

Predict

我們使用解碼的用戶查詢,并將其傳遞給之前定義的Crew,以從模型生成響應。

檢查下面突出顯示的代碼:

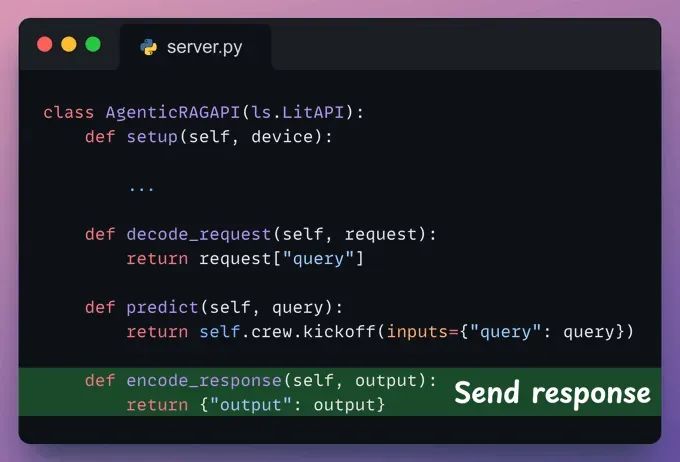

Encode response

這里,我們可以對響應進行后處理并將其發送回客戶端。

注意:LitServe內部按順序調用這些方法:decode_request?→?predict?→?encode_request。

檢查下面突出顯示的代碼:

我們完成了服務器代碼。

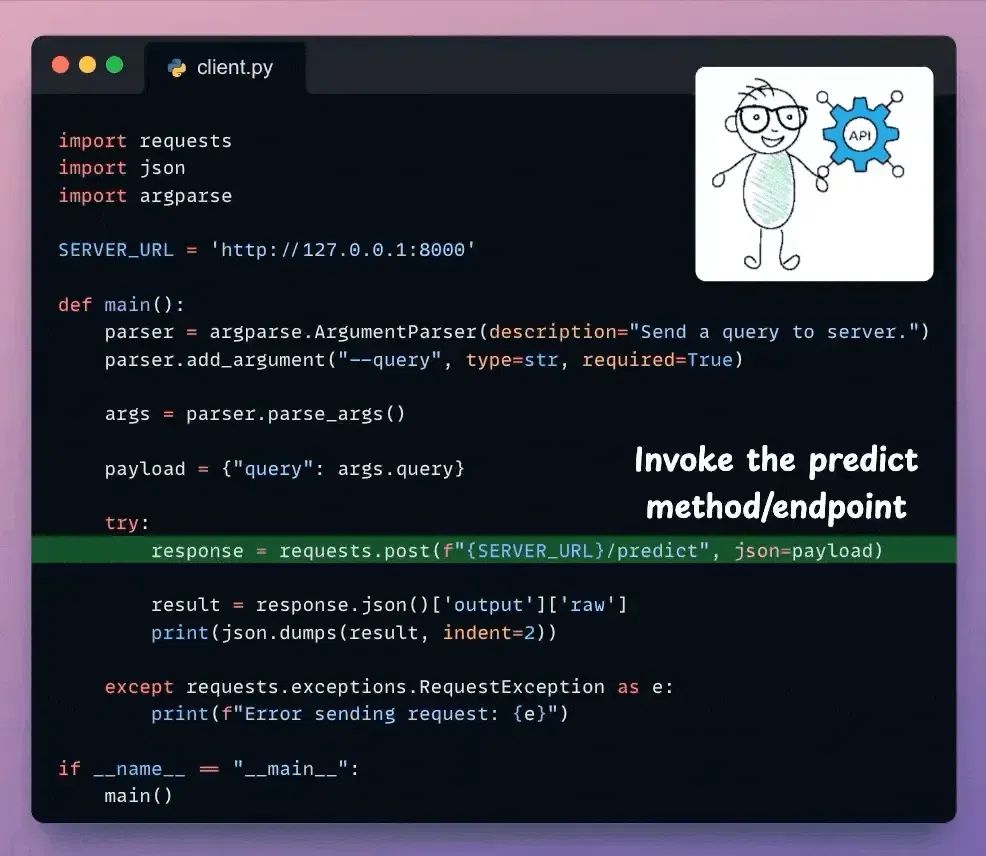

接下來,我們有基本的客戶端代碼來調用我們使用requests Python庫創建的API:

完成!

我們已經使用LitServe部署了完全私有的Qwen 3 Agentic RAG。這里是部署的Qwen3 Agentic RAG的回顧。

原文地址:https://blog.dailydoseofds.com/p/deploy-a-qwen-3-agentic-rag

![[論文閱讀]ControlNET: A Firewall for RAG-based LLM System](http://pic.xiahunao.cn/[論文閱讀]ControlNET: A Firewall for RAG-based LLM System)