最近,AIM 評測了在計算機上本地運行大語言模型(LLM)的最佳工具,Ollama 脫穎而出,成為最高效的解決方案,提供了無與倫比的靈活性。Ollama 是 Jeffrey Morgan 開發的一款開源工具,它正在徹底改變愛好者在本地終端上運行大語言模型的方式。

Ollama 具有友好的用戶界面,并與 LLaMA 2 和 Mistral 等流行模型兼容,希望安全、經濟、高效地進行大語言模型實驗的用戶可以輕松考慮使用 Ollama。它能讓用戶利用先進人工智能模型的力量,而無需依賴云服務或昂貴的硬件。

AIM 通過在 Linux (Pop!_OS)、macOS 和 Windows 等多個操作系統上運行多個大語言模型對 Ollama 進行了測試,以便讓讀者全面了解這款實用工具。

Ollama:在本地快速運行大語言模型的工具

奧拉馬運行獵鷹 2 號

奧拉馬運行獵鷹 2 號

雖然它是在終端上本地運行大語言模型的最快解決方案,但如果你不習慣這樣做,也可以使用圖形用戶界面,但它需要一些額外的步驟(大多數基本用戶都希望避免這些步驟)。

Ollama 可以直接從其庫中獲取大量大語言模型,只需執行一條命令即可下載。下載完成后,只需執行一條命令即可開始使用。這對那些工作負荷主要圍繞終端窗口的用戶很有幫助。如果他們在某個地方卡住了,無需切換到另一個瀏覽器窗口就能得到答案。

在 Linux 上使用 Ollama 時,我們發現其開發人員采用了一種令人驚訝的方法。當你執行安裝腳本時,它會自行處理所有 GPU 驅動程序,無需額外步驟。

另一方面,我們發現 macOS 的安裝程序是三個平臺中最精致的,因為它非常易于瀏覽和使用。當然,你最終必須切換到終端,但它帶你進入終端的方式非常流暢。

不過,如果你想通過圖形用戶界面使用 Ollama,可以使用 Open Web UI。但它只能通過 Docker 容器安裝,這對于不熟悉容器概念的用戶來說可能會很麻煩。

AIM 指出,Ollama 唯一的缺點是沒有提供官方文檔,說明如何使用已經下載的大語言模型。

模型最重要

最肯定的是,使用像 Ollama 這樣的最小實用工具在本地運行大語言模型,會讓你比其他工具更有優勢,但歸根結底,你使用的是什么模型最重要。

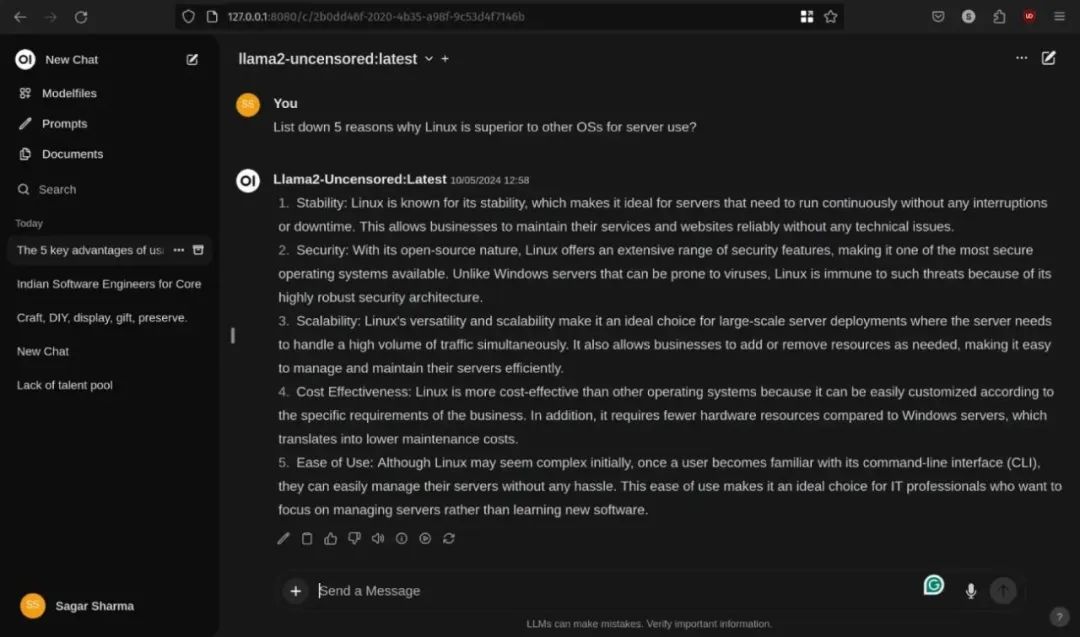

例如,我們在 Ollama 上并排使用了 Llama 2 和 Llama 3,結果讓我們大吃一驚。

在 Ollama 中運行 llama2 和 llama3

在 Ollama 中運行 llama2 和 llama3

正如您所看到的,Llama 2 在幾秒鐘內就開始回答我們的問題,而 LLaMA 3 則花了很長時間,但卻針對給定的標準給出了令人信服的詳細答案。我們在多個實用工具上測試了 LLaMA 2,但 Llama + 終端給出的結果最快,因此我們得出結論:在終端中使用時,Ollama 的速度最快。

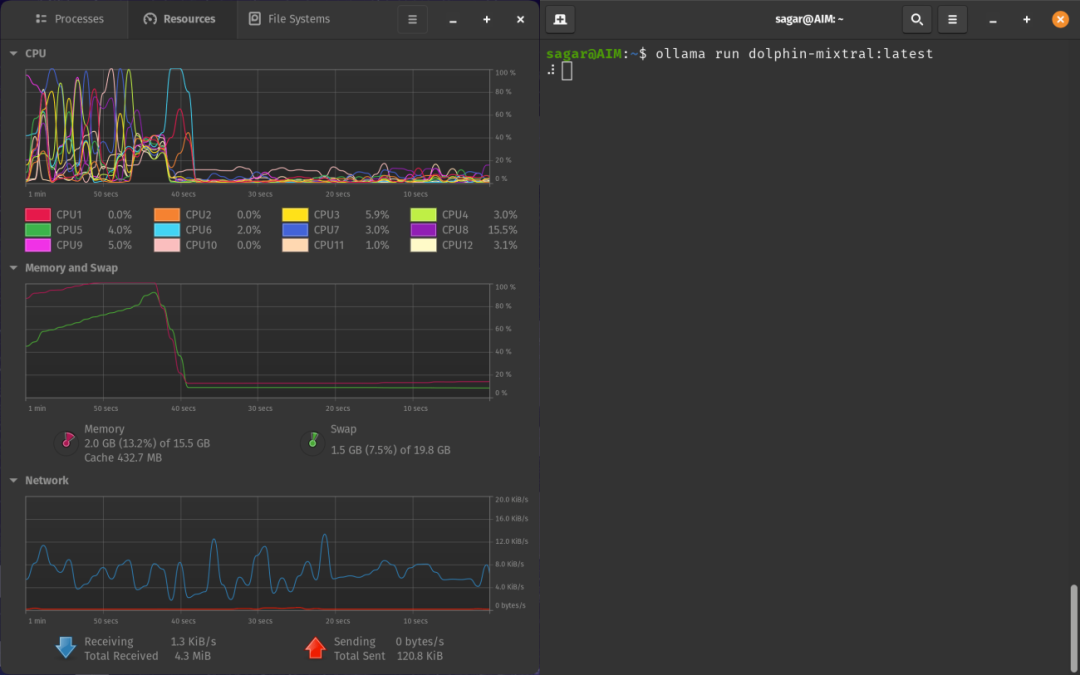

此外,如果你嘗試加載一個超出你的規格所能承受的非常大的模型,就像其他工具一樣,Ollama 將無法加載給定的模型。更可悲的是,它甚至不會通知你 Ollama 已經停止加載模型。

解決這個問題的唯一辦法就是密切關注系統資源。當你看到資源消耗突然下降時,說明 Ollama 加載模型失敗,你可以停止整個過程(否則會無休止地顯示加載動畫)。

總之,我們發現 Ollama 靈活而快速。它既能讓你使用圖形用戶界面,又能在終端中快速響應,可謂一舉兩得。不過,如果你想使用一些簡單的工具,我們很快就會向你介紹 Jan,這是一款能讓你在本地運行大語言模型的工具,可以讓你事半功倍。

?

如何學習AI大模型?

作為一名熱心腸的互聯網老兵,我決定把寶貴的AI知識分享給大家。 至于能學習到多少就看你的學習毅力和能力了 。我已將重要的AI大模型資料包括AI大模型入門學習思維導圖、精品AI大模型學習書籍手冊、視頻教程、實戰學習等錄播視頻免費分享出來。

這份完整版的大模型 AI 學習資料已經上傳CSDN,朋友們如果需要可以微信掃描下方CSDN官方認證二維碼免費領取【保證100%免費】

一、全套AGI大模型學習路線

AI大模型時代的學習之旅:從基礎到前沿,掌握人工智能的核心技能!

二、640套AI大模型報告合集

這套包含640份報告的合集,涵蓋了AI大模型的理論研究、技術實現、行業應用等多個方面。無論您是科研人員、工程師,還是對AI大模型感興趣的愛好者,這套報告合集都將為您提供寶貴的信息和啟示。

三、AI大模型經典PDF籍

隨著人工智能技術的飛速發展,AI大模型已經成為了當今科技領域的一大熱點。這些大型預訓練模型,如GPT-3、BERT、XLNet等,以其強大的語言理解和生成能力,正在改變我們對人工智能的認識。 那以下這些PDF籍就是非常不錯的學習資源。

四、AI大模型商業化落地方案

作為普通人,入局大模型時代需要持續學習和實踐,不斷提高自己的技能和認知水平,同時也需要有責任感和倫理意識,為人工智能的健康發展貢獻力量。

)

)

淘寶的鏡像域名更換)

)案例復現)

插件 + gitee))