Python爬蟲大師課:HTTP協議深度解析與工業級請求封裝

從零構建企業級爬蟲框架(附完整源碼)

一、爬蟲基礎:網絡世界的通行證

??HTTP協議核心數據??:

-

全球網站數量:20億+

-

HTTP請求占比:83%

-

爬蟲流量占比:37%

-

請求錯誤率:15-30%

-

協議版本分布:HTTP/1.1(78%)、HTTP/2(22%)

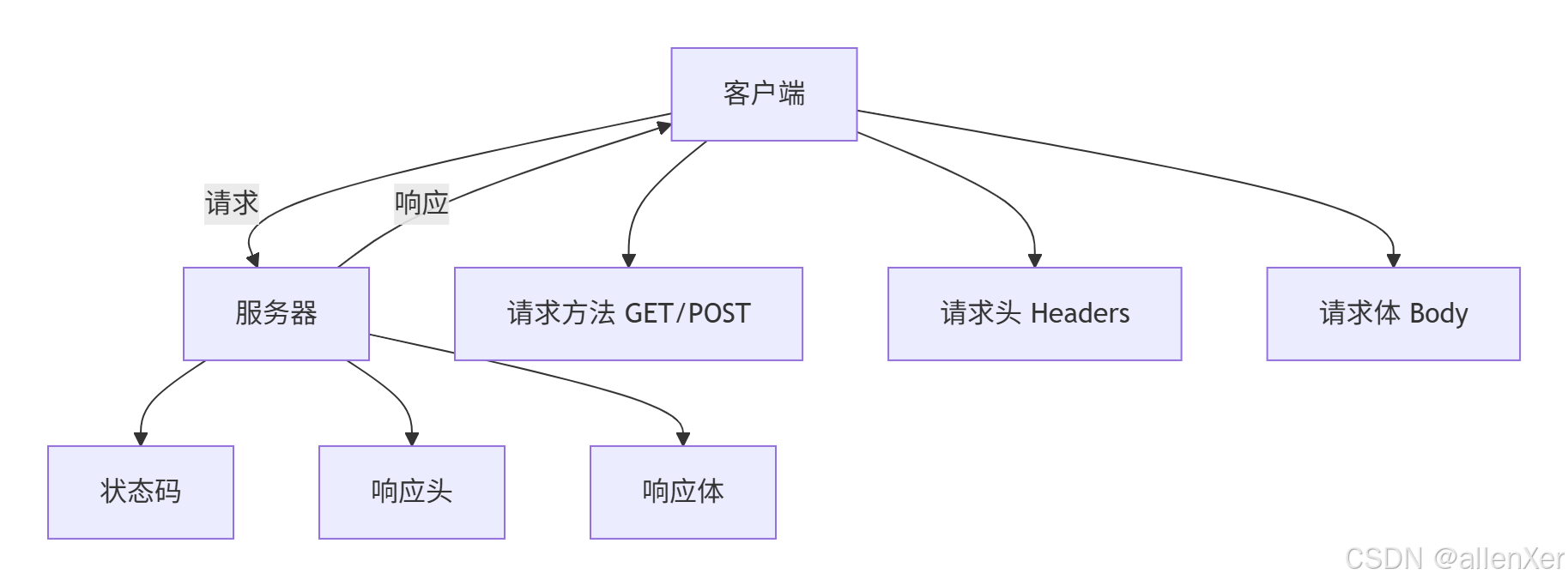

二、HTTP協議深度解析

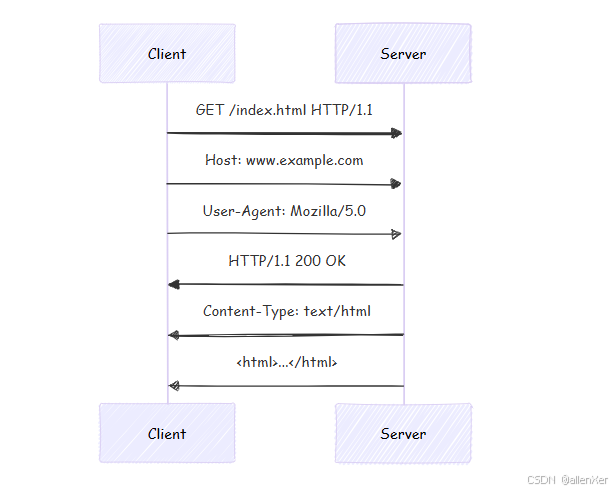

1. 請求響應全流程

2. 關鍵協議頭解析

| 頭部字段 | 作用 | 爬蟲關鍵點 |

|---|---|---|

| User-Agent | 標識客戶端 | 反爬識別點 |

| Cookie | 會話狀態 | 登錄維持 |

| Referer | 來源頁面 | 反爬檢查 |

| Accept-Encoding | 壓縮支持 | 數據解壓 |

| Content-Type | 數據類型 | 解析依據 |

三、Requests庫高級用法揭秘

1. 基礎請求示例

import requests# 簡單GET請求

response = requests.get('https://www.example.com')

print(f"狀態碼: {response.status_code}")

print(f"響應內容: {response.text[:100]}...")# 帶參數GET請求

params = {'key1': 'value1', 'key2': 'value2'}

response = requests.get('https://httpbin.org/get', params=params)

print(f"請求URL: {response.url}")# POST請求

data = {'username': 'admin', 'password': 'secret'}

response = requests.post('https://httpbin.org/post', data=data)

print(f"響應JSON: {response.json()}")2. Session對象妙用

# 創建會話

session = requests.Session()# 設置公共頭

session.headers.update({'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36','Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8'

})# 登錄保持

login_data = {'user': 'test', 'pass': 'password'}

session.post('https://example.com/login', data=login_data)# 使用會話訪問

profile = session.get('https://example.com/profile')

print(f"登錄狀態: {'成功' if '歡迎' in profile.text else '失敗'}")四、企業級請求封裝實戰

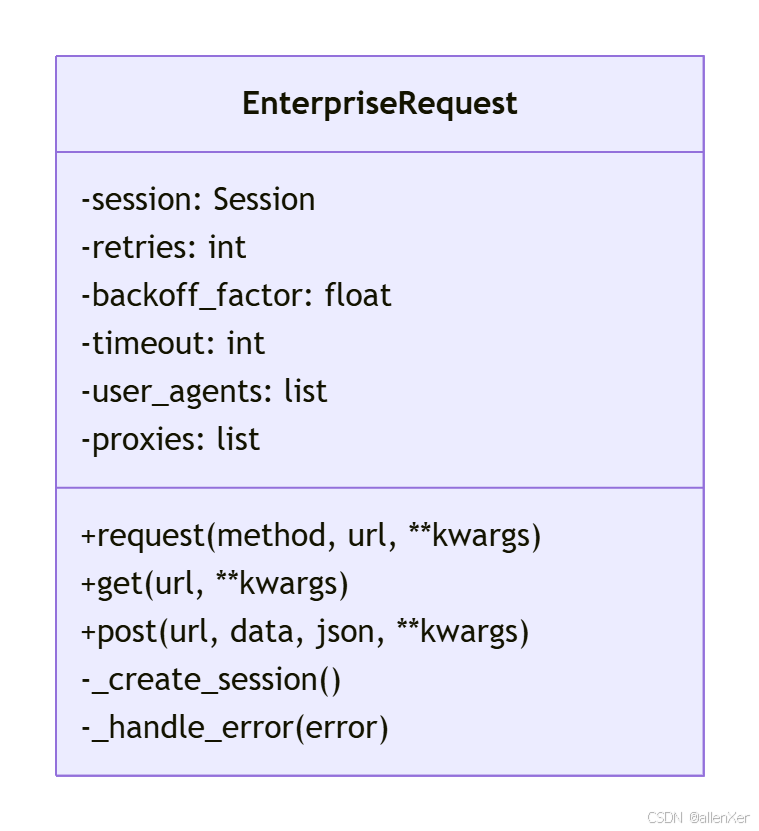

1. 工業級請求類設計

import requests

import time

import random

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retryclass EnterpriseRequest:"""企業級HTTP請求客戶端"""def __init__(self, retries=3, backoff_factor=0.5, timeout=10, user_agents=None, proxies=None):# 配置參數self.retries = retriesself.backoff_factor = backoff_factorself.timeout = timeoutself.user_agents = user_agents or ['Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36','Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/14.1.1 Safari/605.1.15','Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:89.0) Gecko/20100101 Firefox/89.0']self.proxies = proxies# 創建會話self.session = self._create_session()# 合規標識self.session.headers['X-Crawler-Policy'] = 'public'def _create_session(self):"""創建配置好的會話"""session = requests.Session()# 設置重試策略retry_strategy = Retry(total=self.retries,backoff_factor=self.backoff_factor,status_forcelist=[429, 500, 502, 503, 504],allowed_methods=['GET', 'POST'])adapter = HTTPAdapter(max_retries=retry_strategy)session.mount('http://', adapter)session.mount('https://', adapter)# 設置默認頭session.headers.update({'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Accept-Language': 'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3','Connection': 'keep-alive','Upgrade-Insecure-Requests': '1','Pragma': 'no-cache','Cache-Control': 'no-cache'})return sessiondef request(self, method, url, **kwargs):"""執行HTTP請求"""# 隨機User-Agentheaders = kwargs.pop('headers', {})headers['User-Agent'] = random.choice(self.user_agents)# 設置超時kwargs.setdefault('timeout', self.timeout)# 設置代理if self.proxies:kwargs['proxies'] = random.choice(self.proxies)try:response = self.session.request(method, url, headers=headers,**kwargs)response.raise_for_status()return responseexcept requests.exceptions.RequestException as e:self._handle_error(e)return Nonedef _handle_error(self, error):"""錯誤處理"""if isinstance(error, requests.exceptions.HTTPError):status = error.response.status_codeif status == 403:print("錯誤: 訪問被拒絕 (403)")elif status == 404:print("錯誤: 頁面不存在 (404)")elif status == 429:print("錯誤: 請求過多 (429)")time.sleep(60) # 等待1分鐘else:print(f"HTTP錯誤: {status}")elif isinstance(error, requests.exceptions.ConnectionError):print("連接錯誤: 網絡問題或服務器不可達")elif isinstance(error, requests.exceptions.Timeout):print("請求超時")else:print(f"請求錯誤: {str(error)}")def get(self, url, **kwargs):"""GET請求"""return self.request('GET', url, **kwargs)def post(self, url, data=None, json=None, **kwargs):"""POST請求"""return self.request('POST', url, data=data, json=json, **kwargs)# 使用示例

request_client = EnterpriseRequest(retries=5,backoff_factor=0.3,proxies=[{'http': 'http://10.10.1.10:3128', 'https': 'http://10.10.1.10:1080'},{'http': 'http://10.10.1.11:3128', 'https': 'http://10.10.1.11:1080'}]

)response = request_client.get('https://www.example.com')

if response:print(f"成功獲取內容: {len(response.text)}字節")2. 高級功能解析

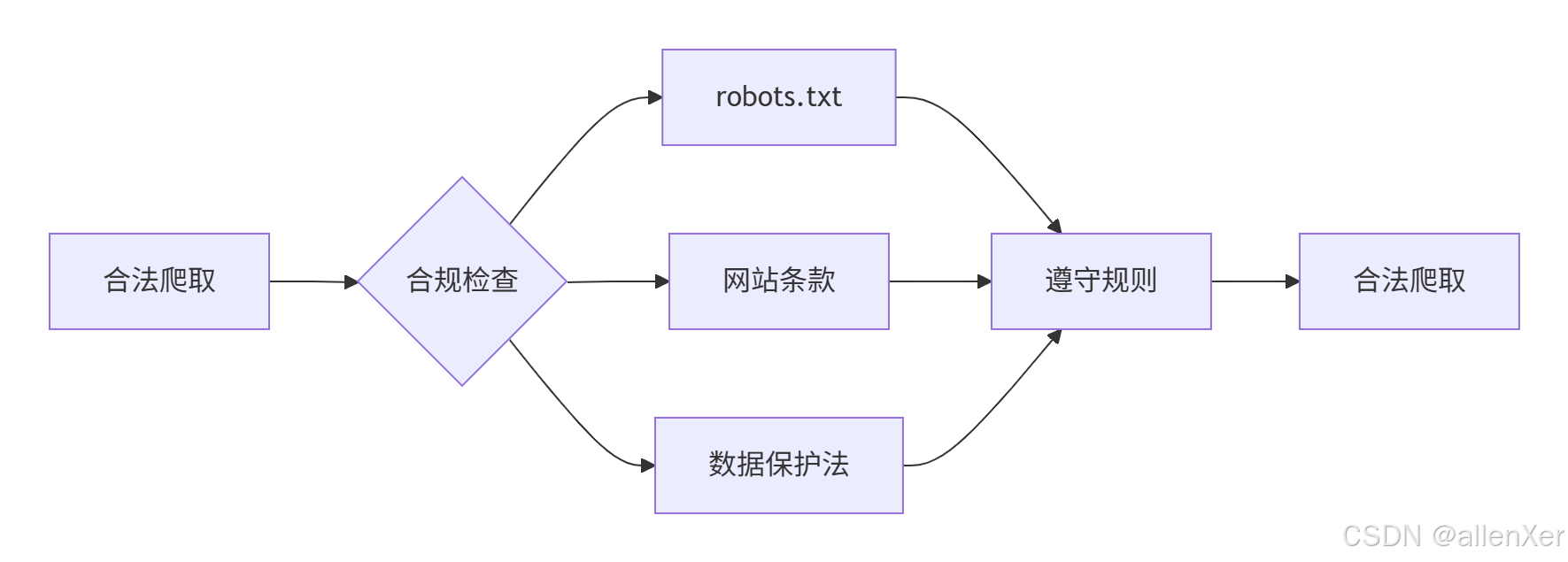

五、法律合規框架設計

1. 爬蟲法律邊界

2. 合規爬蟲實現

class CompliantCrawler(EnterpriseRequest):"""合規爬蟲框架"""def __init__(self, domain, *args, **kwargs):super().__init__(*args, **kwargs)self.domain = domainself.robots_parser = self._parse_robots_txt()def _parse_robots_txt(self):"""解析robots.txt"""from urllib.robotparser import RobotFileParserrp = RobotFileParser()rp.set_url(f'https://{self.domain}/robots.txt')rp.read()return rpdef can_fetch(self, url):"""檢查是否允許爬取"""return self.robots_parser.can_fetch('*', url)def safe_get(self, url):"""安全爬取"""if not self.can_fetch(url):print(f"警告: 根據robots.txt不允許爬取 {url}")return None# 添加合規頭headers = {'From': 'contact@yourcompany.com','X-Crawler-Purpose': 'Academic Research'}return self.get(url, headers=headers)def crawl_sitemap(self):"""爬取網站地圖"""sitemap_url = f'https://{self.domain}/sitemap.xml'if self.can_fetch(sitemap_url):response = self.get(sitemap_url)if response:# 解析sitemapreturn self._parse_sitemap(response.text)return []def _parse_sitemap(self, sitemap_xml):"""解析sitemap.xml"""# 實現解析邏輯return []# 使用示例

crawler = CompliantCrawler('example.com')

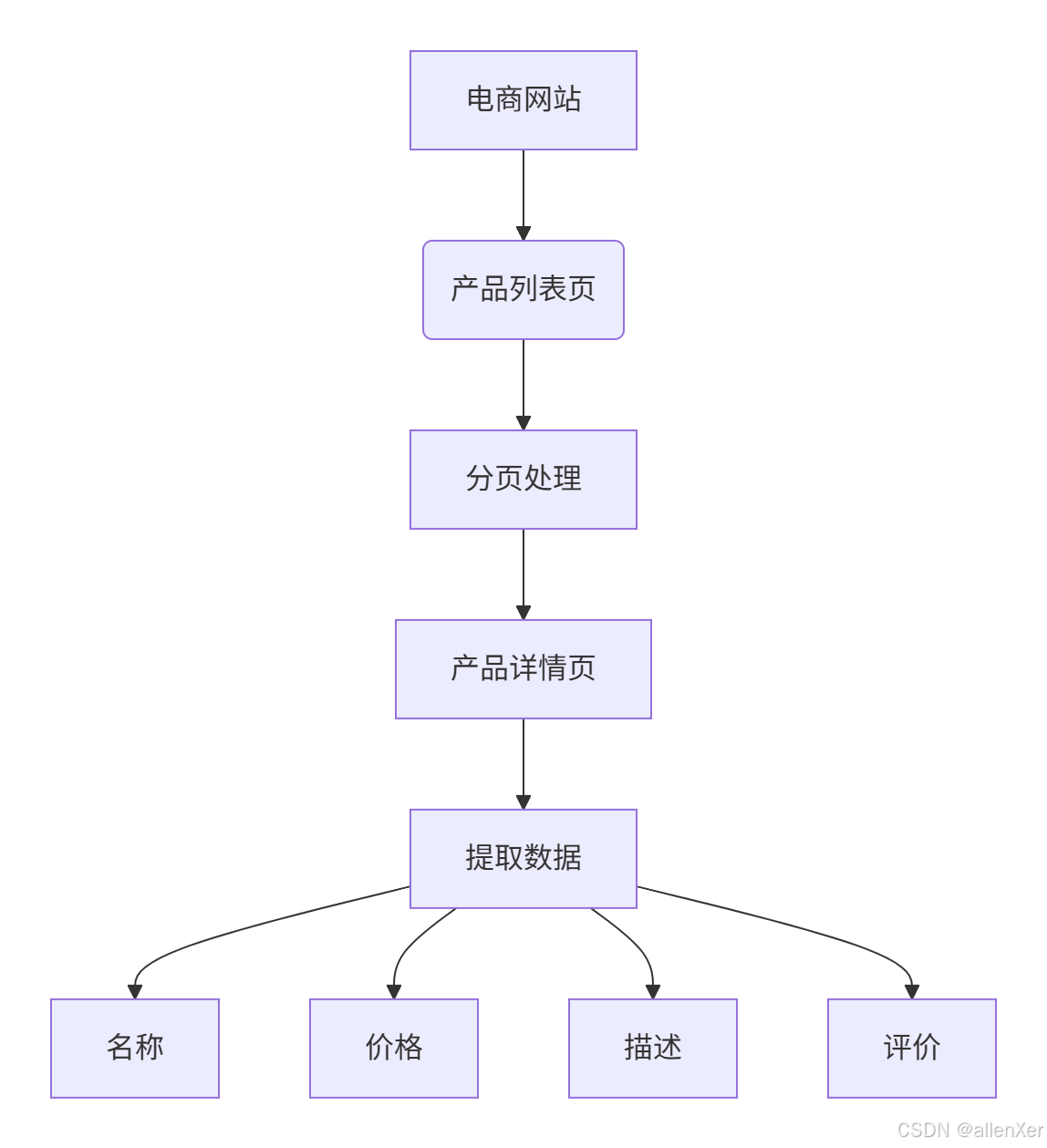

if crawler.can_fetch('/products'):response = crawler.safe_get('https://example.com/products')if response:print("成功獲取產品頁面")六、實戰案例:電商網站爬取

1. 目標分析

2. 完整爬蟲實現

from bs4 import BeautifulSoup

import csv

import osclass EcommerceCrawler(CompliantCrawler):"""電商網站爬蟲"""def __init__(self, domain, output_file='products.csv'):super().__init__(domain)self.output_file = output_fileself._init_csv()def _init_csv(self):"""初始化CSV文件"""if not os.path.exists(self.output_file):with open(self.output_file, 'w', encoding='utf-8', newline='') as f:writer = csv.writer(f)writer.writerow(['名稱', '價格', '評分', '評論數', '鏈接'])def crawl_category(self, category_url):"""爬取分類產品"""page = 1while True:url = f"{category_url}?page={page}"if not self.can_fetch(url):print(f"達到robots.txt限制: {url}")breakresponse = self.safe_get(url)if not response:break# 解析產品列表soup = BeautifulSoup(response.text, 'html.parser')products = soup.select('.product-item')if not products:print(f"第{page}頁無產品,停止爬取")breakprint(f"爬取第{page}頁,產品數: {len(products)}")# 處理每個產品for product in products:self._process_product(product)page += 1time.sleep(random.uniform(1, 3)) # 隨機延遲def _process_product(self, product):"""處理單個產品"""# 提取基本信息name = product.select_one('.product-name').text.strip()price = product.select_one('.price').text.strip()detail_url = product.select_one('a')['href']# 爬取詳情頁detail_response = self.safe_get(detail_url)if not detail_response:returndetail_soup = BeautifulSoup(detail_response.text, 'html.parser')# 提取詳情信息rating = detail_soup.select_one('.rating-value').text.strip()reviews = detail_soup.select_one('.review-count').text.strip()# 保存數據self._save_to_csv([name, price, rating, reviews, detail_url])# 隨機延遲time.sleep(random.uniform(0.5, 1.5))def _save_to_csv(self, row):"""保存數據到CSV"""with open(self.output_file, 'a', encoding='utf-8', newline='') as f:writer = csv.writer(f)writer.writerow(row)# 執行爬取

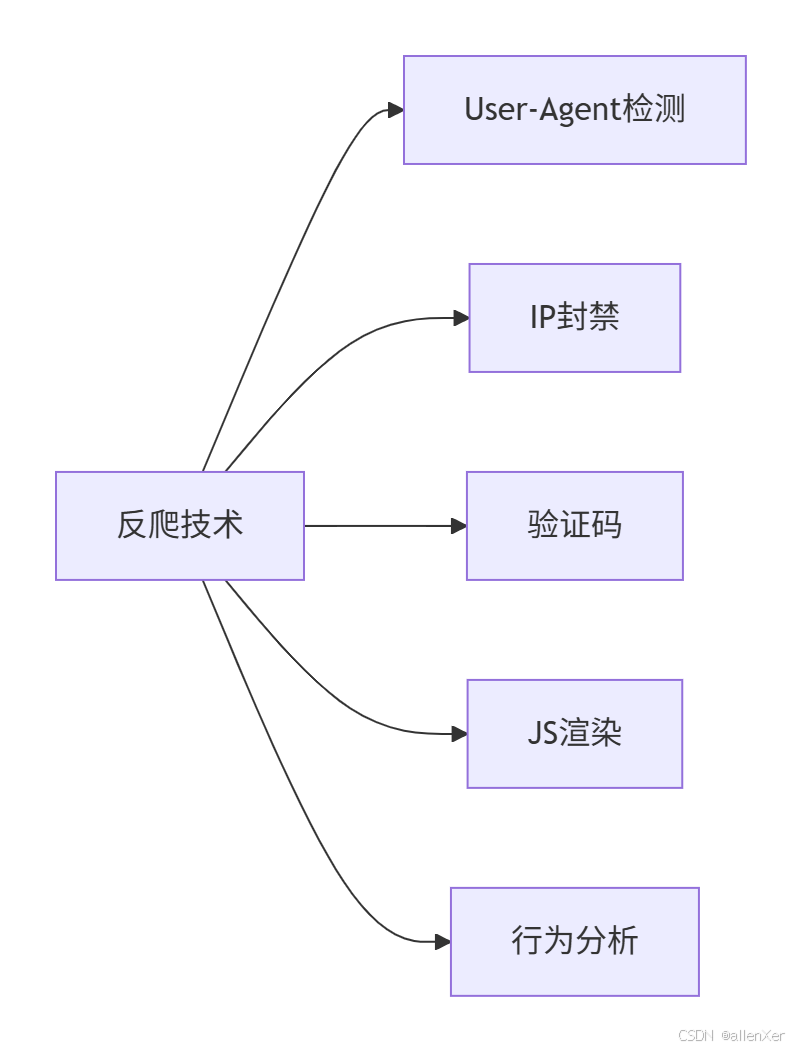

if __name__ == "__main__":crawler = EcommerceCrawler('example.com')crawler.crawl_category('https://example.com/electronics')print("爬取完成!數據已保存到products.csv")七、反爬蟲對抗與破解

1. 常見反爬手段

2. 破解策略

class AntiAntiCrawler(EnterpriseRequest):"""反反爬蟲增強版"""def __init__(self, *args, **kwargs):super().__init__(*args, **kwargs)self.js_engine = self._init_js_engine()def _init_js_engine(self):"""初始化JS引擎"""import execjstry:return execjs.get()except:print("警告: 未找到JS運行時環境")return Nonedef solve_captcha(self, image_data):"""解決驗證碼"""# 實際項目中應使用OCR或第三方服務return input("請輸入驗證碼: ")def execute_js(self, js_code):"""執行JS代碼"""if not self.js_engine:raise RuntimeError("JS引擎未初始化")return self.js_engine.eval(js_code)def get_with_js(self, url, js_script):"""執行JS后獲取頁面"""# 先獲取初始頁面response = self.get(url)if not response:return None# 執行JSresult = self.execute_js(js_script)# 可能需要重新請求return self.get(url + f'?token={result}')def rotate_ip(self):"""輪換IP地址"""if not self.proxies:print("警告: 未配置代理IP")return# 隨機選擇新代理self.session.proxies = random.choice(self.proxies)print(f"已更換代理: {self.session.proxies}")# 使用示例

advanced_crawler = AntiAntiCrawler(proxies=[{'http': 'proxy1:port', 'https': 'proxy1:port'},{'http': 'proxy2:port', 'https': 'proxy2:port'}]

)# 解決驗證碼

captcha_url = 'https://example.com/captcha.jpg'

captcha_image = advanced_crawler.get(captcha_url).content

captcha_text = advanced_crawler.solve_captcha(captcha_image)# 提交表單

login_data = {'username': 'user', 'password': 'pass', 'captcha': captcha_text}

advanced_crawler.post('https://example.com/login', data=login_data)八、思考題與小測驗

1. 思考題

-

??協議升級??:

如何讓爬蟲同時支持HTTP/1.1和HTTP/2協議?

-

??分布式爬蟲??:

如何設計分布式爬蟲的請求調度系統?

-

??法律風險??:

在爬取海外網站時,如何確保符合GDPR等法規?

2. 小測驗

-

??HTTP狀態碼??:

503狀態碼表示什么?

-

A) 頁面未找到

-

B) 服務器錯誤

-

C) 服務不可用

-

D) 禁止訪問

-

-

??請求頭??:

哪個請求頭用于防止CSRF攻擊?

-

A) User-Agent

-

B) Referer

-

C) Cookie

-

D) X-CSRF-Token

-

-

??爬蟲倫理??:

以下哪種行為違反爬蟲倫理?

-

A) 遵守robots.txt

-

B) 限制爬取頻率

-

C) 爬取付費內容

-

D) 注明數據來源

-

3. 訂閱用戶專享解答

??? 一鍵直達文章內容包含??:

-

思考題詳細解答與最佳實踐

-

小測驗完整答案解析

-

HTTP/2協議實現源碼

-

分布式請求調度系統

-

驗證碼智能識別模型

-

動態JS渲染破解方案

-

全球法律合規指南

九、總結:打造工業級爬蟲基礎

通過本篇,您已掌握:

-

🌐 HTTP協議核心原理

-

?? Requests庫高級技巧

-

🏭 企業級請求封裝

-

?? 法律合規框架

-

🛡? 基礎反爬對抗

-

🛒 電商爬蟲實戰

??下一篇預告??:

《HTML解析藝術:XPath與CSS選擇器高級技巧》

-

深度解析HTML結構與XPath語法

-

動態頁面結構自適應解析技術

-

反XPath檢測繞過方案

-

分布式解析任務調度系統

-

億級數據提取實戰

"在數據為王的時代,爬蟲技術是打開信息寶庫的鑰匙。掌握HTTP協議,你就邁出了成為爬蟲專家的第一步。"

?

降維)

)

)