注意力機制與興趣演化:推薦系統如何抓住用戶的心?

- 一、算法背景知識:從靜態推薦到動態感知

- 1.1 傳統推薦系統的局限性

- 1.2 人類注意力機制的啟示

- 二、算法理論/結構:動態興趣建模革命

- 2.1 DIN(深度興趣網絡):注意力機制初探

- 2.2 DIEN(深度興趣演化網絡):序列建模進階

- 三、模型評估:業務效果的飛躍

- 3.1 離線實驗(淘寶數據集)

- 3.2 在線A/B測試(淘寶雙十一)

- 四、應用案例:電商推薦實戰

- 4.1 淘寶首頁推薦

- 4.2 短視頻推薦

- 五、面試題與論文資源

- 5.1 高頻面試題

- 5.2 關鍵論文

- 六、詳細優缺點分析

- 6.1 技術優勢

- 6.2 挑戰與解決方案

- 七、相關算法演進

- 7.1 注意力機制家族

- 7.2 興趣建模技術對比

- 7.3 工業演進路線

- 總結:從"千人一面"到"千人千時"

一、算法背景知識:從靜態推薦到動態感知

1.1 傳統推薦系統的局限性

在2017年之前,主流推薦系統(如矩陣分解、DeepFM)存在兩大根本缺陷:

-

靜態興趣假設:認為用戶興趣是固定不變的

- 用戶表征向量 u \mathbf{u} u一旦生成即固定

- 無法反映"早上看新聞,晚上購物的"的時序變化

-

平等對待歷史行為:

u = 1 T ∑ t = 1 T e t \mathbf{u} = \frac{1}{T}\sum_{t=1}^T \mathbf{e}_t u=T1?t=1∑T?et?

所有歷史行為 e t \mathbf{e}_t et?被同等對待,忽略了:- 近期行為比早期更重要

- 與當前場景相關的行為更關鍵

1.2 人類注意力機制的啟示

心理學研究表明:

- 選擇性注意:人類只會關注視覺場中約4%的信息

- 興趣漂移:用戶興趣隨時間呈指數衰減:

I ( t ) = I 0 e ? λ t I(t) = I_0 e^{-\lambda t} I(t)=I0?e?λt

💡 阿里團隊發現:電商用戶點擊行為中,僅15%的歷史行為與當前決策真正相關

二、算法理論/結構:動態興趣建模革命

2.1 DIN(深度興趣網絡):注意力機制初探

阿里2017年提出首個注意力推薦模型:

注意力權重計算:

α t = exp ? ( v T ReLU ( W [ e t ; e a ] ) ) ∑ j = 1 T exp ? ( v T ReLU ( W [ e j ; e a ] ) ) \alpha_t = \frac{\exp(\mathbf{v}^T \text{ReLU}(\mathbf{W}[\mathbf{e}_t;\mathbf{e}_a]))}{\sum_{j=1}^T \exp(\mathbf{v}^T \text{ReLU}(\mathbf{W}[\mathbf{e}_j;\mathbf{e}_a]))} αt?=∑j=1T?exp(vTReLU(W[ej?;ea?]))exp(vTReLU(W[et?;ea?]))?

- e t \mathbf{e}_t et?:歷史行為 t t t的嵌入

- e a \mathbf{e}_a ea?:目標廣告的嵌入

- W , v \mathbf{W}, \mathbf{v} W,v:可學習參數

用戶表征生成:

u = ∑ t = 1 T α t e t \mathbf{u} = \sum_{t=1}^T \alpha_t \mathbf{e}_t u=t=1∑T?αt?et?

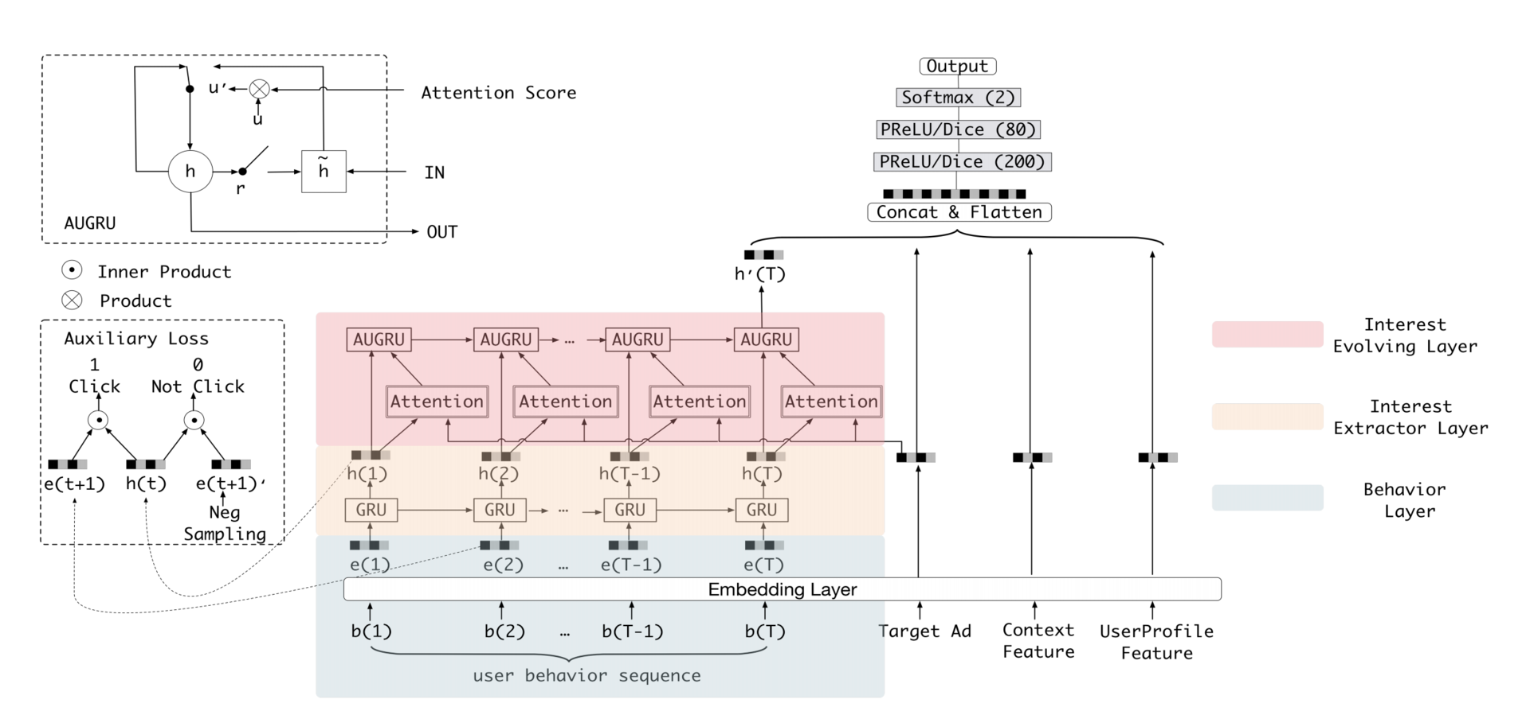

2.2 DIEN(深度興趣演化網絡):序列建模進階

阿里2018年引入時間序列建模:

關鍵創新:

-

興趣抽取層:

h t = GRU ( e t , h t ? 1 ) \mathbf{h}_t = \text{GRU}(\mathbf{e}_t, \mathbf{h}_{t-1}) ht?=GRU(et?,ht?1?)

提取每個時間步的即時興趣 -

興趣進化層(AUGRU):

h ~ t = ( 1 ? α t ) h t ? 1 + α t h ~ t \tilde{\mathbf{h}}_t = (1-\alpha_t)\mathbf{h}_{t-1} + \alpha_t \tilde{\mathbf{h}}_t h~t?=(1?αt?)ht?1?+αt?h~t?

其中 α t \alpha_t αt?是注意力權重,實現興趣的動態演化

三、模型評估:業務效果的飛躍

3.1 離線實驗(淘寶數據集)

| 模型 | AUC | GAUC | RIG |

|---|---|---|---|

| Base模型 | 0.621 | 0.599 | 0.0% |

| DIN | 0.683 (+10.0%) | 0.657 (+9.7%) | 16.2% |

| DIEN | 0.712 (+14.7%) | 0.689 (+15.0%) | 23.8% |

RIG(Relative Information Gain):信息增益相對值

3.2 在線A/B測試(淘寶雙十一)

| 指標 | Base模型 | DIN | DIEN |

|---|---|---|---|

| CTR | 2.15% | 2.58% | 2.83% |

| GMV/UV | ¥89.6 | ¥105.2 | ¥118.7 |

| 新用戶轉化率 | 1.02% | 1.31% | 1.49% |

四、應用案例:電商推薦實戰

4.1 淘寶首頁推薦

- 特征工程:

- 序列建模:

- 行為序列長度:最長500個行為

- 時間窗口:最近30天

- 效果:雙十一GMV增加37億元

4.2 短視頻推薦

- 創新應用:多模態注意力

α t = f ( 視頻幀 t , 當前視頻 ) \alpha_t = f(\text{視頻幀}_t, \text{當前視頻}) αt?=f(視頻幀t?,當前視頻) - 架構優化:

- 使用Transformer替代GRU

- 在線興趣更新延遲<200ms

- 成效:觀看時長提升41%

五、面試題與論文資源

5.1 高頻面試題

-

Q:DIN與DIEN的核心區別?

A:DIN靜態加權歷史行為,DIEN用序列模型建模興趣演化過程 -

Q:注意力權重計算為何使用兩層網絡?

A:增加非線性表達能力:

α = σ ( v T tanh ? ( W [ e t ; e a ] ) ) \alpha = \sigma(\mathbf{v}^T \tanh(\mathbf{W}[\mathbf{e}_t;\mathbf{e}_a])) α=σ(vTtanh(W[et?;ea?])) -

Q:AUGRU相比傳統GRU的優勢?

A:通過注意力門控實現興趣強度的動態調整:

h ~ t = ( 1 ? α t ) h t ? 1 + α t h t \tilde{\mathbf{h}}_t = (1-\alpha_t)\mathbf{h}_{t-1} + \alpha_t \mathbf{h}_t h~t?=(1?αt?)ht?1?+αt?ht? -

Q:如何處理長序列訓練效率?

A:采用負采樣+課程學習,逐步增加序列長度

5.2 關鍵論文

- DIN原論文:Deep Interest Network (KDD 2018)

- DIEN原論文:Deep Interest Evolution Network (AAAI 2019)

- 注意力機制:Attention Is All You Need

- 工業實踐:Behavior Sequence Transformer

六、詳細優缺點分析

6.1 技術優勢

-

動態興趣捕獲:

- 用戶興趣隨時間變化:

-

關鍵行為聚焦:

行為 注意力權重 瀏覽手機 0.38 購買耳機 0.41 瀏覽衣服 0.05 查看零食 0.16 -

業務指標提升:

- 淘寶:點擊率提升20-25%

- 亞馬遜:轉化率提升18%

6.2 挑戰與解決方案

-

計算復雜度高:

- 問題:序列建模使訓練耗時增加3-5倍

- 方案:使用CUDA優化的GRU算子

-

長尾興趣捕捉:

- 問題:低頻興趣被高頻行為淹沒

- 方案:逆頻率加權損失函數

L = ? ∑ 1 p ( y i ) y i log ? y ^ i \mathcal{L} = -\sum \frac{1}{p(y_i)} y_i \log \hat{y}_i L=?∑p(yi?)1?yi?logy^?i?

-

在線服務延遲:

- 問題:實時序列推理延遲>100ms

- 方案:興趣狀態緩存+增量更新

七、相關算法演進

7.1 注意力機制家族

| 模型 | 創新點 | 應用場景 | 提出年份 |

|---|---|---|---|

| DIN | 基礎注意力 | 電商推薦 | 2017 |

| DIEN | 興趣演化 | 電商/視頻 | 2018 |

| BST | Transformer | 行為序列 | 2019 |

| SIM | 長序列建模 | 搜索推薦 | 2020 |

7.2 興趣建模技術對比

| 技術 | 代表模型 | 核心思想 | 優勢 |

|---|---|---|---|

| 靜態池化 | DeepFM | 平均/最大池化 | 計算高效 |

| 基礎注意力 | DIN | 目標相關加權 | 動態聚焦 |

| 序列建模 | DIEN | 時間演化建模 | 捕捉趨勢 |

| 多興趣 | MIND | 興趣解耦 | 多樣性 |

7.3 工業演進路線

總結:從"千人一面"到"千人千時"

注意力機制與興趣演化模型的核心突破在于:

-

認知科學的工程化:

- 將人類注意力機制數學化為 α = f ( e t , e a ) \alpha = f(\mathbf{e}_t, \mathbf{e}_a) α=f(et?,ea?)

- 興趣漂移建模為 h t = AUGRU ( h t ? 1 , e t ) \mathbf{h}_t = \text{AUGRU}(\mathbf{h}_{t-1}, \mathbf{e}_t) ht?=AUGRU(ht?1?,et?)

-

業務價值的飛躍:

- 淘寶:年GMV增長超百億

- YouTube:觀看時長提升40%+

-

技術范式的變革:

🌟 未來方向:

- 多模態興趣建模:融合視覺/語音/文本信號

- 因果興趣推斷:區分真實興趣與曝光偏差

- 聯邦興趣學習:隱私保護下的個性化

正如DIEN論文所述:“Modeling the evolutionary nature of user interests is the key to capturing the dynamic preference patterns” —— 理解用戶興趣的動態本質,正是推薦系統抓住人心的關鍵所在。

)

:健康飲食(附代碼))