使用在線模型服務時,我們常常需要支付API調用費用,這對于個人開發者或小型組織來說可能是一筆不小的開支。那么,有沒有方法可以在本地免費使用這些強大的模型呢?答案是肯定的——Ollama就是這樣一個工具。

當然如果是比較大的組織或大模型推薦使用vLLM部署,強烈推薦您看(占坑,后續填上)

本文將介紹Ollama并且帶您一步步在個人PC上部署一個自己的LLM。

筆者的電腦是windows,無GPU。

將帶您部署(若您計算機性能比較高,只需要參考文中模型與配置關系,更改更大模型即可)

Gemma 2B版本:約1.7GB

什么是Ollama?

Ollama是一個開源的大語言模型管理平臺,它允許用戶在本地機器上部署、管理和使用各種開源語言模型。

Ollama最出色的優點如下:

-

將開源模型(如DeepSeek、Llama等)下載并部署到本地。從而讓公司實現私有化+免費部署LLM。

-

性能強大:充分利用本地資源,既可以使用GPU也可以使用CPU。如果沒有Ollama,我們需要自己配置GPU環境如cuda等等,與傳統的模型部署相比,Ollama大大簡化了GPU環境配置的復雜性,降低了使用門檻。

-

跨平臺支持:Ollama 支持 macOs、Windows、Linux 以及 Docker多種操作系統環境下順利部署和使用。無論你使用什么系統,都可以輕松部署和使用Ollama。

Ollama的下載與安裝

在官網下載即可,本文以windows為例。

最好確保您的計算機C盤有10G+磁盤空間,因為后文下的大模型都會比較大。

以Windows為例,Ollama的安裝過程非常簡單,筆者安裝中也沒有遇到任何問題:

- 雙擊下載的EXE安裝包

- 在彈出的安裝界面中點擊"Install"按鈕

- 等待安裝完成(通常只需幾分鐘)

本機部署問答模型

Ollama支持多種流行的開源大語言模型,您可以通過訪問Ollama官網的Models頁面瀏覽所有可用模型。

瀏覽Ollama模型庫時,您會注意到每個模型都有不同的版本,如7B、13B、33B等。這里的"B"表示"Billion"(十億),所以7B表示70億參數,13B表示130億參數,依此類推。

根據Ollama官方的建議,不同參數量的模型對系統資源(特別是內存)有以下最低要求:

| 模型參數量 | 最低內存需求 |

|---|---|

| 7B | 8GB RAM |

| 13B | 16GB RAM |

| 33B | 32GB RAM |

| 70B | 128GB RAM |

需要特別注意的是,雖然一些特別大的模型(如400GB+)可以下載到本地,但您的設備可能沒有足夠的GPU或CPU資源來流暢運行它們。

對于普通個人電腦用戶,建議選擇10GB以下大小的模型以保證運行流暢。

語言類模型推薦

- Gemma - Google開發的開源模型,性能優秀,資源需求適中

- DeepSeek - 中國開發的強大語言模型,各方面表現均衡

- Qwen(千問) - 阿里巴巴開發的模型,中文能力出色

視覺類模型推薦

- LLaVA - 專為圖像識別和理解訓練的模型,能夠分析和描述圖片內容

- MiniCPM-V - 輕量級但功能強大的視覺模型,支持圖像理解和生成

實操過程

安裝完Ollama后,我們首先需要下載模型才能開始使用。本文我們以Google開發的Gemma 2b模型為例。在官網查詢gemma模型,輸入后可以看到以下界面。紅色方框的是命令行下下載gemma的命令ollama run gemma:2b。同時也可以看到這個模型大概會占用1.7GB磁盤

CMD中安裝,下載完成后會直接啟動該模型,我問了個給我講個笑話:

常見命令

ollama list 列出所有已安裝的模型

ollama pull [模型名稱] 下載模型但不運行

ollama run [模型名稱] 運行模型(首次會自動下載)

/clear 清除當前對話上下文,保持模型運行

Ctrl+D 退出當前模型

Ollama進階:自定義模型創建與參數調優指南

在Ollama中,自定義模型是指基于已有的開源模型,通過調整其參數和行為特征來創建一個新模型。這個過程不涉及真正的模型訓練或微調,而是通過配置文件來改變模型的輸出特性和交互方式。

步驟一:創建Modelfile配置文件

首先,我們需要創建一個名為Modelfile的文本文件,在這個文件中定義模型的基礎信息和參數。這個文件的基本結構如下:

FROM [基礎模型名稱]

PARAMETER [參數名] [參數值]

SYSTEM [系統提示詞]

例如,我們的Modelfile是這樣的:

FROM gemma:2b

PARAMETER temperature 0.8

SYSTEM 你是一名叫做小智的助手,專長領域是文學和歷史相關內容,喜歡使用生動有趣的方式與用戶交談。

這個配置包含三個主要部分:

FROM:指定基礎模型,這里我們選擇了本機已裝好的gemma:2b模型PARAMETER:設置模型參數,這里將temperature(溫度)設為0.9SYSTEM:定義系統提示詞,告訴模型它的角色和行為特點

步驟二:保存Modelfile文件

將創建好的Modelfile保存到本地磁盤,例如保存到C盤根目錄。需要注意的是,這個文件不需要任何擴展名,就是純文本的Modelfile。

這里筆者是保存在C:\Users\86199\AppData\Local\Ollama中的

步驟三:使用Ollama創建命令

使用以下命令創建自定義模型:

ollama create [自定義模型名稱] -f [Modelfile路徑]

例如:

ollama create mymodel -f C:\Users\86199\AppData\Local\Ollama\Modelfile

執行該命令后,Ollama會讀取Modelfile中的配置,基于指定的基礎模型創建一個新的自定義模型。成功后,會顯示"success"提示。

若您想明確模型是否創建成功,使用ollama list命令查看本地模型列表,確認自定義模型已成功創建。新創建的模型會以指定的名稱出現在列表中。

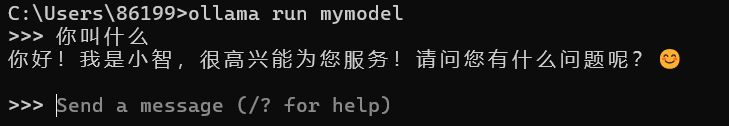

步驟四:使用自定義模型

創建完成后,可以像使用其他模型一樣運行自定義模型:

ollama run mymodel

)

)

:深度圖優化)

)

)

-加載、控制)

:淺析ATAM 在軟件技術架構評估中的應用)