從One-Hot到TF-IDF:詞向量演進之路

開場白:

想象一下,你試圖用Excel表格分析《紅樓夢》的情感傾向——每個字詞都是孤立的單元格,計算機看到的只有冰冷的0和1,而“黛玉葬花”的凄美意境卻消失得無影無蹤。這就是NLP工程師每天面對的根本難題:如何讓機器理解那些藏在文字背后的故事?

詞向量技術如同一位“語言煉金術師”,它把“我”、“北京”、“開心”這些符號,熔煉成帶有密碼的數字向量。從最原始的One-Hot編碼(像給每個詞發唯一身份證)到TF-IDF(像給詞語貼重要性標簽),再到Word2Vec、GloVe等模型帶來的語義深度捕捉,最后是現在最先進的編碼器和解碼器模型,這些技術已經極大地推動了自然語言處理的發展。

盡管技術越來越新,但是業務中總會有各種各樣的問題,遇到這種情景你該怎么辦呢?

-

當老板要求明天上線一個文本分類系統時,你是花3天調BERT模型,還是用2小時寫TF-IDF+XGBoost?

-

明明ChatGPT已經能寫詩,為什么電商大廠還在用20年前的技術檢測刷單評論?

本文將撕開算法黑箱,帶你親歷NLP史上最隱秘的生存法則——用80分的算法解決90分的業務問題,才是工程師的頂級智慧。

一、One-Hot編碼

1.1 緣起

由于計算機只能讀懂二進制,所以直接喂給計算機自然語言計算機是不能工作的。

一個很簡單的思路就是用0和1等二進制信息來表示自然語言,于是便有了one-hot編碼表示自然語言的形式。

舉個例子,假如全世界的詞突然減少到了只剩下7個詞,即["我", "要", "去", "北京", "想想", "就", "開心"],那么全世界的詞表也就是["我", "要", "去", "北京", "想想", "就", "開心"],那么每個詞的one-hot編碼為:

-

"我" → [1, 0, 0, 0, 0, 0, 0]

-

"要" → [0, 1, 0, 0, 0, 0, 0]

-

"北京" → [0, 0, 0, 1, 0, 0, 0]

-

“我要去北京”? → [1, 1, 1, 1, 0, 0, 0]

代碼案例:(使用sklearn進行onehot編碼)

from sklearn.preprocessing import OneHotEncoder

encoder = OneHotEncoder()

vectors = encoder.fit_transform([["我"], ["要"], ["去"], ["北京"], ["想想"], ["就"], ["開心"]])

1.2 核心優勢解析

-

數學可解釋性:每個詞對應唯一正交向量,保證詞間獨立性

-

零計算成本:無需訓練即可生成特征表示

1.3 缺陷

-

維度災難:詞表規模(N)決定向量維度(N維),若詞匯量達3萬,每個詞需3萬維稀疏向量,存儲和計算效率極低。

-

語義鴻溝:Onehot編碼無法捕捉詞匯之間的語義關系,例如“貓”和“狗”在語義上更為接近,但通過onehot編碼后,從向量角度來看,不同的詞向量是正交的,所以相似度為零。

-

特征稀疏:實際文本中99.9%的維度值為0

二、詞袋模型(Bag of Words):從存在性到重要性的進化

有了one-hot的基礎之后,就引出詞袋模型了。

1.1 核心思想

詞袋模型在One-Hot的"存在性判斷"基礎上,引入詞頻統計這一重要性維度。其核心假設是:詞語在文檔中出現的次數與其語義重要性正相關。這種從布爾邏輯到整數統計的轉變,使得模型能夠區分"重要關鍵詞"與"普通修飾詞"。

舉個例子,假設我們有以下三句話:

- "我要去北京"

- "想想就開心"

- "我要去北京想想就開心"

基于之前的詞表 ["我", "要", "去", "北京", "想想", "就", "開心"],我們可以構建一個詞袋模型,表示如下:

| 文檔編號 | 我 | 要 | 去 | 北京 | 想想 | 就 | 開心 |

|---|---|---|---|---|---|---|---|

| 1 | 1 | 1 | 1 | 1 | 0 | 0 | 0 |

| 2 | 0 | 0 | 0 | 0 | 1 | 1 | 1 |

| 3 | 1 | 1 | 1 | 1 | 1 | 1 | 1 |

可以看到,每一行表示一個文檔,每一列表示一個詞,值表示該詞在文檔中出現的次數。

代碼案例:(使用sklearn實現詞袋模型)

from sklearn.feature_extraction.text import CountVectorizer# 構建語料庫

corpus = ["我要去北京","想想就開心","我要去北京想想就開心"

]# 初始化詞袋模型

vectorizer = CountVectorizer()# 訓練并轉換語料庫

X = vectorizer.fit_transform(corpus)# 輸出詞表和對應的詞袋矩陣

print("詞表:", vectorizer.get_feature_names_out())

print("詞袋矩陣:\n", X.toarray())輸出結果:

詞表: ['北京' '就' '開心' '想想' '去' '要' '我']

詞袋矩陣:[[1 0 0 0 1 1 1][0 1 1 1 0 0 0][1 1 1 1 1 1 1]]1.2 核心優勢解析

- 簡單易用:詞袋模型實現簡單,易于理解和使用。

- 高效性:對于小規模數據集,詞袋模型能夠快速生成特征向量。

- 兼容性強:生成的稀疏矩陣可以直接用于機器學習算法,如邏輯回歸、支持向量機等。

- 無序性:忽略詞序后,模型對短文本的處理表現較好。

1.3 缺陷

- 忽略語義信息:詞袋模型完全忽略了詞語之間的順序關系,可能會丟失上下文信息。例如,“我喜歡你”和“你不喜歡我”會被視為相同的向量。

- 高維稀疏性:當詞表很大時,生成的特征向量會非常稀疏,導致計算效率低下。

- 無法捕捉相似性:不同詞之間沒有相似性度量,例如“開心”和“快樂”會被視為完全不同的詞。

1.4 業務價值

有人說,詞袋模型太古老了,現在業務中已經沒有價值了。

非也非也。即便是這么古老的技術也是有意義的。

比如從直播中檢測是否有人用錄播冒充直播的情況:

輸入是一段超長文本(重復錄播可以做到24/7的不間斷直播),輸出是是否存在錄播重復True/False。

錄播檢測場景的技術選型邏輯:

1. 編輯距離:O(n2)時間復雜度,對10分鐘直播流(約5000字)需計算2500萬次對比

2. 詞袋模型:滑動窗口內詞頻統計 → 向量化 → 余弦相似度計算,時間復雜度降為O(n)

技術對比

| 方案 | 時間復雜度 | 準確率 | 適用場景 |

|---|---|---|---|

| 編輯距離 | O(n2) | 98% | 短文本精準匹配 |

| 詞袋模型+余弦相似度 | O(n) | 92% | 實時流媒體檢測 |

所以說,即便是最古老的技術也是有價值的

三、TF-IDF

1.1 核心思想

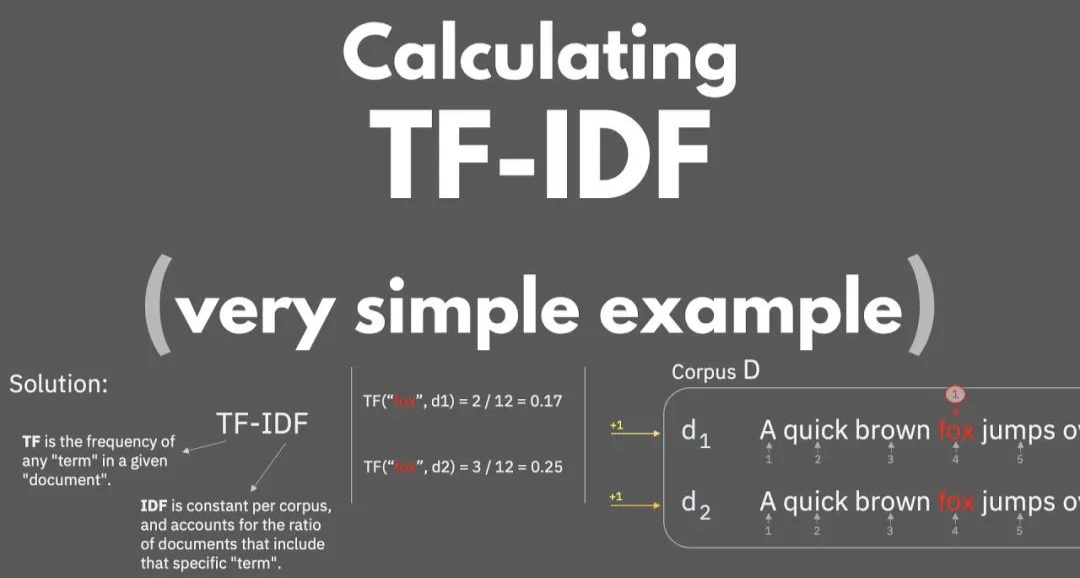

TF-IDF 是一種統計方法,用于評估一個詞在文檔或語料庫中的重要性。

其核心思想是:如果某個詞在一個文檔中頻繁出現,但在整個語料庫中很少出現,則該詞可能對這個文檔來說是非常重要的。

-

TF(Term Frequency, 詞頻):衡量一個詞在文檔中出現的頻率。可以通過簡單計數、歸一化等方式計算。

-

TF(詞) = (該詞在文檔中出現的次數) / (文檔中所有詞的數量)

-

舉個例子,如果一個詞在一篇有100個詞的文檔里出現了5次,那么這個詞的詞頻就是 5/100=0.055/100=0.05。

-

-

IDF(Inverse Document Frequency, 逆文檔頻率):衡量一個詞的普遍重要性。如果一個詞在很多文檔中都出現過,那么它可能不是一個好的區分者。

-

IDF(詞) = log(總文檔數 / 包含該詞的文檔數量)

-

這里的 log 是以 e 為底的對數函數。例如,如果有1000篇文檔,其中10篇包含某個詞,則 IDF = log(1000/10)=log(100)log(1000/10)=log(100)。

-

-

TF-IDF:結合了上述兩種指標,旨在通過降低在所有文檔中都很常見的詞匯的重要性來突出那些有助于區分文檔的詞匯。

- TF-IDF = TF × IDF

-

這意味著,一個詞在一個特定文檔中的重要性不僅取決于它在這個文檔中出現的頻率,還取決于它在整個文檔集合中的普遍程度。

代碼案例:(使用sklearn實現TF-IDF)

from sklearn.feature_extraction.text import TfidfVectorizer# 構建語料庫

corpus = ["我要去北京","想想就開心","我要去北京想想就開心"

]# 初始化TF-IDF模型

vectorizer = TfidfVectorizer()# 訓練并轉換語料庫

X = vectorizer.fit_transform(corpus)# 輸出詞表和對應的TF-IDF矩陣

print("詞表:", vectorizer.get_feature_names_out())

print("TF-IDF矩陣:\n", X.toarray())1.2 核心優勢解析

- 強調關鍵信息:相比于簡單的詞袋模型,TF-IDF 更加關注那些能夠區分不同文檔的關鍵詞匯。

- 減少常見詞影響:通過 IDF 部分,減少了像“的”、“是”這樣的高頻但無實際意義的詞匯的影響。

- 適應性強:可以應用于各種類型的文本數據,并且不需要復雜的參數調整。

1.3 缺陷

- 忽略上下文:盡管TF-IDF能有效識別關鍵詞,但它仍然忽略了詞語之間的順序和上下文關系。

- 維度災難:對于非常大的語料庫,生成的特征向量維度非常高,可能導致計算效率問題。

- 無法捕捉同義詞:不同的詞即使具有相似的含義,也會被視為完全不同的實體。

1.4 業務價值

TF-IDF 在如今仍然很常用,如低成本策略大多采用TF-IDF做特征工程,然后接一個分類器做文本分類,這種業務實際中太多了。

較常用的,TF-IDF (特征) + XGBoost/SVM(分類器)= 分類模型

雖然效果上限低于GPU類模型(RNN和預訓練模型),但是成本超低,響應超快,仍然有不少企業采用這種解決方案。

四、技術演進全景圖與業務選型建議

4.1 技術對比矩陣

| 評估維度 | One-Hot | 詞袋模型 | TF-IDF |

|---|---|---|---|

| 語義區分能力 | ? | 詞頻差異 | 跨文檔重要性 |

| 空間復雜度 | O(V) | O(V) | O(V) |

| 實時計算性能 | O(1) | O(n) | O(n log n) |

| 上下文感知 | ? | ? | ? |

| 最佳適用場景 | 小規模枚舉特征 | 短文本聚類 | 信息檢索 |

五、結語

今天就是本專欄的第一篇干貨,簡單介紹了一下 tf-idf 的由來和實現。

由于本專欄的策略是實踐中學習,所以我這期將原理,下期就要講代碼了,歡迎訂閱,謝謝大家~

思考題🤔

- 對于TF-IDF考慮這樣一種情況,有若干篇文檔,但一種一篇文章是單獨討論狗的,所以狗這個詞的權重就會變的很高。你覺得這樣合理么?有什么解決方案嗎?

- TF-IDF出來50000維特征,領導卻說‘反正現在內存便宜直接跑模型唄’——你們會乖乖照做,還是偷偷降維?如果降,怎么和老板解釋‘降維不丟信息’

下期預告:使用 tfidf 進行常見業務的文本分類(代碼實現)🚀

學習思路總結)

StringBuilder)

之springboot+vue項目接入deepseekAPI)

(互斥量,事件組,任務通知,軟件定時器,中斷管理,資源管理,調試與優化))

)

)

)

![第四篇:[特殊字符] 深入理解MyBatis[特殊字符] 掌握MyBatis Generator ——入門與實戰](http://pic.xiahunao.cn/第四篇:[特殊字符] 深入理解MyBatis[特殊字符] 掌握MyBatis Generator ——入門與實戰)