前言

自從前段時間偶然間被當下AI繪畫的水平震住之后(超越一切的AI作畫神器,和它創作的234個盔甲美女未來戰士) ,作者深感當今AI繪畫的飛速進展或許已遠超所有人的預期。 而這里的前因后果,包括AI繪畫的歷史,以及最近的突破性進展,值得好好和大伙兒梳理和分享一下。 因此有了本文。

本文分為如下幾小節:

- 2022,進擊的AI繪畫

- AI繪畫的歷史

- AI繪畫何以突飛猛進

- 頂級AI繪畫模型的PK

- AI繪畫的突破對人類意味著什么

一、2022,進擊的AI繪畫

今年以來,輸入文本描述自動生成圖片的AI繪畫神器突然雨后春筍的冒了出來。

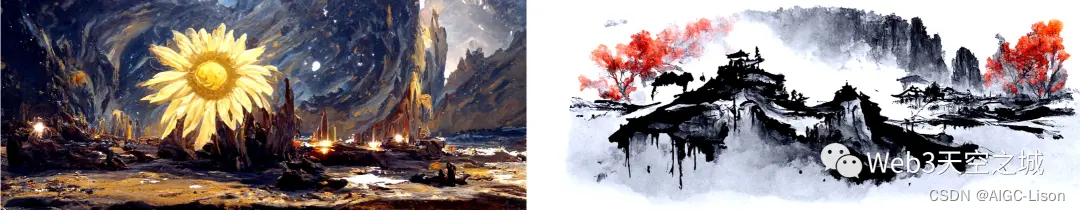

首先是Disco Diffusion。

Disco Diffusion 是在今年 2 月初開始爆紅的一個 AI 圖像生成程序,它可以根據描述場景的關鍵詞渲染出對應的圖像:

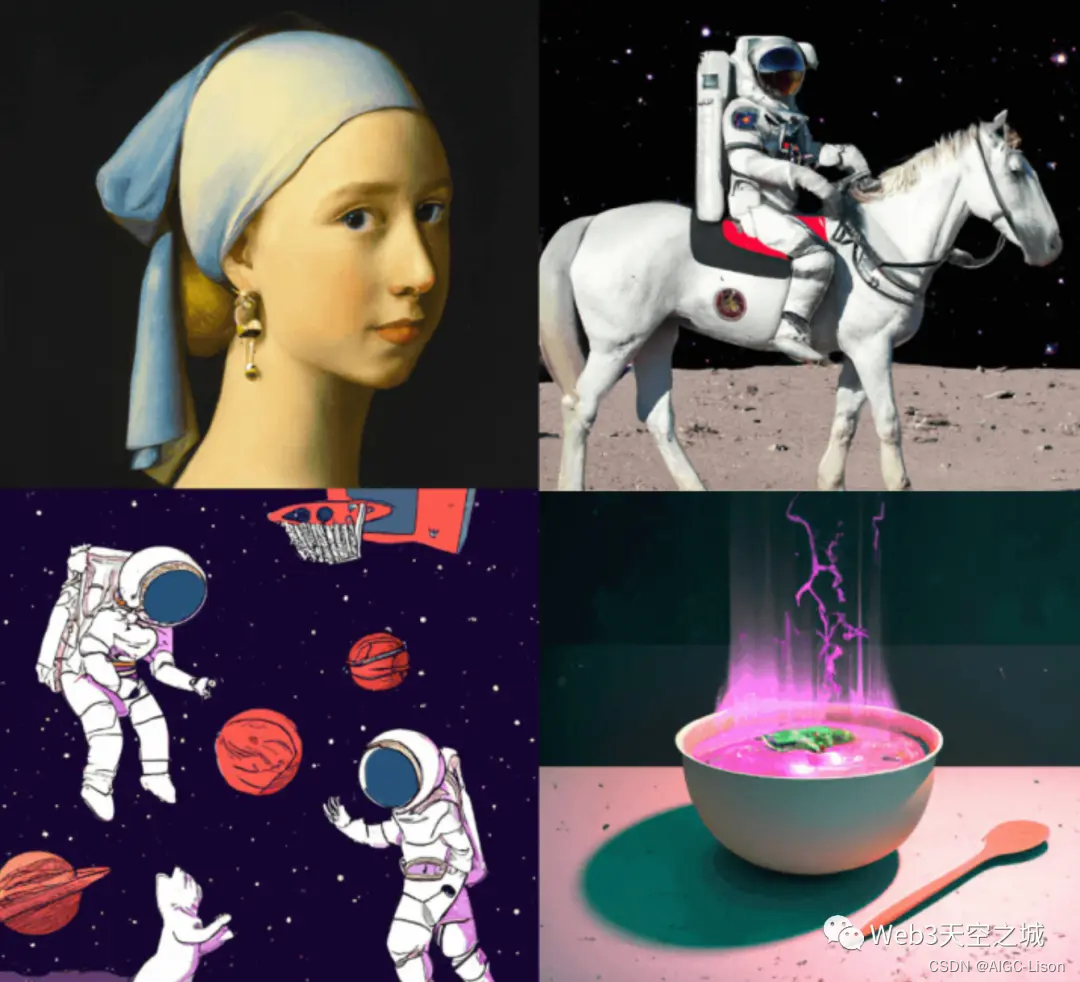

到了今年4月,著名人工智能團隊OpenAI 也發布了新模型 DALL·E 2代,該名稱來源于著名畫家達利(Dalí)和機器人總動員(Wall-E),同樣支持從文本描述生成效果良好的圖像。

而很多讀者對AI繪畫開始產生特別的關注,或許是從以下這幅AI作品鬧出的新聞開始的:

這是一幅使用AI繪畫服務 MidJourney 生成的數字油畫,生成它的用戶以這幅畫參加美國科羅拉多州博覽會的藝術比賽,奪得了第一名。 這件事被曝光之后引發了網絡上巨大的爭論至今。

目前 AI繪畫的技術仍在不斷變化發展中,其迭代之快,完全可以用”日新月異”來形容。即使把今年年初的AI繪畫和現在相比,效果也有天壤之別。

在年初的時候,用Disco Diffusion可以生成一些很有氛圍感的草圖,但基本還無法生成人臉; 僅僅2個月后,DALL-E 2已經可以生成準確的五官; 現在,最強大的Stable Diffusion在畫作的精致程度和作畫速度上更是有了一個量級的變化。

AI繪畫這項技術并不是近年才有的,但是今年以來,AI產出作品的質量以肉眼可見的速度日益提升,而效率也從年初的一個小時縮短到現在的十幾秒。

在這個變化后面,究竟發生了什么事情?就讓我們先全面回顧一下AI繪畫的歷史,再來理解一下,這一年多來,AI繪畫技術足以載入史冊的突破發展。

二、AI繪畫的歷史

AI繪畫的出現時間可能比很多人想象的要早。

計算機是上世紀60年代出現的,而就在70年代,一位藝術家,哈羅德·科恩Harold Cohen(畫家,加利福尼亞大學圣地亞哥分校的教授) 就開始打造電腦程序”AARON”進行繪畫創作。 只是和當下AI繪畫輸出數字作品有所不同,AARON是真的去控制一個機械臂來作畫的。

Harold 對 AARON的改進一直持續了幾十年,直到他離世。 在80年代的時候,ARRON”掌握”了三維物體的繪制; 90年代時,AARON能夠使用多種顏色進行繪畫,據稱直到今天,ARRON仍然在創作。

不過,AARON的代碼沒有開源,所以其作畫的細節無從知曉,但可以猜測,ARRON只是以一種復雜的編程方式描述了作者Harold本人對繪畫的理解 — 這也是為什么ARRON經過幾十年的學習迭代,最后仍然只能產生色彩艷麗的抽象派風格畫作,這正是 Harold Cohen 本人的抽象色彩繪畫風格。 Harold用了幾十年時間,把自己對藝術的理解和表現方式通過程序指導機械臂呈現在了畫布上。

盡管難說AARON如何智能,但作為第一個自動作畫且真的在畫布上作畫的程序,給予它一個AI作畫鼻祖的稱號,倒也符合其身份。

2006年,出現了一個類似ARRON的電腦繪畫產品 The Painting Fool。 它可以觀察照片,提取照片里的塊顏色信息,使用現實中的繪畫材料如油漆,粉彩或者和鉛筆等進行創作。

以上這兩個例子算是比較”古典”方式的電腦自動繪畫,有點像一個學步的嬰兒,有一點樣子,但從智能化的角度來看是相當初級的。

而現在,我們所說的”AI繪畫”概念,更多指的是基于深度學習模型來進行自動作圖的計算機程序。 這個繪畫方式的發展其實是比較晚的。

在2012年 Google兩位大名鼎鼎的AI大神,吳恩達和Jef Dean進行了一場空前的試驗,聯手使用1。6萬個CPU訓練了一個當時世界上最大的深度學習網絡,用來指導計算機畫出貓臉圖片。 當時他們使用了來自youtube的1000萬個貓臉圖片,1。6萬個CPU整整訓練了3天,最終得到的模型,令人振奮的可以生成一個非常模糊的貓臉。

在今天看起來,這個模型的訓練效率和輸出結果都不值一提。 但對于當時的AI研究領域,這是一次具有突破意義的嘗試,正式開啟了深度學習模型支持的AI繪畫這個”全新”研究方向。

在這里我們稍微講一點技術細節: 基于深度學習模型的AI繪畫究竟有多麻煩呢,為什么2012年已經很現代水平的大規模計算機集群耗時多天的訓練只能得出一點可憐的結果?

讀者們或許有個基本概念,深度學習模型的訓練簡單說來就是利用外部大量標注好的訓練數據輸入,根據輸入和所對應的預期輸出,反復調整模型內部參數加以匹配的過程。

那么讓AI學會繪畫的過程,就是構建已有畫作的訓練數據,輸入AI模型進行參數迭代調整的過程。

一幅畫帶有多少信息呢?首先就是長x寬個RGB像素點。 讓計算機學繪畫,最簡單的出發點是得到一個輸出有規律像素組合的AI模型。

但RGB像素組合一起的并非都是畫作,也可能只是噪點。 一副紋理豐富,筆觸自然的畫作有很多筆畫完成,涉及繪畫中每一筆的位置,形狀,顏色等多個方面的參數,這里涉及到的參數組合是非常龐大的。 而深度模型訓練的計算復雜度隨著參數輸入組合的增長而急劇增長…… 大家可以理解這個事情為啥不簡單了。

在吳恩達和Jeff Dean開創性的貓臉生成模型之后,AI科學家們開始前赴后繼投入到這個新的挑戰性領域里。 在2014年,AI學術界提出了一個非常重要的深度學習模型,這就是大名鼎鼎的對抗生成網絡GAN(Generative Adverserial Network,GAN)。

正如同其名字”對抗生成”,這個深度學習模型的核心理念是讓兩個內部程序 “生成器(generator)” 和“判別器(discriminator)”互相PK平衡之后得到結果。

GAN模型一問世就風靡AI學術界,在多個領域得到了廣泛的應用。 它也隨即成為了很多AI繪畫模型的基礎框架,其中生成器用來生成圖片,而判別器用來判斷圖片質量。 GAN的出現大大推動了AI繪畫的發展。

但是,用基礎的GAN模型進行AI繪畫也有比較明顯的缺陷,一方面是對輸出結果的控制力很弱,容易產生隨機圖像,而AI藝術家的輸出應該是穩定的。 另外一個問題是生成圖像的分辨率比較低。

分辨率的問題還好說,GAN在”創作”這個點上還存在一個死結,這個結恰恰是其自身的核心特點: 根據GAN基本架構,判別器要判斷產生的圖像是否和已經提供給判別器的其他圖像是同一個類別的,這就決定了在最好的情況下,輸出的圖像也就是對現有作品的模仿,而不是創新…………

在對抗生成網絡GAN之外,研究人員也開始利用其他種類的深度學習模型來嘗試教AI繪畫。

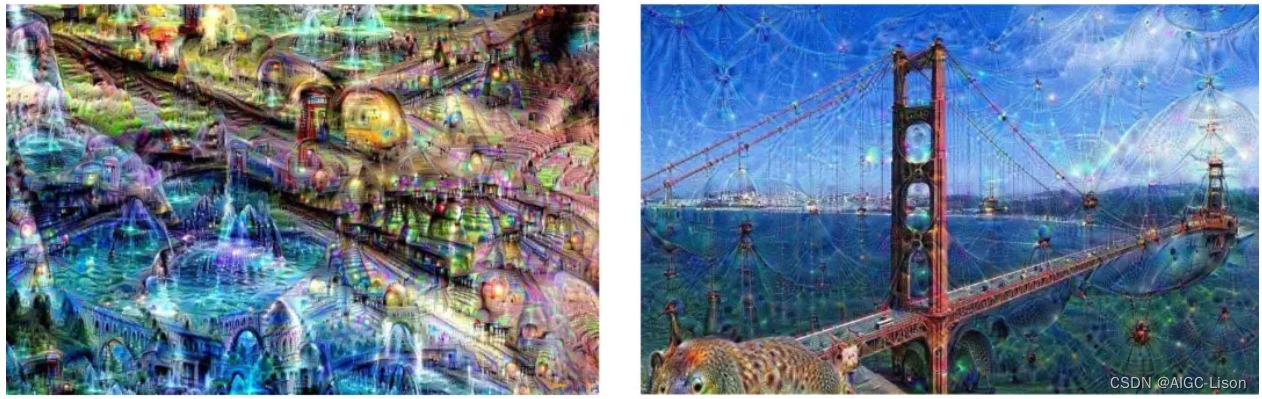

一個比較著名的例子是2015年 Google發布的一個圖像工具深夢(Deep Dream)。 深夢發布了一系列畫作,一時吸引了很多眼球。谷歌甚至為這個深夢的作品策劃了一場畫展。

三、AI繪畫何以突飛猛進

在很多科幻電影或劇集里,往往會有這么一幕,主角和特別有科幻感的電腦AI說了一句話,然后AI生成了一個3D影像,用VR/AR/全息投影的方式呈現在主角面前。

拋開那些酷炫的視覺效果包裝,這里的核心能力是,人類用語言輸入,然后電腦AI理解人類的表達,生成一個符合要求的圖形圖像,展示給人類。

仔細一想,這個能力最基礎的形式,就是一個AI繪畫的概念嘛。(當然,從平面繪畫到3D生成還稍有一點距離,但相比于AI憑空創作一幅具象有意義的繪畫作品的難度,從2D圖自動生成對應的3D模型就不是一個量級上的問題)

所以,無論是用說話控制,還是更玄乎的腦電波控制,科幻影視中的酷炫場景實際上描述了一種AI能力 ,那就是把”語言描述” 通過AI理解自動變為了圖像。 目前語音自動識別文本的技術已經成熟至極,所以這本質上就是一個從文本到圖像的AI繪畫過程。

四、頂級AI繪畫模型的PK:Stable Diffusion V.S MidJourney

作者在之前文章里已經介紹了MidJourney這個在線AI作畫神器,它最大的優點就是零門檻的交互和非常好的輸出結果。創作者無需任何技術背景就能利用基于Discord的MidJourney bot進行對話式繪畫創作(恩,當然,全英文)

從輸出風格上看,MidJourney非常明顯針對人像做了一些優化,用多了后,MidJourney的風格傾向也比較明顯(作者在MidJourney上花了數百刀的計算資源嘗試了各種主題創作后的第一手感受),說得好聽是比較細膩討巧,或者說,比較油膩一點點。

而Stable Diffusion的作品,就明顯的更淡雅一些,更藝術化一些。

哪種風格更好?其實蘿卜青菜各有所愛。

因為做過針對性的優化,如要出人像圖或者糖水風格美圖用MidJourney更方便。 但比較了多張作品后,作者認為Stable Diffusion還是明顯技高一籌,無論從藝術表達上還是風格變化的多樣性上。

不過,MidJourney這幾個月的迭代是有目共睹的快(畢竟是付費服務,很賺錢很有動力啊),加上Stable Diffusion的完全開源,預計相關技術優勢會很快被吸收進MidJourney。 而另一方面,Stable Diffusion模型的訓練還在持續進行中,我們可以非常期待,未來版本的Stable Diffusion模型也將百尺竿頭更進一步。

對所有的創作者用戶而言,這都是天大的好事。

五、AI繪畫的突破對人類意味著什么

2022年的AI領域,基于文本生成圖像的AI繪畫模型是風頭無兩的主角。 從2月份的Disco Diffusion開始,4月 DALL-E 2和MidJourney邀請內測,5月和6月Google發布兩大模型Imagen 和Parti(不開放內測只有論文,感覺略水),然后7月底,Stable Diffusion橫空出世……

真的讓人眼花繚亂。 也勿怪作者在上篇文章里感慨,怎么稍不注意AI繪畫的水平就突飛猛進到如此地步,事實上,確實就是在這一年半載里,AI繪畫發生了革命性的,甚至可以說歷史上會留名的突破性進展。

而接下去的時間里,AI繪畫,或者更廣泛的,AI生成內容領域(圖像,聲音,視頻,3D內容等……)還會發生什么,讓人充滿了遐想和期待。

但不用等待未來,體驗了當下以Stable Diffusion 為代表的最先進AI繪畫模型所能觸達的藝術高度,我們已經基本可以確認,”想象力”和”創造力”這兩個曾經充滿著神秘主義的詞匯,同時也是人類最后的驕傲,其實也是可以被技術解構的。

對人類靈魂神圣至上說法的擁護者而言,當今AI繪畫模型所展現的創造力,是一種對信仰的無情打擊。 所謂靈感,創造力,想象力,這些充滿著神性的詞,即將(或者已經)被超級算力+大數據+數學模型的強力組合無情打臉了。

事實上,類似Stable Diffusion這種AI生成模型的一個核心思路,或者說很多深度學習AI模型的核心思路,就是把人類創作的內容,表示為某個高維或者低維數學空間里的一個向量(更簡單的理解,一串數字)。 如果這個”內容-向量”的轉化設計足夠合理,那么人類所有的創作內容都可以表示為某個數學空間里的部分向量而已。 而存在于這個無限的數學空間里的其他向量,正是那些理論上人類可能創造,但尚未被創造出來的內容。 通過逆向的”向量-內容”的轉換,這些還沒被創造的內容就被AI挖掘出來了。

這正是目前MidJourney,Stable Diffusion這些最新AI繪畫模型所做的事情。 AI可以說是在創作新的內容,也可以說是新繪畫作品的搬運工。AI產生的新繪畫作品在數學意義上一直客觀存在,只是被AI通過很聰明的方式,從數學空間里還原出來,而已。

寫在最后

感興趣的小伙伴,贈送全套AIGC學習資料,包含AI繪畫、AI人工智能等前沿科技教程和軟件工具,具體看這里。

AIGC技術的未來發展前景廣闊,隨著人工智能技術的不斷發展,AIGC技術也將不斷提高。未來,AIGC技術將在游戲和計算領域得到更廣泛的應用,使游戲和計算系統具有更高效、更智能、更靈活的特性。同時,AIGC技術也將與人工智能技術緊密結合,在更多的領域得到廣泛應用,對程序員來說影響至關重要。未來,AIGC技術將繼續得到提高,同時也將與人工智能技術緊密結合,在更多的領域得到廣泛應用。

?

一、AIGC所有方向的學習路線

AIGC所有方向的技術點做的整理,形成各個領域的知識點匯總,它的用處就在于,你可以按照下面的知識點去找對應的學習資源,保證自己學得較為全面。

二、AIGC必備工具

工具都幫大家整理好了,安裝就可直接上手!

三、最新AIGC學習筆記

當我學到一定基礎,有自己的理解能力的時候,會去閱讀一些前輩整理的書籍或者手寫的筆記資料,這些筆記詳細記載了他們對一些技術點的理解,這些理解是比較獨到,可以學到不一樣的思路。

四、AIGC視頻教程合集

觀看全面零基礎學習視頻,看視頻學習是最快捷也是最有效果的方式,跟著視頻中老師的思路,從基礎到深入,還是很容易入門的。

五、實戰案例

紙上得來終覺淺,要學會跟著視頻一起敲,要動手實操,才能將自己的所學運用到實際當中去,這時候可以搞點實戰案例來學習。

通過社區投票將代幣遷移并更名為 CXT,以推動人工智能更深層次的創新)

,這樣既快速又高效,省去了“各種安裝+各種配置+各種遷移數據”帶來的麻煩和時間)

表達式(3)PAYLOAD EXPRESSIONS)

)

及同類型軟件介紹)