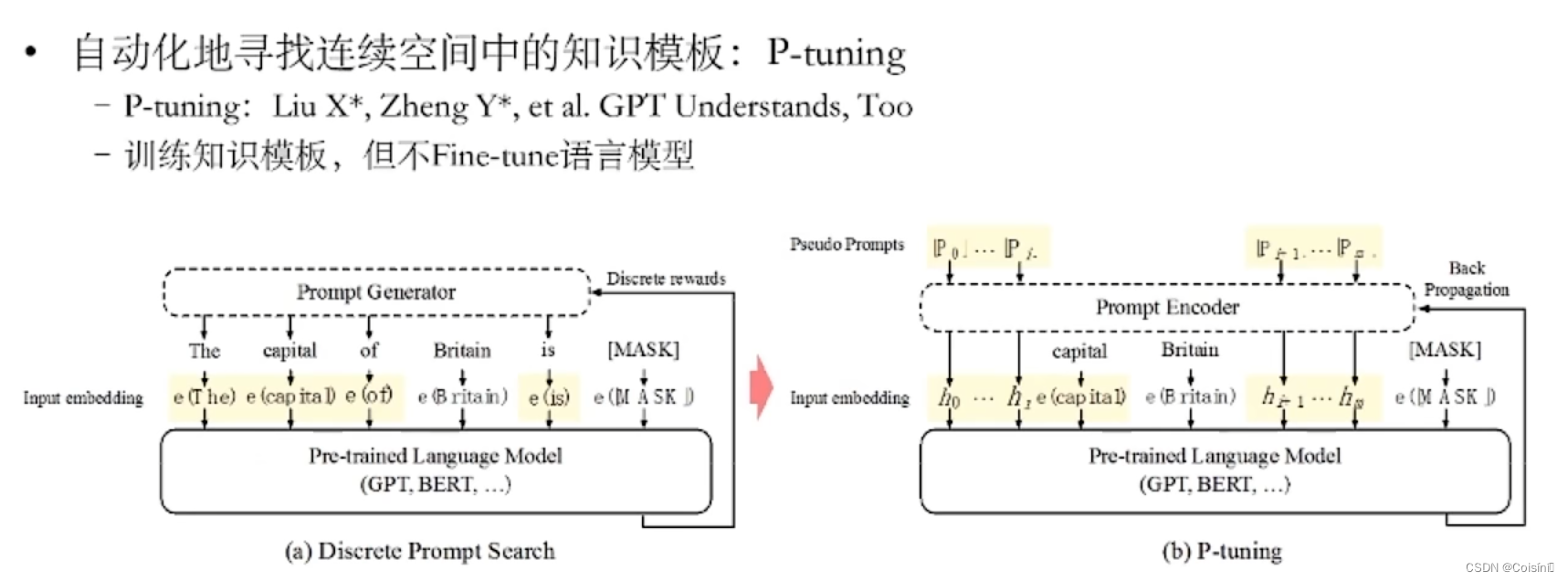

推薦的一個視頻:p-tuning

P-tunning直接使用連續空間搜索

做法就是直接將在自然語言中存在的詞直接替換成可以直接訓練的輸入向量。本身的Pretrained LLMs 可以Fine-Tuning也可以不做。

這篇論文也解釋了為什么很少在其他領域結合知識圖譜的原因:就是因為大模型本身就是一個很好的KG,作者在視頻中講到利用P-tuning的方法完全可以在WikiData上實現60%的準確率,也就說可以完全通過大模型形成60%的WikiData中三元組表示內容。而且隨著模型規模的上升,這個精度也會繼續增加。

【使用Fine-tunning的方法,BERT的性能表現要高于GPT;而基于P-tunning的方法,GPT的性能表現高于BERT】

通訊作者簡介:

青島科技大學-王宜敏教授主頁

摘要

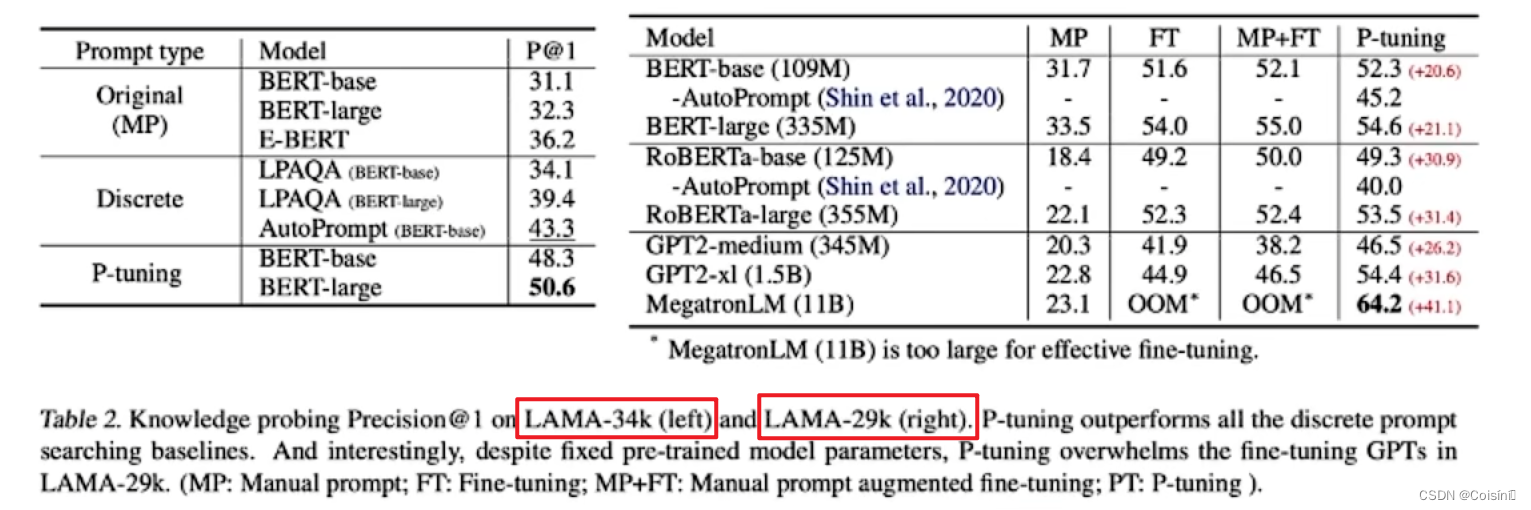

假新聞檢測的標準范式依賴于利用文本信息來建模新聞的真實性。然而,網絡假新聞的微妙本質使得僅僅依靠文本信息進行揭穿具有挑戰性。近年來針對多模態假新聞檢測的研究表明了該方法與純文本檢測方法同樣具有優越的性能,從而建立了檢測假新聞的新范式。然而,這種范例可能需要大量的訓練實例或更新整套預訓練的模型參數。此外,現有的多模態方法通常集成跨模態特征,而不考慮來自不相關語義表示的可能引入的噪聲。此外,現有的多模態方法通常集成跨模態特征,而不考慮來自不相關語義表示的潛在噪聲引入。為了解決這些問題,本文提出了相似性感知多模態提示學習(SAMPLE)框架。將提示學習融入多模式假新聞檢測中,我們使用三個帶有軟語言器的提示模板來檢測假新聞。 此外,我們引入了一種相似性感知融合方法,該方法自適應地融合多模態表示的強度,以減輕來自不相關的跨模態特征的噪聲注入。評估結果表明,SAMPLE 的性能優于之前的工作,在兩個多模態基準數據集上獲得了更高的 F1 和準確度分數,無論數據豐富還是少樣本設置都證明了其在現實場景中的可行性。

Introduction

社交媒體的日益普及極大地影響了信息傳播和消費的方式。 雖然社交媒體平臺為人們尋找和分享信息提供了有效的方式,但假新聞的傳播給國際社會造成了巨大傷害。 為了減輕在線假新聞的影響,學術界和工業界開發了各種技術。 早期研究[29,4]主要集中于分析假新聞的文本內容。然而,假新聞可以采取多種形式,僅依靠文本信息來驗證其真實性需要專業知識,這可能非常耗時。 例如,圖 1 顯示了兩個新聞片段,這對僅通過文本信息來識別其真實性提出了挑戰。 因此,最近開發了多模態假新聞檢測(FND)技術來利用圖像和文本信息,展示了通過跨模態分析提供的互補優勢的良好性能。

多模態 FND 旨在結合圖像和文本的特征來自動識別虛假新聞帖子。 傳統的深度學習方法,例如卷積神經網絡 (CNN)、循環神經網絡 (RNN) 和 Transformer,在假新聞的文本和圖像表示建模方面取得了重大進展。然而,這些方法通常受到依賴大量注釋數據來實現令人滿意的性能的限制。 最近,人們對利用大型預訓練模型進行 FND 越來越感興趣。許多研究[42,2]使用預訓練的語言模型(例如 BERT [10])和預訓練的視覺模型(例如 ResNet [16])分別對新聞帖子的文本和圖像特征進行編碼。然而,預訓練模型通常是在不特定于任何特定領域的大型、未經精煉的語料庫上進行訓練的。 盡管預訓練模型可以利用外部知識來識別虛假帖子,但 FND 系統的有效性高度依賴于其焦點領域 [19]。

微調是使預訓練模型適應不同下游任務的常用技術。 在最近的研究中,BERT 的變體,包括原始的預訓練模型,已經專門針對 FND 進行了微調 [7]。 然而,由于需要大量標記實例來訓練額外的分類器,FND 的微調通常會在資源匱乏的情況下帶來困難 [5]。 傳統的預訓練語言模型采用完形填空式的目標進行訓練,其中涉及預測屏蔽詞以了解其分布,而微調的目的是直接識別目標標簽。 因此,預訓練模型需要大量標記數據來針對特定任務進行微調。 同時,由于預訓練模型的大小,微調、更新單個任務的所有模型參數給現實世界的 FND 帶來了挑戰 [27]。 提示學習是一種旨在通過向輸入添加附加信息并在調整過程中使用完形填空式任務來更好地利用預訓練知識的方法,從而更有效地應用預訓練信息[37]。此外,提示學習對于現實世界的 FND 場景尤其重要,因為在現實世界中,手動標記的假新聞數據很少。 它使預先訓練的模型即使在標記數據有限的資源匱乏的環境中也能獲得有競爭力的性能[5]。 然而,當前基于提示的 FND 方法[19]主要考慮文本信息,對假新聞帖子中跨模態特征的分析尚不成熟。

圖 1. 兩個假新聞片段及其原始報道。

與直接輸出類別分布的微調模型相比,提示學習與語言建模目標保持一致,通過在原始文本輸入之前添加補充信息來生成與 FND 相關的特定答案詞。 **如圖1左側的新聞片段所示,通過在原文前引入提示(例如,“這是一條新聞。前總統和違法者巴拉克·奧巴馬……” ),這種方法的目的是檢索提示文本的屏蔽標記。**然而,離散提示的局限性在于它需要嵌入模板詞以與自然語言詞的嵌入保持一致。 為了解決這個問題,連續提示[35]通過直接在預訓練模型的連續空間中執行提示來消除離散提示的約束,例如“< soft > < soft >…< soft > < mask >,Former president and breaker of laws, Barack Obama…” ,其中每個 < soft > 可以與隨機初始化的可訓練向量相關聯。此外,混合提示[19]不是利用完全可學習的提示模板,而是將可訓練向量合并到離散提示模板中(例如:“< soft > This is a piece of < mask > news < soft >. Former president and breaker of laws, Barack Obama…”)并展示了比單獨使用每種提示類型更優越的性能。

以前的多模態 FND 方法 [26,41] 旨在通過直接融合多模態表示來提高性能。 然而,僅僅結合圖像和文本特征并不能保證信息的可靠性,因為新聞文章的真實性并不完全與圖文相關性相關。 在這種情況下,文本和圖像特征之間的相關性往往較弱,導致多模態表示出現噪聲。 因此,多模態 FND 模型掌握不同模態之間的語義相關性并自適應地結合多模態特征進行準確分類至關重要。

語義相似度的方法大概率來自于SAFE模型。

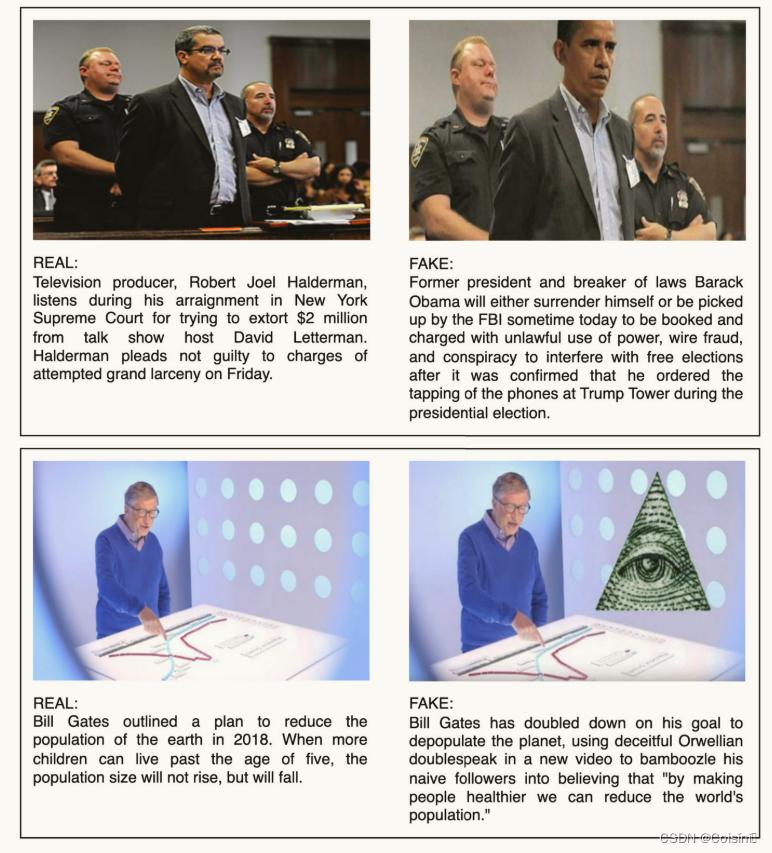

本文提出了一種用于 FND 的相似性感知多模態提示學習(SAMPLE)框架。 三種流行的提示學習方法(離散提示(DP)、連續提示(CP)和混合提示(MP))被系統地集成到用于 FND 任務的軟言語器中。 此外,應用預訓練模型對比語言-圖像預訓練(CLIP)[36]來提取文本和圖像特征,用于生成多模態表示。 為了解決文本和圖像之間語義表示不相關的問題,該框架計算了它們特征之間的語義相似度。 為了調整聚合多模態表示的強度,語義相似性被進一步歸一化。 為了評估所提出的 SAMPLE 框架的性能,使用了兩個特定領域的可公開訪問的數據集:PolitiFact 和 GossipCop [39])。 我們將 SAMPLE 與現有的 FND 方法以及標準微調方法進行比較,在少樣本和數據豐富的場景下模擬真實世界的 FND 設置。 實驗結果表明,無論數據豐富還是少樣本場景,SAMPLE 在宏觀 f1 和準確性指標方面都顯著優于傳統的深度學習和微調方法。

本文的貢獻是:

- 我們提出了一個名為 SAMPLE 的框架,它自適應地將 CLIP 模型生成的多模態特征與預先訓練的語言模型的文本表示融合在一起,以幫助快速學習來檢測假新聞。

- 所提出的框架通過使用預訓練 CLIP 模型生成的標準化余弦相似度來調整融合多模態特征的強度,從而緩解了不相關的跨模態語義問題。

- SAMPLE 在兩個基準多模式假新聞檢測數據集上進行了評估,在資源匱乏和數據豐富的場景中都優于以前的方法。

Related work

假新聞被描述為“通過新聞媒體或互聯網以真實新聞為幌子傳播以獲取政治或經濟利益的虛假信息”[30]。 此外,最近的許多研究旨在將虛假內容與類似概念區分開來,例如錯誤信息[20]和虛假信息[43]。 在這種情況下,錯誤信息是由于失誤或認知偏見而產生的虛假信息,而虛假信息是故意捏造的,在這兩種情況下,其形式并不限于新聞媒體。

單模態虛假新聞檢測

對單模態 FND 的早期研究通常使用手工特征來識別帖子文本或圖像中的異常情況。 傳統的圖像篡改檢測方法[8]可以有效地檢測新聞圖像的篡改行為。 這些方法從假新聞中學習圖像取證、語義、統計和上下文特征。 假新聞的特點通常是違反常識的語義不一致[24],以及圖像質量差[14]。 在文本模式中,之前的研究 [32] 設計了一個模塊化工具 MedOSINT 來識別與 Covid-19 相關的假新聞。 王等人[45]提出了一種雙層次壓縮學習框架,其中包括多種數據增強策略和 FND 的三個對比學習任務。 Khullar 和 Singh [23] 建立了一個聯邦學習框架來對假新聞進行分類并維護數據隱私。 雖然單模態 FND 是檢測假新聞的可靠基線,但 FND 中各模態的相關性和一致性尚未確定。

多模態虛假新聞檢測

先前多模態假新聞檢測(FND)的研究通常集中在兩種方法:設計復雜網絡或利用預先訓練的模型作為特征提取器。周等人 [46]提出了SAFE模型,該模型使用Image2Sentence模型將圖像轉換為文本標題,并擴展Text-CNN模型以從新聞描述中提取文本特征。為了檢測假新聞,該模型使用稍微修改的余弦相似性度量來計算文本和視覺信息之間的相關性,然后將其輸入分類器。 Meel 和 Vishwakarma [31] 結合了分層注意力網絡、圖像字幕和取證分析來檢測多模式假新聞。

最近,許多研究選擇利用預先訓練的模型來提取 FND 中的文本和視覺特征。 例如,CAFE [9]采用 BERT 和 ResNet-34 作為分別編碼文本和視覺特征的預訓練模型。 同樣,周等人 [47]提出了FND-CLIP模型,該模型同時使用基于ResNet的編碼器、基于BERT的編碼器和兩個成對的CLIP編碼器從圖像和文本中提取特征表示。 華等人[18]建立了一種基于 BERT 的反向翻譯文本和整個圖像多模態模型,具有對比學習和數據增強功能。 靜等人[22]設計了一個漸進融合網絡來捕獲每種模態在不同級別的特征表示,并實現了一個混合器來建立模態之間的連接。

此外,一些研究發現,微調預訓練模型也可以產生有競爭力的性能,而不僅僅是將它們用作特征提取器。 例如,Ro-CT-BERT [7] 用專業短語擴展了詞匯量,并采用了對抗性訓練中激烈的 softmax 損失來提高模型的魯棒性。 盡管傳統的多模態 FND 方法以準確檢測假新聞而聞名,但它們通常需要大量人工注釋的數據才能有效地訓練模型。 此外,雖然在早期階段檢測假新聞可以最大限度地減少其有害影響[40],但 FND 方法仍然受到人工注釋數據可用性的限制。

針對于虛假新聞檢測的提示學習

近年來,提示學習已成為自然語言處理(NLP)的新范式,并在各種 NLP 任務中表現出與標準微調相當的性能。 例如,朱等人 [48]開發了PLST框架,該框架在短文本分類任務中結合了文本輸入和來自開放知識圖的外部知識。 韓等人[15]提出了PTR模型,該模型是為多類文本分類而設計的,并使用包含多個子提示的邏輯規則構造提示。 基于提示的模型也被用來幫助假新聞檢測(FND)。 例如,El Vaigh 等人 [11] 利用 DistilGPT-2 的基于提示的模型結合多任務學習來檢測 MediaEval-2021 中與冠狀病毒相關的假新聞。 江等人[19]提出了KPL,通過整合外部知識來檢測假新聞。 然而,KPL 依賴于人為設計的提示和語言器,這可能非常耗時且可能不可靠。 此外,它沒有解決新聞帖子多模態表示的融合如何增強假新聞檢測。

Methodology

所提出的方法旨在利用文本和圖像來識別新聞文章的真實性。 多模態 FND 的主要目標是為給定的包含 n n n個單詞的文本輸入 x = [ w 1 , w 2 , . . . , w n ] x = [\mathcal{w}_1,\mathcal{w}_2,...,\mathcal{w}_n] x=[w1?,w2?,...,wn?]以及 m m m個圖像 i = [ i 1 , i 2 , . . . , i m ] i = [i_1,i_2,...,i_m] i=[i1?,i2?,...,im?]的新聞文章分配標準二元分類標簽 y ∈ { 0 , 1 } y \in\{0,1\} y∈{0,1}?,其中 0 代表真實新聞,1 代表假新聞。為了識別與給定新聞文章文本相對應的最相關圖像,使用預先訓練的 CLIP 模型分別對文本和圖像表示進行編碼。 在此過程中,僅保留與文本表示具有最高余弦相似度的圖像,而丟棄其余圖像。這里說明了含有多個圖像的帖子的處理方法

圖 2. 用于假新聞檢測SAMPLE的整體結構。

離散提示

在本節中,我們利用離散提示[38],它主要對應于自然語言短語并自動搜索離散空間中描述的模板。 此外,我們引入了一個稱為連續提示的擴展版本[35],它使用包含預訓練語言模型詞匯中不存在的偽標記的提示。 我們還采用了混合提示,結合了 FND 的離散提示和連續提示。 最后,我們標準化文本和圖像之間的語義相似性來調整融合的多模態表示。 圖 2 說明了所提出的 SAMPLE 的整體結構。

我們利用手動構建的離散模板作為提示機制。 為了使模型能夠檢索被屏蔽的單詞,文本輸入最初在提示學習階段被屏蔽。 離散提示涉及通過有限的、人為設計的模板故意扭曲文本輸入,并用掩碼替換單個關鍵字。 我們研究了五個不同的離散模板,因為模板的選擇可能會對語言模型的性能產生重大影響,如附錄 A 所示。離散模板 d t dt dt="This is a news piece with < mask > information"是一個人為設計的模板。接下來,我們通過預訓練的語言模型計算與 FND 任務的目標相關的屏蔽詞的表示。 為了實現這一點,我們將任意模板 d t dt dt 與初始輸入 x x x 連接起來以生成提示, x d = [ d t ; x ] x_d=[dt;x] xd?=[dt;x]。隨后,計算 x d x_d xd?的隱藏狀態:

其中, h i d t ( i ∈ [ 1 , m ] ) h^{dt}_i(i\in[1,m]) hidt?(i∈[1,m])和 h m a s k d t h^{dt}_{mask} hmaskdt?分別是長度為m和< mask >離散模板標記的隱藏向量。 h j x ( j ∈ [ 1 , n ] ) h^x_j(j\in[1,n]) hjx?(j∈[1,n])是長度為n的輸入文本的隱藏向量, P L M ( ) PLM() PLM()是屏蔽語言模型的輸出。

其中, h i d t ( i ∈ [ 1 , m ] ) h^{dt}_i(i\in[1,m]) hidt?(i∈[1,m])和 h m a s k d t h^{dt}_{mask} hmaskdt?分別是長度為m和< mask >離散模板標記的隱藏向量。 h j x ( j ∈ [ 1 , n ] ) h^x_j(j\in[1,n]) hjx?(j∈[1,n])是長度為n的輸入文本的隱藏向量, P L M ( ) PLM() PLM()是屏蔽語言模型的輸出。

連續提示

盡管離散提示自然地繼承了任務描述的可解釋性,但它受到在自然語言中嵌入模板詞的要求的限制。 此外,離散提示可能不是最理想的,因為預訓練的語言模型可能已經從完全不同的上下文中學習了目標知識。 這種手動設計的約束也可以應用于言語生成器,因為手動言語生成器通常基于有限的信息來確定預測。例如,標準語言描述器映射$ fake ? {counterfeit, sham, …, falsify}$,這意味著在推斷過程中,只有預測那些與token相關的詞才會被認為是正確的,而不管對其他相關詞的預測,如“unreal”或“untrue”,這些也具有有用的信息。

為了解決上述問題,通過用連續模板替換可訓練標記來重新格式化離散模板 s t st st=“ < s o f t 1 > , < s o f t 2 > , . . . , < s o f t t > , < m a s k > <soft_1>,<soft_2>,...,<soft_t>,<mask> <soft1?>,<soft2?>,...,<softt?>,<mask>”,其中每一個 < s o f t > < soft > <soft>與隨機初始化的可訓練向量相關聯。(三種初始化方法的比較如附錄 B 所示。實驗結果表明,隨機初始化實現了可比的性能,驗證損失的收斂速度比其他方法稍快。)

其中, h k s t ( k ∈ [ 1 , t ] ) h^{st}_k(k\in[1,t]) hkst?(k∈[1,t])和 h m a s k s t h^{st}_{mask} hmaskst?分別是長度為 t t t的隱藏向量和連續模板的 m a s k mask mask標記。

混合提示

最近的研究表明,與單獨使用它們相比,采用混合連續和離散模板的混合提示表現出更優越的性能[15]。在此基礎上,我們將可訓練tokens合并到離散提示模板中。 具體來說,我們在混合模板的開頭和結尾插入了兩個可訓練的tokens, h h e a d m t h^{mt}_{head} hheadmt?和 h t a i l m t h^{mt}_{tail} htailmt?,表示為

mt = “$<h^{mt}{head}>This\space is\space a\space piece\space of<h^{mt}{mask}>\space news.<h^{mt}_{tail}> $”。

與離散提示類似,新的混合提示 x m = [ m t ; x ] x_m=[mt;x] xm?=[mt;x]?。 然后我們計算其隱藏狀態如下:

其中, h i m t ( i ∈ [ 1 , m ] ) h^{mt}_i(i\in[1,m]) himt?(i∈[1,m])和 h m a s k m t h^{mt}_{mask} hmaskmt?分別是長度為 m m m的隱藏向量和混合模板的 m a s k mask mask標記。

相似性感知的多模態特征融合

根據之前的研究[47],從預訓練模型中提取的文本和圖像特征表現出很大的語義差距。 因此,多模態特征的直接融合無法捕獲內在的語義相關性。單模態預訓練模型,例如 BERT 和 ViT-B-32,傾向于關注瑣碎的線索,而不是提取語義上有意義的信息。 BERT 可以更好地從文本輸入中學習情感特征,而 ViT-B-32 可以捕獲圖像中的噪聲模式。 因此,即使文本和圖像在語義上相關,單模態特征的直接融合也可能會將噪聲注入多模態表示中。 相比之下,預先訓練的 CLIP 模型利用大量圖像-文本對數據集來捕獲情感特征或噪聲模式之外的語義相關性。

為了有效地整合圖像和文本特征,應用預訓練的CLIP模型來獨立提取這些特征。 CLIP 模型由用于文本編碼的文本 Transformer 組成,并采用 Vision Transformer (ViT-B-32) 作為圖像編碼器。 為了降低編碼器提供的粗略特征的維數并消除冗余信息,我們利用單獨的投影頭 P t x t P_{txt} Ptxt?和 P i m g P_{img} Pimg?來處理文本和圖像特征。每個投影頭具有兩組全連接層 (FC),后面是批量歸一化、修正線性單元 (ReLU) 激活函數和一個 dropout 層。接下來,我們測量 P t x t P_{txt} Ptxt?和 P i m g P_{img} Pimg?之間的余弦相似度 s i m sim sim來修正融合特征 f f u s e d f_{fused} ffused?的強度:

在實驗過程中,我們注意到某些新聞帖子,無論其真實性如何,都沒有表現出明確的跨模態語義關系。 因此,連接單模態特征以生成融合特征可能會引入噪聲,特別是在相似度較低的情況下。 為了解決這個問題,我們應用標準化和 Sigmoid 函數將相似度值限制在 [0 ?1] 范圍內。標準化涉及在訓練期間計算平均值和標準差,從 s i m sim sim中減去運行平均值,然后將結果除以運行標準差。然后可以使用標準化相似度來調整最終跨模式表示的強度 m f u s e d m_{fused} mfused?:

軟言語器

為了恢復提示模板中的屏蔽單詞,使用軟語言器將標簽映射到其相應的單詞。 在本研究中,我們利用 WARP [13] 來識別連續嵌入空間中的最佳提示,其中預先訓練的語言模型通過進行搜索來預測屏蔽標記。 我們在上述三種模板類型中使用軟語言來比較不同的提示方法。為了確定提示和言語嵌入的最佳參數 θ = { θ P , θ V } \theta=\{\theta^P,\theta^V\} θ={θP,θV}?,我們首先使用殘差連接將掩碼語言模型的輸出向量添加到調整后的跨模態表示中。 然后將組合輸出輸入 FC 層:

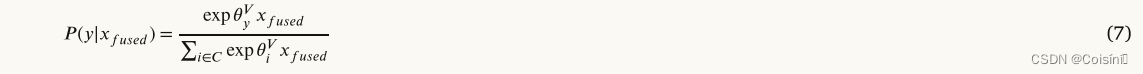

其中 x ′ x' x′是上面的提示模板之一相連接的輸入序列。分類概率 p ( y ∣ x ′ ) p(y|x') p(y∣x′)可以計算為:

其中的C是類別的集合, θ y V \theta^V_y θyV?是真實標簽的嵌入, θ i V \theta^V_i θiV?是預測標簽詞的嵌入。最后,交叉熵損失可以最小化為:

Experiment

我們在資源匱乏和數據豐富的場景中在兩個基準 FND 數據集上評估了我們提出的方法。 本節的第一部分概述了基準多模式 FND 數據集,包括其統計數據。 在第二部分中,我們解釋了數據豐富和少樣本設置的實現細節。 最后,我們對我們提出的方法以及基線模型進行了詳細的討論和分析。

數據

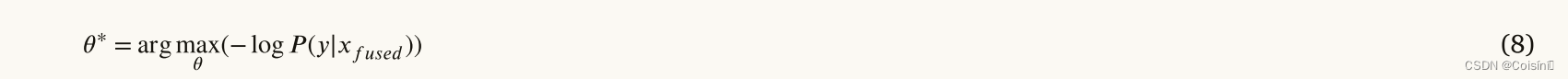

我們使用兩個可公開訪問的數據集來檢測虛假信息,即 PolitiFact 和 GossipCop,它們分別包含政治新聞和名人八卦,并包含在 FakeNewsNet 項目中 [39]。 使用提供的數據爬行腳本,我們從 PolitiFact 檢索了 1,056 條新聞,從 GossipCop 檢索了 22,140 條新聞。為了減少冗余,對于具有多個圖像的新聞,我們僅根據文本和圖像的余弦相似度保留最相關的圖像。 沒有圖像或圖像 URL 無效的新聞將被排除。 結果數據集統計數據如表 1 所示。

實施細節

采用 HuggingFace 庫中預訓練的 RoBERTa 作為快速學習的主要模塊。 應用來自預訓練 CLIP (ViT-B-32) 模型的文本和圖像編碼器來提取各自的特征。 隱藏層投影層的大小設置為768,dropout率為0.6。 我們使用 AdamW 優化器來優化模型參數,學習率為 3e?5,衰減參數為 1e?3,這兩個參數都是根據經驗確定的。 該模型經過 20 個 epoch 的訓練,我們選擇能夠產生最佳驗證性能的模型檢查點來進行測試。 我們在少樣本和數據豐富的設置中評估該方法。

在少樣本設置中,我們的模型是使用從數據集中隨機抽樣的少量實例( n n n)進行訓練的。具體地說,我們考慮 n ∈ [ 2 , 4 , 8 , 16 , 100 ] n∈[2,4,8,16,100] n∈[2,4,8,16,100]? 。其余實例用于測試。此外,還會創建與訓練集大小相同的驗證集用于模型選擇。PolitiFact 數據集包含數量有限的新聞條目。 為了解決這一限制,我們采用了一種稱為 PolitiFact 100-shot 設置的特定配置。 在此配置中,我們分配 100 個實例用于訓練,50 個實例用于開發目的。 由于訓練集和驗證集質量對模型性能的顯著影響,我們使用不同的隨機種子重復上述數據采樣方法五次。然后,我們計算平均分數(排除最高和最低分數),以評估模型在少樣本設置中的性能。 對于訓練集和驗證集,我們確保訓練階段標記實例的平衡分布。

在數據豐富的情況下,兩個數據集被分為三部分,即訓練集、驗證集和測試集,分割比例為8:1:1。 為了評估所提出模型的穩定性,我們使用不同的隨機種子重復上述數據采樣過程五次。 我們報告平均分數,計算為從五次運行中去除最高和最低分數后的分數平均值。

基線模型

我們將所提出的 SAMPLE 模型與之前在 FND 數據集上實現了最先進性能的幾個模型進行了比較。 具體來說,我們的比較涉及單模態方法 (1-2)、多模態方法 (3-6) 和標準微調方法 (7)。 為了初始化單詞嵌入,我們利用在 60 億個單詞的語料庫上訓練的預訓練 100 維 GloVe 嵌入 [34]。

- (1) LDA-HAN [21]:該模型將潛在狄利克雷分配(LDA)[3]主題分布納入分層注意力網絡中。

- (2) T-BERT [2]:這種基于特征的方法使用級聯三重 BERT 模型來預測假新聞。

- (3) SAFE [46]:該模型將圖像轉換為其文本描述,并利用文本和視覺信息之間的相關性來檢測假新聞。

- (4) RIVF[44]:該模型利用VGG和BERT模型對圖像和文本特征進行編碼。 它將縮放點積注意力機制應用于融合的多模態特征來捕獲文本和圖像之間的關系。

- (5) SpotFake[42]:該模型使用預訓練的圖像模型VGG和BERT來提取各自的圖像和文本特征,將它們連接起來以對假新聞進行分類。

- (6) CAFE [9]:該模型使用模糊感知多模態方法來自適應聚合單模態特征和相關性。

- (7) FT-RoBERTa:這是預訓練語言模型 RoBERTa 的標準、微調版本。

結果

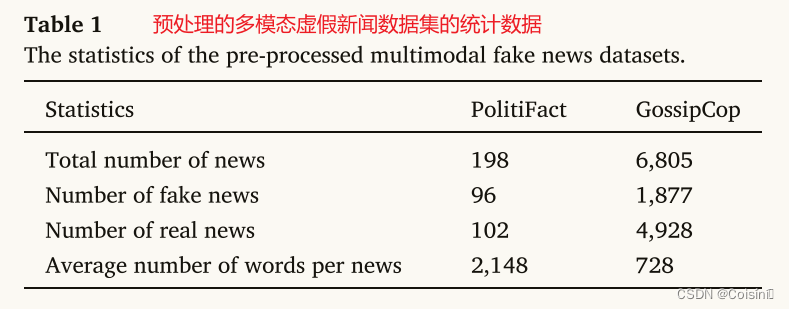

表2.基線和多模態提示學習框架之間的整體宏觀 F1 和準確性。 D-SAMPLE、C-SAMPLE 和 M-SAMPLE 分別表示所提出的 SAMPLE 框架中的離散提示、連續提示和混合提示。

表 2 顯示了將所提出的 SAMPLE 框架與微調方法、多模態和單模態 FND 方法進行比較的總體結果。

與微調相比。 首先,我們通過評估各自的 F1 分數來研究標準微調 RoBERTa (FT-RoBERTa) 和提議的 SAMPLE 的性能。我們計算 M-SAMPLE 的平均改進(即 ( 0.44 ? 0.39 ) + . . . ( 0.58 ? 0.52 ) 5 × 2 + ( 0.47 ? 0.46 ) + . . . ( 0.81 ? 0.77 ) 5 × 2 \frac{(0.44?0.39)+...(0.58?0.52) }{5×2}+ \frac{(0.47?0.46)+...(0.81?0.77)}{ 5×2 } 5×2(0.44?0.39)+...(0.58?0.52)?+5×2(0.47?0.46)+...(0.81?0.77)?),C-SAMPLE 和 D-SAMPLE 優于 FT-RoBERTa,發現所有 SAMPLE 方法分別優于 FT-RoBERTa 0.05、0.024 和 0.035。隨著訓練樣本數量的減少,這種改進更加顯著,凸顯了在資源匱乏的場景下即時學習的優越性。

然而,在數據豐富的情況下,改進變得更小,其中 F1 的平均改進分別為 0.005、0.005 和 0.01,這表明 FT-RoBERTa 在訓練數據充足時能夠實現可比的性能。 SAMPLE 方法和 FT-RoBETRa 之間的準確性比較與上述觀察結果一致,證明了所提出的方法在利用 PLM 信息方面的優越性,特別是在訓練數據稀缺的情況下。 然而,在數據豐富的環境中,標準微調方法仍然可以作為可靠的基線。

與多模態方法進行比較。 我們與之前的多模態 FND 方法相比評估了 SAMPLE 的性能。 我們的結果表明,無論是多模態還是單模態方法,SAMPLE 的 F1 和準確度得分在所有設置中都優于以前的方法。 例如,在 PolitiFact 數據集上進行評估時,與 CAFE 相比,M-SAMPLE 在 100 個樣本設置中實現了高達 0.29 秒的顯著改進。 這一改進主要歸功于 CLIP 模型的學習方法,它利用大量的圖像文本對來學習多模態語義的提取。 相反,CAFE 常用的預訓練模型(如 BERT 和 ResNet-34)可能無法有效捕獲以異構特征分布為特征的單模態特征。

不同提示模板的分析。 結果表明,混合提示 (M-SAMPLE) 優于 C-SAMPLE 和 D-SAMPLE,F1 的平均改進分別為 0.04 和 0.02。 這一發現表明,連續提示不如離散和混合提示方法。 具體來說,C-SAMPLE 的使用可能無法提供足夠的先驗人類知識來幫助語言表達者從連續空間中捕獲標簽詞。

總體而言,實驗結果表明,無論采用少鏡頭還是數據豐富的設置,所提出的 SAMPLE 方法在多模態 FND 任務中都表現出優越的性能。

分析

本小節在少樣本和數據豐富的設置中對所提出的 SAMPLE 方法進行了全面分析。 首先,評估圖像模態的重要性。 接下來,給出了所提出的模型在各種數據設置下的標準差。 消融研究進一步檢查了 SAMPLE 的關鍵組成部分。 最后,我們可視化并比較不同基線模型生成的嵌入。

圖像模態的影響

將圖像和文本特征之間的語義相似性集成到 SAMPLE 中的多模態表示中,可以自動調整跨多種模態的相關性。 然而,該方法不允許直接測量圖像模態的有效性。

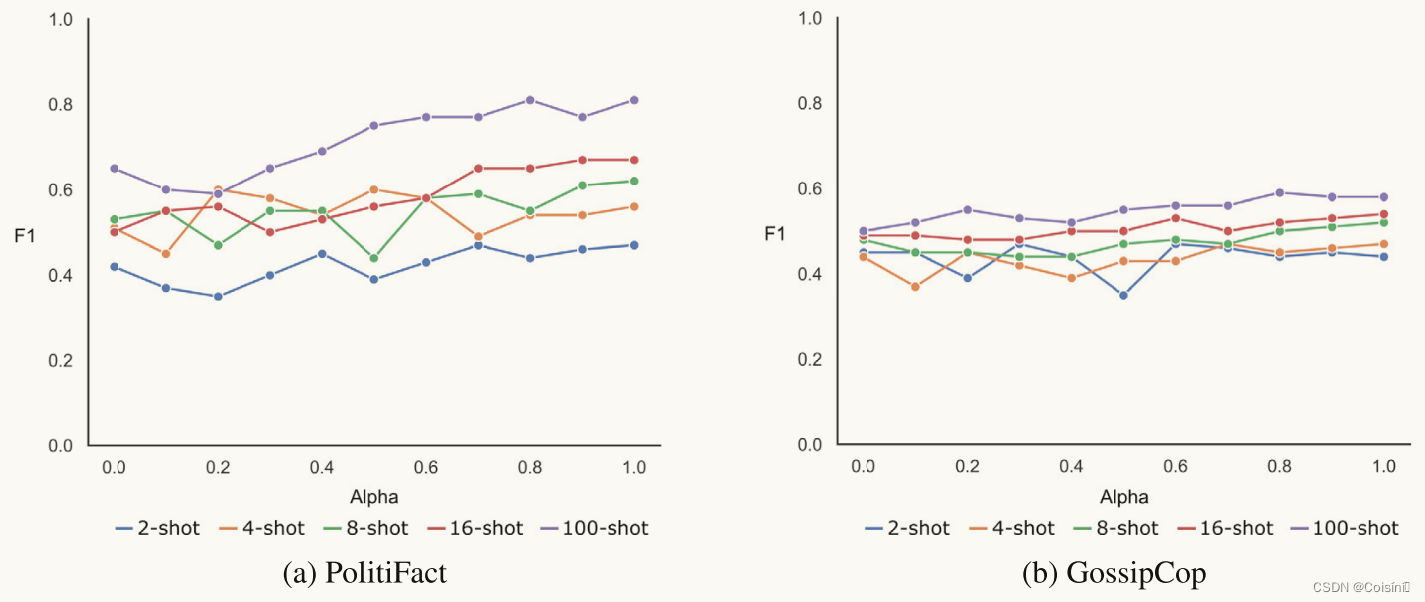

圖 3. 所提出框架中圖像模態的重要性。

為了理解視覺模態對模型推理的影響,我們引入了一個可調節參數,參數 α \alpha α,來調節視覺模態在少樣本訓練過程中的參與程度。準確地說,融合的多模態特征乘以 α ∈ [ 0 , 1 ] \alpha\in[0,1] α∈[0,1]。將 α \alpha α設置為0會消除視覺模態的貢獻,而將 α \alpha α設置為1則充分利用圖像和文本兩個模態。在這個實驗中,我們應用了M-SAMPLE,它實現了最高的F1。 根據圖 3 所示的結果,隨著 α \alpha α的增加,M-SAMPLE 獲得了更高的 F1,這表明視覺模態的參與可以增強模型性能。然而,我們也觀察到包含視覺模態會導致 F1 下降的情況,特別是當訓練樣本數量相對較小時,例如在 2-shot、4-shot 和 8-shot 設置中。 這表明,當與其他模態的相關性有限時,視覺模態特征的存在可能會對少樣本設置中的整體性能產生不利影響。

穩定性測試

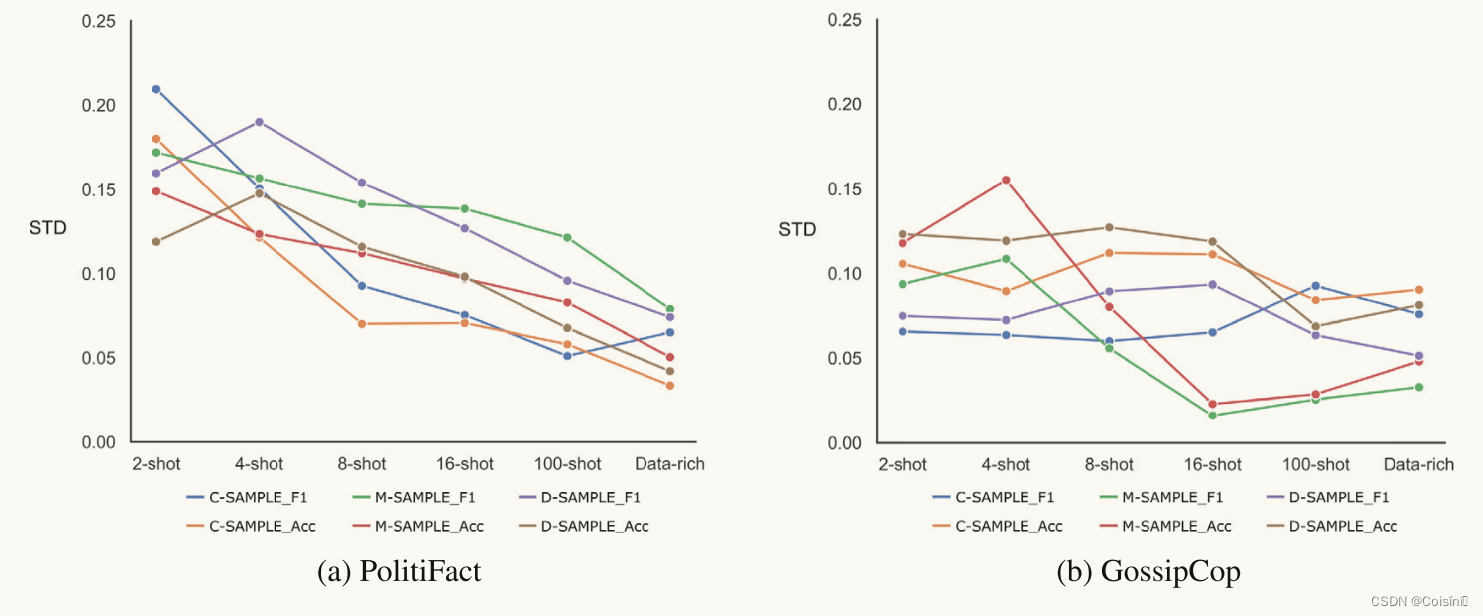

? 圖 4. 所提出框架中 F1 的標準差和準確度。

在本研究中,我們通過測量少樣本和數據豐富設置中 F1 的標準差和準確性來評估 SAMPLE 模型的穩定性。 如圖 4 所示,我們展示了對每個樣本模型進行的上述五次實驗的平均標準差。 我們觀察到標準差隨著訓練樣本數量的增加而減小,特別是在 PolitiFact 數據集中,如圖 4a 所示。 此外,GossipCop 數據集比 PolitiFact 數據集相對更不穩定,如圖 4b 所示。 這可能歸因于 GossipCop 中語義的復雜性,這也導致所有模型的 F1 分數和準確性較低。

多模態融合策略

附錄C:CLIP 與預訓練單模態模型進行特征提取的比較

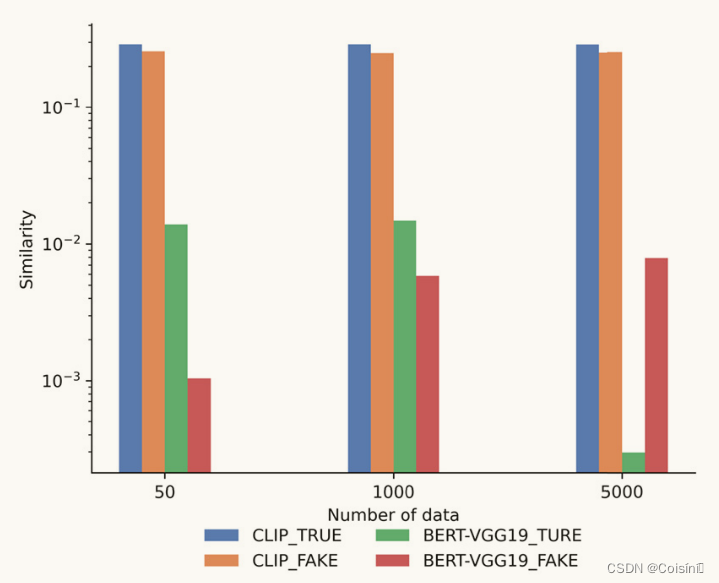

圖 7. 預訓練模型之間的對數尺度語義相似度比較。

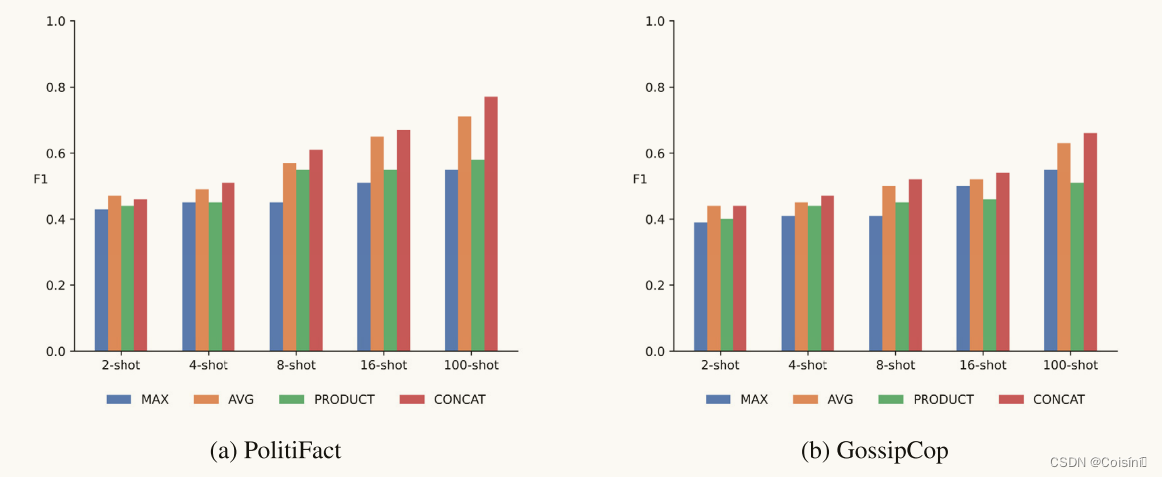

圖 5. 不同多模態融合策略的比較。

如圖5所示,我們使用M-SAMPLE來評估各種多模態融合方法對模型性能的影響。 具體來說,比較了四種基于規則的融合策略 [1] 的 F1 分數。 利用基于規則的融合策略背后的動機植根于 CLIP 模型在單模態特征之間生成有效時間對齊的能力 [47],如附錄 C 所示。具體來說,符號“MAX”表示使用 最大池化層。 類似地,“AVG”表示通過平均池化層進行融合。 另一方面,“PRODUCT”表示多模態特征是通過所有單模態特征的元素乘積形成的。 最后,“CONCAT”意味著將單模態特征串聯起來以創建多模態特征。 結果表明,在少樣本設置中,與其他融合策略相比,兩個單模態特征的串聯可以產生更好的 F1 分數。

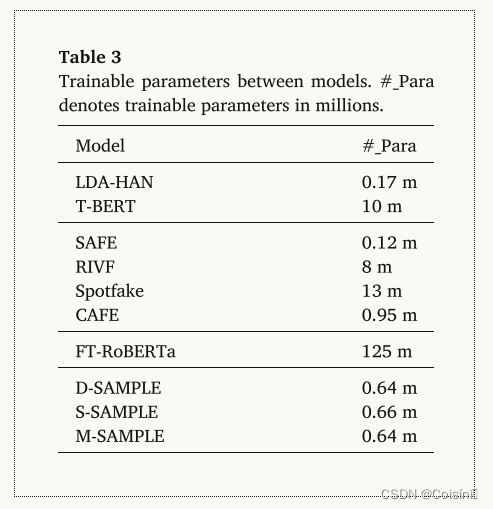

可訓練參數比較

我們比較了基線和 SAMPLE 之間的可訓練參數數量,如表 3 所示。SAMPLE 框架中的可訓練參數相當小,大部分來自語言器和模板。 相比之下,當對整個模型進行完全微調時,FT-RoBERTa 具有最多數量的可訓練參數。 因此,與微調相比,即時學習需要更低的計算成本,同時仍能獲得與其他深度學習方法相當的結果。

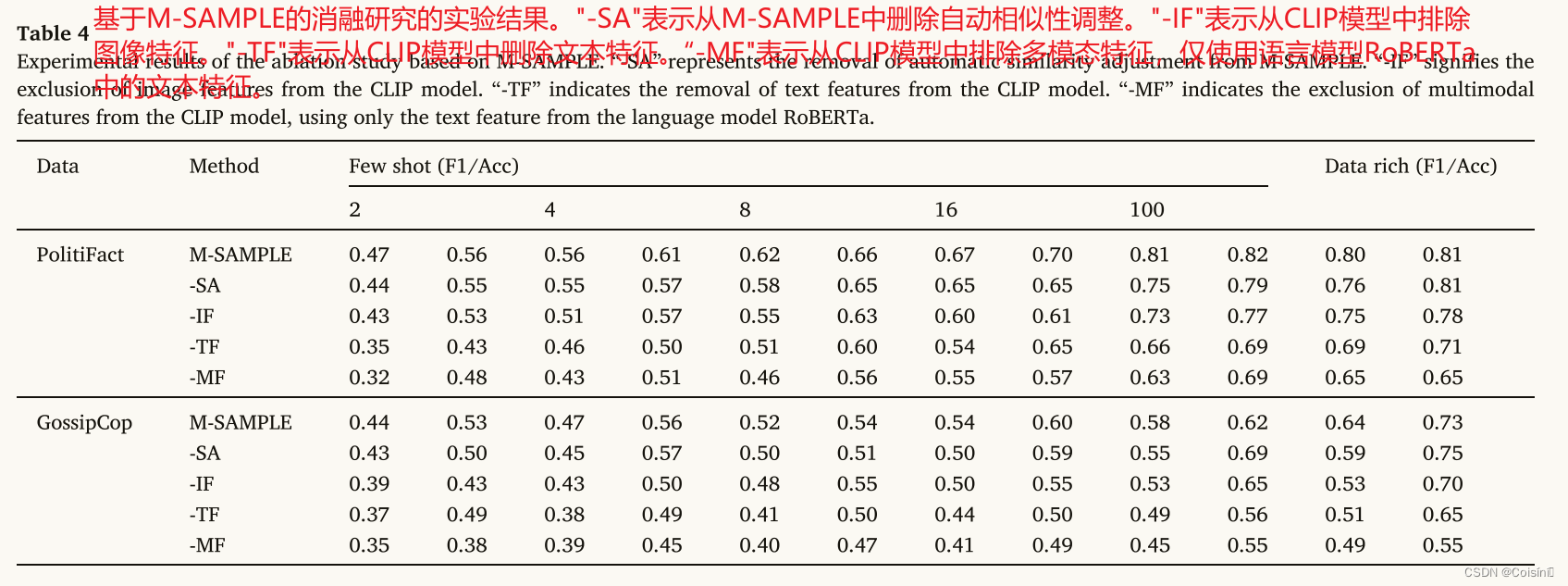

消融實驗

我們通過評估 SAMPLE 框架在各種部分配置下的性能來檢查 SAMPLE 框架中關鍵組件的影響。 我們采用 M-SAMPLE,在每次測試中刪除不同的組件,并從頭開始訓練框架。 表 4 中的結果表明,當在大多數測試設置中移除 M-SAMPLE 的任何組件時,M-SAMPLE 的性能會下降。 這表明了 SAMPLE 中每個單獨關鍵模塊的有效性。 具體來說,我們發現當刪除自動相似性調整“-SA”時,性能略有下降。 這一觀察結果凸顯了在多模態特征融合中標準化語義相似性的重要性。 這樣做有助于減少假新聞分類中的不相關信息,同時還可以減輕不同模態的多模態特征帶來的噪音。

此外,與在框架內刪除圖像特征(“-IF”)相比,從 CLIP 中刪除文本特征(“-TF”)通常會導致 F1 分數和準確性較低。 我們的研究結果表明,雖然圖像模態被證明在 FND 中很有價值,如圖 3 所示,但值得注意的是,文本特征在提示學習過程中仍然至關重要。 這主要是由于提示學習的訓練目標,其重點是從模板中恢復屏蔽標記。 該目標主要與從預訓練模型中提取的文本特征保持一致并利用。 從不同的預訓練模型 RoBERTa 和 CLIP 中提取兩個文本特征,為分類器提供了更加多樣化和更具表現力的文本信息。 另一方面,圖像特征的主要作用是最小化不同模態之間的差異可能產生的噪聲。

當從 CLIP 模型獲得的融合多模態特征(“-MF”)被刪除時,所提出的框架歸結為提示學習方法的普通版本,該方法利用預先訓練的語言模型來直接預測 FND。 分析結果表明,即使是基本的提示學習方法也可以優于僅依賴文本特征的單模態方法。 這一觀察結果強調了 FND 中提示學習的優越性。

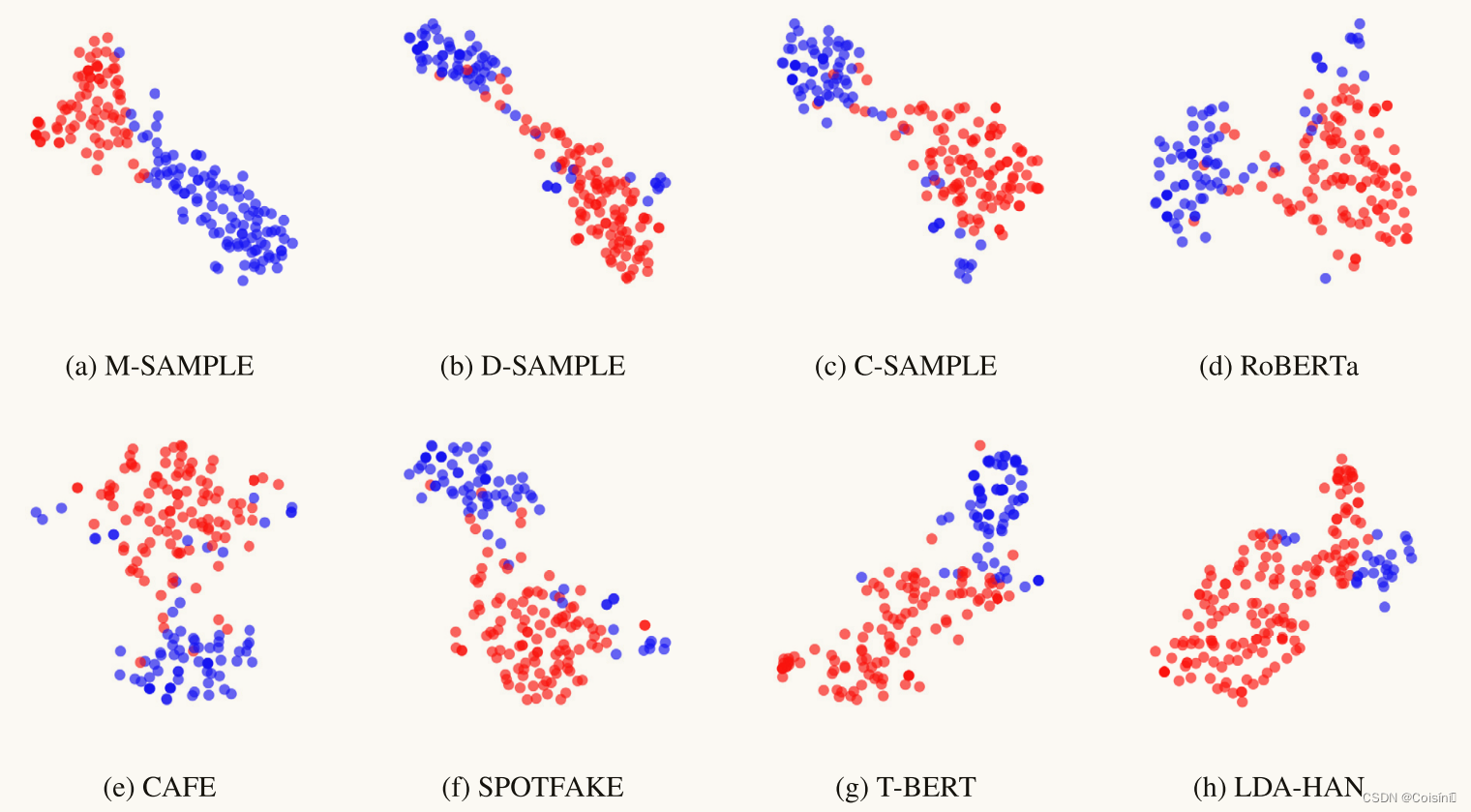

T-SNE可視化

圖 6. 在分類器之前從 M-SAMPLE、D-SAMPLE、C-SAMPLE、RoBERTa、CAFE、SPOTFAKE、T-BERT 和 LDA-HAN 在 2-PolitiFact 測試集上學習的特征的 T-SNE 可視化2-shot設置。

如圖 6 所示,在 2-shot 設置的 PolitiFact 測試集上分析了分類器之前學習到的特征。假新聞和真實新聞的降維特征表示由紅點和藍點表示。 從圖 6a、圖 6b 和圖 6c 中,我們注意到與 D-SAMPLE 和 C-SAMPLE 相比,M-SAMPLE 的邊界似乎更加清晰。 這表明 M-SAMPLE 中學習到的特征表示更具辨別力。 雖然 FT-RoBERTa 在 F1 和準確度方面表現出相當的性能,但它確實在 2-shot 設置中顯示了一些明顯的錯誤分類實例。 此外,與 SAMPLE 相比,FT-RoBERTa 中學習到的特征表示往往更稀疏,如圖 6d 所示。 這意味著在少樣本場景中,多模態特征和即時學習方法的組合優于標準微調方法。 我們還可視化了 CAFE 和 SPOTFAKE 的特征表示,如圖 6e 和圖 6f 所示。 分析表明,與即時學習和微調方法相比,錯誤分類實例的數量明顯更高。 此外,我們的研究結果表明,T-BERT 和 LDA-HAN 等單峰方法表現出最多的錯誤分類實例。 這表明,與僅依賴文本特征相比,結合多模態特征可以捕獲更具表現力的信息,如圖 6g 和圖 6h 所示。

Discussion

所提出的 SAMPLE 框架將多個提示學習模板與軟語言器集成在一起,以便能夠在少量樣本和數據豐富的環境中自動檢測假新聞。 首先,本節首先分析我們的方法與現有研究之間的關系。 接下來,我們詳細闡述所提出的 SAMPLE 方法如何對 FND 領域產生積極影響并為實際應用提供支持。 最后,本文討論了我們方法的局限性,并概述了未來工作的潛在途徑。

與前人作品的聯系和比較

無論是在少量樣本還是數據豐富的場景中,SAMPLE 在檢測假新聞方面都表現出了令人滿意的性能。 當將SAMPLE與FND領域的其他方法進行比較時,傳統方法可以分為三類:(1)僅基于文本或圖像特征的單模態方法[6,8]; (2)通過預訓練模型或深度學習表示來同化文本和視覺特征的多模態方法[44]; (3)標準微調方法,使用特定任務的數據微調預先訓練的單峰模型[33]。

在本研究中,SAMPLE 包含 (2) 和 (3) 的混合方法。 然而,由于它利用了提示學習算法,因此它與標準微調方法不同。 盡管微調有可能實現最佳性能,但它會消耗大量內存。 這是因為微調會更新整套模型參數,以滿足特定任務的目標。 相比之下,提示學習利用自然語言提示來查詢語言模型,保持了與預訓練類似的目標,同時顯示出可比較的性能,特別是在有限的訓練實例中。 通過將標準微調的結果與SAMPLE的結果進行比較,實驗結果證實了上述推理,如表2所示。

先前的多模態方法,例如 CAFE 和 SAFE,依賴于外部跨模態模塊來對齊和測量不同的單模態特征。 然而,此類外部模塊需要足夠數量的訓練實例來捕獲跨模態相關性,這通常會導致性能不足,特別是在少數樣本設置中。 我們的新穎提案引入了一種相似性感知的多模態特征融合方法,該方法利用了 CLIP 的預訓練策略。 CLIP 利用大量圖像-文本對來學習多模態語義的集成。 此外,跨模態特征相關性的標準化結合了 Sigmoid 函數來確定文本和圖像輸入之間的語義相似性。 進行了消融研究,以研究我們在少樣本設置中的方法,如表 4 所示。結果清楚地表明少樣本性能的顯著改善,這歸因于提示學習和所提出的相似性感知多模態融合過程的結合。

對未來研究的貢獻

我們引入了一種新穎的 FND 框架 SAMPLE,用于通過提示學習來識別假新聞。 盡管提示學習在眾多分類任務中表現出了高性能,但不同提示策略與多模態特征的集成仍有待探索。 本文提出了一種有前途的方法,該方法取得了令人印象深刻且穩健的結果,并且可以作為多模式 FND 未來研究的重要基線。

傳統的多模態 FND 系統通常需要大量的訓練數據才能達到令人滿意的性能水平。 然而,在現實環境中獲取帶注釋的數據具有挑戰性。 本文證明 SAMPLE 提供了可比較的結果,特別是在少數樣本場景中,表明其在現實情況下檢測假新聞的能力。 此外,所提出的將相似性感知多模態特征與提示學習相融合的方法對于未來類似性質的分類任務具有潛力。

局限性和未來的工作

本研究有幾個局限性。 首先,SAMPLE 主要關注研究軟語言表達器的效果,該語言器旨在自動從詞匯表中識別適當的標簽詞。 然而,在低數據條件下優化更廣泛詞匯量的軟語言器仍然是一個相當大的挑戰。 這表明需要額外的自適應修改來提高整體性能。 其次,新提出的基于相似性感知策略的多模態融合方法,旨在減少相關性較弱的跨模態特征中的噪聲注入。 它沒有明確考慮不相關的跨模態關系。 第三,仍然需要進一步探索包含不同模式的多模態FND 方法,例如新聞實體和社交網絡。

多項研究表明,語言表達者的選擇對表現有很大影響。 手動語言器[38]尤其依賴于特定于任務的先驗知識,并且需要大量的勞動來識別代表類別的標簽詞。 另一方面,盡管軟語言器[12]旨在簡化這一過程,但在低數據環境中針對大詞匯量有效優化它仍然具有挑戰性。 此外,知識豐富的提示調整方法[17]利用外部知識庫來擴大標簽詞的覆蓋范圍,并減少與手動語言器相關的偏差。 研究不同言語者的影響將是我們未來工作的一部分。 此外,整合新聞實體、主題和社交網絡等其他模式有可能在未來進一步擴展多模態融合方法。

Conclusion

本文提出了一種新穎的相似性感知多模態 FND 框架,名為 SAMPLE,它利用提示學習。 為了緩解數據不足的問題,SAMPLE 對原始輸入文本結合了三種流行的提示模板:離散提示、連續提示和混合提示。 采用預訓練的語言模型 RoBERTa 從提示中獲取文本特征。 此外,使用預訓練的 CLIP 模型來獲取輸入文本、圖像及其語義相似度。 為了解決語義差距并改善圖像和文本模態之間的協作,我們引入了一種相似性感知的多模態特征融合方法,該方法應用標準化和 Sigmoid 函數來調整最終跨模態表示的強度。 最后,將多模態特征輸入全連接層來投影并獲得與特定新聞類別相對應的詞分布。

我們在兩個基準數據集上進行了多模態 FND 實驗來評估所提出的方法。 SAMPLE 的性能與單模態、多模態和標準微調方法進行了廣泛的比較。 我們的實驗結果表明,無論是少量樣本還是數據豐富的設置,SAMPLE 的性能都優于以前的方法。 此外,我們的結果表明,盡管圖像模態提供了有意義的信息,但不相關的跨模態特征會對 FND 性能產生負面影響,特別是當訓練實例數量有限時。 此外,我們方法的每個組成部分,特別是標準化的多模態特征融合模塊,有助于來自預訓練模型的單模態特征更有效地協作,挖掘 FND 的關鍵特征。

我們評估了來自各種預訓練模型的文本和圖像特征之間的語義相似性。 具體來說,我們應用 BERT 模型和 VGG-19 從每個訓練樣本中提取特征。 隨后,計算平均相似度分數,以評估真實新聞和假新聞之間的語義相似度。 類似地,我們使用 CLIP 文本轉換器和視覺轉換器來提取單峰特征并計算它們的語義相似度。 我們還增加了樣本數量來觀察語義相似度的任何變化。 最后,為了準確地表示單峰模型之間的微小差異,我們對軸上的值進行對數縮放。

我們的實驗結果表明,與從單模態模型獲得的文本和圖像特征相比,從 CLIP 模型提取的文本和圖像特征表現出更高的一致性,如圖 7 所示。這可以歸因于 CLIP 通過聯合訓練和學習多模態表示的能力。 它利用對比損失函數,有助于區分相關對和不相關對。 結果,無論樣本數量多少,真實新聞(CLIP_TRUE)的語義相似度始終高于假新聞(CLIP_FAKE)。 相比之下,BERT-VGG19組合分別從文本和圖像中提取特征,這可能會在特征提取過程中引入更多噪聲。

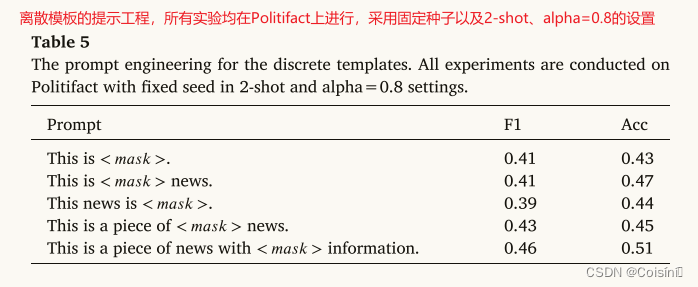

附錄A:離散模板的提示工程

為了評估各種模板對性能的影響,我們創建了離散模板,如表 5 所示。由于即時工程涉及的時間和成本,我們在本文中將我們的研究限制為僅五個離散模板。 隨后,我們選擇獲得最高 F1 分數的離散模板作為我們實驗中的最終模板。

附錄B:連續模板的不同初始化方法的比較

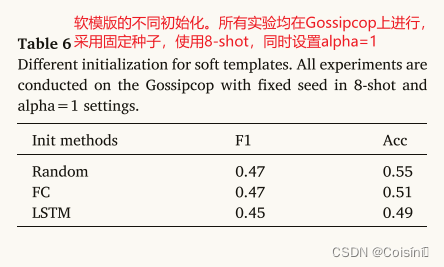

該研究比較了連續模板中<𝑠𝑜𝑓𝑡>標記的三種初始化方法,如表6所示。“隨機”初始化方法即隨機初始化<𝑠𝑜𝑓𝑡>標記。“FC”方法用另一個可訓練矩陣重新參數化 <𝑠𝑜𝑓𝑡 > 標記,并通過 FC 層向前傳播它[25]。“LSTM”方法通過 LSTM 層提供 < 𝑠𝑜𝑓𝑡 > token,并將輸出用作可訓練向量 [28]。盡管三種初始化方法在 F1 和精度方面的表現略有不同,但研究還觀察到,與“隨機”初始化相比,“FC”和“LSTM”初始化導致驗證損失較晚收斂。 這是由于需要額外的訓練來獲得 < 𝑠𝑜𝑓𝑡 > 向量。

![洛谷 AT_abc169_d [ABC169D] Div Game 題解](http://pic.xiahunao.cn/洛谷 AT_abc169_d [ABC169D] Div Game 題解)

2024真題目錄(全、新、準))