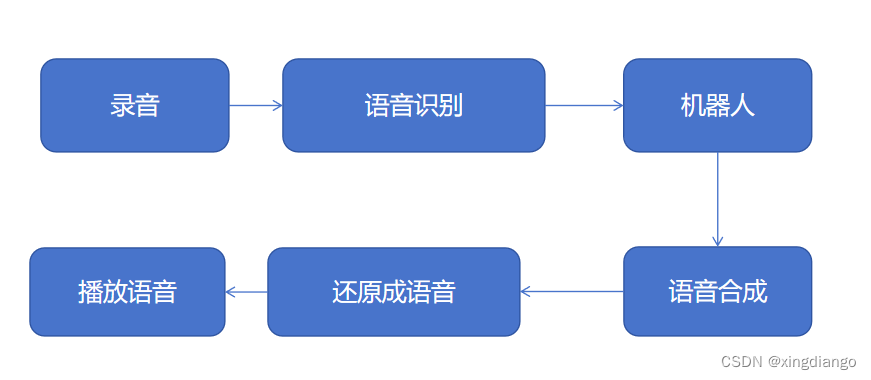

想要做一款能通過語音識別來聊天的智能機器人,首先需要能通過麥克風錄制語音進行識別轉換成文字,將文字發送給機器人得到聊天結果,并能將返回的文字轉換成語音進行合成,之后再通過本地播放語音實現語音交互。

架構:

實現步驟

一、本地錄音

本地錄音可以通過pyAudio庫實現語音錄制。

音頻采樣率

音頻采樣率是指在一秒鐘內對聲音進行采樣的次數。采樣率越高,音頻質量就越好。常見的音頻采樣率是44.1kHz和48kHz。

音頻位深度

音頻位深度是指存儲每個采樣的精度。位深度越高,音頻質量就越好。常見的位深度是16位和24位。

音頻通道數

音頻通道數是指記錄音頻信號的通道數。單通道(單聲道)音頻只有一個通道,雙通道(立體聲)音頻有兩個通道,多通道音頻有超過兩個通道。

PyAudio API

PyAudio的API定義了一組函數和常量,可用于錄制、播放和處理音頻數據。以下是一些重要的函數和常量:

pyaudio.PyAudio()

這是一個構造函數,用于創建一個PyAudio實例。可以使用這個實例來訪問其他PyAudio函數。

pyaudio.paInt16

這是一個常量,代表16位音頻數據類型。您可以使用其他常量來指定不同的音頻數據類型。

pyaudio.paFloat32

這是一個常量,代表32位浮點數音頻數據類型。這種數據類型通常用于音頻信號處理。

PyAudio.open()

這個函數用于打開音頻流。它返回一個PyAudio的流對象。

stream.read()

這個函數用于從音頻流中讀取數據。

stream.write()

這個函數用于將數據寫入音頻流。

import requests

import pyaudio

import wavedef record_human_voice():chunk = 1024FORMAT = pyaudio.paInt16CHANNELS = 2RATE = 44100RECORD_SECONDS = 5WAVE_OUTPUT_FILENAME = "output.wav"p = pyaudio.PyAudio()stream = p.open(format=FORMAT,channels=CHANNELS,rate=RATE,input=True,frames_per_buffer=chunk)print("開始錄音:")frames = []for i in range(0, int(RATE / chunk * RECORD_SECONDS)):data = stream.read(chunk)frames.append(data)print("錄音結束。")stream.stop_stream()stream.close()p.terminate()wf = wave.open(WAVE_OUTPUT_FILENAME, 'wb')wf.setnchannels(CHANNELS)wf.setsampwidth(p.get_sample_size(FORMAT))wf.setframerate(RATE)wf.writeframes(b''.join(frames))wf.close()if __name__ == '__main__':record_human_voice()本地錄音結束后,可以在本地項目目錄下生成一個output.wav語音文件,可以通過本地播放器嘗試打開播放,是否為本人錄制視頻。另外,需要注意,需要打開windows聲音模塊的麥克風錄制開關,否則不能成功執行。

二、語音播放

可以使用wav