摘要:阿里巴巴開源通義萬相Wan2.1模型,支持文生視頻、圖生視頻等多種功能,并整合關鍵環節簡化創作流程。官方和Kiji版本需配套使用各自工作流。低顯存顯卡可使用GGUF模型解決方案,最低適配4G顯存。ComfyUI已原生支持該模型,Kiji版本需額外插件。本文詳細介紹模型下載與工作流應用基礎知識,文中提供所用模型的國內網盤下載鏈接。

———————————————————————————————————————————

? ? 2025年5月,阿里巴巴正式開源通義萬相Wan2.1-VACE模型,Wan2.1模型同時支持文生視頻、圖像參考視頻生成、視頻重繪、視頻局部編輯、視頻背景延展以及視頻時長延展等多種生成和編輯能力,并且將生成與編輯的眾多關鍵環節整合,極大地簡化了創作流程,提升了創作效率。

? ? 萬相2.1模型可以在comfyui上自由調用,同時支持文生視頻、圖生視頻和視頻生視頻等功能,開源社區還有很多適配wan2.1的lora,視頻生成的效果也越來越好。

1 原生節點與模型

1.1 插件安裝

? ? comfyui官方在通義萬相模型發布后第二天即集成了對wan2.1模型的原生支持,無需額外插件,將comfyui內核更新至最新版本即可。

? ? 另外目前在各大平臺常見的還有kiji發布的wan2.1模型與工作流,但是需要注意的是:Kijai版本的模型與ComfyUI官方版本不兼容,需要各自分開配合對應工作流才能使用。即使用comfyui原生節點,無需安裝額外插件,使用wan2.1官方版本模型即可;使用kiji模型,需要使用對應的插件和節點(插件安裝目錄中提供有示例工作流)。

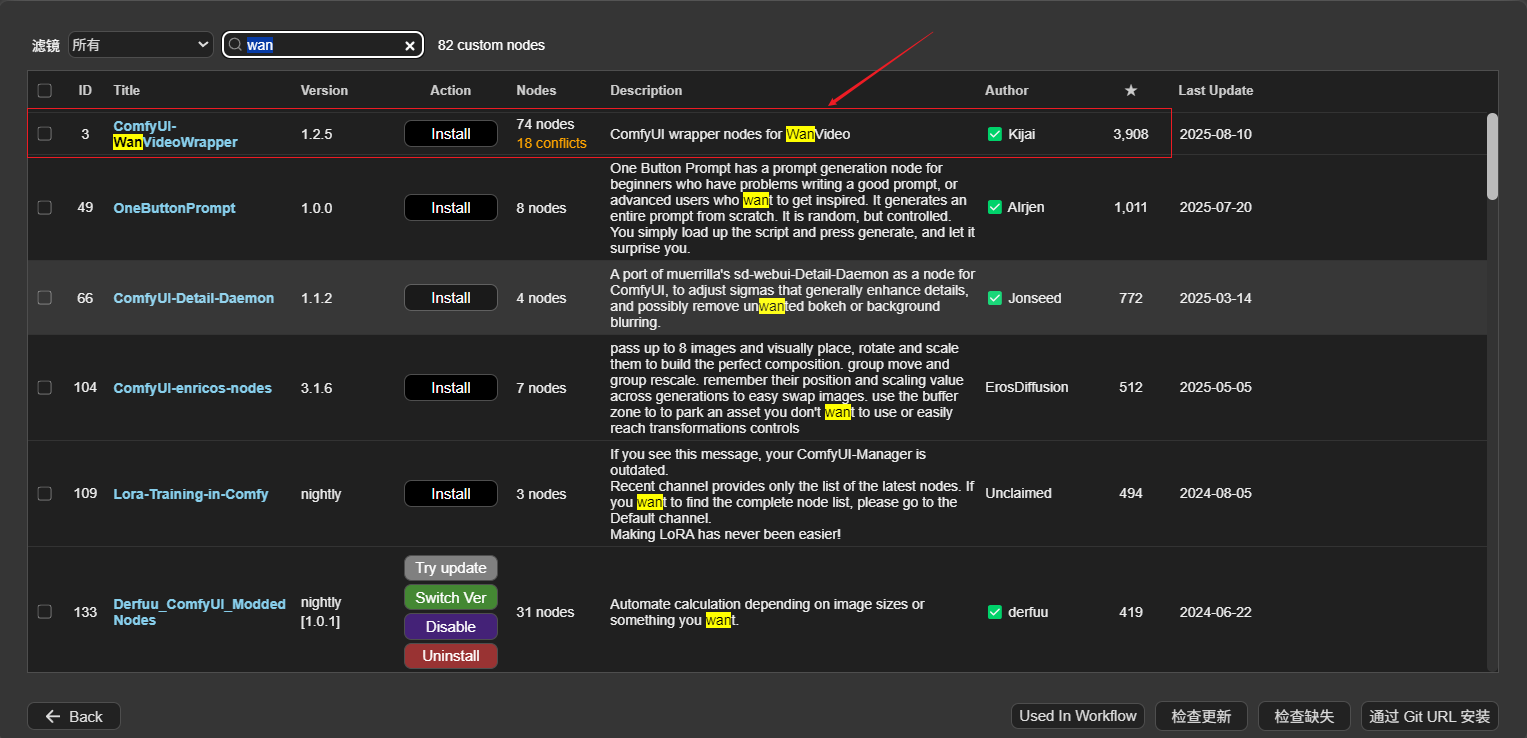

? ? kiji模型適配萬象2.1模型的插件是WanVideoWrapper

? ? 插件地址:https://github.com/kijai/ComfyUI-WanVideoWrapper

? ? wanwideowrapper可以通過管理器直接進行安裝。

1.2 模型下載:

(1)官方模型下載地址:

https://huggingface.co/Wan-AI/models

(2)kiji發布的模型地址:

標準版本:https://huggingface.co/Kijai/WanVideo_comfy/tree/main

fp8版本:https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled/tree/main

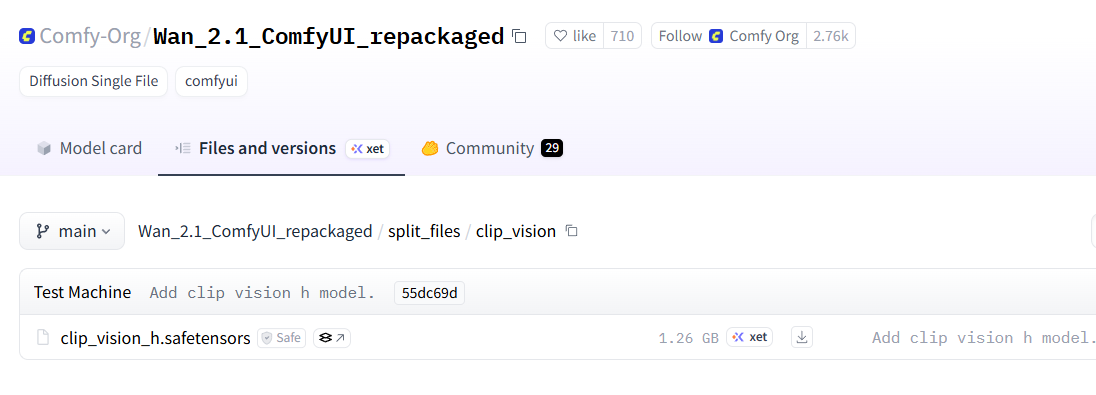

注意:kiji版本模型與工作流需要下載kiji版本的VAE模型、text_encoders模型及clip模型,上述模型均在kiji模型發布頁中,見下圖示例,本節不再詳細說明。

后文以官方版本模型與工作流為例進行演示說明。

1.2.1 wan2.1視頻模型(官方版本)

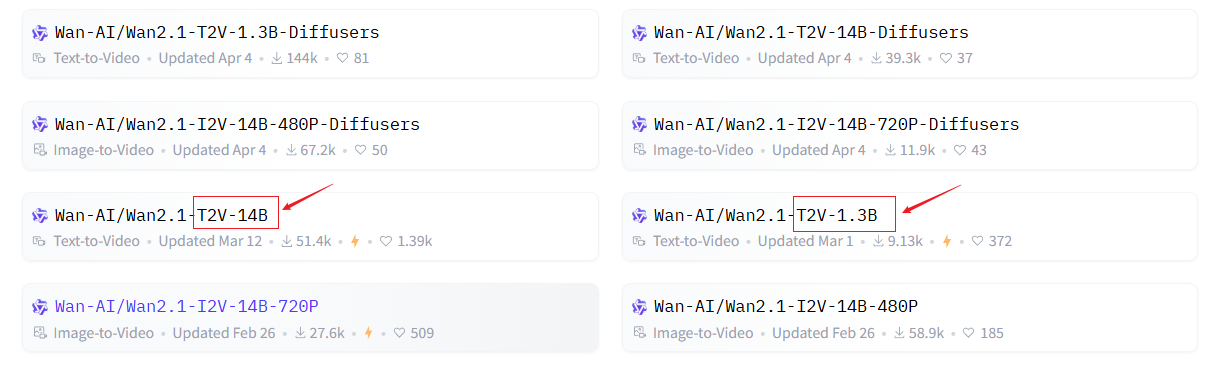

wan2.1模型分為文生視頻(Text to Video)和圖生視頻(image to Video)兩種模型。

(1)文生視頻模型:

分為1.3B和14B兩種版本

1.3B版本可在消費級顯卡運行,最低需要8G及以上顯存,推薦16G以上顯存?,最大支持生成832×480像素視頻。

14B版本需要至少40G顯存的顯卡,適用于A100或H100等專業卡?,支持1280×720像素和832×480像素視頻。

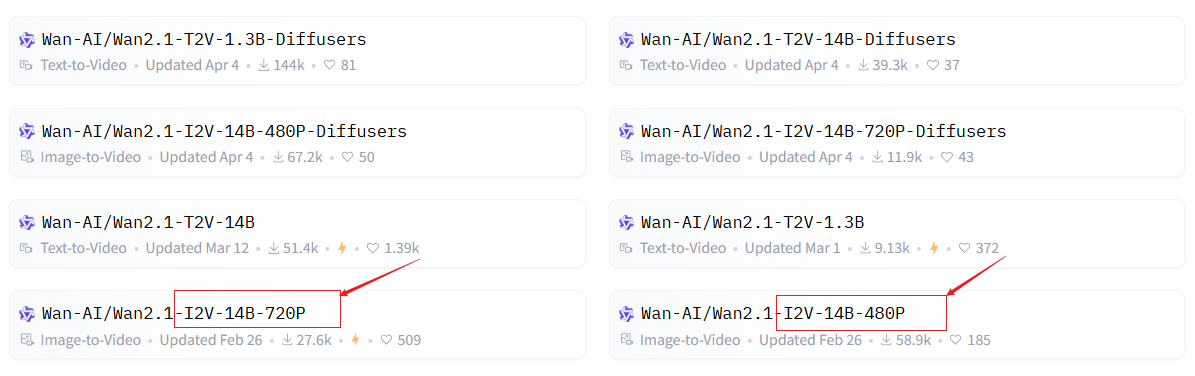

(2)圖生視頻模型:大小都是14B,分為480P和720P兩種分辨率。

480p模型,最大支持生成832×480像素視頻。

720p模型,最大支持生成1280×720像素視頻。

(3)模型選擇

模型放置地址:..\ComfyUI\models\diffusion_models

需要根據電腦顯卡顯存的大小選擇對應版本的模型。

如下載kiji等發布的量化版本模型,推薦使用 fp16 版本而不是 bf16 版本,因為它們會得到更好的結果。質量排名(從高到低):fp16 > bf16 > fp8_scaled > fp8_e4m3fn

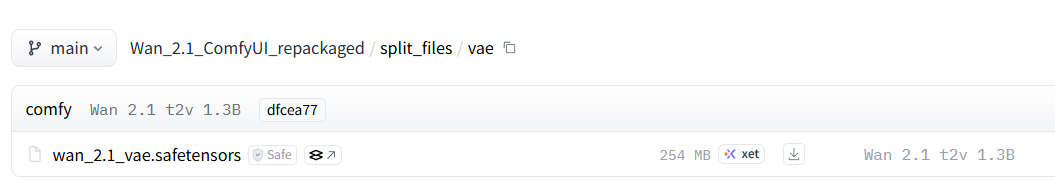

1.2.2 VAE模型(官方版本)

官方版本VAE模型下載地址:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/vae

文件存放目錄:..\comfyui\models\vae

文件存放目錄:..\comfyui\models\vae

1.2.3 Clip模型(官方版本)

官方版本VAE模型下載地址:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/clip_vision

文件存放目錄:..\comfyui\models\clip vision

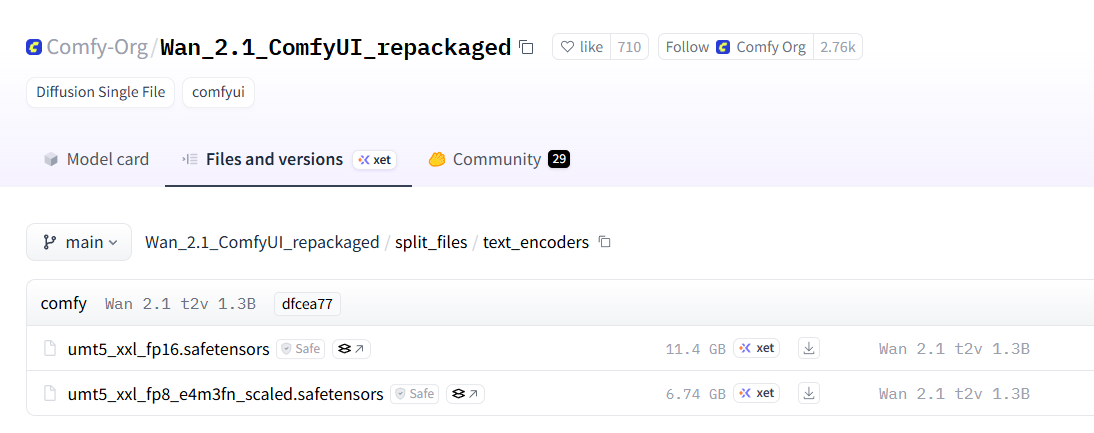

1.2.4 text_encoders模型(官方版本)

官方版本模型下載地址:

https://huggingface.co/Kijai/WanVideo_comfy/tree/main

文件存放目錄:..\comfyui\models\text_encoders

注意:選擇模型時可以嘗試更高的分辨率,但不要過于追求精度,相同分辨率下的fp16與fp8效果差距不明顯,但fp16運行明顯變慢!

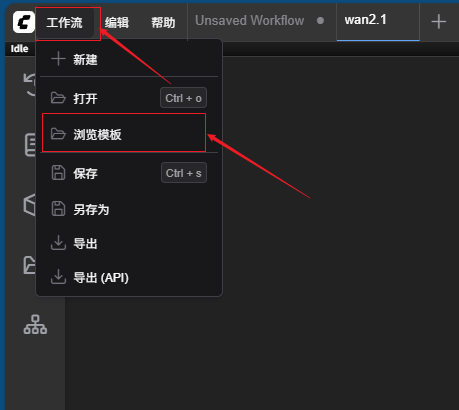

1.3 示例工作流

1.3.1 官方原生版本示例工作流

官方版本的示例工作流,可以在comfyui操作界面中的模板中直接調取,先點擊左上角“工作流”→“瀏覽模版”

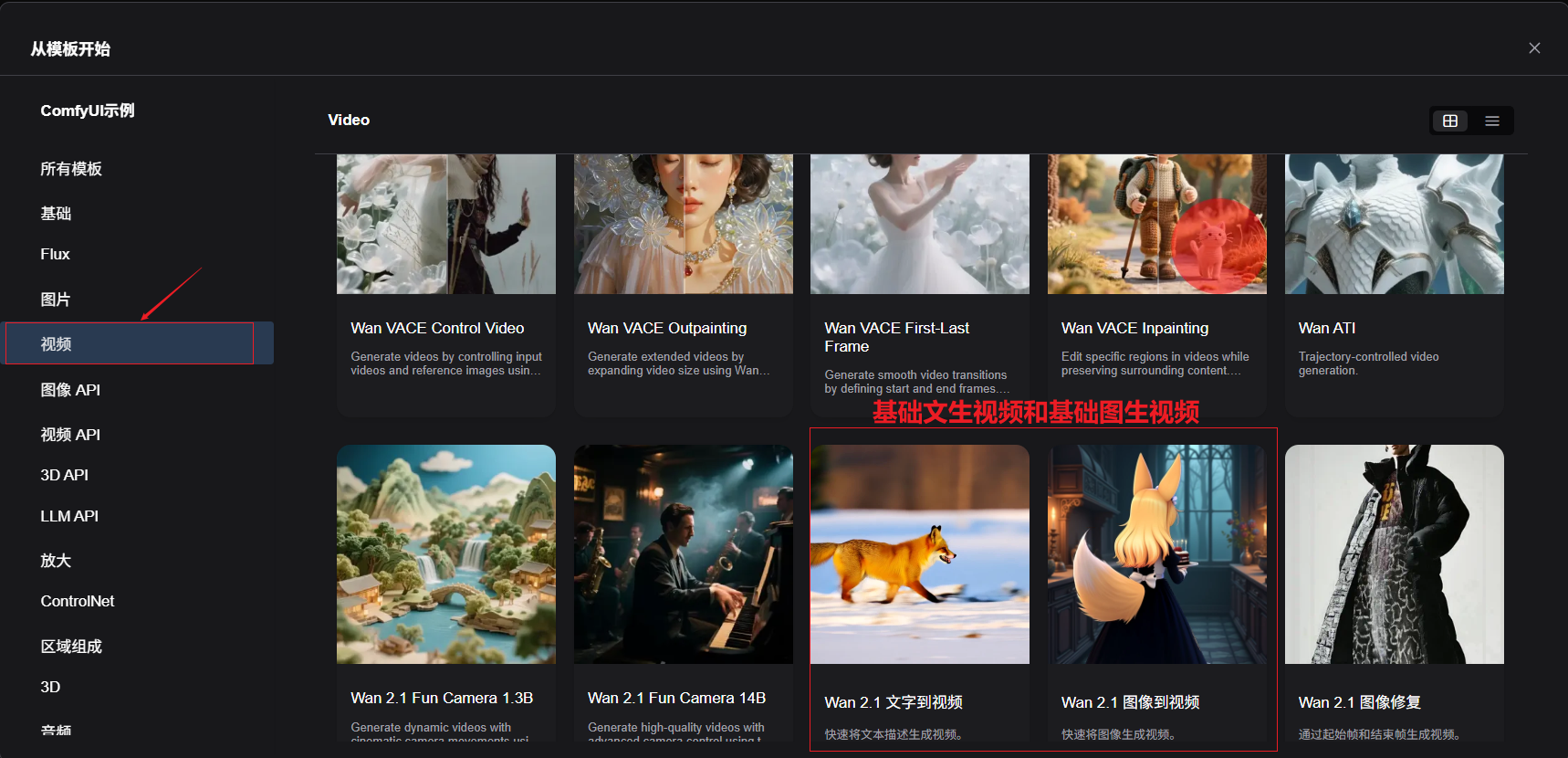

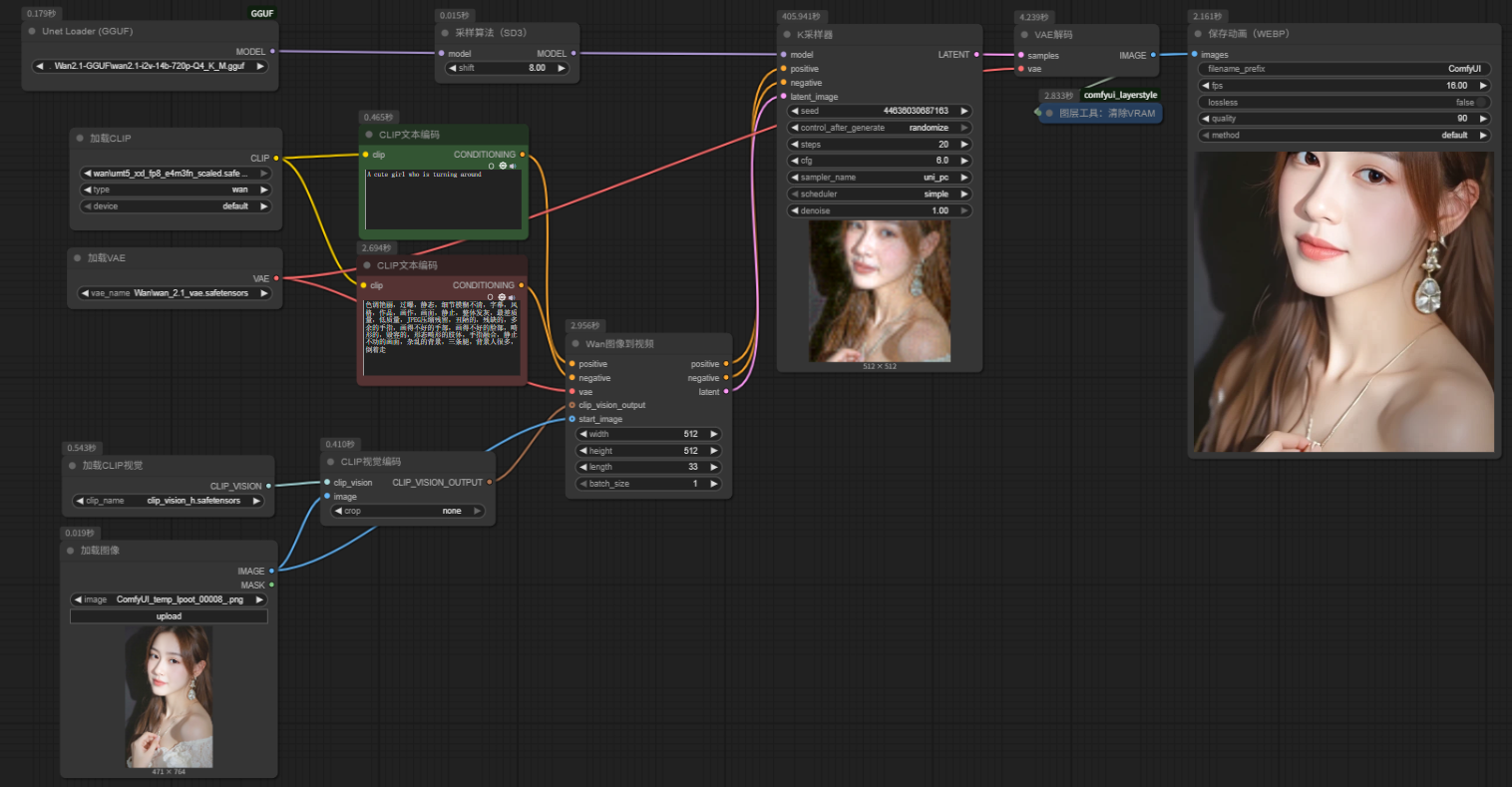

在模版的“視頻”界面中可以找到wan2.1的基礎文生視頻和基礎圖生視頻工作流模板,點擊即可進入編輯頁面。

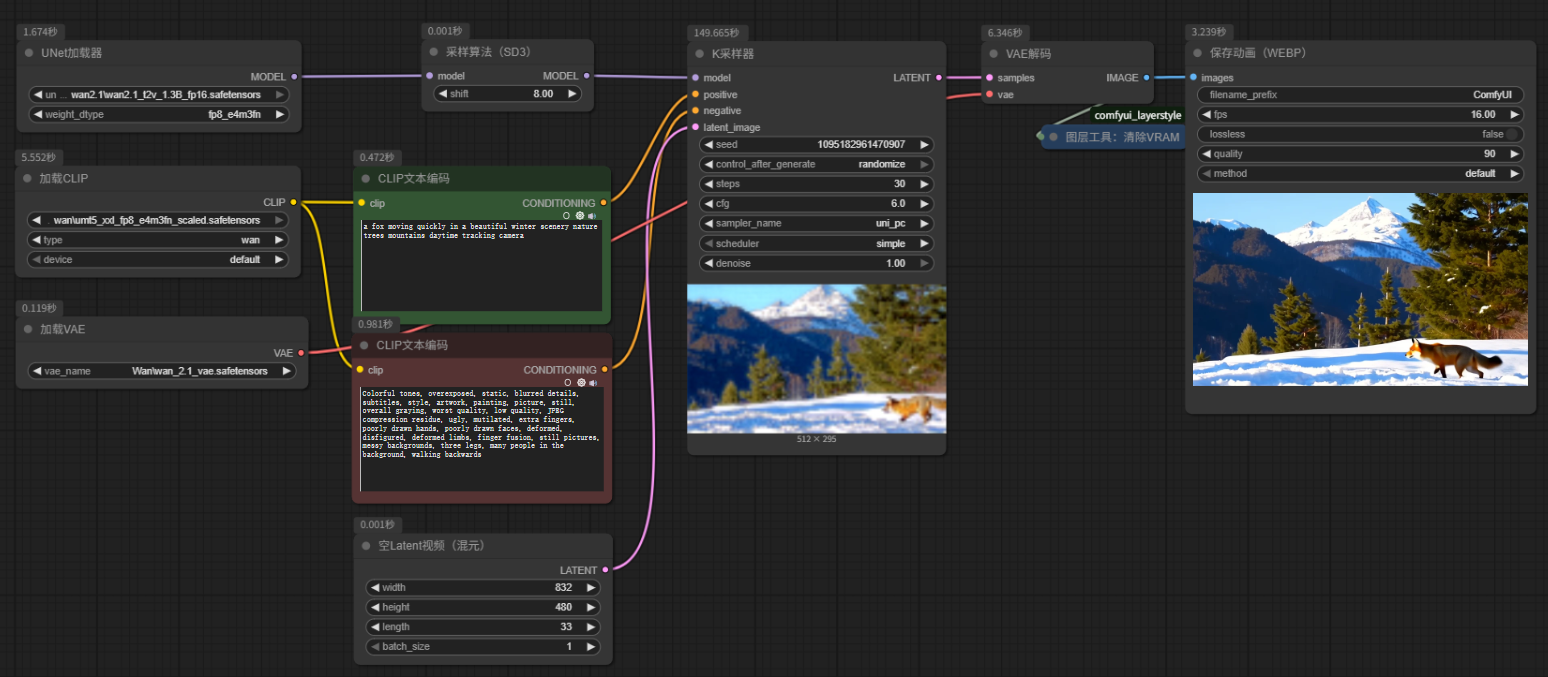

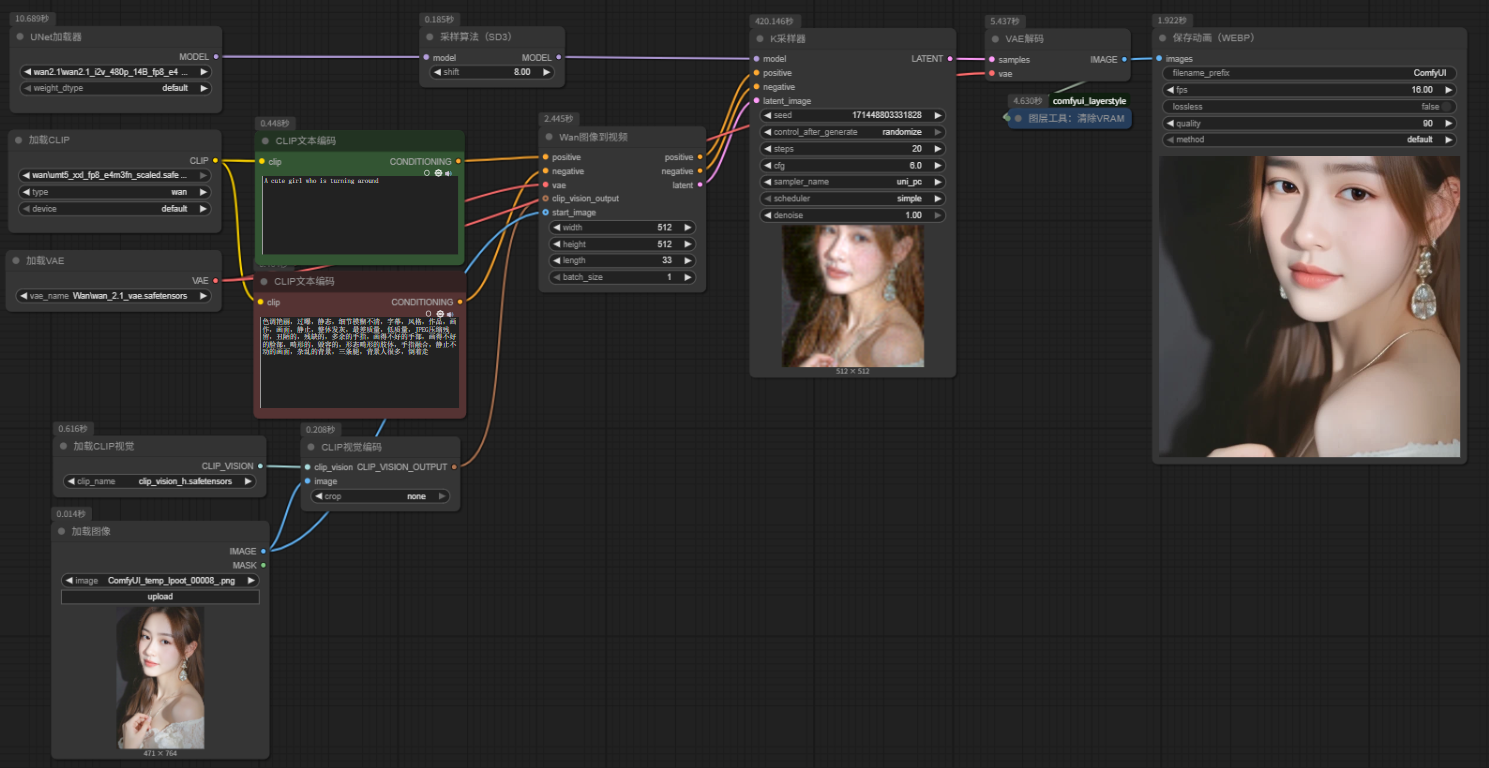

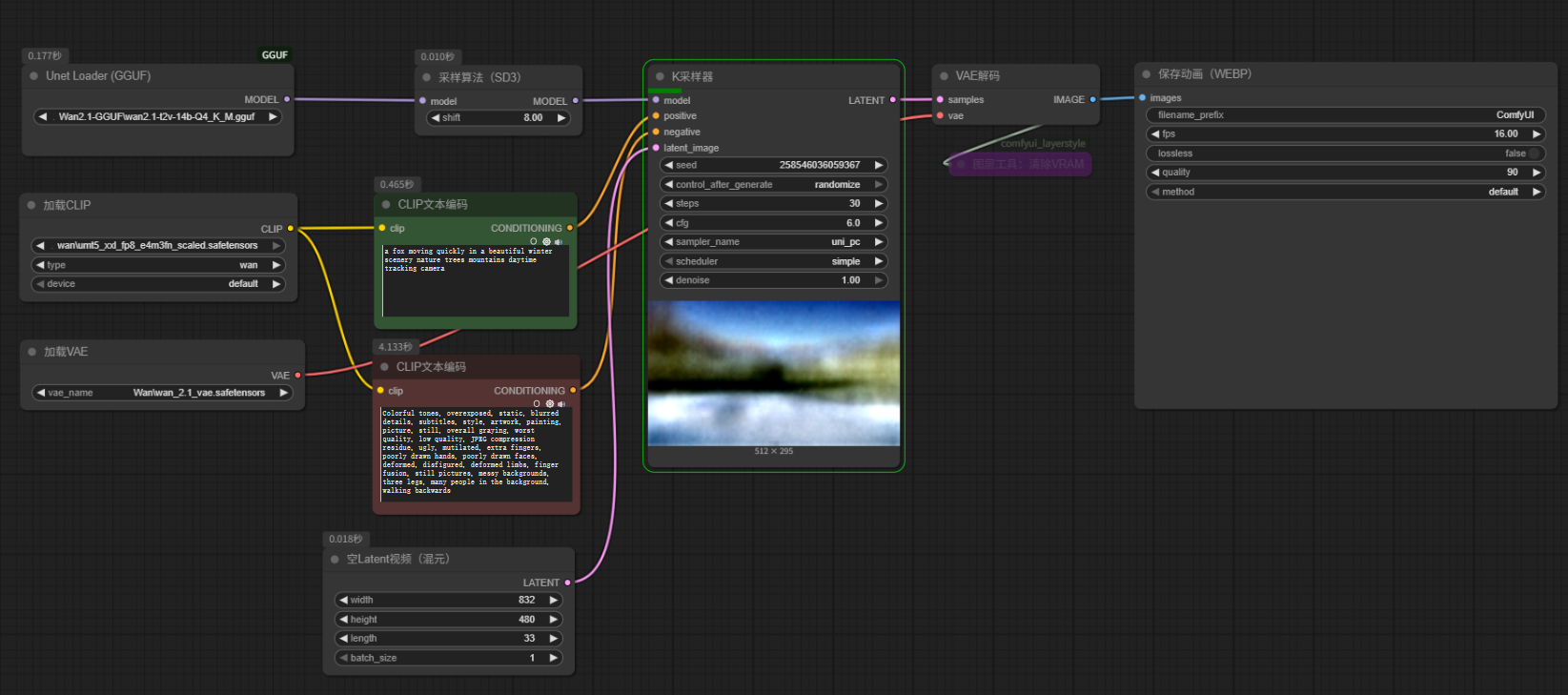

可以看到官方版本的wan2.1文生視頻和圖生視頻工作流都十分簡潔,整體與flux模型的工作流相似,按照這個工作流案例,調換對應的視頻模型即可。

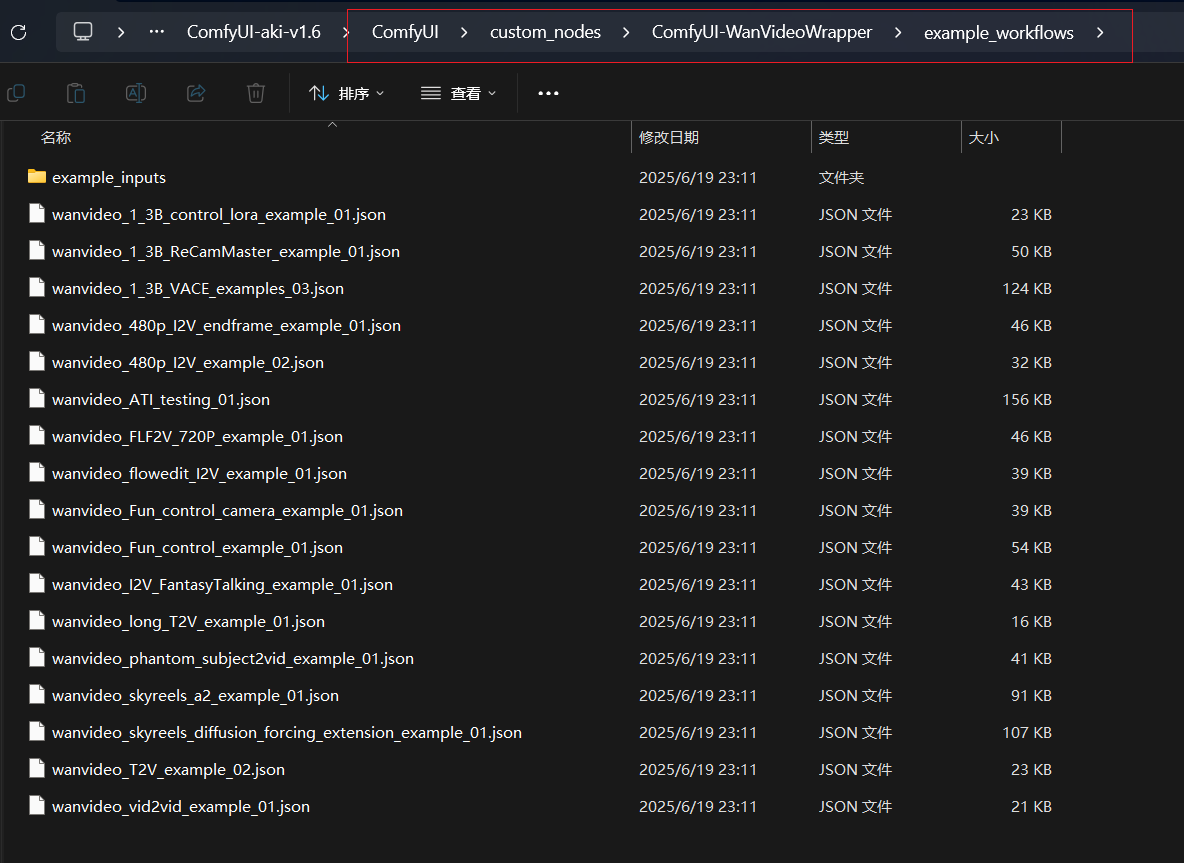

1.3.2 kiji版本示例工作流

kiji版本的示例工作流在WanVideoWrapper插件的安裝目錄中,地址如下:

..\comfyui\custom_nodes\ComfyUI-WanVideoWrapper\example_workflows

打開默認的文生圖工作流,將工作流中的模型全部改變本地模型,然后點擊生成,用默認提示詞生成一段視頻。

2 低顯存顯卡GGUF模型解決方案

低顯存顯卡可以使用GGUF模型,最小可以適配到4G顯存,能在較低的配置資源上完成高質量的VACE視頻生成。

2.1 模型下載

2.1.1GGUF視頻模型

GGUF視頻模型發布頁:

https://huggingface.co/city96/models

UUGF模型放置路徑:..\ComfyUI\models\unet

2.1.2其它模型

GGUF模型在工作流中所需的VAE模型、text_encoders模型及clip模型均與官方版本大模型所使用的配套模型一致,無需額外下載。

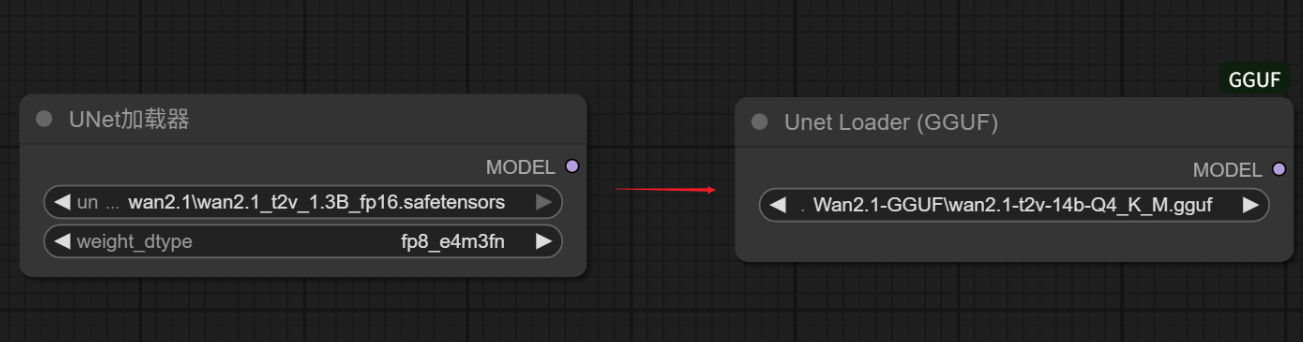

2.2 工作流應用

GGUF的工作流應用也很簡單,僅需將官方基礎工作流中的“UNet加載器”替換為“Unet Loader(GGUF)”,并選擇GGUF版本大模型即可。

———————————————————————————————————————————

說明:文中所有模型已上傳至國內網盤,需要請自行轉存下載:

鏈接:https://pan.quark.cn/s/d2a73d8c9169

? ? 歡迎正在學習comfyui等ai技術的伙伴V加huaqingshan進入學習小組。在這里大家共同學習comfyui的基礎知識、最新模型與工作流、行業前沿信息等,也可以討論comfyui商業落地的思路與方向、實現副業自由。 歡迎感興趣的小伙伴,分享博主自用的comfyui整合包(已安裝超全節點與必備模型)、基礎學習資料、高級工作流等……

? ? 致敬每一位在路上的學習者,你我共勉!Ai技術發展迅速,學習comfyUI是緊跟時代的第一步,促進商業落地并創造價值才是學習的實際目標。

——畫青山學習專欄———————————————————————————————

Webui基礎學習與實操:https://blog.csdn.net/vip_zgx888/category_13020854.html

Comfyui基礎學習與實操:https://blog.csdn.net/vip_zgx888/category_13006170.html

comfyui功能精進與探索:https://blog.csdn.net/vip_zgx888/category_13005478.html

系列專欄持續更新中,歡迎訂閱關注,共同學習,共同進步!

—————————————————————————————————————————

?

)

)

)

)