Bert+ P-tuning

Bert+PET、Bert+P-Tuning

Chain of Thought

Few shot Cot

Auto-COT 解決手動編寫高質量CoT示例麻煩耗時的問題

Auto COT 自動思維鏈生成器

1.業務場景: 每天收到很多反饋,之前需要人工整理,找到重點,做判斷那些需要立即處理,

那些可以 慢慢處理,那些不是問題,希望生成報告

2反饋聚類:

根據這個反饋,看一看提出了哪些方面的問題

3代表性采樣:

從歷史的業務數據中找到每個類別,代表性問題

4.Zero shot Cot 生成分析范例:

把代表性問題丟給大模型,讓他生成思考過程

添加大模型作為裁判

5. 構建最終提示:

將前面的內容拼接 成一個few shot

把拼接好的結果丟給大模型。

比較適合的業務場景:

問題多樣性 要處理的問題是不是高度多樣化,需要考慮不同的維度

是否需要多步復雜推理

示例構建難度 (自己手動寫高質量的COT是不是很耗時間)

是不是總有擴展需求

質量需求(當前任務對結果需求是否很高)

上面幾個問題,有一半以上都跟場景能對得上,就是適合的場景,如果不是,自己寫COT的提示詞模板

速度慢,比較浪費TOKEN

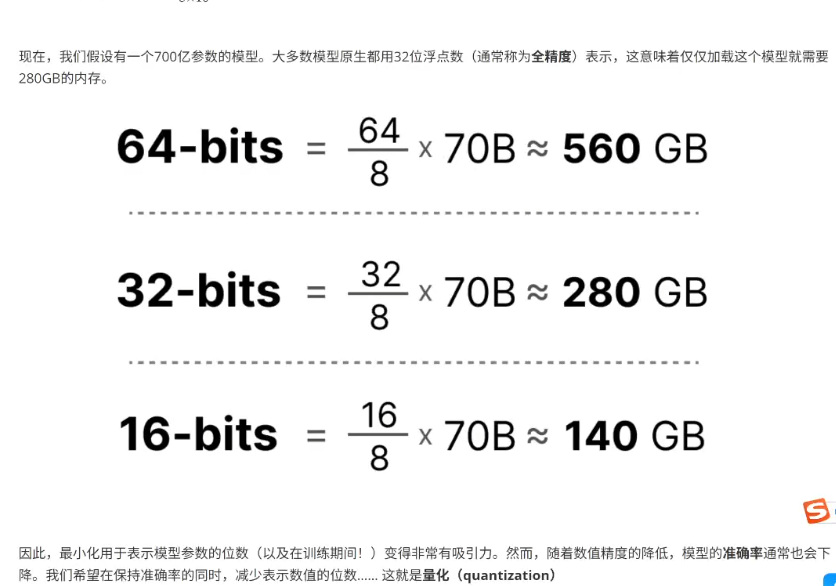

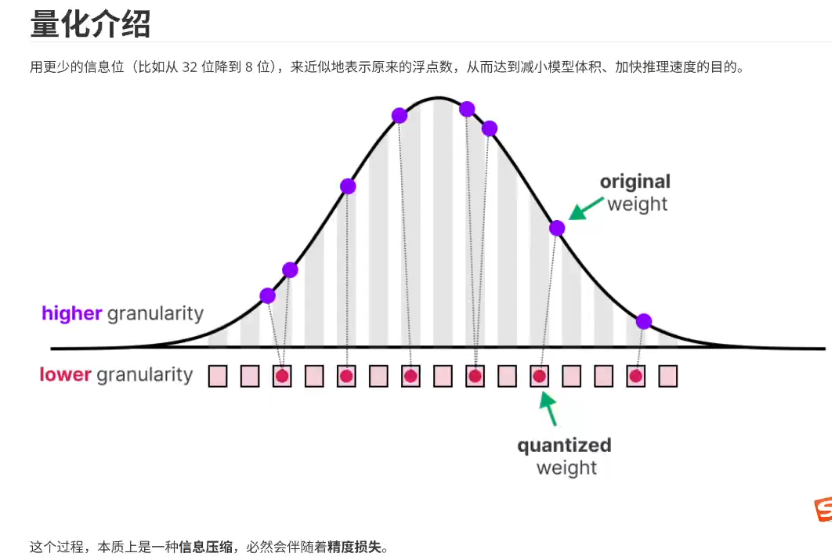

大模型的量化:

H20 8卡 96G 141G

DeepSeek R1 671B FP8訓練的 1B字節對應1G 輸入KV-cache

4090 24G 5090 32G 量化+offload 卸載一部分參數加載到內存中

KTransformer 存內存的方式 GPU+內存

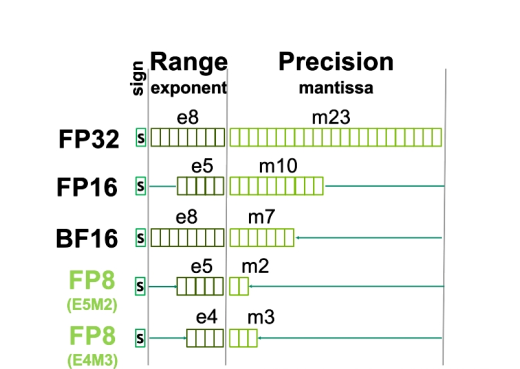

FP64

FP32

FP16、BF16

FP8 FP6 FP4

int8 int4

GGUF

qwen3 8B模型 參數裝進顯卡 FP8 需要多少顯存

FP16, BF16 int8 在各種卡上都能跑的量化方式。

v100 相對便宜一點 32G 5000元

H20 150W

消費級顯卡: 3090 4090 5090 游戲卡

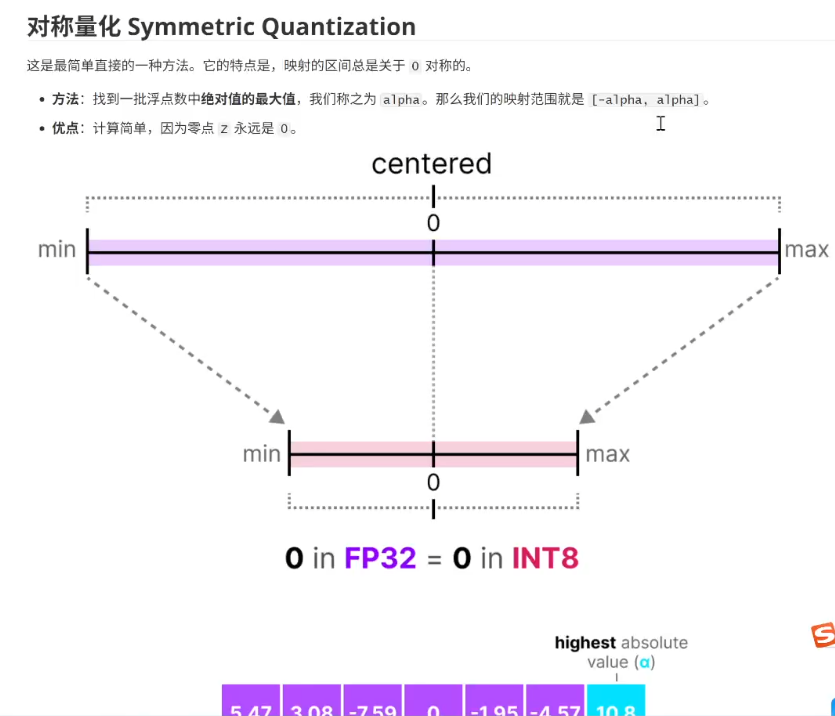

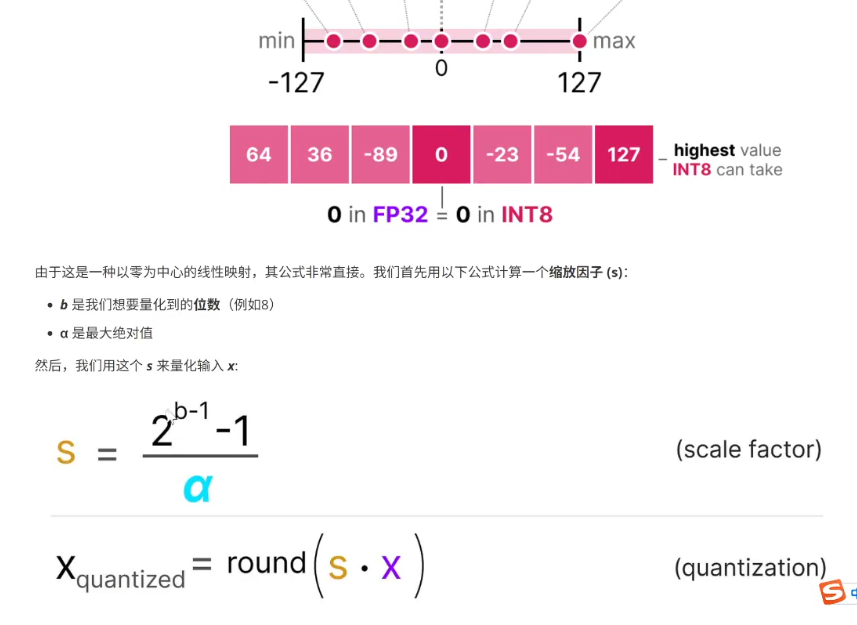

對稱量化

非對稱量化

范圍映射與裁剪 Clipping

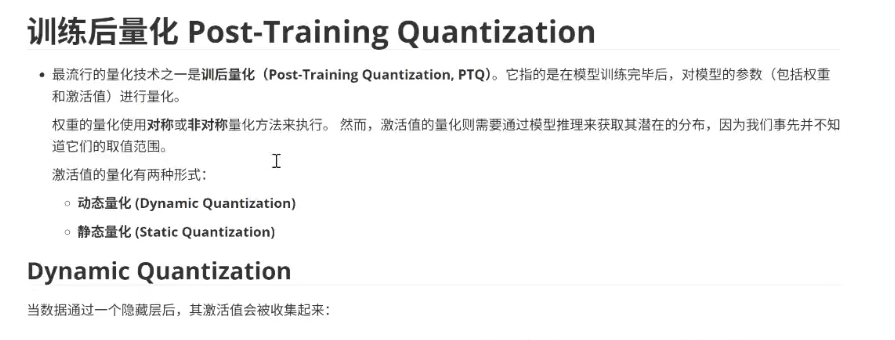

訓練后量化 Post-Training Quantization

然后,這個激活值的分布被用來計算量化輸出所需要的零點(z)和 縮放因子(s)

Dynamic Quantization 動態

Static Quantization 靜態

量化計算方式:

對稱量化

非對稱量化

量化的時機:

訓練后量化:

靜態量化, 激活值通過一組校準數據集,走一遍模型,計算出數據經過每一層的 s 和 z,

把每層的s 和 z都存起來

動態量化:一邊 推理一邊計算

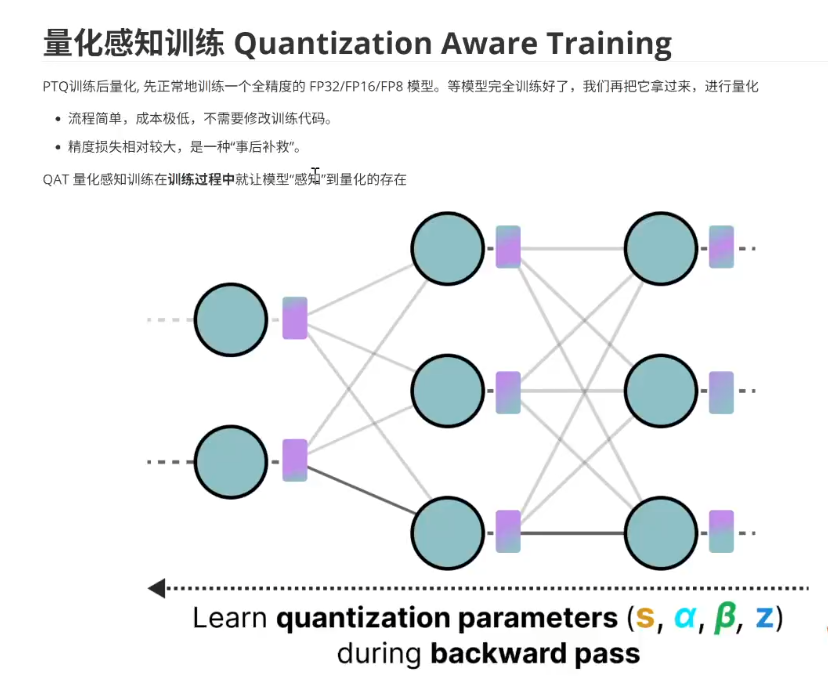

訓練時量化:

量化感知訓練:

顯卡:

本地化部署:

2016年 Pascal Tesla P100 Tesla P40 24G顯存 幾百塊錢

FP32 int8

FP16/BF16 不支持

Volta 2017 V100 32G/ 16G

FP16 Tensor Core BF16不支持

int8

Turing 架構 2018 年

Tesla T4 2080Ti 22G顯存(2500-3000) 11G顯存

FP16 int8 int4 硬件加速

BF16不支持

Ampere 2020年

A100 80G、40G顯存

L20 L40 48G顯存

原生支持BF16 上限與下限比較大 對比FP16容易出現值溢出

Hopper H100 H200(國內有限制了)

FP8 好多大模型都是在FP8精度上進行訓練的

H20 對中國大陸的閹割版 算力,帶寬都有限制

2024 blackwell B100 B200

FP4 原生支持

云 阿里云 V100

消費機顯卡 , 工業級顯卡

消費級顯卡: 算力帶寬比同時期的工業級顯卡 要小

工業級顯卡: 支持nylink 帶寬比較高,傳輸效率比較高

多卡

單機單卡:

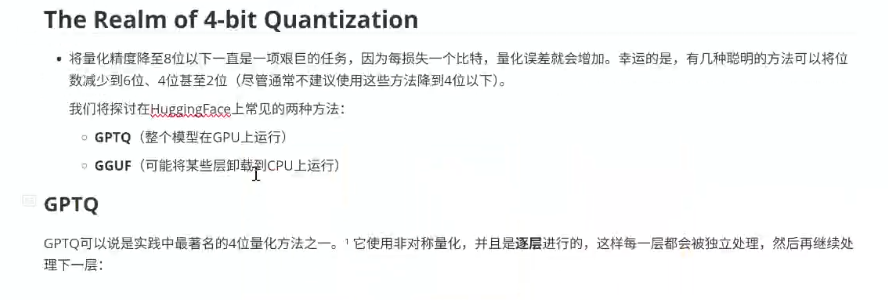

671B FP8

多機多卡:每臺機器之間網絡連接

量化重點:

FP16,BF16

int8 int4

FP8 現在大多數的新的模型都是在FP8精度下訓練的。

int8 int4 低于8的低比特量化主要用于推理階段

量化的計算方式:

對稱: 量化前是 0 和 量化后 還是0

非對稱:

量化的時機:

訓練后量化:

動態量化

靜態量化

訓練量化感知(訓練時就考慮量化)

低比特量化:

GGUF

)

)

優化算法簡介)

)

)

)

![數學建模算法-day[14]](http://pic.xiahunao.cn/數學建模算法-day[14])