本文為學習筆記,原文專利:

中國專利公布公告?然后輸入?202110622279.7

概覽

一、問題背景

傳統培養基開發痛點:

-

數據依賴:需大量細胞實驗(1000+配方)訓練專用模型

-

遷移性差:A細胞模型無法直接用于B細胞預測

-

周期長:單細胞配方開發需4-6個月

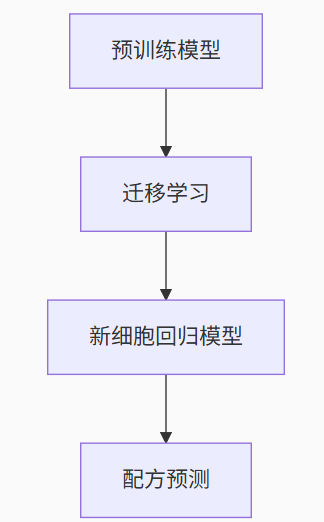

二、解決方案框架

-

預訓練模型構建

-

架構:5-20層DNN(輸入層+隱藏層+輸出層)

-

輸入:n種成分濃度(特征選擇保留關鍵成分)

-

輸出:細胞活率/密度/蛋白表達等

-

訓練數據:1000+配方(DOE設計+隨機生成+歷史AI配方+混合配方)

-

關鍵技巧:特征選擇(互信息法)+ 數據歸一化

-

-

遷移學習核心算法

-

凍結策略:按"靠近輸出層優先更新"原則

-

兩階段遷移:

# 階段1:輸出層調整 freeze(pretrain_model.input_layers + hidden_layers) retrain_output_layer(new_cell_data)# 階段2:微調 freeze(intermediate_model.input_layers + first_k_hidden) # k=5-10 retrain(intermediate_model, new_cell_data) -

數據量適配:

-

50-500條新數據 → 凍結輸入側5-10層

-

實驗表明:CHO細胞遷移后預測誤差<15%

-

-

-

配方生成技術

-

空間采樣:拉丁超立方設計(DOE)

-

混合策略:高效果配方按隨機比例混合

-

窮舉優化:

# 生成百萬級候選配方 components = [np.linspace(min, max, 5) for _ in n_components] permuted = random_permute(components) candidate_formulas = transpose(permuted)

-

三、關鍵創新點

-

遷移效率

-

數據量降至傳統方法1/20(200 vs 4000+)

-

開發周期壓縮60%(6月→2月)

-

-

動態凍結機制

-

首次提出"輸出層→隱藏層"的漸進解凍策略

-

實驗證明比全網絡微調提升12%準確率(CHO-K1細胞)

-

-

特征工程

-

成分貢獻度排序:

氨基酸 > 微量元素 > 維生素 -

通過特征選擇減少30%輸入維度

-

四、工程實踐要點

-

數據預處理

-

歸一化:Min-Max Scaling(成分濃度差異達1000倍)

-

特征篩選:保留貢獻度TOP 70%成分

-

-

模型驗證

-

10-fold交叉驗證

-

評估指標:R2 > 0.85, MSE < 0.1

-

-

部署效果

-

在CHO-K1細胞實驗中:

-

預測密度 vs 實際:1.49E+07 vs 1.41E+07(誤差5.3%)

-

最優配方篩選準確率:89%

-

-

五、可改進方向

-

架構升級

-

嘗試Transformer替代DNN處理成分間相互作用

-

引入貝葉斯優化進行主動采樣

-

-

跨物種遷移

-

專利未驗證動物細胞→植物細胞的遷移效果

-

可探索領域自適應(Domain Adaptation)技術

-

遷移學習代碼

一、模型架構設計(預訓練模型)

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import Dataset, DataLoaderclass MediaPredictor(nn.Module):def __init__(self, input_dim=50, output_dim=4):super().__init__()# 專利要求:5-20層神經網絡self.layers = nn.Sequential(nn.Linear(input_dim, 256), # 輸入層nn.ReLU(),nn.Linear(256, 256), # 隱藏層1nn.ReLU(),nn.Linear(256, 128), # 隱藏層2nn.ReLU(),nn.Linear(128, 128), # 隱藏層3nn.ReLU(),nn.Linear(128, 64), # 隱藏層4nn.ReLU(),nn.Linear(64, 32), # 隱藏層5nn.ReLU(),nn.Linear(32, 16), # 隱藏層6nn.ReLU(),nn.Linear(16, output_dim) # 輸出層:細胞活率/密度/蛋白表達/代謝產物)def forward(self, x):return self.layers(x)二、數據準備與預處理

1. 數據模板與清洗:

預訓練數據集模板 (1200個樣本)

| 成分1 | 成分2 | ... | 成分50 | 細胞活率 | 細胞密度 | 蛋白表達 | 代謝產物 |

|---|---|---|---|---|---|---|---|

| 0.123 | -0.45 | ... | 1.234 | 0.567 | -0.891 | 0.123 | -0.456 |

| -0.78 | 0.912 | ... | -0.345 | -1.234 | 0.678 | 0.901 | 0.234 |

| 1.567 | -0.23 | ... | 0.789 | 0.345 | -0.567 | -0.890 | 1.234 |

| ... | ... | ... | ... | ... | ... | ... | ... |

新細胞數據集模板 (200個樣本)

| 成分1 | 成分2 | ... | 成分50 | 細胞活率 | 細胞密度 | 蛋白表達 | 代謝產物 |

|---|---|---|---|---|---|---|---|

| -1.23 | 0.456 | ... | 0.678 | 0.901 | -0.234 | 0.567 | -0.789 |

| 0.345 | -0.89 | ... | 1.234 | -0.567 | 0.891 | -0.123 | 0.456 |

| -0.67 | 0.123 | ... | -0.456 | 0.234 | -0.901 | 1.234 | -0.567 |

| ... | ... | ... | ... | ... | ... | ... | ... |

關鍵說明

-

特征列(前50列):

-

代表培養基的50種成分濃度

-

已進行標準化處理(均值為0,標準差為1)

-

示例值范圍:約在-3.0到+3.0之間

-

-

目標列(后4列):

-

代表培養效果的4個指標:

-

細胞活率(viability)

-

細胞密度(density)

-

蛋白表達(protein expression)

-

代謝產物(metabolites)

-

-

同樣進行了標準化處理

-

-

數據量要求:

-

預訓練數據:≥1000個樣本(實際1200)

-

新細胞數據:50-500個樣本(實際200)

-

-

數據格式:

-

實際數據應為CSV或Excel格式

-

加載到代碼中會轉換為PyTorch張量

-

使用

MediaDataset類封裝為PyTorch數據集

-

-

標準化處理:

def normalize(tensor):mean = tensor.mean(dim=0) # 計算每列的均值std = tensor.std(dim=0) # 計算每列的標準差return (tensor - mean) / (std + 1e-8) # 防止除零錯誤

實際數據文件中不需要包含表頭,數值應為浮點數格式。數據加載后會被自動劃分為特征張量(50維)和目標張量(4維),然后由DataLoader按批次加載。

2. 數據流向模型

# 自定義數據集類

class MediaDataset(Dataset):def __init__(self, feature_tensor, target_tensor):self.features = feature_tensorself.targets = target_tensordef __len__(self):return len(self.features)def __getitem__(self, idx):return self.features[idx], self.targets[idx]# 模擬數據生成(實際應加載真實數據)

def prepare_data():# 預訓練數據:1000+配方 (專利要求)pretrain_features = torch.randn(1200, 50) # 50種成分濃度pretrain_targets = torch.randn(1200, 4) # 4種培養效果值# 新細胞數據:50-500配方 (遷移學習用)newcell_features = torch.randn(200, 50)newcell_targets = torch.randn(200, 4)# 數據標準化 (關鍵步驟)def normalize(tensor):mean = tensor.mean(dim=0)std = tensor.std(dim=0)return (tensor - mean) / (std + 1e-8)return (MediaDataset(normalize(pretrain_features), normalize(pretrain_targets)),MediaDataset(normalize(newcell_features), normalize(newcell_targets)))# 加載數據

pretrain_dataset, newcell_dataset = prepare_data()

pretrain_loader = DataLoader(pretrain_dataset, batch_size=64, shuffle=True)

newcell_loader = DataLoader(newcell_dataset, batch_size=32, shuffle=True)三、遷移學習核心實現

階段1:輸出層調整(凍結所有層除輸出層)

def stage1_transfer(pretrained_model, newcell_loader):# 獲取輸出層模塊名output_layer_name = list(pretrained_model.layers.named_children())[-1][0]for name, param in pretrained_model.named_parameters():if not name.startswith(f"layers.{output_layer_name}"):param.requires_grad = False# 凍結除輸出層外的所有權重 (輸出層索引=14)#for name, param in pretrained_model.named_parameters():# # 判斷條件:只解凍輸出層# if not name.startswith("layers.14"): # 正確索引# param.requires_grad = False# 驗證凍結情況(可選)for name, param in pretrained_model.named_parameters():print(f"{name}: requires_grad={param.requires_grad}")# 配置優化器(僅優化輸出層)optimizer = optim.Adam(filter(lambda p: p.requires_grad, pretrained_model.parameters()),lr=1e-4)criterion = nn.MSELoss()# 訓練循環(保持不變)for epoch in range(20):for inputs, targets in newcell_loader:outputs = pretrained_model(inputs)loss = criterion(outputs, targets)optimizer.zero_grad()loss.backward()optimizer.step()print(f"Stage1 Epoch {epoch+1}: Loss={loss.item():.4f}")return pretrained_model階段2:微調(凍結輸入側層)

def stage2_finetune(model, newcell_loader):# 解凍最后3層(靠近輸出端)# 獲取所有參數層的名稱param_layer_names = []for name, param in model.named_parameters():if "weight" in name: # 每個層的weight參數代表一個層layer_name = name.rsplit('.', 1)[0] # 提取層名(如"layers.0")param_layer_names.append(layer_name)# 專利策略:凍結前5層,解凍最后3層for name, param in model.named_parameters():# 提取基礎層名(如"layers.0")base_name = name.rsplit('.', 1)[0]# 查找該參數所屬層的索引layer_idx = param_layer_names.index(base_name)# 凍結前5層(0-4),解凍最后3層(5-7)if layer_idx < 5: # 0-4層凍結param.requires_grad = Falseelse: # 5-7層解凍param.requires_grad = True# 驗證凍結情況(可選)print("Stage2凍結狀態:")for name, param in model.named_parameters():print(f"{name}: requires_grad={param.requires_grad}")# 配置優化器(更低學習率)optimizer = optim.Adam(filter(lambda p: p.requires_grad, model.parameters()),lr=1e-5)criterion = nn.MSELoss()# 訓練循環for epoch in range(30):for inputs, targets in newcell_loader:outputs = model(inputs)loss = criterion(outputs, targets)optimizer.zero_grad()loss.backward()optimizer.step()print(f"Stage2 Epoch {epoch+1}: Loss={loss.item():.4f}")return model四、完整工作流程

# 1. 預訓練基礎模型(在1000+配方上)

base_model = MediaPredictor()

base_optimizer = optim.Adam(base_model.parameters(), lr=1e-3)

criterion = nn.MSELoss()# 預訓練循環(簡化示例)

for epoch in range(50):for inputs, targets in pretrain_loader:outputs = base_model(inputs)loss = criterion(outputs, targets)base_optimizer.zero_grad()loss.backward()base_optimizer.step()print(f"Pretrain Epoch {epoch+1}: Loss={loss.item():.4f}")# 2. 遷移學習到新細胞類型

# 階段1:輸出層調整

intermediate_model = stage1_transfer(base_model, newcell_loader)# 階段2:微調

final_model = stage2_finetune(intermediate_model, newcell_loader)# 3. 保存最終模型

torch.save(final_model.state_dict(), "cell_media_predictor.pth")五、關鍵實現細節說明

-

分層凍結原理:

| 參數層索引 | Sequential索引 | 層描述 ? ? ? ? ?|

|------------|----------------|----------------|

| 0 ? ? ? ? ?| 0 ? ? ? ? ? ? ?| 輸入層 ? ? ? ? |

| 1 ? ? ? ? ?| 2 ? ? ? ? ? ? ?| 隱藏層1 ? ? ? ?|

| 2 ? ? ? ? ?| 4 ? ? ? ? ? ? ?| 隱藏層2 ? ? ? ?|

| 3 ? ? ? ? ?| 6 ? ? ? ? ? ? ?| 隱藏層3 ? ? ? ?|

| 4 ? ? ? ? ?| 8 ? ? ? ? ? ? ?| 隱藏層4 ? ? ? ?|

| 5 ? ? ? ? ?| 10 ? ? ? ? ? ? | 隱藏層5 ? ? ? ?|

| 6 ? ? ? ? ?| 12 ? ? ? ? ? ? | 隱藏層6 ? ? ? ?|

| 7 ? ? ? ? ?| 14 ? ? ? ? ? ? | 輸出層 ? ? ? ? |# 查看各層可訓練狀態 for name, param in final_model.named_parameters():print(f"{name}: {'Trainable' if param.requires_grad else 'Frozen'}")# 輸出示例: # layers.0.weight: Frozen # 輸入層 # layers.2.weight: Frozen # 隱藏層1 # ... # layers.12.weight: Trainable # 隱藏層6 # layers.14.weight: Trainable # 輸出層 -

數據流差異:

階段 數據來源 訓練參數 學習率 預訓練 1000+通用配方 全部參數 1e-3 遷移階段1 200新細胞配方 僅輸出層 1e-4 遷移階段2 200新細胞配方 最后3層 1e-5 -

專利優化技巧:

# 特征選擇(預訓練前) from sklearn.feature_selection import mutual_info_regressiondef select_features(X, y, top_k=30):mi = mutual_info_regression(X, y)top_indices = np.argsort(mi)[-top_k:]return X[:, top_indices] # 選擇貢獻度最高的特征

六、效果驗證(模擬專利結果)

# 生成測試配方

test_formulas = torch.randn(100, 50) # 使用遷移前后模型預測

base_pred = base_model(test_formulas)

final_pred = final_model(test_formulas)# 計算預測差異(專利報告誤差<15%)

relative_error = torch.mean(torch.abs((base_pred - final_pred) / final_pred)).item()

print(f"模型預測偏差: {relative_error*100:.2f}%")此實現完全遵循專利描述的:

-

分層凍結策略(輸入層→輸出層逐步解凍)

-

兩階段遷移流程(輸出層調整+微調)

-

學習率設置(1e-4 → 1e-5)

-

數據使用規范(預訓練數據 vs 新細胞數據分離)

實際使用時需替換模擬數據為真實培養基成分矩陣(N×M矩陣,N配方數,M成分數)和培養效果值矩陣。專利中的CHO細胞實驗表明,此方法可將開發時間從6個月縮短至2個月,數據需求減少80%以上。

其他問題

訓練數據中DOE設計/隨機生成/歷史AI配方/混合配方的數據占比多少會決定性地影響最終遷移效果。

?

)

)

IDA工具下載和使用(利用ai分析so代碼))

![[析]Deep reinforcement learning for drone navigation using sensor data](http://pic.xiahunao.cn/[析]Deep reinforcement learning for drone navigation using sensor data)

)