課程地址:(超爽中英!) 2024公認最好的【吳恩達深度學習】教程!附課件代碼 Professionalization of Deep Learning_嗶哩嗶哩_bilibili

1.目錄

2.什么是神經網絡

3.用神經網絡進行監督學習

4.為什么深度學習會興起

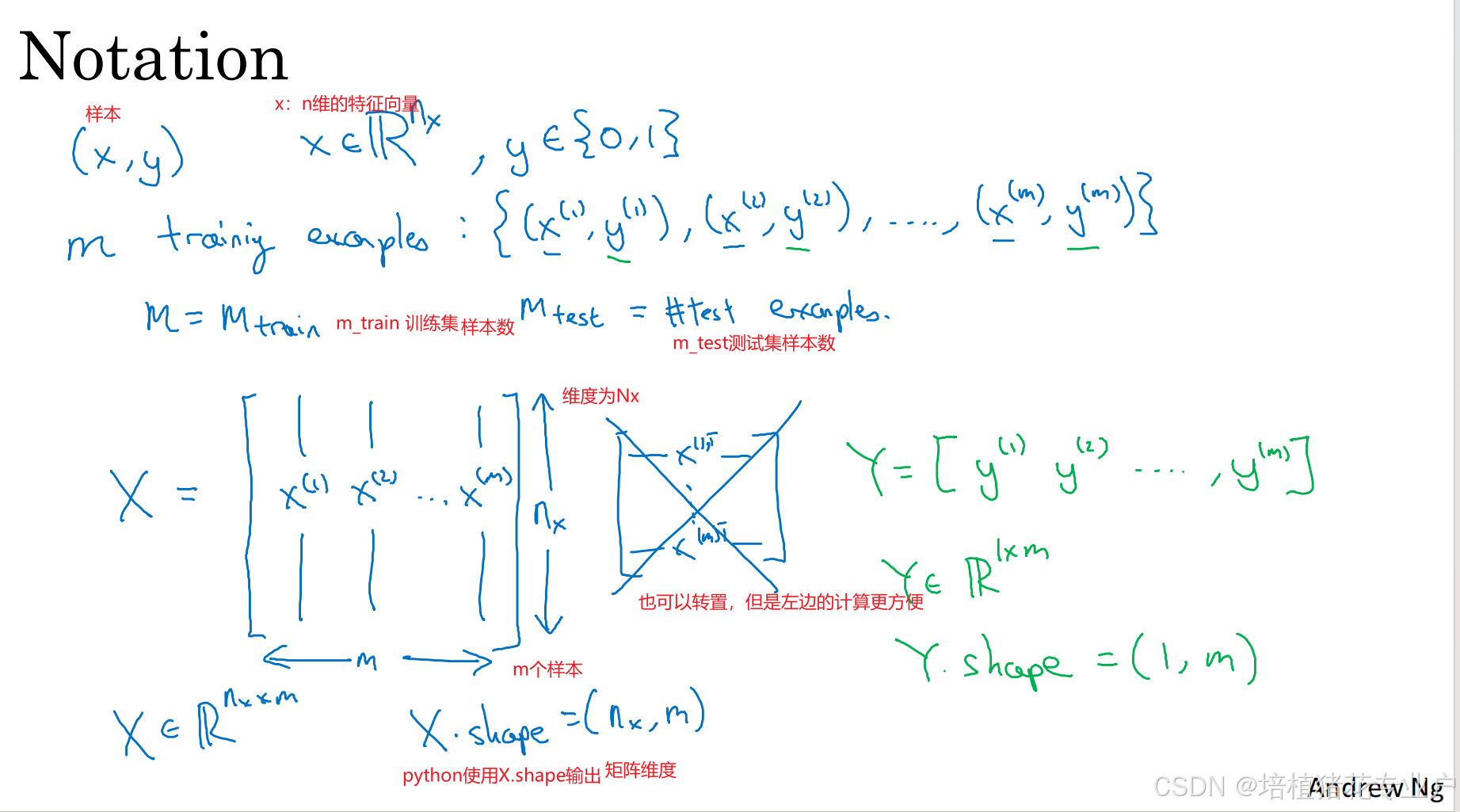

7.二分分類

適用于二元分類問題的函數:邏輯回歸,輸出0/1

9.logistic回歸損失函數

10.梯度下降法

15.logistic回歸中的梯度下降法

![]()

da/dZ=![]() =a(1-a)

=a(1-a)

所以dL/dZ=a-y

求dL/dw1=x1*dZ??dL/dw2=x2*dZ? ?dL/db=dZ??

16.m個樣本的梯度下降

上圖就是梯度下降的一次迭代

上圖就是梯度下降的一次迭代

但是在里面有兩個循環,外層循環是1~m,內層循環是w1~wn

矢量化可以避免循環

17.向量化

用向量化避免loop,提高代碼運行速率

18.向量化的更多例子

19.向量化logistic回歸

正向傳播一步迭代的向量化實現,同時處理m個訓練樣本

20.向量化logistic回歸的梯度輸出

上個視頻學會了計算向量化計算整個訓練集預測值a

這個視頻將學會向量化計算m個訓練數據的梯度

這個技術叫Broadcasting

21.Python中的廣播

24.(選修)logistic損失函數的解釋 未來看

25.神經網絡概覽

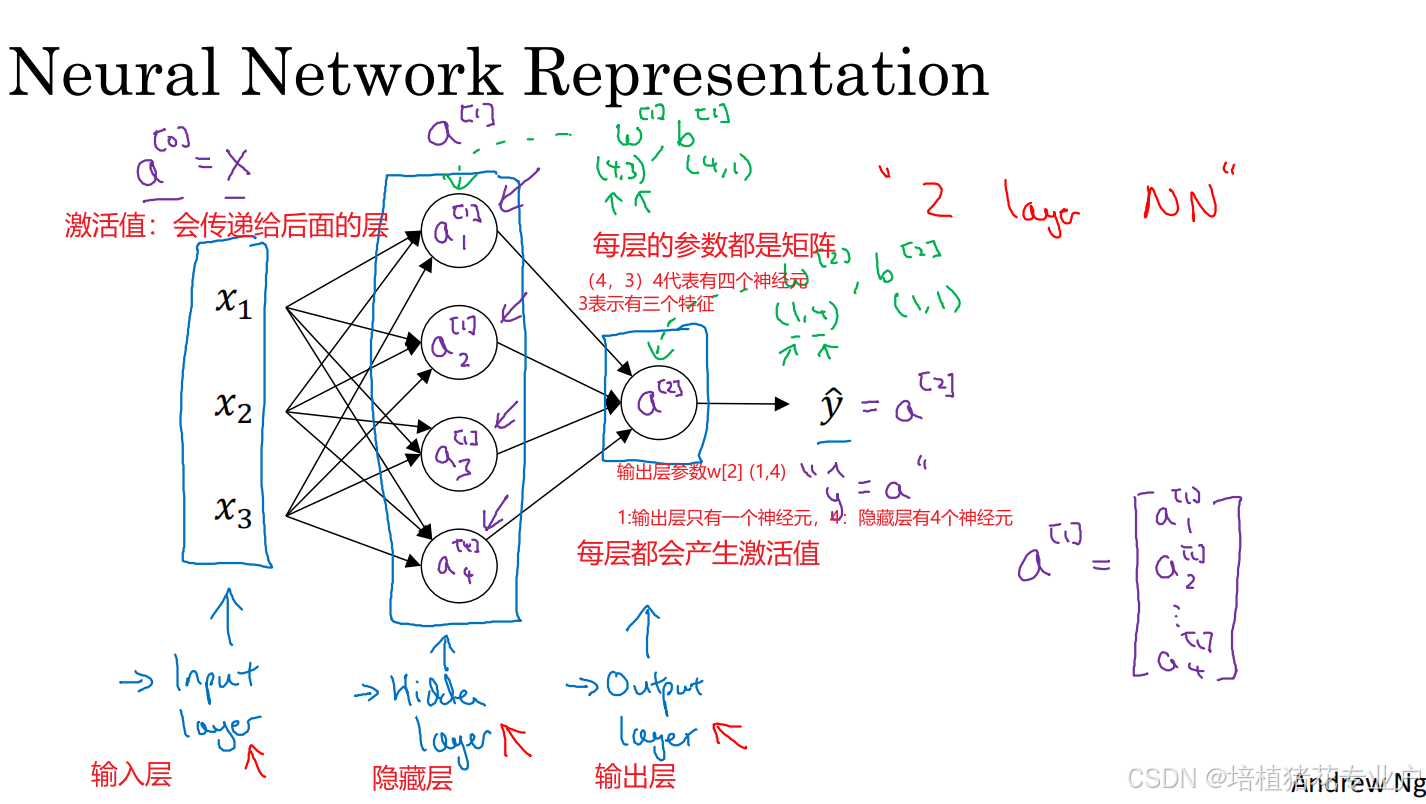

26.神經網絡表示

a[0]? a[n]每一層的激活值

27.計算神經網絡的輸出

補:a[1]=將sigmoid作用于矩陣Z[1]

向量化的經驗法則:如果一層有不同的節點,就將他們縱向堆疊起來

28.多樣本向量化 29向量化實現的解釋 都是線代

30.激活函數

建立神經網絡有很多選擇,比如隱藏單元數、激活函數、如何初始化權重

對于你的項目,事實上很難預測哪種選擇最有效,最好是實際上跑一跑

31.為什么需要非線性激活函數

只有一種情況可以使用線性激活函數,就是當預測房價,最高可以無窮大,那么在輸出層可以使用線性激活函數,并且隱藏層必須是非線性的激活函數

只有壓縮或者非常特殊的情況,在隱藏層使用線性激活函數

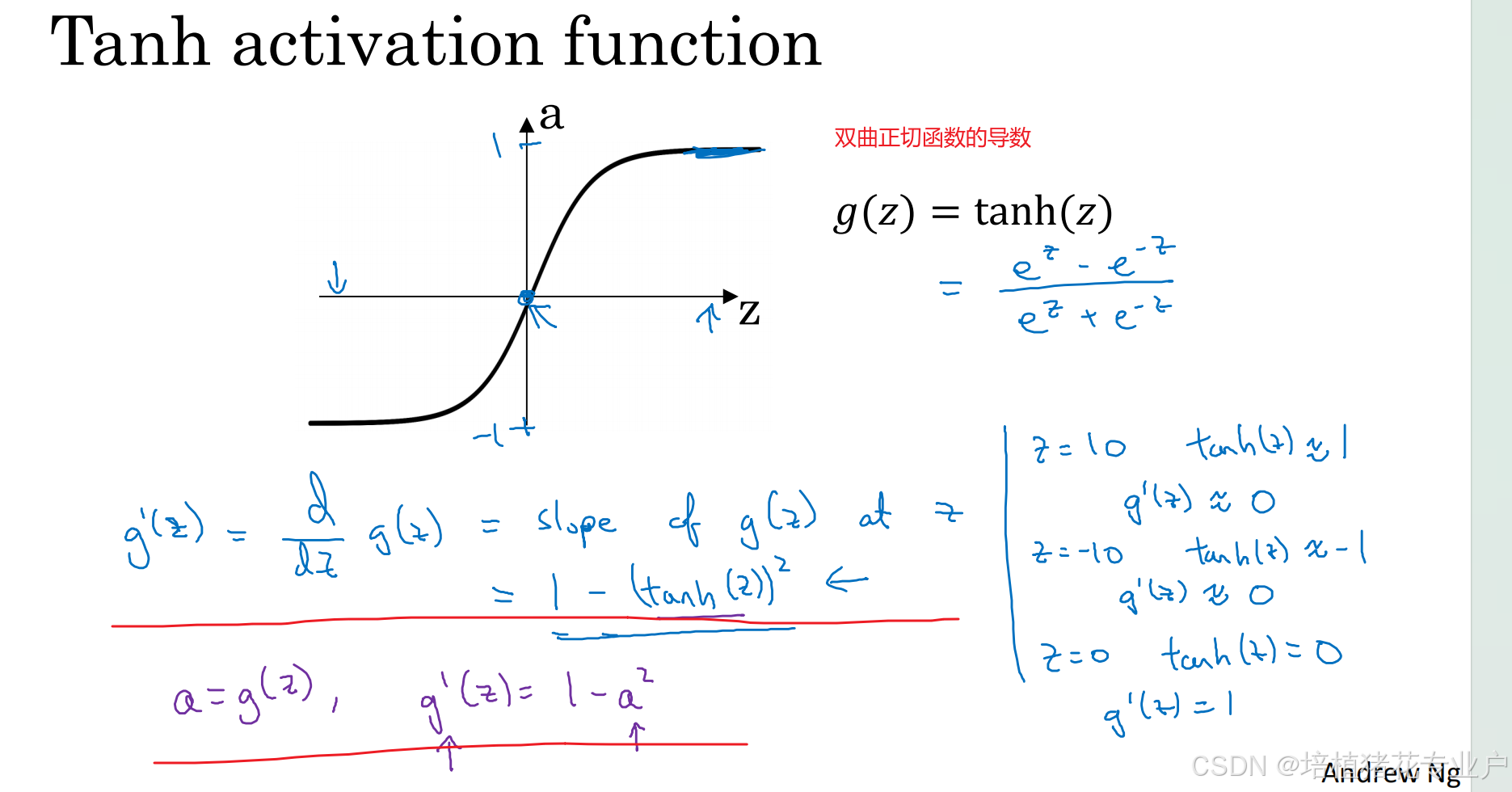

32.激活函數的導數

33.神經網絡的梯度下降法

34.(選修)直觀理解反向傳播

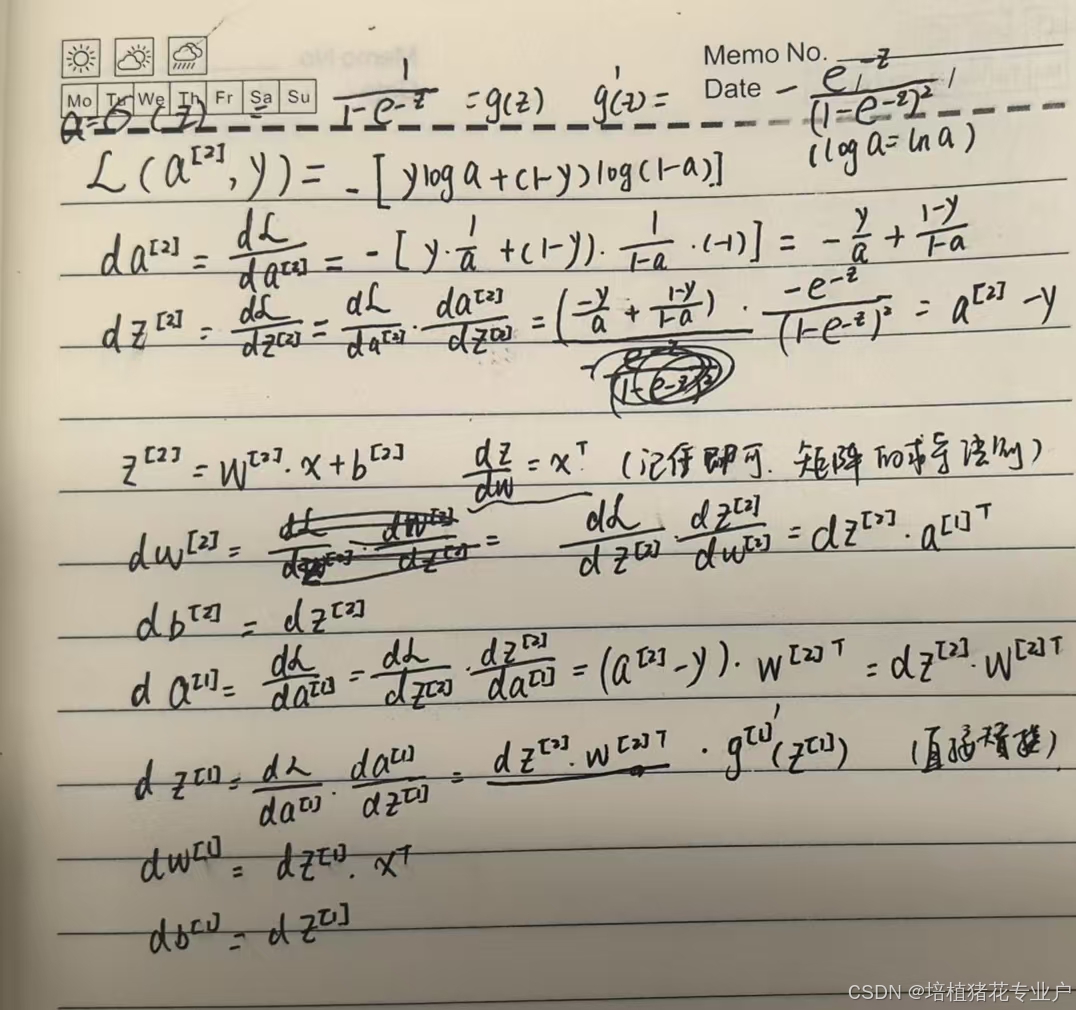

反向傳播公式手推:

35.隨機初始化

補充:每個激活函數的權重也是一樣的

單層神經網絡設為0.01應該還可以,如果是深層的需要嘗試其他的constant?

36.深層神經網絡

介紹了一些符號約定。

a[l]最后一層的a l表示層數

:數據交互篇)

概率論)

)

)

:Python復刻「崩壞星穹鐵道」嗷嗚嗷嗚事務所---源碼級解析該小游戲背后的算法與設計模式【純原創】)