研究者能夠擴展神經網絡并構建非常大型網絡的原因之一,就是神經網絡可以被向量化,vectorized;可以非常高效地用矩陣地乘法實現。

事實上,并行計算硬件,例如GPU,一些CPU的功能,非常擅長進行非常大的矩陣乘法,矢量化的神經網絡是如何工作的。

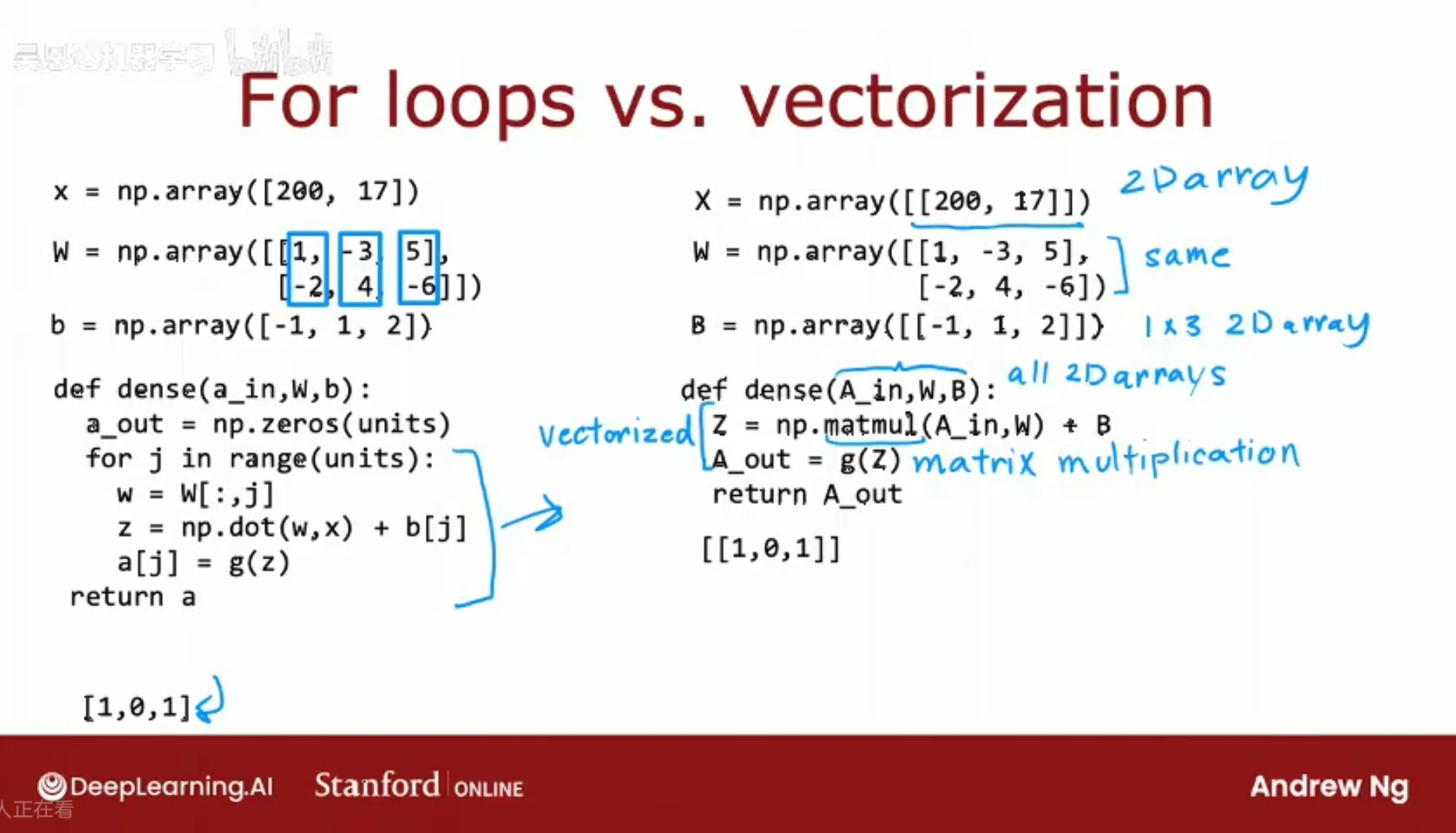

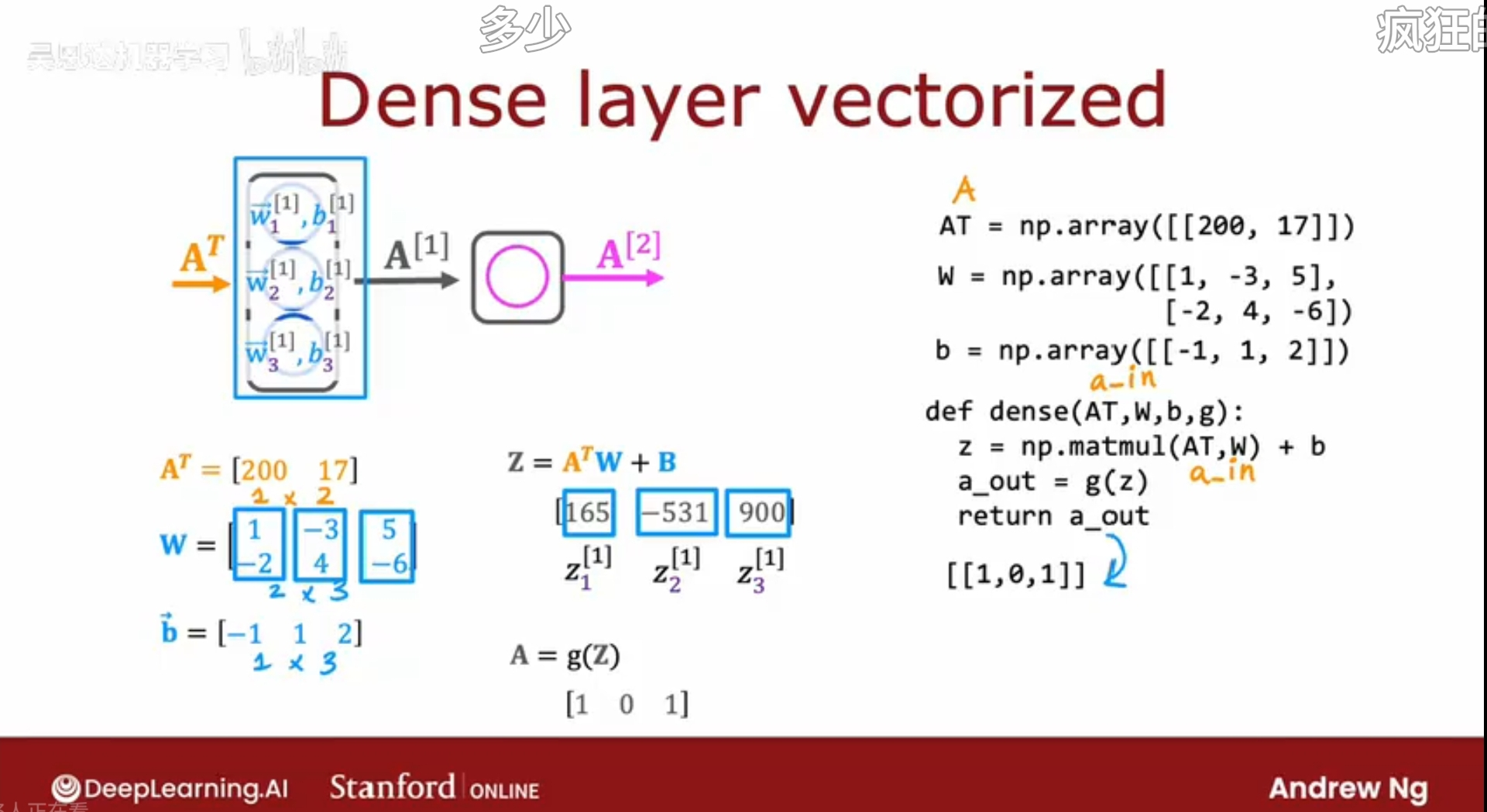

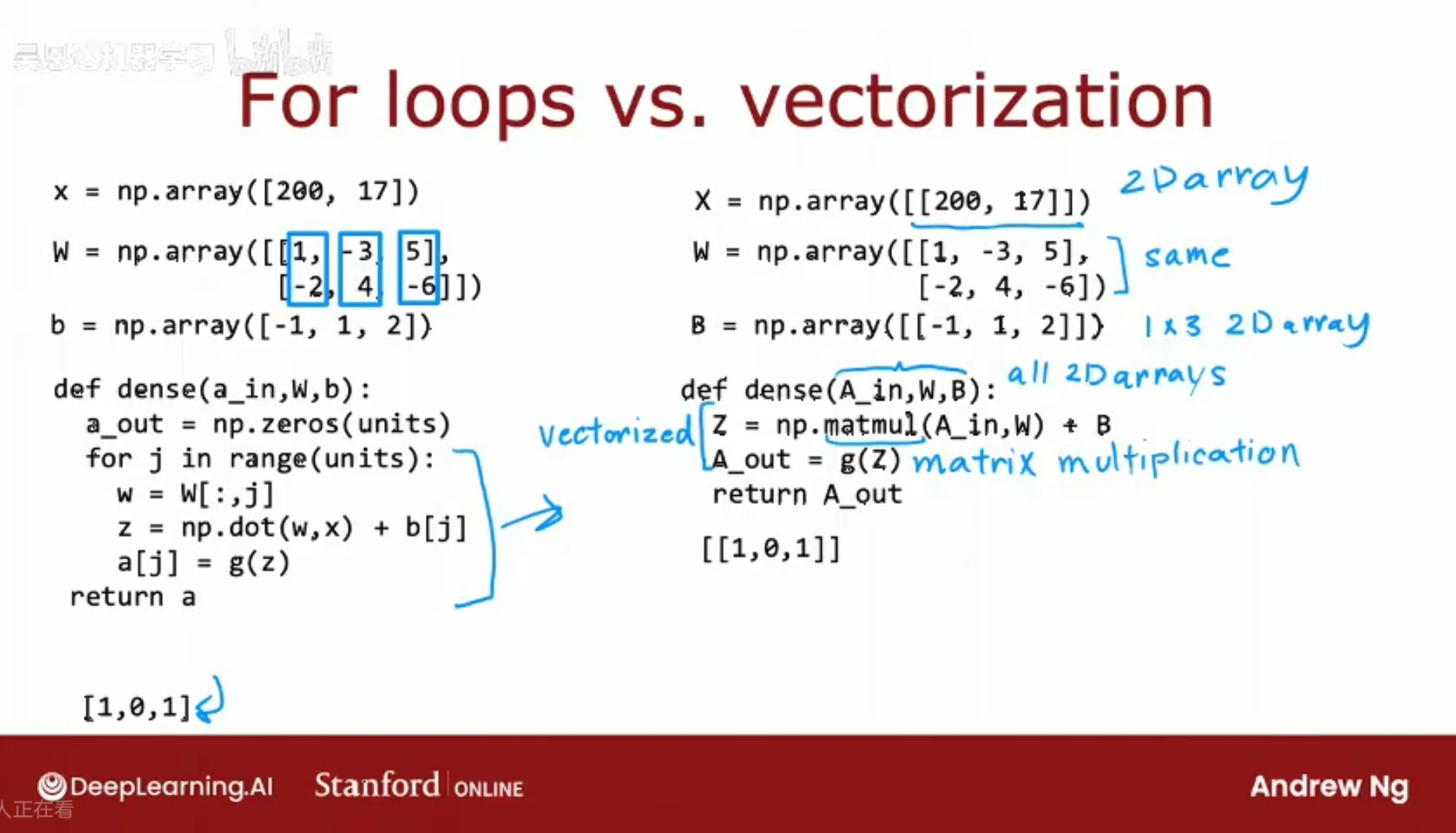

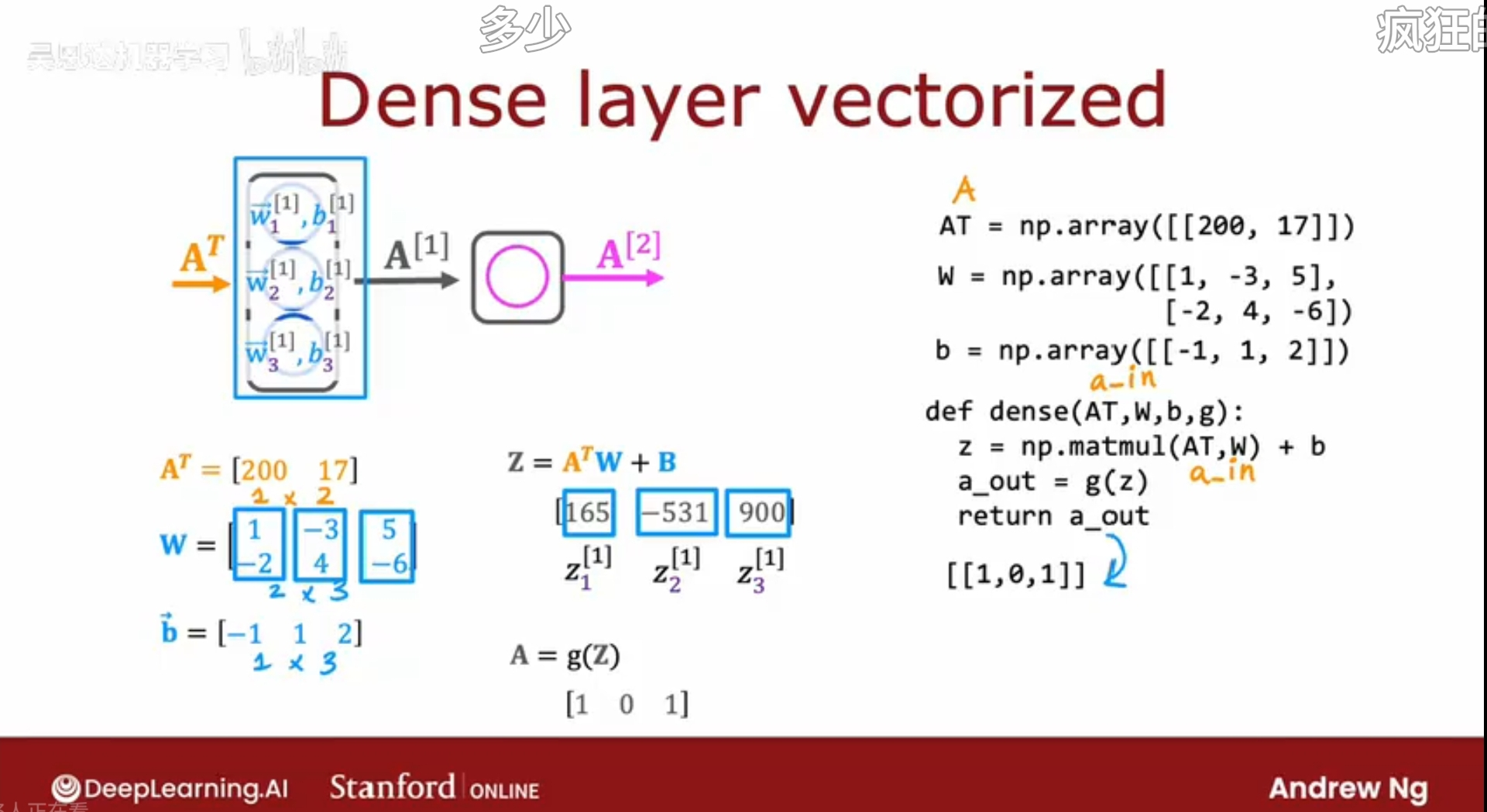

將參數X, W, B, A_in, A_out 全部當作矩陣處理,會非常高效地得到某一層的輸出A_out,matmul是NumPy中的矩陣乘法;

研究者能夠擴展神經網絡并構建非常大型網絡的原因之一,就是神經網絡可以被向量化,vectorized;可以非常高效地用矩陣地乘法實現。

事實上,并行計算硬件,例如GPU,一些CPU的功能,非常擅長進行非常大的矩陣乘法,矢量化的神經網絡是如何工作的。

將參數X, W, B, A_in, A_out 全部當作矩陣處理,會非常高效地得到某一層的輸出A_out,matmul是NumPy中的矩陣乘法;

本文來自互聯網用戶投稿,該文觀點僅代表作者本人,不代表本站立場。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。 如若轉載,請注明出處:http://www.pswp.cn/news/918415.shtml 繁體地址,請注明出處:http://hk.pswp.cn/news/918415.shtml 英文地址,請注明出處:http://en.pswp.cn/news/918415.shtml

如若內容造成侵權/違法違規/事實不符,請聯系多彩編程網進行投訴反饋email:809451989@qq.com,一經查實,立即刪除!