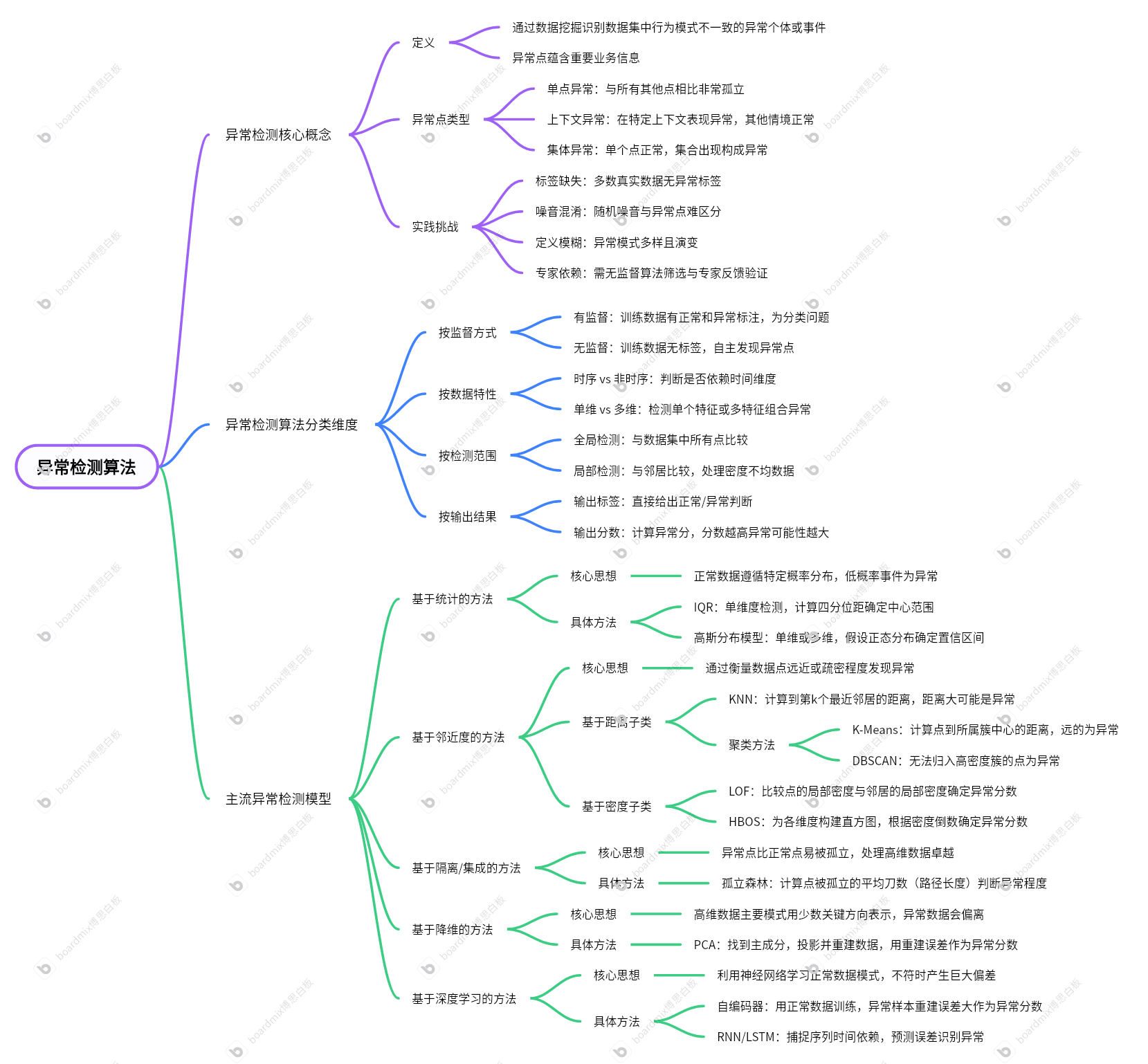

第一部分:異常檢測的核心概念

在深入算法細節之前,理解異常檢測的“語境”至關重要。

1. 什么是異常檢測?

異常檢測(Anomaly Detection 或 Outlier Detection)旨在通過數據挖掘技術,識別出數據集中與大多數數據在行為模式上不一致的“異常個體”或“異常事件”。這些異常點通常蘊含著重要的業務信息,如欺詐行為、設備故障或新的商業機會。

2. 異常點的類型

- 單點異常 (Global Outlier):一個數據點與數據集中所有其他點相比都顯得非常孤立。例如,在一群小黃人中,突然出現一個海綿寶寶。

- 上下文異常 (Contextual Outlier):一個數據點在特定上下文中表現出異常,但在其他情境下可能完全正常。例如,夏季的某一天氣溫驟降到10℃,在“夏季”這個上下文中即為異常。

- 集體異常 (Collective Outlier):單個數據點本身不異常,但當一小組數據點集合在一起出現時,則構成了異常。例如,小區里有10戶人家在同一天搬家,這個“集體行為”就是異常。

3. 實踐中的挑戰

- 標簽缺失:絕大多數真實場景的數據沒有“異常”標簽,導致無法直接使用有監督學習。

- 噪音混淆:數據中的隨機噪音與有價值的異常點很難區分。

- 定義模糊:異常模式多樣且持續演變(如欺詐手段升級),難以給出精確定義。

- 專家依賴:通常需要“無監督算法初步篩選 + 領域專家反饋驗證”的閉環模式來持續優化模型。

第二部分:異常檢測算法的分類維度

我們可以從不同角度對算法進行歸類,這有助于我們根據具體場景選擇最合適的工具。

-

按監督方式 (Supervision)

- 有監督:訓練數據已明確標注“正常”和“異常”。問題轉化為一個(通常是類別不均衡的)分類問題。

- 無監督:訓練數據完全沒有標簽,算法需要自主發現“與眾不同”的數據點。這是最常見、也是挑戰最大的場景。

-

按數據特性 (Data Characteristics)

- 時序 vs. 非時序:異常的判斷是否依賴于時間維度。

- 單維 vs. 多維:是只檢測單個特征的異常值,還是在多特征構成的空間中尋找異常組合。

-

按檢測范圍 (Detection Scope)

- 全局檢測:將每個數據點與數據集中的所有其他點進行比較。

- 局部檢測:僅將每個數據點與其“鄰居”進行比較,更擅長處理密度不均的數據。

-

按輸出結果 (Output Result)

- 輸出標簽:模型直接給出“正常/異常”的判斷。

- 輸出分數:模型為每個數據點計算一個“異常分”,分數越高代表異常可能性越大,決策更靈活。

第三部分:主流異常檢測模型詳解

幾乎所有現代算法都源于一些經典的核心思想。下面我們按照模型的內在邏輯,對它們進行歸類和詳細解析。

1. 基于統計的方法 (Statistical-based Methods)

核心思想:正常數據遵循一個特定的概率分布,而低概率事件被視為異常。

-

IQR (Interquartile Range,四分位距)

- 適用場景:單維度異常檢測。

- 工作原理:這是一種簡單穩健的統計方法。它通過計算數據的上四分位數(Q3)和下四分位數(Q1)的差值(IQR = Q3 - Q1),來定義數據的“中心范圍”。任何超出

[Q1 - 1.5*IQR, Q3 + 1.5*IQR]這個“圍欄”的數據點都被視為異常。它不需要假設數據分布,非常實用。

-

高斯分布模型 (Gaussian Model)

- 適用場景:單維或多維數據。

- 工作原理:假設正常數據服從高斯(正態)分布。通過計算數據的均值和標準差,我們可以確定一個置信區間(如均值±3倍標準差)。落在該區間之外的數據點因其出現概率極低,被判定為異常。在多維場景下,則使用“多元高斯分布”模型。

2. 基于鄰近度的方法 (Proximity-based Methods)

核心思想:通過衡量數據點之間的“遠近”或“疏密”程度來發現異常。這類方法在處理低維數據時非常有效。

-

子類:基于距離 (Distance-based)

- KNN (K-Nearest Neighbors):其思想是“物以類聚,離群索居”。對每個點,計算它到其第K個最近鄰居的距離。如果這個距離特別大,說明該點處于一個稀疏區域,遠離任何種群,因此很可能是異常點。

- 聚類方法 (Clustering-based):

- K-Means:先將數據聚成k個簇,然后計算每個點到其所屬簇中心的距離。距離中心非常遙遠的點,可以被看作不屬于任何一個簇的異常點。

- DBSCAN:這是一個基于密度的聚類算法。它能自動發現高密度區域作為簇。那些無法被歸入任何一個高密度簇的點,會被算法直接標記為“噪聲(Noise)”,這些噪聲點就是我們尋找的異常點。

-

子類:基于密度 (Density-based)

- LOF (Local Outlier Factor, 局部異常因子):這是對純距離方法的重大改進。它認為,異常的判斷應該是“相對”的。LOF不僅看一個點到鄰居的距離,更關鍵的是,它會比較這個點的局部密度與其鄰居們的局部密度。如果一個點的密度遠低于其周圍鄰居的密度,它就會被賦予一個很高的異常分數,即使它處于一個整體稀疏的區域。

- HBOS (Histogram-based Outlier Score):這是一種快速的密度估計方法。它為數據的每個維度(特征)單獨構建直方圖。一個數據點的異常分數由它在各個維度上所落入的直方圖“箱子”的高度(即密度)的倒數決定。如果一個點在多個維度上都落在低密度區域,它的總分就會很高。

3. 基于隔離/集成的方法 (Isolation/Ensemble-based Methods)

核心思想:異常點因為“稀少且與眾不同”,所以應該比正常點更容易被“孤立”出來。這類方法在處理高維數據時表現卓越。

- 孤立森林 (Isolation Forest)

- 工作原理:想象一下用隨機的“刀”(超平面)去切割數據空間。異常點由于處于稀疏地帶,往往用很少的幾刀就能被完美地從群體中分離出來。而正常的、處于數據簇內部的點,則需要很多刀才能被“孤立”。孤立森林通過計算一個點被孤立所需的平均“刀數”(路徑長度)來判斷其異常程度。路徑越短,異常分數越高。

4. 基于降維的方法 (Dimensionality Reduction-based Methods)

核心思想:高維數據的主要模式可以用少數幾個關鍵方向來表示。正常數據能夠很好地遵循這些模式,而異常數據則會偏離。

- PCA (主成分分析)

- 工作原理:PCA能夠找到代表數據變化最主要方向的幾個“主成分”。我們將所有數據點投影到這些主成分構成的低維空間,然后再將它們“重建”回原始的高維空間。對于正常點,這個過程中的信息損失很小,重建誤差(原始點與重建點之間的距離)也很低。而異常點由于不符合數據的主流模式,在降維時會丟失大量個性信息,導致其重建誤差非常大。這個重建誤差就可以作為其異常分數。

5. 基于深度學習的方法 (Deep Learning-based Methods)

核心思想:利用神經網絡強大的非線性擬合能力,學習正常數據的復雜模式。當模型遇到與該模式不符的數據時,會產生巨大偏差。

-

自編碼器 (Autoencoder)

- 適用場景:復雜的非時序數據,如圖像、用戶向量等。

- 工作原理:這是一種自我監督的神經網絡。它由一個編碼器(壓縮數據)和一個解碼器(解壓并重建數據)組成。我們只用正常數據來訓練它,迫使它學會如何完美地重建正常樣本。當一個異常樣本(如一張它從未見過的圖片)輸入時,由于模型沒有學過它的模式,解碼器將無法很好地重建它,導致巨大的重建誤差。這個誤差值就是異常分數。

-

RNN/LSTM (循環神經網絡)

- 適用場景:時序相關數據、序列數據。

- 工作原理:RNN及其變體(如LSTM)擅長捕捉序列中的時間依賴關系。通過在正常的時間序列上進行訓練,模型能學習到“下一時刻應該發生什么”。當一個不符合歷史規律的事件發生時,模型的預測會與真實值產生巨大差異,這個預測誤差就可以用來識別上下文異常或集體異常。

)

![【[CSP-J 2022] 上升點列】](http://pic.xiahunao.cn/【[CSP-J 2022] 上升點列】)

)

動態內存分配與它的指針變量)

SmartWaterServer)