Sora,一款由OpenAI在2024年2月推出的創新性文生視頻的生成式AI模型,能夠依據文字說明,創作出既真實又富有想象力的場景視頻,展現了其在模擬現實世界方面的巨大潛能。本文基于公開技術文檔和逆向工程分析,全面審視了Sora背后的技術背景、應用場景、當前面臨的挑戰以及文轉視頻AI技術的未來發展方向。

文章首先回顧了Sora的開發歷程,探索了支撐這一“數字世界構建者”的關鍵技術。

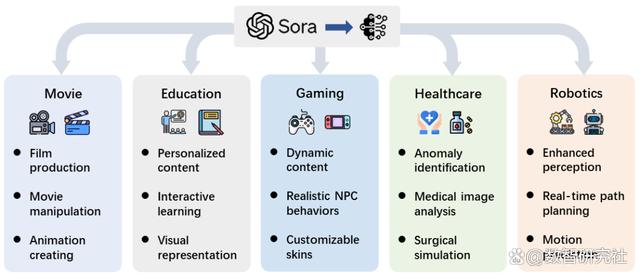

接著,我們詳細探討了Sora在電影制作、教育、市場營銷等多個領域內的應用潛力及其可能帶來的影響。文章還深入討論了為實現Sora的廣泛應用需克服的主要挑戰,例如保證視頻生成的安全性和公正性。

最后,我們展望了Sora乃至整個視頻生成模型技術未來的發展趨勢,以及這些技術進步如何開創人機互動的新方式,進而提升視頻創作的效率和創新性。

1 引言

自ChatGPT于2022年11月面世以來,AI技術已經迎來翻天覆地的變化,這不僅改變了我們的交流方式,還深刻融入了我們的日常生活和眾多行業?。順應趨勢的OpenAI于2024年2月推出了Sora,一個能夠將文本提示轉化為視頻的生成式AI模型,無論是現實場景還是想象中的場景,它都能夠栩栩如生地呈現。區別于以往的視頻生成技術,Sora能夠根據用戶的文本指令,生成最長達一分鐘的高清視頻。Sora的發展,標志著AI長期研究的一個里程碑:讓AI系統(或AI智能體)不僅能理解復雜的用戶指令,還能將這些理解應用于解決現實世界的問題,通過動態和情境豐富的模擬互動。

圖注: Sora的文本到視頻生成示例。文本指令輸入到OpenAI的Sora模型中,隨后它生成了三段根據指令制作的視頻。

Sora展現了解讀和執行復雜人類指令的驚人能力,正如圖?2?中所展示的那樣。這個模型能夠創造出含有多個角色在復雜背景下進行特定活動的詳細場景。研究人員認為,Sora的高效表現不僅來源于它對用戶輸入的文本提示的處理能力,還包括它對場景中復雜元素相互作用的敏銳洞察。

Sora最令人矚目的特點之一是它能夠制作長達一分鐘的視頻,并且視頻質量高、視覺連貫性強。不同于早期只能制作短片的模型,Sora能夠讓視頻從開始到結束都保持著視覺上的連貫性和故事進展。

此外,Sora能夠制作包含細致動作和互動的長視頻序列,突破了以往模型在視頻長度和視覺表現上的限制。這一進步標志著 AI 創意工具的重大飛躍,讓用戶能夠把文字敘述轉換成豐富的視覺故事。整體而言,Sora作為一種世界模擬器,展現了它在描繪場景的物理和情境動態方面的細膩洞察力。

技術層面,Sora的核心是一種預先訓練好的擴散式Transformer。Transformer模型已在許多自然語言處理任務上證明了其可擴展性和有效性。與GPT-4等大型語言模型相似,Sora能夠解析文本并理解復雜的用戶指令。

為了實現高效的視頻生成,Sora采用了時空潛碼片段作為其基本構成單元。簡而言之,Sora將視頻壓縮為潛碼的時空表示,然后從這個壓縮的視頻中提取出一系列的時空潛碼片段,這些潛碼片段概括了短時間內的視覺外觀和運動動態。這些潛碼片段,相當于語言模型中的詞匯Token,為Sora提供了構建視頻的詳細視覺“短語”。Sora利用擴散式Transformer模型,從一個充滿視覺噪點的幀開始,逐步去噪并根據輸入的文本提示添加具體細節,最終生成的視頻經過多次精細化,更加符合預期的內容和質量。

關于Sora的亮點。Sora的能力對多個領域都有深遠影響:

提升模擬能力:Sora的大規模訓練讓它在模擬物理世界的各個方面表現出色。即便沒有具體的3D模型,Sora也能表現出3D世界的一致性,包括物體的持久存在和簡單的世界互動,以及動態的攝像機移動和遠景連貫性。更有趣的是,Sora能夠模擬像Minecraft這樣的數字環境,通過簡單的操作策略,同時保持視覺上的真實感。這表明,發展視頻模型是模擬物理和數字世界復雜性的有效途徑。

激發創造力:想象一下,僅通過文本描述,就能在幾秒鐘內生成一個逼真或極具風格的視頻。Sora加速了設計過程,讓藝術家、電影制作人和設計師能夠快速探索和精煉他們的創意,極大地激發了他們的創造潛能。

推動教育創新:視覺輔助一直是教育中傳授重要概念的關鍵工具。利用Sora,教師可以輕松地將教學計劃從文字轉化為視頻,吸引學生的注意力,提高教學效果。無論是科學模擬還是歷史重現,Sora都開辟了無限可能。

增強可訪問性:提高視覺內容的可訪問性非常重要。Sora通過將文字描述轉換為視覺內容,為包括視障人士在內的所有人提供了創作和交流的新方式。這讓更多人能夠通過視頻分享自己的想法,營造了一個更加包容的環境。

促進新興應用的發展:Sora的應用范圍十分廣泛。從營銷人員使用它創建動態廣告,到游戲開發者依據玩家的敘事生成定制化視覺效果或角色動作,Sora都展現了強大的潛力。

限制與機遇:盡管Sora取得了顯著的技術進步,但仍面臨挑戰,如更復雜動作的呈現和微妙面部表情的捕捉等。此外,確保生成內容無偏見且安全,避免不良視覺輸出的倫理問題,也是開發者和研究者必須重視的。隨著視頻生成技術的快速發展,Sora有望成為一個充滿活力的生態系統的一部分,這個系統通過合作與競爭,不斷推動創新,提升視頻品質,創造新的應用,使工作更高效,生活更加豐富多彩。

我們的貢獻:本文基于公開的技術報告和我們的逆向工程,首次全面評述了Sora的背景、相關技術、應用前景、當前的局限以及未來的機遇。

2 背景

2.1 發展歷程

在計算機視覺(CV)這個領域,深度學習帶來革命之前,人們主要依靠手工設計特征的方法來生成圖像,比如紋理合成和紋理映射。但這些傳統技術很難創造出既復雜又生動的圖像。隨后,生成對抗網絡(GANs)和變分自編碼器(VAEs)的出現成為了一個里程碑,它們在多個領域展現出了驚人的能力。緊接著,流模型和擴散模型的發展,使圖像生成的細節和質量得到了進一步提升。最近,人工智能生成內容(AIGC)技術的進步讓內容創作變得更加普及,現在用戶可以僅通過簡單的文字指令,就能創造出他們想要的內容。

在過去十年中,生成式計算機視覺模型的發展走過了多條路徑,如圖所示那樣。這個領域的轉變開始變得明顯是在Transformer架構在自然語言處理領域取得成功之后,BERT和GPT的出現便是明證。在CV領域,研究者們更進一步,將Transformer架構與視覺元素相結合,使之能夠應用于視覺領域的各種任務,如視覺Transformer(ViT)和Swin Transformer所示。

與此同時,擴散模型在圖像和視頻生成領域也取得了顯著的進展。擴散模型通過一個數學上的可靠框架,利用U-Net技術將噪聲轉化為圖像,這一過程中,U-Net通過預測和減少每步的噪聲來幫助這一轉換。

自2021年以來,AI研究的一個重點是開發能夠理解人類指令的生成式語言和視覺模型,即多模態模型。例如,CLIP是一個結合了Transformer架構和視覺元素的創新視覺-語言模型,它能夠處理大量的文本和圖像數據集。通過結合視覺和語言知識,CLIP能夠在多模態生成框架中作為圖像編碼器的角色。另一個例子是Stable Diffusion,這是一個適應性強、使用方便的多功能文本到圖像AI模型。它使用Transformer架構和潛碼擴散技術來解析文本輸入,生成各種風格的圖像,進一步展現了多模態AI的發展成就。

圖注: 視覺領域生成式AI發展史。

自ChatGPT于2022年11月面世以來,我們迎來了如Stable Diffusion、Midjourney、DALL-E 3這樣的商業文本轉圖像產品的興起。這些工具讓用戶可以通過簡單的文本提示創造出高分辨率、高質量的圖像,展現了AI在圖像創作領域的發展。

2.2 進階概念

視覺模型的擴展規律。隨著大語言模型的擴展規律逐漸明朗,人們開始探詢視覺模型是否也遵循著類似的成長路徑。最近,Zhai等人證明了,只要有充分的訓練數據,ViT模型在性能與計算力之間的關系大致呈現一種(趨于飽和的)冪律分布。緊接著,谷歌研究提出了一套高效且穩定訓練22B參數ViT模型的策略。實驗結果表明,通過凍結模型來生成嵌入,再在其上疊加幾層簡單的訓練層,便能夠取得優異的表現。作為一種大型視覺模型,Sora遵循了這些擴展原則,并在文到視頻的生成任務中展現出了多種涌現性能力,這一進步顯著地展示了大型視覺模型實現與大語言模型相似突破的可能性。

涌現性能力。大語言模型中的涌現性能力是指在模型達到一定規模時,出現的一些復雜行為或功能,這些并非開發者預先設定或預料的。這些能力之所以被稱作“涌現”,是因為它們是模型在廣泛的數據集上進行深入訓練,并依托其龐大的參數量所自然形成的。這種能力使得模型能夠建立起超越簡單模式識別或機械記憶的聯系和推理。而這些能力的出現,并不能僅通過觀察小規模模型的表現來預測。雖然如ChatGPT和GPT-4等多個大語言模型已展現出涌現性能力,但直到Sora的問世,能展現出類似能力的視覺模型還是相當稀缺。根據Sora的技術報告,它是首個證實具有涌現性能力的視覺模型,為計算機視覺領域標記了一個重要的發展里程碑。

除了涌現性能力,Sora還具備其他引人注目的能力,包括跟隨指令、視覺提示技術應用以及視頻內容理解等。這些能力的展現,代表了在視覺領域取得的重大進步,接下來的章節將對此進行更深入的探討。

3 技術

3.1 Sora框架概覽

圖注: Sora框架的反向工程概覽

Sora本質上是一個具備靈活采樣尺寸的先進技術,正如圖 4 所示。它由三大核心部分組成:

(1) 首先,一個時間-空間壓縮器將原始視頻轉換為深層的潛碼空間表示;

(2) 接下來,一個ViT處理這些潛碼的數據表示,輸出清潔、無噪聲的視頻數據表示;

(3) 最后,一個類似于CLIP的智能條件設置機制利用大語言模型增強的用戶指令和可能的視覺提示,引導視頻生成過程,創造出具有特定風格或主題的視頻。在經過多次清潔處理之后,視頻的深層表示被捕獲,并通過一個專門的解碼器轉換回可視的像素格式。本節旨在揭示Sora技術背后的原理,并與廣泛的相關研究進行對話。

3.2 數據預處理

3.2.1 視頻與圖像的多樣性:時長、分辨率與寬高比

Sora的一大特色就是它能夠處理、理解并生成各種原生尺寸的視頻和圖像,正如圖所示。與傳統方法不同,后者常將視頻調整尺寸、裁剪或改變寬高比以符合統一的標準——通常是短片段、正方形幀且分辨率固定較低。這種處理方式通常會在較寬的時間跨度內生成樣本,并依靠專門訓練的幀插入和分辨率渲染模型作為最終步驟,導致視頻內容的不連貫。Sora利用了擴散變換器架構,成為了第一個能夠適應視覺數據多樣性的模型,它可以處理各種格式的視頻和圖像,從寬屏1920x1080p到豎屏的1080x1920p,以及介于兩者之間的任何尺寸,而不會改變它們的原始尺寸。

圖注: Sora能生成各種尺寸和分辨率的圖像,范圍從1920x1080p到1080x1920p之間。

圖注: 通過將Sora(右側)與一個經過修改以將視頻裁剪為正方形的版本(左側)進行比較,可以看出Sora在保持視頻原始寬高比方面的優勢。

在原始分辨率上訓練數據,顯著提升了生成視頻的構圖和畫面布局效果。實踐證明,保持視頻的原始寬高比,Sora能創造出更加自然流暢的視覺敘事。如圖所示,與那些訓練于統一裁剪的正方形視頻的模型相比,Sora明顯占據優勢,其生成的視頻在畫面構成上做得更好,確保了場景中的主體被完整地展現,避免了正方形裁剪所常見的部分視角被切割的問題。

這種對視頻和圖像原有特征的深入洞察和保留,代表了在生成模型領域的一大進步。Sora的策略不僅展現了生成更自然、更吸引人視頻的巨大潛力,還突出了訓練數據多樣性對于獲得高品質生成式AI成果的重要性。

Sora的訓練方法遵循了Richard Sutton在《The Bitter Lesson》中提出的核心觀點,即優先利用計算力而不是人工設計的特性,能夠打造出更高效、更靈活的AI系統。正如原始的擴散變換器設計追求的簡潔性和擴展性,Sora采用原始尺寸數據訓練的策略,摒棄了傳統AI依賴于人工抽象概念的做法,轉而采用一種隨著計算力增長而擴展的全能策略。

在本節剩余部分,我們嘗試解析Sora的架構設計,并探討為實現這一杰出功能所采用的相關技術。

3.2.2 統一的視覺數據表現形式

為了能夠有效處理不同持續時間、分辨率和寬高比的圖像和視頻等多樣化的視覺輸入,一個關鍵策略是將這些不同形態的視覺數據轉化為統一的格式。這樣做不僅有助于提高生成模型的訓練效率,還能提高處理效果。

具體而言,Sora首先將視頻數據壓縮到一個更低維度的潛碼空間中,接著再將這些數據分解為時空片段(Spacetime Patches)。盡管Sora的技術報告?只是簡略地介紹了這一概念,但這使得其他研究者難以實際操作實驗。因此,我們嘗試詳細解析其可能使用的技術和方法。此外,我們還將探討一些可能的替代方案,這些方案基于現有研究成果,旨在實現與Sora相似的功能。

圖注: 從整體上來看,Sora將視頻通過首先壓縮到一個低維潛碼空間,再將其分解為時空片段的方式,轉換成片段。

3.2.3 視頻壓縮技術

圖注: ViT技術將一幅圖像分割成多個固定大小的塊,對每個塊進行線性嵌入,并加入位置信息,然后將這些向量序列輸入標準的Transformer編碼器中進行處理。

Sora的視頻壓縮技術旨在降低視頻數據的維度,生成一個在時間和空間上都進行了壓縮處理的潛碼表示(如圖所示)。根據技術報告中的引用,這一技術基于VAE或者向量量化的VAE (VQ-VAE)?。但是,技術報告也提到,如果不進行圖像的調整和裁剪,使用VAE技術將任意尺寸的視覺數據統一映射到一個固定大小的潛碼空間是有一定挑戰的。我們在這里介紹兩種可能的實現方法,以應對這一挑戰:

空間區塊壓縮(Spatial-patch Compression)技術。這項技術通過將視頻幀分割成固定大小的區塊,然后將這些區塊編碼到一個隱藏的空間中,從而處理視頻。這種方法的靈感來源于ViT和MAE的處理方式。它特別適用于處理不同分辨率和長寬比的視頻,因為它能通過單獨處理每個小區塊來編碼整個視頻幀。接下來,這些所謂的空間標記按時間順序排列,形成一個結合了空間和時間的隱藏表示,這對于視頻處理至關重要。該技術考慮到幾個關鍵點:視頻時長的變化意味著隱藏空間的時間維度不能固定。解決方案包括選取特定數量的幀(較短視頻可能需要加入額外幀或進行時間插值),或者定義一個超長的輸入長度以便后續處理;對于高分辨率視頻,推薦使用預訓練的視覺編碼器,比如穩定擴散中的VAE編碼器。

而Sora的團隊則計劃從零開始,自行訓練一個包含解碼器的壓縮網絡,后者負責生成視頻,這一過程借鑒了訓練潛碼擴散模型的方法。這些編碼器能高效壓縮大尺寸的區塊,比如256x256像素,這對于管理大量數據非常有幫助;而由于該方法主要聚焦于空間上的壓縮,因此還需要一個額外的機制來整合時間上的信息。

捕捉隨時間發生的動態變化這一方面極其關鍵,相關的深入討論將在后續章節中展開。

空間-時間片段壓縮技術。這一技術致力于同時封裝視頻數據的空間和時間維度,以提供一個全方位的表述。它不僅分析靜態畫面,還考慮了幀之間的運動和變化,有效捕捉了視頻的動態特性。采用三3D卷積技術是實現這種整合的一個直接且有效的方法。這一技術與僅對空間進行劃分的方法相比較的圖示和分析。與空間片段壓縮類似,使用空間-時間片段壓縮并設定好的卷積核參數(例如,固定的核大小、步長和輸出通道數量)會由于視頻輸入的特性差異,導致潛碼空間維度的不同。這種差異主要是由視頻的不同持續時間和分辨率引起的。為應對這一挑戰,空間劃分的方法同樣適用且有效。

圖注: 視頻壓縮中不同劃分方法的比較。

來源: ViViT。(左圖)空間劃分僅對nt幀進行采樣,并按照ViT的方式獨立嵌入每一幀2D畫面。?(右圖)空間-時間劃分則提取并線性嵌入跨越時空輸入體的非重疊或重疊的小塊。

總的來說,我們基于變分自編碼器(VAE)或其變體如向量量化-變分自編碼器(VQ-VQE)逆向工程了這兩種片段級壓縮方法,因為這樣的操作對于處理不同類型的視頻更加靈活。

鑒于Sora旨在生成高保真度的視頻,因此采用了較大的片段尺寸或核心尺寸來實現高效壓縮。這里,我們偏好使用固定尺寸的片段,以保證簡單性、可擴展性和訓練的穩定性。但是,也可以使用不同尺寸的片段,以使得整體幀或視頻在潛碼空間中的維度保持一致。然而,這可能會導致位置編碼無效,并為解碼器在生成不同尺寸潛碼片段的視頻時帶來挑戰。

3.2.4 失控潛碼片段(Spacetime Latent Patches)

在視頻壓縮網絡的設計中,我們面臨一個關鍵挑戰:如何在輸入層處理來自不同視頻類型的潛碼特征塊或片段數量的差異。本節將探討幾種可能的策略。

根據Sora的技術報告及相關文獻,一種被稱為打包與封裝 (PNP) 的方法顯得尤為合適。PNP技術能夠將不同圖片來源的多個片段整合到一個序列中,正如圖所示那樣。這種方法借鑒了自然語言處理中對變長輸入進行高效訓練的示例打包技術,通過舍棄部分詞元來適應輸入長度的變化。在壓縮網絡中,首先要完成的是片段化和詞元嵌入步驟,而Sora也可能進一步將這些潛碼特征片段化,以適配擴散變換器的詞元,如同擴散變換器本身的操作。無論是否進行第二次片段化,我們都需要解決如何高效打包這些詞元,并控制哪些詞元應當被舍棄的問題。

對于高效打包的問題,采用了一種簡單的貪心算法,該算法將示例盡可能地填充到第一個有空間的序列中,直到沒有更多示例可以加入。隨后,序列會被填充詞元補齊,以滿足批處理操作所需的固定序列長度。這種打包方式可能會因為輸入長度的分布而產生大量的填充。為了解決這一點,我們可以通過調整序列長度和控制采樣的分辨率與幀數來優化打包效率,減少填充的需要。對于舍棄詞元的策略,一種直觀的做法是去除相似的詞元,或者采用像PNP那樣的丟棄率調度策略。

但值得一提的是,保持3D一致性是Sora的一個優勢,過度舍棄詞元可能會使我們在訓練過程中忽視到一些細微的特征。

因此,我們認為OpenAI可能采用了一個極長的處理窗口來整合視頻中所有的信息片段,雖然這樣的處理方式計算成本高昂。這主要是因為多頭注意力機制在處理時,其計算成本會隨著處理序列的長度增加而呈二次方增長。具體而言,長視頻中提取的時空潛碼片段可以被組織在一個序列中,而多個短視頻的信息則被串聯組合在另一序列中。

圖注:通過片段打包技術,可以使不同分辨率的圖像或視頻維持其原始的寬高比。此外,有時候刪減信息片段也可以作為一種數據增強手段。

3.2.5 討論

我們探討了Sora可能采用的兩種數據預處理的技術解決方案。這些解決方案都是在片段層面上進行,因為它們在建模時展現出了極好的靈活性和擴展性。不同于以往將視頻統一調整大小、裁剪或修剪的方法,Sora保留視頻的原始尺寸進行訓練。雖然這樣做有其優勢,但也面臨一些技術挑戰,其中最主要的是神經網絡難以直接處理不同長度、分辨率和寬高比的視覺數據。通過技術分析,我們認為Sora首先將視覺片段壓縮成低維度的隱藏表示,然后將這些表示或進一步處理的片段以序列形式組織起來,并在輸入到擴散變換器之前,對這些隱藏片段添加噪聲。Sora采用的時空片段化方法簡單實用,它有效減少了需要處理的信息量,并降低了處理時間序列信息的復雜度。

對研究界而言,我們建議尋找成本效益高的視頻壓縮和表現形式的替代方案。這包括使用預訓練模型(如壓縮網絡),縮短處理的時間窗口,采用輕量級的建模方法,如分組多查詢注意力或高效的結構(如Mamba),必要時降低數據采樣率和減少處理的數據量。在視頻建模中尋找效果和效率的平衡是一個值得深入探討的課題。

3.2.6 擴撒變換器

圖注:DiT(左)和 U-ViT(右)的總體框架

3.3 模型構建

圖像擴散變換器介紹。傳統的擴散模型主要依賴于包括降低和提高圖像分辨率的處理塊的卷積U-Net架構,作為其去噪網絡的核心。然而,最新的研究表明,U-Net架構并非擴散模型優異性能的唯一關鍵。通過引入更加靈活的Transformer架構,基于Transformer的擴散模型能夠處理更多的訓練數據并支持更大的模型參數。在這方面,DiT和U-ViT是首批采用視覺Transformer技術構建潛碼擴散模型的先行者。與ViT類似,DiT采用了多頭自注意力機制和逐點前饋網絡,并在其中加入了層歸一化和縮放層。

更進一步,如圖所示,DiT還通過自適應層歸一化技術(AdaLN)和一個額外的MLP層來引入條件變量,這種設計使得每個殘差塊從身份函數開始,大大增強了訓練的穩定性。DiT的靈活性和擴展性已經得到了驗證,成為擴散模型的新標桿。而在U-ViT中,如圖所示,研究人員將時間、條件和噪聲圖像片段都作為輸入元素,并在Transformer的淺層和深層之間建立了長距離的跳躍連接。這一發現表明,在基于CNN的U-Net中,降低和提高分辨率的步驟并非總是必需的,U-ViT在圖像及文本到圖像轉換任務中創下了新的FID分數記錄。

如掩碼自編碼器 (MAE)?所展示,掩碼擴散變換器 (MDT)?通過在擴散過程中加入掩碼潛碼模型,有效地增強了圖像合成中各對象語義部分間的上下文關聯學習。特別地,正如圖顯示,MDT在訓練階段采用了一種輔助的掩碼令牌重建任務,通過側向插值技術,不僅提升了訓練效率,還學習到了強大的上下文感知位置嵌入,以便于推理時使用。與DiT相比,MDT 展現了更優的性能和更快的學習速度。不同于采用 AdaLN 進行時間條件建模的方法,Hatamizadeh等人引入的擴散視覺變換器 (DiffiT) 利用了一個隨時間變化的自注意力 (TMSA) 模塊,以模擬各個采樣時間點上的動態去噪過程。此外,DiffiT還采用了兩種混合層次的架構,分別針對像素空間和潛碼空間實現了高效的去噪,從而在多項生成任務中取得了前所未有的成績。總的來說,這些研究成功地利用視覺變換器處理圖像潛碼擴散問題,為未來探索其他模態的研究提供了新的思路。

圖注: 掩碼擴散變換器 (MDT) 的整體架構圖。圖中實線和虛線分別代表了訓練和推理階段的每一步操作。訓練時使用的掩碼和邊緣插值技術在推理時會被去除。

視頻擴散轉換技術。基于文本到圖像轉換(T2I)擴散模型的基礎性研究,近期研究主要致力于探索擴散轉換器在文本到視頻生成(T2V)任務中的應用潛力。視頻的時空特性給DiTs在視頻領域的應用帶來了三大挑戰:一是如何在空間和時間上有效壓縮視頻到潛碼空間進行高效去噪;二是如何將這些壓縮后的潛碼信息轉換成小塊并輸入到變換器中;三是如何處理視頻長期的時空依賴性并保證內容連貫性。

本節我們將重點討論那些設計用于在時空壓縮的潛碼空間內工作的基于變換器的去噪網絡架構,并詳細評述了OpenAI Sora技術報告參考文獻中提到的兩個重要成果——Imagen Video和Video LDM。

Imagen Video,谷歌研究推出的這款創新文本到視頻轉換系統,通過一個復雜的模型級聯流程,包括7個子模型,來實現從文本到高清視頻的轉換。這個流程首先通過一個固定的T5文本編碼器,將文本提示轉化為深層次的上下文信息,這一步對于確保視頻內容與文本指令緊密對應非常關鍵。然后,這些深層信息被整合到后續所有處理步驟中,包括基礎的視頻生成過程。接下來,這個基礎模型先產生一個低分辨率的視頻,之后再通過一系列精細的模型處理,逐步提升視頻的清晰度。

在這個轉換過程中,Imagen Video采用了一種特別的3D U-Net架構,這種設計巧妙地結合了時間和空間處理,以高效捕捉視頻幀之間的動態關系。它還運用了一些高級技術,比如穩定數值的v-預測方法,以及促進不同模型間協同訓練的條件增強技術。

通過在圖像和視頻上同時進行訓練,每個圖像都被視為視頻的一幀,這樣做能夠充分利用大量數據資源。此外,Imagen Video還采用了無分類器引導和漸進式蒸餾技術,這些技術不僅提高了生成內容的質量,還大大減輕了計算負擔,保持了視頻的高感知質量。

圖例展示了Imagen Video的整體框架,它的設計和實現體現了高度的創新性和復雜性,能夠生成各種風格、高度可控的高質量視頻內容,包括多樣的視頻、文本動畫和藝術風格的內容。

(a) 在視頻生成過程中,一個額外的時間層被添加到預訓練的模型中,這一層專門負責學習如何將單獨的幀整合成一個時間上連貫的序列。在這個過程中,模型的主體結構保持不變,只有這個時間層的參數進行調整和優化,以實現更精準的幀對齊。

(b)視頻潛碼擴散模型(LDM)技術。視頻LDM技術首先創建幾個重要但數量不多的關鍵幀,接著使用同一種潛碼擴散模型進行兩次時間上的細致插值處理,從而實現視頻的高幀率展現。在此過程的最后一步,將這些潛碼的視頻內容轉換回清晰的像素畫面,并可以選擇性地使用一個專門的視頻畫質提升模型進行進一步的優化。

圖注: 視頻LDM的整體架構示意圖。來源:視頻LDM。

Blattmann和團隊提出了一個創新思路:將傳統的二維潛碼擴散模型改進為能處理視頻內容的視頻潛碼擴散模型。他們通過在U-Net結構的基礎上和VAE解碼器中增加特定的時間處理層來實現這一目標,這些層專門用來整合和對齊視頻幀。這種時間層針對編碼后的視頻數據進行訓練,而空間處理層則保持不變,這樣做能夠有效利用大規模的圖像數據集進行預訓練。通過對LDM解碼器進行微調,增強其在時間上的連貫性和空間分辨率,從而能夠產生空間細節更豐富、時間上更為一致的視頻效果。

此外,為了生成長度更長的視頻,研究團隊設計了一種基于上下文幀預測未來幀的訓練方式,使得視頻在生成過程中不需要分類器的引導也能保持高質量。視頻的高時間分辨率是通過首先生成關鍵幀然后在關鍵幀之間進行插值來實現的。采用這種分步驟的方法,最終通過擴散模型將視頻內容的空間分辨率提高了四倍,既保證了畫面的高清晰度也保持了時間上的流暢性。這種方法不僅提高了視頻生成的全局連貫性,而且大幅提升了計算效率。此外,該團隊還成功地將已經訓練好的圖像LDM(例如Stable Diffusion)轉換為能夠生成文本到視頻內容的模型,僅通過對時間對齊層的訓練,就實現了最高達到1280 ×2048分辨率的視頻合成能力。

3.2.2 討論

空間與時間細化的級聯擴散模型。Sora能夠制作高清視頻。通過研究現有的文獻和對Sora進行逆向工程分析,我們推測它采用了一種特殊的模型架構,稱為級聯擴散模型。

這種架構包括一個基本模型和多個用于細化空間和時間的模型。在這個體系中,基礎模型和低分辨率模型可能不會大量使用注意力機制,因為在處理高分辨率視頻時,注意力機制的計算成本高且性能提升有限。為了保證視頻和場景在空間和時間上的連貫性,Sora更注重時間連貫性而非空間連貫性,因為研究顯示時間連貫性對視頻或場景的生成更為關鍵。因此,Sora可能采用了一種高效的訓練策略,使用時間較長但分辨率較低的視頻來實現時間上的連貫性。此外,考慮到其優越的性能,Sora可能使用了一種特殊的v-參數化擴散模型,這種模型在預測原始潛碼變量x或噪聲?方面比其他模型更為出色。

關于潛編碼器的思考。為了提高訓練效率,許多現有的研究選擇使用預訓練的穩定擴散VAE編碼器作為模型訓練的起點。但這些編碼器缺少處理視頻時間信息的能力。盡管有研究建議僅微調解碼器來處理時間信息,但解碼器在處理壓縮潛碼空間中的視頻時間數據時,性能仍然不盡人意。根據技術報告,我們的分析表明,與其使用預訓練的VAE編碼器,Sora更可能采用從頭開始訓練的空間-時間VAE編碼器,這種編碼器針對視頻數據進行優化,其性能超越了現有技術,特別是在處理視頻壓縮潛碼空間方面。

3.4 跟隨語言指令

用戶通常通過輸入自然語言的指令來與生成式AI模型互動,這些指令也就是我們所說的文本提示。為了讓AI模型更準確地理解并執行這些文本指令,研究人員開展了模型指令優化的工作。這種優化讓模型在處理文本查詢時能夠生成更貼近人類自然反應的回答。我們的討論從大語言模型(LLMs)及DALL·E 3這樣的文本到圖像模型開始,探討它們是如何通過技術進步來更好地理解和執行指令的。Sora在提升文本到視頻模型理解文本指令的能力方面,采取了與DALL·E 3相似的策略,通過訓練一個專門的描述性字幕制作器,并利用其生成的數據來進行模型的微調。

這樣的優化讓Sora能夠精準地響應各種用戶需求,無論是對指令細節的精確捕捉,還是生成完全符合用戶預期的視頻。

3.4.1 大語言模型

大語言模型在理解并執行指令方面的能力得到了深入研究。這項能力使得大語言模型能夠閱讀、理解并恰當地回應那些描述著尚未遇到的任務的指令,而且這一切都無需給出示例。通過在一系列以指令形式呈現的任務上進行微調,大語言模型不僅學會了如何跟隨指令,還在處理未曾遇見的任務上表現出了卓越的能力。Wei等人的研究表明,經過這種指令優化的大語言模型在處理新任務時,其性能遠超那些未經優化的模型。這種跟隨指令的能力標志著AI發展進入了一個全新的階段,大語言模型現在已經成為了可以處理各種任務的通用解決方案。

3.4.2 文字轉圖片

DALL·E 3所采用的策略基于一個核心假設:模型訓練所用的文本-圖片對質量直接影響到最終生成的文字到圖片模型的表現。數據質量低下,尤其是充斥著的噪聲數據和缺少大量視覺信息的簡短標題,會引起諸如忽略關鍵詞、混淆詞序以及誤解用戶意圖等一系列問題。為了解決這些問題,提出了一種通過為現有圖片重新編寫更詳盡描述性的標題的方法。該過程首先是訓練一個能生成精確描述性圖像標題的視覺-語言模型。隨后,這些生成的描述性圖像標題被用于微調文字到圖片模型。具體而言,DALL·E 3采用了一種稱為對比字幕器(CoCa)的方法,該方法將一個圖像字幕器和語言模型目標進行聯合訓練,該字幕器基于CLIP架構。

這個系統包括了圖像編碼器、用于提取語言信息的單模態文本編碼器和多模態文本解碼器。它首先使用圖像與文本單模態嵌入間的對比損失,然后是多模態解碼器輸出的字幕生成損失。在經過微調后,圖像字幕器能夠根據包括主要物體、環境、背景、文字、風格和顏色等細節描述生成詳細的圖像標題。文字到圖片模型的訓練數據集是由這種重新標注的數據集與真實的人類編寫數據混合構成的,確保了模型能準確捕捉用戶意圖。這種圖像標題改進方法可能會引入實際用戶指令與訓練數據中描述性圖像描述不匹配的問題。DALL·E 3通過一種稱為“上采樣”的技術解決這一問題,即利用大語言模型 (LLMs) 將簡短的用戶指令擴展成更為詳細和長篇的指導,保證了模型在推理時接收到的文本輸入與訓練期間的輸入一致。

3.4.3 從文字到視頻

為了提升模型按照指令執行的能力,Sora采取了一種提升視頻描述能力的方法。這個過程首先是訓練一個視頻描述生成器,該生成器能夠為視頻創建詳盡的描述。接著,把這個生成器用于訓練集中的所有視頻,生成高質量的視頻及其描述性字幕對,用這些數據對Sora進行微調(fine-tune),以增強它的指令理解和執行能力。

Sora的技術報告沒有詳細說明視頻描述生成器的訓練細節。考慮到該生成器是一個將視頻轉換為文字的模型,構建這種模型的方法有很多種。一個簡單的方法是使用CoCa架構來進行視頻描述,即抓取視頻的多幀,并將每幀獨立輸入圖像編碼器,這一過程稱為VideoCoCa。

VideoCoCa在CoCa基礎上,重用了圖像編碼器的預訓練權重,并將其獨立應用于選取的視頻幀上。這些幀的嵌入表示被平整化后串聯成一個長視頻表示序列。然后,這些序列通過生成式池化器和對比池化器進行處理,這兩種池化器通過對比損失和描述生成損失共同訓練。構建視頻描述生成器的其他方法還包括mPLUG-2、GIT、FrozenBiLM等。最后,為了確保用戶的輸入與訓練數據中的描述性字幕格式一致,Sora還進行了一步額外的輸入擴展操作,通過GPT-4V把用戶的簡短輸入擴充為更詳細的描述性提示。

3.4.4 討論

Sora能夠根據用戶的指令創造出長達一分鐘、場景復雜且符合用戶意圖的視頻,這種指令執行能力至關重要。Sora的技術報告透露,這一能力是通過開發一個能生成詳盡字幕的系統獲得的,這些詳盡的字幕隨后被用來訓練模型。但是,如何收集用于訓練此系統的數據仍是一個謎,這個過程可能非常耗時,因為它需要對視頻內容進行詳細的描述。此外,視頻描述系統有時可能會錯誤地添加視頻中并不存在的細節。我們認為,改進視頻描述系統,以更好地遵循指令,是一個值得進一步探究的關鍵問題。

3.5 提示工程

所謂提示工程,是指為了達到特定目標或優化結果而對AI系統輸入內容的設計與優化過程,尤其適用于生成模型領域。提示工程既是一門藝術也是一門科學,它通過巧妙設計輸入,引導模型生成更準確、相關且邏輯連貫的回應。

3.5.1 文本提示技巧

在將文本轉換為視頻的過程中,文本提示的設計至關重要,它能夠指導模型(如Sora)創造出既符合用戶需求又視覺上引人注目的視頻。這一過程包括精心編寫詳細的描述,以便模型能夠有效地將人類的創意思維和AI的執行力結合起來。Sora 的文本提示覆蓋了多種情境。近期的研究,如VoP、Make-A-Video以及 Tune-A-Video,展示了文本提示如何利用模型對自然語言的理解能力,將復雜的指令轉化為連貫、生動且高質量的視頻故事。正如圖展示,“一位穿著時尚,在東京燈火輝煌的街道上漫步的女性……”這樣一個精心設計的文本提示,確保了Sora能夠制作出與期望視覺完美契合的視頻。優秀的文本提示設計在于精確選擇每一個詞匯、詳細說明每一個細節,以及深刻理解這些因素如何影響模型的最終輸出。

圖注: 一個關于如何通過文本提示在文本到視頻轉換中進行創意設計的案例研究,使用顏色代碼明確區分創作過程。藍色高亮部分描述了Sora生成的元素,如展現一位時尚女性的形象;而黃色部分則強調了模型如何解釋動作、場景和角色造型,展示了一個精心構思的文本提示是如何被轉化為一段生動、充滿動感的視頻故事的。

3.5.2 圖像提示

圖像提示為視頻創作提供了一種視覺基準,讓即將制作的視頻內容、角色、場景和氛圍等元素得以具象化。通過結合文本提示,模型能夠為這些靜態元素注入生命,比如添加運動效果、互動和故事發展等,使圖像變得生動。利用圖像提示,Sora能夠將靜態圖片轉化為充滿故事性的動態視頻,這一過程中既利用了視覺信息也利用了文本信息。在圖中,我們展現了幾個示例,包括“一個戴貝雷帽和高領衫的柴犬”、“一個別致的怪物家族”、“形成‘SORA’字樣的云朵”和“沖浪者在古老大廳中駕馭巨浪”。這些示例充分展示了,通過向Sora提供DALL·E生成的圖像作為啟發,可以創造出何種水平的視頻內容。

圖注:這個示例展示了圖像提示是如何指引Sora的文本到視頻模型創造出視頻的。紅色框體突出顯示了每個場景的核心元素——多樣化設計的怪物、拼成“SORA”的云朵,以及在裝飾華麗的大廳中面對巨大潮浪的沖浪者。

3.5.3 視頻提示技巧

視頻提示技術已被證明可以用于創造視頻內容,如文獻研究顯示。近期的研究,如Moonshot和Fast-Vid2Vid,表明有效的視頻提示既要具體又要靈活。這樣不僅可以確保模型明確了解到具體的創作目標,比如要展示的特定物體和視覺風格,還能在最終的視頻作品中加入創新的變化。例如,在視頻擴展任務中,可以通過提示來指明視頻展開的方向(時間向前還是向后)以及內容的主題或背景。

如圖(a) 所示,通過視頻提示,可以讓Sora將視頻向后延伸,探索起始點之前發生的事件。在使用視頻提示進行視頻編輯時,正如圖?(b) 所展示的那樣,模型需要清晰地識別出需要的改變,無論是視頻的風格、場景設置還是氛圍的變化,或是像燈光或情緒這樣的細節調整。

在圖(c) 中,提示引導Sora將不同的視頻片段連接起來,并確保視頻中不同場景的物體之間能夠平滑過渡。

圖注:這些示例展示了對Sora模型使用視頻提示技巧的幾種方式:(a) 視頻擴展,模型將視頻序列向原始片段的相反方向推進,(b) 視頻編輯,根據文本提示對視頻中的特定元素,比如場景進行改變,以及 (c) 視頻連接,通過兩個不同的視頻提示將視頻片段無縫結合,創造出一個連貫的故事。每個步驟都受到一個視覺焦點的引導,用紅色框標出,保證視頻內容的連貫性和準確性。

3.5.4 討論

通過巧妙設計提示,我們可以引導AI模型創造出符合用戶意愿的內容。以Sora為例,它通過結合文本、圖片和視頻的提示,不僅能創作出吸引眼球的內容,還能精準捕捉用戶的期望和意圖。盡管之前的研究主要關注文本和圖片的提示技術,特別是在大語言模型和大視覺模型的應用上,我們預計未來視頻提示在視頻內容生成領域將會受到越來越多的關注。

3.6 可信性

隨著ChatGPT、GPT4-V和Sora等高級模型的快速進步,它們的功能已經得到了極大的增強,為提高工作效率和促進技術革新作出了顯著貢獻。但是,這些進步同時也帶來了一系列問題,如假新聞的產生、隱私泄漏以及倫理道德的挑戰。因此,如何確保這些強大的模型可靠且不被濫用,已經成為了學術界和產業界共同關注的重點議題。

3.6.1 安全問題

模型的安全性是一個重點關注領域,特別是其在面對誤用和“越獄”攻擊的抵抗能力方面。越獄攻擊指用戶嘗試通過漏洞生成違禁或有害內容的行為。例如,引入了AutoDAN,這是一種基于梯度技巧的創新且易于理解的對抗性攻擊方式,用于實現對系統的繞過。近期研究發現,大語言模型 (LLM) 在抵御越獄攻擊時面臨的兩大挑戰包括目標不一致和泛化能力不匹配。除了文本攻擊,對于多模態模型(如GPT-4V和Sora)來說,視覺越獄同樣構成安全威脅。最近的一項研究發現,由于額外的視覺輸入的連續和高維特性,大型多模態模型對對抗性攻擊更加敏感,這增加了潛碼的攻擊范圍。

3.6.2 其他利用問題

鑒于大型基礎模型(如ChatGPT和Sora)在訓練數據集的規模和方法上的先進性,提升這些模型的真實性變得尤為重要,尤其是面對廣泛討論的諸如“虛假輸出”等相關問題。“虛假輸出”在此背景下,指的是模型生成的回答可能聽起來令人信服,但實際上是沒有依據或是錯誤的。這一現象對模型輸出的可靠性和信賴度提出了挑戰,迫切需要采取全面措施來評價并解決此問題。已有大量研究致力于從多角度探討“虛假輸出”問題,包括評估不同模型和場景下“虛假輸出”的范圍和本質。這些評估為理解“虛假輸出”發生的原因和方式提供了重要見解,為制定減少其發生策略奠定了基礎。與此同時,目前大量研究正集中于發展和實施減少大模型中“虛假輸出”發生的方法。

公平性與偏差問題是建立信任的另一核心要素。開發既不傳遞也不加劇社會偏見的模型至關重要,因為這些模型中的偏差會加深社會不平等,導致不公平的結果。正如Gallegos、Zhang、Liang等人,和Friedrich等人的研究所展示,致力于精確識別和消除這些偏差。目標是開發出公正的模型,平等對待每一個人,不論種族、性別或其他敏感因素。這不僅需要識別和減少數據集中的偏差,還需要設計能夠積極阻止偏差擴散的算法。

隨著這些模型的部署,數據隱私保護成為一個基礎性的支柱。在對數據隱私日益關注的今天,保護用戶信息的重要性前所未有。隨著公眾對個人數據處理方式越來越關心,大模型的評估變得更加嚴格,這些評估著重于確保個人信息的安全,避免不小心泄露信息。Mireshghallah等人,Plant等人,和Li等人的工作,推動了保護隱私技術和方法的發展。

3.6.3 模型對齊

在應對這些挑戰的過程中,確保大型模型值得信賴已成為研究者們格外關注的一個核心問題。模型對齊技術是其中極為關鍵的一環,它旨在確保模型的行為和產出能夠符合人類設計者的初衷和倫理規范。這不僅涉及技術開發本身,還包括其所承擔的道德責任和反映的社會價值。在大語言模型的研究領域里,結合了強化學習和直接人類反饋的“以人類反饋為導向的強化學習”(RLHF)方法已被廣泛采用來實現模型對齊。通過這種方法,模型能夠更精準地根據人類的預期和標準來理解和完成任務。

3.6.4 討論

通過分析Sora的技術報告,我們發現了幾個深具啟示性的觀點,這些觀點對于指導未來的研究方向具有重要價值:

(1) 模型與外部防護的全面保障:隨著生成型模型的能力日益增強,如何避免它們被濫用生成有害內容,比如仇恨言論和虛假信息,成為了一大挑戰。除了加強模型自身的道德約束,外部的安全防護措施同樣不容忽視,包括內容過濾、審查機制、使用許可與訪問控制、數據隱私保護以及提升透明度和可解釋性等。例如,OpenAI利用檢測分類器來判斷視頻是否由Sora生成,并部署文本分類器來識別可能的有害文本輸入。

(2) 多模態模型面臨的安全難題:Sora這樣的文本到視頻模型引入了新的安全挑戰,由于它們能夠處理和生成多種類型的內容(如文本、圖片、視頻等),這不僅增加了濫用的途徑,也帶來了版權問題。由于這些模型生成的內容更加復雜多元,傳統的內容驗證方法可能不再適用,這就需要我們開發新的技術和方法來鑒別和過濾有害內容,提高監管和管理的難度。

(3) 需要跨領域的合作:確保模型安全并非僅是技術層面的問題,它還需要法律、心理學等多個學科領域的專家共同努力,以形成共識(比如,什么是安全的,什么是不安全的)、制定政策和開發技術解決方案。這種跨學科的合作極大地增加了解決這些安全問題的復雜度。

4 應用領域

隨著Sora這類視頻擴散模型成為尖端技術,它們在各個研究領域和行業的應用正迅速擴展。這項技術的潛力遠不止于視頻制作,它還能在自動化內容生成、復雜決策過程等任務中發揮變革性作用。本節我們將深入探索視頻擴散模型當前的應用情況,并重點介紹Sora如何不僅展現了其強大能力,而且徹底改變了我們解決復雜問題的方式。我們旨在展現這些技術在實際應用場景中的廣泛前景。

圖注: Sora的應用案例。

4.1 電影產業

傳統電影制作是一個費時費力且成本高昂的過程,往往需要幾十年的時間、先進設備和巨額投資。但現在,隨著高級視頻生成技術的出現,電影制作迎來了新紀元:通過簡單的文本輸入就能自動生成電影,這一夢想正在成為現實。研究人員利用視頻生成模型拓展到電影制作領域,開創了電影生成的新篇章。

例如,MovieFactory利用擴散模型根據ChatGPT生成的精細劇本生成電影風格的視頻,標志著技術上的一大進步。隨后,MobileVidFactory能夠僅憑用戶提供的簡文本自動創作豎屏移動視頻。Vlogger讓用戶能以此技術創作出一分鐘長的視頻日志。Sora輕松生成吸引人電影內容的能力,預示著電影制作民主化的新時代。這展現了一個未來景象,任何人都有機會成為電影制作人,極大降低了進入電影界的門檻,并引入了一種新的電影制作維度,將傳統敘述與AI驅動的創意完美融合。

這些技術不僅簡化了電影制作過程,還有望徹底改變電影制作領域的面貌,使其更加開放、多樣化,更好地適應觀眾不斷變化的偏好和分發渠道的發展。

4.2 教育革新

長期以來,教育領域的內容主要由靜態資源構成,雖然這些資源具有一定的價值,但它們往往無法滿足當前學生的多元化需求和學習方式。視頻擴散模型作為教育革命的先鋒,開創了定制化和活化教育材料的新篇章,極大地提高了學習者的參與度和理解能力。這些尖端技術讓教育工作者能夠把文字描述或課程大綱轉換成充滿活力、吸引人的視頻內容,這些內容根據每個學生的獨特風格和興趣量身定制。

此外,圖像至視頻的編輯技巧為將靜態教育資源變為互動視頻提供了創新方法,滿足了各種學習偏好,有望進一步提升學生的參與感。將這些模型融入教育內容的創作中,教師們可以就各種主題制作視頻,讓復雜的概念變得更加通俗易懂,為學生們帶來吸引力。使用Sora來顛覆傳統教育領域,展現了這些技術改變游戲規則的潛力。這種向個性化、動態教育內容的轉變,標志著教育領域新紀元的到來。

4.3 游戲行業

游戲產業始終在尋找方法,以突破真實感和沉浸體驗的邊界。然而,傳統的游戲開發往往受限于預設的環境和劇本事件。

現在,利用擴散模型實時生成的動態高清視頻內容和逼真音效,有望突破這些限制。這為游戲開發者們開辟了新天地,使他們能夠創造出隨玩家行為和游戲事件自然變化的游戲環境?。這包括能夠即時生成變化的天氣、變幻的景觀,乃至于創造全新的游戲場景,讓游戲世界變得更加生動和反應靈敏。有些技術還能根據視頻輸入生成真實的碰撞聲音,提升游戲的音效體驗。整合了Sora技術的游戲領域,能夠創造出前所未有的沉浸式體驗,極大地吸引玩家。這不僅將改變游戲的開發和玩法方式,還將開啟講故事、互動和沉浸體驗的新篇章。

4.4 醫療保健

在醫療保健領域,盡管主要強調創造能力,視頻擴散模型在理解和生成復雜視頻序列方面的能力,使其特別適合于識別身體內部的動態變化,如細胞早期的自我消亡、皮膚病變的發展以及不規則的人體運動。這對早期發現疾病并采取干預措施至關重要。

此外,像MedSegDiff-V2這樣的模型利用變換器技術,以空前的精確度進行醫學圖像分割,使醫生可以更準確地識別出各種成像技術中的關鍵區域。通過將Sora技術融入臨床實踐,不僅可以優化診斷流程,還可以根據精確的醫學成像分析,為患者提供定制化的治療方案。然而,技術的融合也帶來了挑戰,包括必須建立強有力的數據隱私保護措施,并在醫療實踐中考慮倫理問題。

4.5 機器人

在機器人領域,視頻擴散模型正開啟一個新篇章,它們不僅能創造和理解復雜的視頻內容,從而極大地提升機器人的感知能力,還能夠在決策制定上發揮關鍵作用。這項技術讓機器人擁有了前所未有的互動及執行復雜任務的能力。通過引入大規模的擴散模型,我們看到了機器人視覺和理解能力的巨大提升潛力。

例如,現在的機器人可以通過“潛碼擴散模型”接收語言指令來預測視頻中的動作結果,這意味著它們能夠更好地理解和完成任務。此外,利用視頻擴散模型創造出的高度逼真的視頻序列,解決了機器人研究依賴模擬環境的局限性,為機器人提供了豐富多樣的訓練場景,克服了真實世界數據不足的問題。我們認為,將像Sora這樣的尖端技術融入機器人學,將會帶來革命性的進展。利用Sora的強大功能,機器人學的未來將實現空前的飛躍,使得機器人能夠更自然地與周圍環境互動和導航。

5 討論

Sora展現了其對人類復雜指令的精確理解和執行能力,特別擅長創作設置在精心布置的場景中、涵蓋多種角色的細節豐富的視頻。其最引人注目的特點之一是能夠生成長達一分鐘的視頻,并保持始終如一且吸引人的敘事。這在先前主要關注制作更短視頻的嘗試中是一個重大進步,因為Sora的視頻不僅敘事流暢,還能從頭到尾維持視覺連貫性。

此外,Sora能創造出描繪復雜動作和互動的長視頻,突破了早期模型僅能處理短視頻和基礎圖像的局限。這一進展是AI驅動創意工具的一大飛躍,讓用戶有能力將文本故事轉換為具有前所未有的細節和復雜度的生動視頻。

5.1 局限性

面對物理真實性的挑戰,Sora作為一個仿真平臺,在準確再現復雜情境方面存在一些局限。其中最顯著的問題是它在處理復雜場景時對物理規則的應用不一致,有時候無法準確模擬出因果關系的特定例子。比如,吃掉一塊餅干可能不會留下明顯的咬痕,這種情況反映了系統偶爾會偏離物理的合理性。這一問題也影響到了運動的模擬,Sora在模擬運動時,有時會產生與現實物理不符的動作,比如物體的不自然變形或是椅子這類剛體結構的不正確模擬,導致了不現實的物理互動。在模擬物體和角色之間復雜的相互作用時,問題更加明顯,偶爾還會產生一些更傾向于幽默的結果。

空間和時間方面的復雜性也是一個挑戰。Sora有時會誤解有關物體和角色在場景中的放置或排列的指令,造成方向上的混淆(比如將左和右弄反)。同時,它在維持事件發生的時間順序上也面臨挑戰,尤其是在遵循特定的攝影機移動或場景順序時,可能會偏離原計劃的時間線。在涉及許多角色或元素的復雜場景中,Sora偶爾會加入一些與場景無關的動物或人物,這種情況可能會大幅改變場景原本的設想和氛圍,偏離預定的敘事或視覺布局。這不僅影響了模型再現特定場景或敘事的準確性,也影響了其產出內容與用戶期望及內容連貫性緊密對齊的可靠性。

在人機交互(HCI)方面,盡管Sora在視頻生成領域展現了潛力,但它在HCI方面存在顯著的限制。這些限制主要體現在用戶與系統交互的連貫性和效率上,尤其是在對生成的內容進行詳細的修改或優化時。例如,用戶可能難以精確地指定或調整視頻中特定元素的展示,如動作的細節和場景的過渡。

此外,Sora在理解復雜的語言指令或把握細微的語義差異方面也顯示出限制,可能導致視頻內容無法完全滿足用戶的期望或需求。這些問題限制了Sora在視頻編輯和增強方面的應用潛力,也影響了用戶體驗的總體滿意度。

使用限制方面,OpenAI對公眾開放Sora的具體上線時間持謹慎態度,強調在進行廣泛推廣前,需要確保安全性和準備工作充分。這意味著,在安全、隱私保護及內容審查等方面,Sora還需經過進一步的完善和測試。目前,Sora生成的視頻最長只能達到一分鐘,根據已發布案例,多數視頻僅有數十秒的長度。這一局限性使其難以應用于需要展示較長內容的場合,如詳盡的教程視頻或深入的故事講述,從而影響了Sora在內容創作上的靈活度。

5.2 機遇

在學術界,OpenAI推出Sora是向著鼓勵AI社區更深層次探索文本到視頻模型、并利用擴散及變換器技術的戰略轉型的一大步。此舉意在引導關注點轉向利用文本描述直接創造出復雜細膩視頻內容的潛能,這一領域的探索預示著內容創作、敘事及信息共享方式的革命性變革。此外,Sora在其原生尺寸數據上的訓練方法,與傳統的縮放或裁剪相比,為學術界提供了新的啟示,突出了使用未修改數據集的優勢,為生成更先進模型鋪平了道路。

在行業方面,Sora目前的能力展現了視頻仿真技術發展的廣闊前景,特別是在提高物理及數字領域真實度方面的潛力。通過文本描述能夠創造出高度真實環境的能力,為內容創作領域帶來了光明的未來,尤其是在游戲開發上,展示了用前所未有的簡易度和精準度創造沉浸式世界的可能。此外,企業可以利用Sora快速適應市場變化,制作定制化的營銷視頻,這樣不僅可以降低生產成本,還能提升廣告的吸引力和效果。Sora依靠文本描述獨自生成高度真實視頻的能力,有望徹底變革品牌與觀眾的互動方式,創造出既吸引人又引人入勝的視頻,以新穎的方式展現其產品或服務的核心價值。

社會影響。

(1)盡管利用文本轉視頻技術替代傳統電影制作的想法還很遙遠,但Sora和類似的平臺對社交媒體內容創作具有革命性的影響力。現有的視頻長度限制并未影響這些工具使高質量視頻制作變得普及的潛力,讓每個人都能夠輕松制作引人入勝的內容,無需依賴昂貴的設備。這標志著內容創作者在TikTok和Reels等平臺上被賦予了更大的權力,開啟了創意和參與度的新紀元。

(2)編劇和創意人員可以借助Sora把書面劇本變為視頻,這不僅幫助他們更生動地展示和分享創意想法,還能制作短片和動畫。將劇本轉化為詳細生動的視頻,這一能力將徹底改變電影和動畫前期制作的過程,預示著未來故事講述者可能如何推介、發展和精煉他們的故事。這項技術為劇本開發引入了一種更動態、互動的方式,使創意想法可以即時可視化和評估,成為創新和合作的有力工具。

(3)記者和新聞機構也可以通過Sora快速制作新聞報道或解說視頻,讓新聞內容更加鮮活和引人關注。這大大提高了新聞報道的傳播范圍和觀眾的參與程度。Sora提供了一種強大的視覺敘事工具,通過模擬真實環境和場景,幫助記者以先前難以實現或成本高昂的視頻形式講述復雜的故事。綜上所述,Sora在推動營銷、新聞和娛樂內容創作革命方面擁有巨大的潛力。

結論

我們綜合回顧了Sora,旨在幫助開發者和研究者深入了解其功能和相關研究。這項工作基于我們對已發布技術報告的調研和現有文獻的逆向工程。隨著Sora的API開放和更多細節的披露,我們將持續更新這篇論文。我們期待這篇綜述能為開源研究社區提供價值,為未來社區共同開發Sora的開源版本鋪平道路,實現在AIGC時代的視頻自動創作民主化。為此,我們歡迎各方的討論、建議和合作。

作者:Yixin Liu、Kai Zhang、Yuan Li、Zhiling Yan、Chujie Gao、Ruoxi Chen、Zhengqing Yuan、Yue Huang、Hanchi Sun、Jianfeng Gao、Lifang He、Lichao Sun(利哈伊大學;微軟研究院)

用pytorch實現線性回歸)

—13獲取《人民網》【最新】【國內】【國際】寫入Word(附完整代碼))

(含源碼)(圖文版))

)

)

)

:能源行業應用)