mamba相關的圖像分割:VM-Unet,Manba-Unet,BRAU-Net++,MDD-Unet,EGE-Unet,U-Mamba

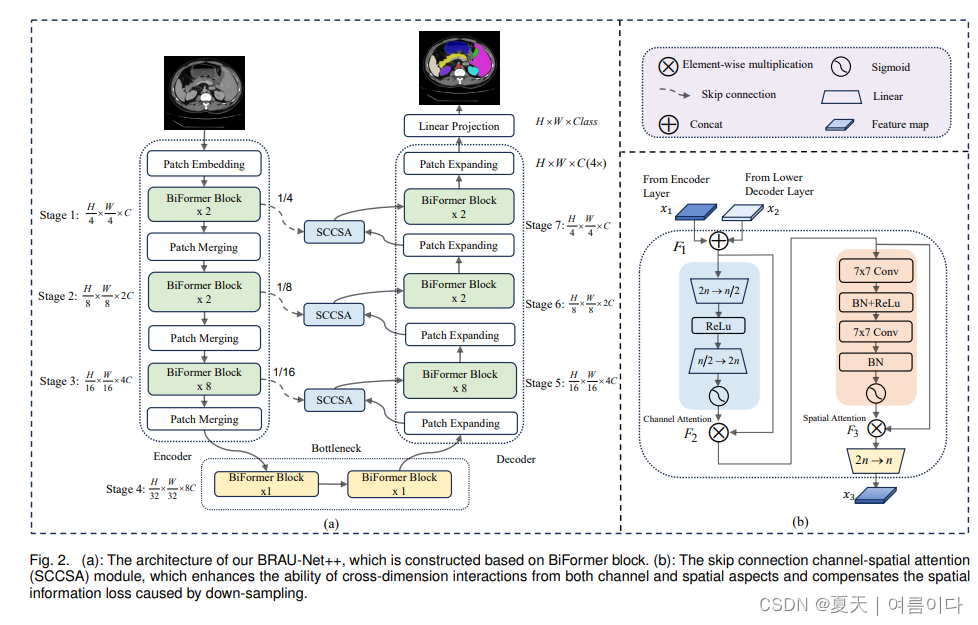

2024.01.01_BRAU-Net++

Paper:BRAU-Net++: U-Shaped Hybrid CNN-Transformer Network for Medical Image Segmentation

https://arxiv.org/pdf/2401.00722.pdf

2024.01.09_U-Mamba

Paper:U-Mamba: Enhancing Long-range Dependency for Biomedical Image Segmentation

arxiv.org/pdf/2401.04722.pdf

Code:bowang-lab/U-Mamba: U-Mamba: Enhancing Long-range Dependency for Biomedical Image Segmentation (github.com)

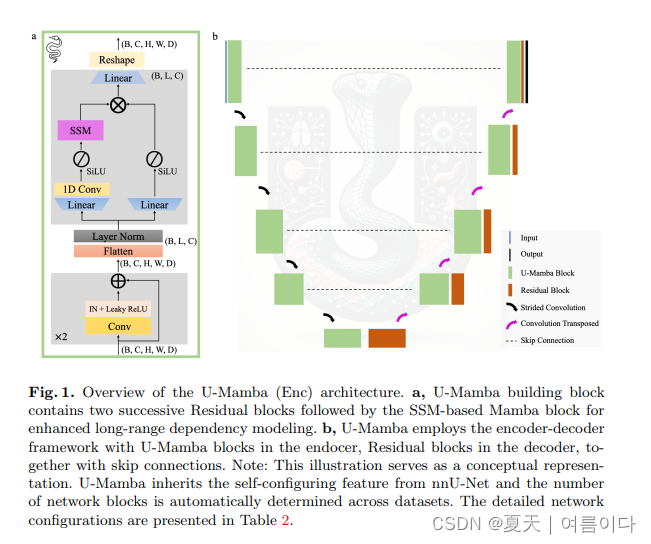

受狀態空間序列模型(SSM)這一新的深度序列模型家族的啟發,該模型以其處理長序列的強大能力而聞名,論文設計了一個混合 CNN-SSM 模塊,它將卷積層的局部特征提取能力與以下能力集成在一起: 用于捕獲遠程依賴性的 SSM。 此外,U-Mamba 具有自我配置機制,無需人工干預即可自動適應各種數據集。

?

?

?

?

2024.02.04_VM-UNet

Paper:VM-UNet: Vision Mamba UNet for Medical Image Segmentation2402.02491.pdf (arxiv.org)

Code:JCruan519/VM-UNet: This is the official code repository for "VM-UNet: Vision Mamba UNet for Medical Image Segmentation". (github.com)

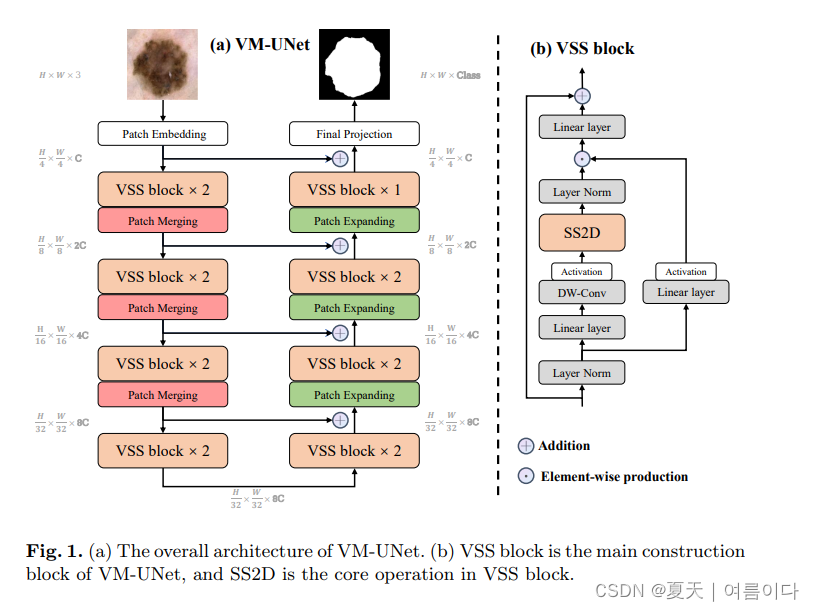

?論文框架包含了:Patch Embedding layer, an encoder, a decoder, a Final Projection layer, and skip connections.

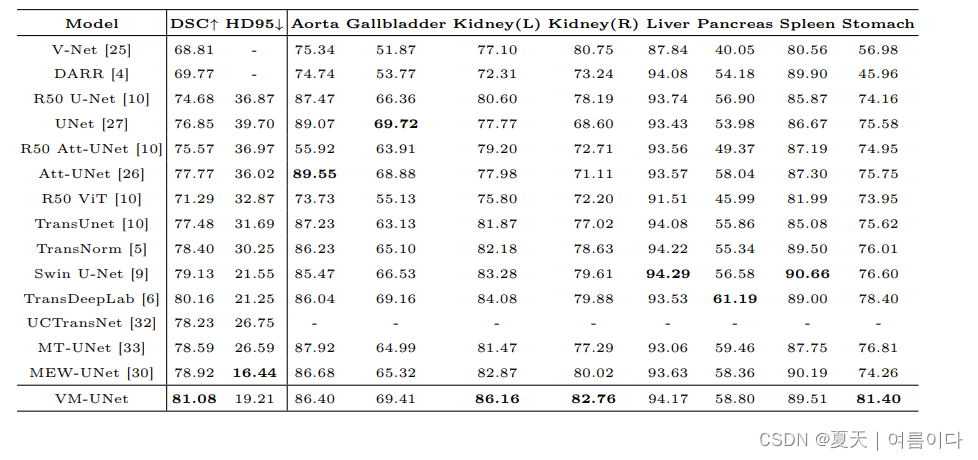

結果

?2024.02.05_Swin-UMamba:基于Mamba和ImageNet預訓練的醫學圖像分割模型

Paper:2402.03302.pdf (arxiv.org)

Code:JiarunLiu/Swin-UMamba: Swin-UMamba: Mamba-based UNet with ImageNet-based pretraining (github.com)

總結

- 相比較于U-Mamba,Swin-UMamba在三種醫學圖像分割任務指標上可以取得平均3.58%的提升。

- 該篇工作通過實驗驗證了ImageNet預訓練對基于Mamba的醫學圖像分割模型起到非常重要的作用,在迭代次數不變的情況下最高可為Swin-UMamba帶來13.08%的DSC提升。

- 提出了一種變體網絡Swin-UMamba,其僅需要相比于U-Mamba不到1/2的網絡參數量和約1/3的FLOPs就能夠實現與Swin-UMamba相近的性能。

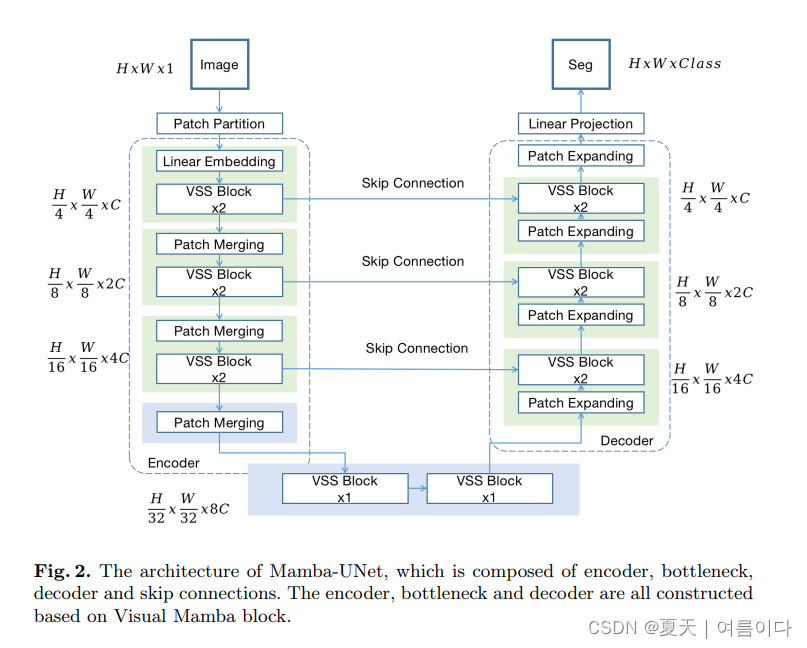

2024.02.07_Mamba-UNet

?Paper:Mamba-UNet: UNet-Like Pure Visual Mamba for Medical Image Segmentation2402.05079.pdf (arxiv.org)

Code:JCruan519/VM-UNet: This is the official code repository for "VM-UNet: Vision Mamba UNet for Medical Image Segmentation". (github.com)

在本論文中,簡單介紹了之前論文的VSS塊,編碼器,解碼器,Bottleneck & Skip Connetions

在本文中作者認為與典型的視覺轉換器不同,VSS 模塊了位置嵌入。視覺轉換器不同,它沒有 MLP 結構、所以就能在相同的深度預算內堆疊更密集的區塊。

參考文獻

【1】2024.01.18_VMamba: Visual State Space Model2401.10166.pdf (arxiv.org)

【2】VM-UNet:視覺Mamba UNet用來醫學圖像分割 論文及代碼解讀_vision mamba-CSDN博客?

)

項目啟動過程--JobTriggerPoolHelper 初始化 (3))

:函數、作用域、匿名函數)

)