1.什么是Token

Token是GPT處理文本的基本單位。Token可以是一個字、一個詞語或特定語言中的一個字符。它們負責將輸入的文本數據轉換為 GPT 可以處理的數據格式。每個 GPT 模型都有一個預設的最大 Tokens 數量,例如,GPT-3 每次調用允許處理的最大 Tokens 數量約為 4096;GPT4則允許處理3萬多個Token, 這個數量包括用戶輸入和GPT輸出的所有 Tokens。

- 當我們在使用大模型時,判斷輸入的內容是否會超過大模型的輸入的最大tokens數量是非常重要的,以避免被截斷

- 在調用大模型API時是以token為單位進行收費的,知道自己的輸入大概所占的token數,能預算使用過程中產生的消費

2.計算

簡單計算: 通常1k token ≈ 750個英文單詞 ≈ 400~500個漢字

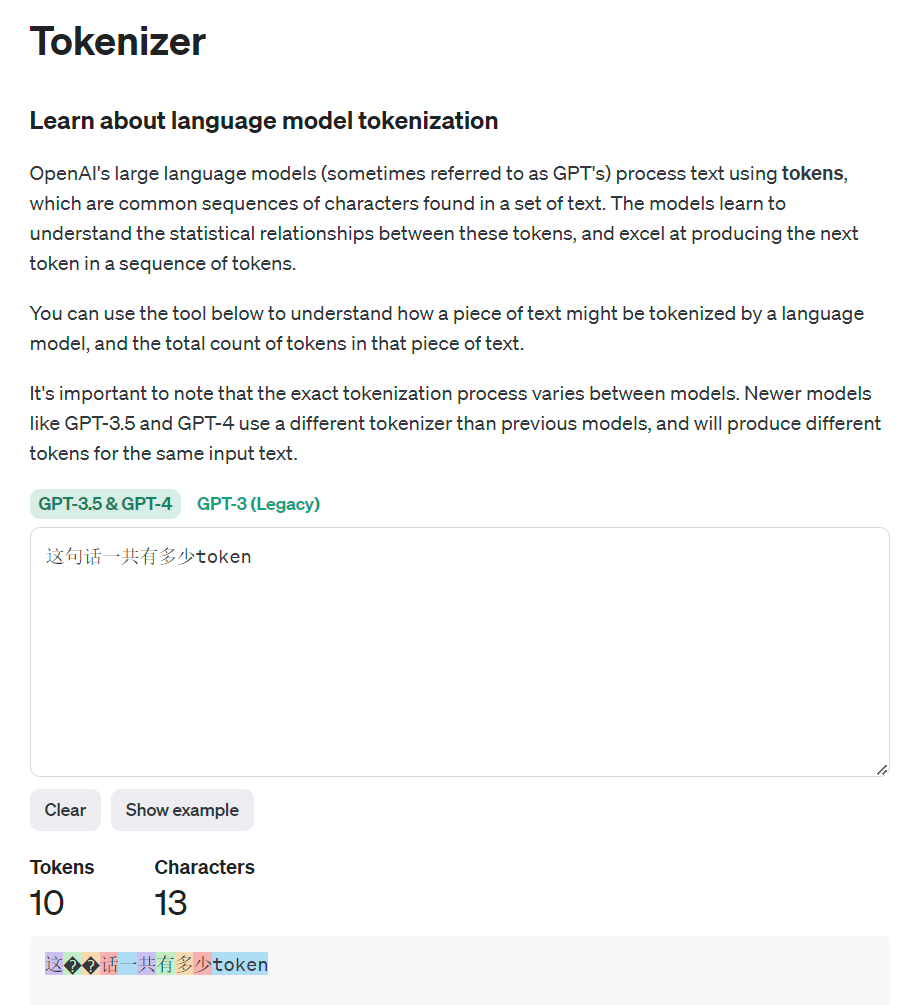

工具計算: OpenAI官網提供了一個文本與token長度的計算工具

- 鏈接: https://platform.openai.com/tokenizer

- 演示:

3.參考文獻

- https://www.zhihu.com/question/594159910/answer/2996337752

)

)

)