第2周:深度神經網絡

將從以下幾個部分開始學習,第1周的概述有需要詳細講解的的同學自行百度;

深度神經網絡的結構與設計

深度學習的參數初始化策略

過擬合與正則化技術

批標準化與Dropout

實踐:使用深度學習框架構建簡單的深度神經網絡,并進行訓練與評估

(一)深度神經網絡的結構與設計

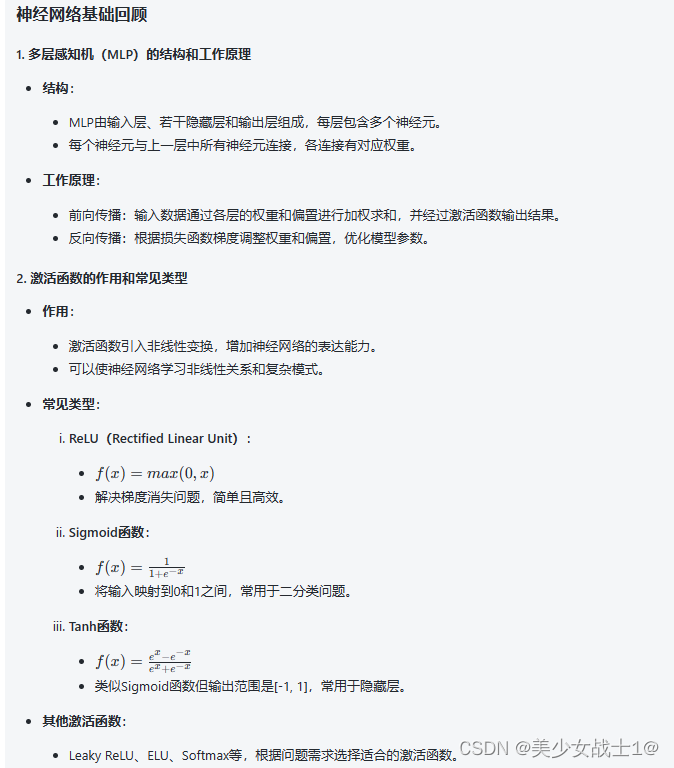

一. 神經網絡基礎回顧

二. 深度神經網絡結構

- 深度網絡

引入深度概念:

深度神經網絡由多個隱藏層組成,可以進行多層次的特征抽取和表示學習。

隨著層數增加,網絡可以學習到更加抽象和復雜的特征。

層與層之間的連接方式:

全連接:每個神經元都與上一層的所有神經元相連,參數量大。

卷積連接:通過卷積操作提取局部特征,共享權重減少參數量。

池化操作:減少特征圖大小、參數量,保留關鍵信息。

- 常見結構

卷積神經網絡(CNN):

適用于圖像數據處理:通過卷積層和池化層提取空間特征。

包括卷積層、池化層、全連接層等,常用于圖像分類、目標檢測等任務。

循環神經網絡(RNN):

適用于序列數據處理:具有記憶功能,能處理不定長序列數據。

可以捕捉序列中的時間依賴關系,常用于自然語言處理、時間序列預測等領域。

注意力機制(Attention):

用于處理不定長序列數據:允許模型在不同時間步關注輸入序列的不同部分。

提高模型對長序列的處理能力,常用于機器翻譯、語音識別等任務。

三. 神經網絡設計與調參

- 網絡設計要點

深度與寬度的選擇:

深度:增加深度可提高網絡表達能力,但也增加訓練難度和計算成本。根據任務復雜度和數據量進行選擇。

寬度:每層神經元數量的選擇影響網絡的表示能力,通常在實踐中會通過試驗選擇最佳寬度。

正則化與批標準化的使用:

正則化:如L1/L2正則化、Dropout等可以減少過擬合問題。

批標準化:減少內部協變量偏移,加速訓練過程,提高模型泛化能力。

梯度消失與爆炸問題的處理:

梯度消失:通過使用恰當的激活函數(如ReLU)、初始化權重(如He初始化)、或者使用殘差連接(如ResNet)來緩解。

梯度爆炸:梯度裁剪、合適的權重初始化(如Xavier初始化)等方法可以解決。

- 超參數調優

學習率、批大小、激活函數的選擇:

學習率:影響模型收斂速度和性能,可以采用學習率衰減策略。

批大小:影響梯度更新頻率和內存占用,選擇適當大小有助于加快訓練。

激活函數:根據任務需求選擇適當的激活函數。

交叉驗證、網格搜索等調參方法:

交叉驗證:評估模型泛化能力,選擇最佳超參數組合。

網格搜索:通過遍歷不同超參數組合來尋找最優模型配置。

四. 實踐與案例分析

- 實踐項目:文本情感分類

項目描述:

任務:對電影評論進行情感分類,判斷評論是正面還是負面情感。

數據集:使用IMDb數據集,包含大量電影評論和對應情感標簽。

模型:使用卷積神經網絡(CNN)進行文本分類。

設計過程:

數據預處理:文本分詞、構建詞典,將文本轉換為詞向量表示。

搭建CNN模型:包括卷積層、池化層和全連接層。

模型訓練:選擇合適的損失函數(如交叉熵損失)、優化器(如Adam)、正則化方法(如Dropout)進行訓練。

代碼示例:

數據預處理:

# 文本分詞及構建詞典

tokenizer = Tokenizer(num_words=max_words)

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

word_index = tokenizer.word_index# 將文本轉換為詞向量表示

data = pad_sequences(sequences, maxlen=maxlen)

labels = np.asarray(labels)搭建CNN模型:

model = Sequential()

model.add(Embedding(max_words, embedding_dim, input_length=maxlen))

model.add(Conv1D(filters, kernel_size, activation='relu'))

model.add(GlobalMaxPooling1D())

model.add(Dense(hidden_dim, activation='relu'))

model.add(Dense(1, activation='sigmoid'))model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])模型訓練:

model.fit(X_train, y_train, epochs=epochs, batch_size=batch_size, validation_data=(X_val, y_val))- 案例分析:AlphaGo

案例描述:

任務:圍棋對弈。

網絡結構:使用深度殘差網絡(ResNet)和卷積神經網絡(CNN)。

調參策略:

網絡結構設計:采用深度殘差網絡和CNN結構,利用殘差連接減少梯度消失問題。

強化學習算法:采用蒙特卡洛樹搜索(Monte Carlo Tree Search, MCTS),結合策略價值網絡進行決策。

自我對弈:通過大量自我對弈生成數據,用于訓練深度神經網絡模型。

代碼示例:

網絡結構設計:

# 深度殘差網絡(ResNet)部分

def residual_block(input_tensor, filters, kernel_size):x = Conv2D(filters, kernel_size, padding='same')(input_tensor)x = BatchNormalization()(x)x = Activation('relu')(x)x = Conv2D(filters, kernel_size, padding='same')(x)x = BatchNormalization()(x)x = Add()([x, input_tensor])x = Activation('relu')(x)return x# 卷積神經網絡(CNN)部分

def convolutional_block(input_tensor, filters, kernel_size):x = Conv2D(filters, kernel_size, padding='same')(input_tensor)x = BatchNormalization()(x)x = Activation('relu')(x)return x強化學習算法(蒙特卡洛樹搜索):

def monte_carlo_tree_search(game_state):root_node = Node(state=game_state)for i in range(num_simulations):node = root_nodewhile not node.is_leaf():node = node.select_child()if node.visits > 0:action = node.get_best_action()else:action = random.choice(game_state.get_legal_actions())new_state = game_state.play_action(action)reward = simulate(new_state)node.update(reward)return root_node.get_best_action()自我對弈:

def self_play():game_state = initialize_game_state()while not game_state.is_terminal():action = monte_carlo_tree_search(game_state)game_state = game_state.play_action(action)final_reward = calculate_reward(game_state)return final_reward五.總結與展望

-

總結:

深度神經網絡的結構與設計要點:

神經網絡結構:包括輸入層、隱藏層和輸出層,隱藏層可以是卷積層、循環層或全連接層等。

激活函數:用于引入非線性因素,常見的激活函數有ReLU、Sigmoid和Tanh等。

損失函數:用于衡量模型預測輸出與實際標簽之間的差異,常見的損失函數有交叉熵損失和均方誤差等。

優化器:用于調整模型參數以最小化損失函數,常見的優化器有SGD、Adam和RMSprop等。

正則化:包括L1正則化、L2正則化和Dropout等方法,用于防止過擬合。 -

展望:

深度學習領域的發展趨勢與挑戰:

自動化與自適應性:未來深度學習模型將更加自動化和自適應,能夠適應不同任務和數據的特點。

多模態融合:深度學習將更多地涉及多模態數據(文本、圖像、語音等)的融合與處理。

可解釋性:解釋深度學習模型決策的可解釋性將成為重要研究方向,以提高模型的可信度和應用范圍。

邊緣計算:將深度學習模型部署到邊緣設備上,實現智能化的邊緣計算應用。

數據隱私與安全:在深度學習中注重數據隱私保護和模型安全性,是未來發展的重要挑戰

聲明:本人的深度學習相關文章全部來自于與AI 的對話整理匯總(學習筆記整理),僅作用于共同學習,不做他用;

持續匯總,持續學習中。。。

案例)

docker netty OOM問題記錄)

:2024.01.01-2024.01.10)

)

![[Android View] 可繪制形狀 (Shape Xml)](http://pic.xiahunao.cn/[Android View] 可繪制形狀 (Shape Xml))