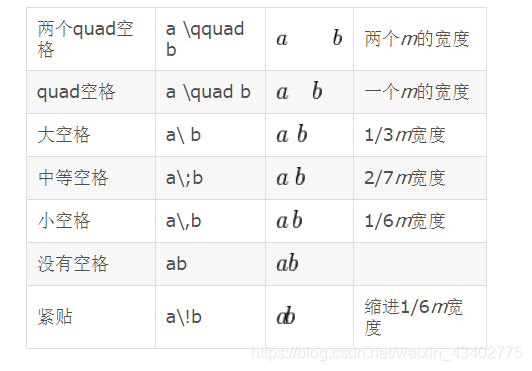

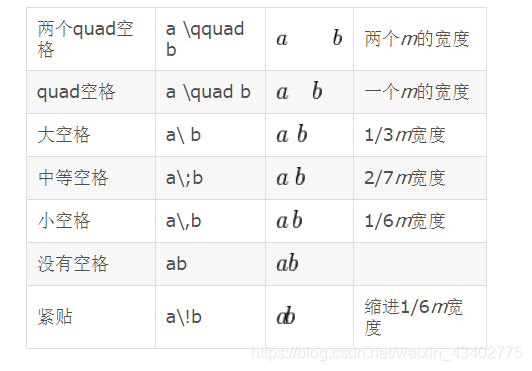

Latex 加空格的方法

本文來自互聯網用戶投稿,該文觀點僅代表作者本人,不代表本站立場。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。 如若轉載,請注明出處:http://www.pswp.cn/news/535216.shtml 繁體地址,請注明出處:http://hk.pswp.cn/news/535216.shtml 英文地址,請注明出處:http://en.pswp.cn/news/535216.shtml

如若內容造成侵權/違法違規/事實不符,請聯系多彩編程網進行投訴反饋email:809451989@qq.com,一經查實,立即刪除!相關文章

Latex的表格注釋

調用threeparttable包

在文檔的最前面加入以下命令:

\usepackage{threeparttable}在表格處插入命令

\begin{table*} \label{table:number}

\centering

\caption{....}

\begin{threeparttable}

\begin{tabular}{lc}\hlineA & B \\\hline

A & B\tnote{*} \…

Latex 插入目錄 設置首頁頁碼為空

插入目錄

\begin{document}

\maketitle\tableofcontents

\newpage # 從下一頁開始\end{document}\maketitle

\tableofcontents

\textbf{\ \\\\\\\\\\$*$ means that it is a supplementary experimental results for the manuscript.\\ $**$ means that it is a newly added …

Pytorch GPU內存占用很高,但是利用率很低

1.GPU 占用率,利用率

輸入nvidia-smi來觀察顯卡的GPU內存占用率(Memory-Usage),顯卡的GPU利用率(GPU-util)

GPU內存占用率(Memory-Usage) 往往是由于模型的大小以及batch size的大…

sambd ERROR: job for smbd.service failed

sudo service smbd restart

出現如下問題

解決方案

sudo cp /usr/share/samba/smb.conf /etc/sambs這樣就可以重新啟動了

Pytorch 反向傳播實例,梯度下降

1.手寫更新權重

#求 y w*x

x_data [1.0,2.0,3.0,4.0]

y_data [2.0,4.0,6.0,8.0]w 1.0def grad(x,y): #計算梯度# (y^ - y)^2 (wx -y)^2 grad:2w(wx-y)return 2 * x * (w * x - y)def loss(x,y):return (y - (w * x)) * (y - (w * x))for i in range(30):for …

python環境快速安裝opencv 離線版安裝

1. 進入清華大學opencv Python庫:

https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/opencv-python/

下載適合自己版本的opencv

怎么判斷是否適合自己的環境? 只需要輸入

pip install opencv-python # 太慢了 下載 我們不用它然后在網站下載…

Pytorch離線安裝 matlibplot

因為使用pip安裝太慢了,所以我們使用離線安裝包來安裝。

1.下載安裝包

https://pypi.org/project/matplotlib/#files 選擇自己合適的安裝包

2. cd到指定的文件夾

然后

pip install .whl即可

Normalization 歸一化方法 BN LN IN GN

1.分類

BN是在batch上,對N、H、W做歸一化,而保留通道 C 的維度。BN對較小的batch size效果不好。BN適用于固定深度的前向神經網絡,如CNN,不適用于RNN;LN在通道方向上,對C、H、W歸一化,主要對RN…

Linux 服務器拷貝遠程文件 SCP

1.復制文件

(1)將本地文件拷貝到遠程 (有時候權限不允許) scp 文件名 用戶名計算機IP或者計算機名稱:遠程路徑

scp /root/install.* root192.168.1.12:/usr/local/src(2)從遠程將文件拷回本地 scp 用戶名…

Pytorch: model.eval(), model.train() 講解

文章目錄1. model.eval()2. model.train()兩者只在一定的情況下有區別:訓練的模型中含有dropout 和 batch normalization

1. model.eval()

在模型測試階段使用

pytorch會自動把BN和DropOut固定住,不會取每個batchsize的平均,而是用訓練好的…

Job for smbd.service failed because the control process exited with error code. See “systemctl statu

錯誤

$ sudo service smbd restartJob for smbd.service failed because the control process exited with

error code. See "systemctl status smbd.service" and "journalctl -xe"

for details.$ systemctl status smbd.servicesmbd.service - Samba SM…

RuntimeError: one of the variables needed for gradient computation has been modified by an inplace o

問題

RuntimeError: one of the variables needed for gradient computation has been modified by an inplace operation: [torch.cuda.FloatTensor [4]] is at version 1; expected version 0 instead

分析

nn.relu(True) # 這個引起的問題原來的變量被替換掉了ÿ…

batchsize大小對訓練速度的影響

1.batchsize越大 是不是訓練越快?

GPU :一塊2080Ti 平臺:pytorch cuda 圖片數量:2700

batchsize一個圖片處理時間GPU內存占用GPU算力使用一個epoch 所用時間10.117s2.5G20%2700 * 0.0117 318s50.516s8G90%2700 * 0.516/5 279s

batchsize大…

os.environ[‘CUDA_VISIBLE_DEVICES‘]= ‘0‘設置環境變量

os.environ[‘環境變量名稱’]‘環境變量值’ #其中key和value均為string類型

import os

os.environ["CUDA_VISIBLE_DEVICES"]‘6‘’,‘7’這個語句的作用是程序可見的顯卡ID。

注意 如果"CUDA_VISIBLE_DEVICES" 書寫錯誤,也不報…

nn.ReLU() 和 nn.ReLU(inplace=True)中inplace的作用

inplace

作用: 1.用relu后的變量進行替換,直接把原來的變量覆蓋掉 2.節省了內存

缺點: 有時候出現梯度回傳失敗的問題,因為之前的變量被替換了,找不到之前的變量了 參考這篇文章

pytorch:加載預訓練模型(多卡加載單卡預訓練模型,多GPU,單GPU)

在pytorch加載預訓練模型時,可能遇到以下幾種情況。 分為以下幾種在pytorch加載預訓練模型時,可能遇到以下幾種情況。1.多卡訓練模型加載單卡預訓練模型2. 多卡訓練模型加載多卡預訓練模型3. 單卡訓練模型加載單卡預訓練模型4. 單卡訓練模型加載多卡預訓…

python中 numpy轉list list 轉numpy

list to numpy

import numpy as np

a [1,2]

b np.array(a)numpy to list

a np.zero(1,1)

a.tolist()

知識蒸餾 knowledge distill 相關論文理解

Knowledge Distil 相關文章1.FitNets : Hints For Thin Deep Nets (ICLR2015)2.A Gift from Knowledge Distillation:Fast Optimization, Network Minimization and Transfer Learning (CVPR 2017)3.Matching Guided Distillation(…

模型壓縮 相關文章解讀

模型壓縮相關文章Learning both Weights and Connections for Efficient Neural Networks (NIPS2015)Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman Coding(ICLR2016)Learning both Weights and …

, model.train() 講解)

![os.environ[‘CUDA_VISIBLE_DEVICES‘]= ‘0‘設置環境變量](http://pic.xiahunao.cn/os.environ[‘CUDA_VISIBLE_DEVICES‘]= ‘0‘設置環境變量)

和 nn.ReLU(inplace=True)中inplace的作用)

)