文章目錄

- 前言

- 一、啟動 HDFS 并顯示當前所有 Java 進程

- 二、DataNode 啟動異常場景描述

- 三、DataNode 啟動異常解決方式

- 四、Web 界面檢查 Hadoop 信息

- 總結

前言

本文用于解決 Apache Hadoop 啟動時 DataNode 啟動異常的問題,但是請注意這會刪除 HDFS 中原有的所有數據,如果原有的數據很重要請不要這樣做。

一、啟動 HDFS 并顯示當前所有 Java 進程

依次在 Hadoop 安裝目錄下執行以下命令啟動 HDFS 并顯示當前所有 Java 進程:

./bin/hdfs namenode -format #格式化NameNode

./sbin/start-dfs.sh #啟動HDFS

jps #顯示當前所有的Java進程

二、DataNode 啟動異常場景描述

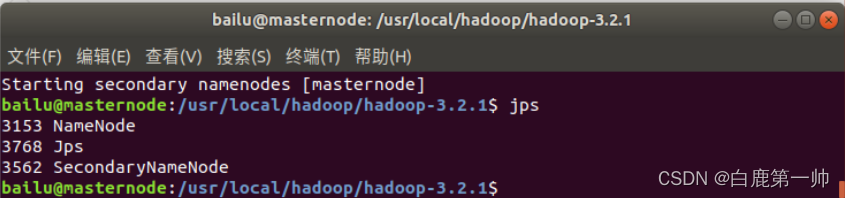

當 DataNode 啟動異常時或者沒有啟動時我們調用 jps 命令不會顯示其進程,具體如下圖所示:

三、DataNode 啟動異常解決方式

再次提醒:刪除 tmp 文件,會刪除 HDFS 中原有的所有數據。

依次執行如下命令:

./sbin/stop-dfs.sh #關閉HDFS

rm -r ./tmp #刪除tmp文件,注意這會刪除HDFS中原有的所有數據,tmp文件目錄根據本地目錄尋找

./bin/hdfs namenode -format #重新格式化NameNode

./sbin/start-dfs.sh #重啟HDFS

jps #顯示當前所有的Java進程

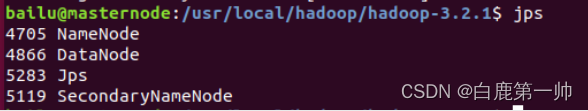

成功啟動后我們可以看到 DataNode 的進程,具體如下圖所示:

四、Web 界面檢查 Hadoop 信息

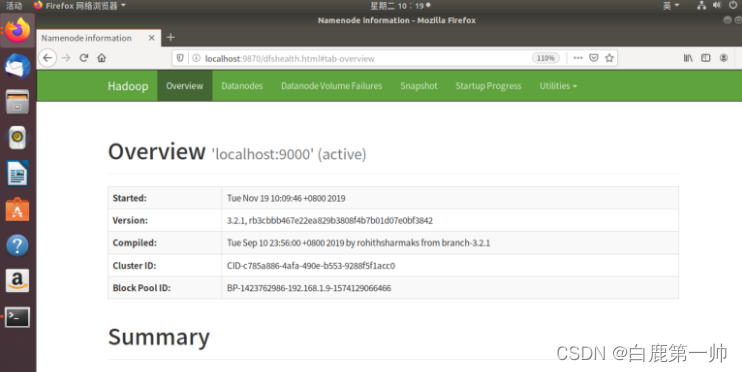

同時,可以通過 Linux 本地瀏覽器訪問 Web 界面(http://localhost:9870)來查看 Hadoop 的信息,具體如下圖所示:

總結

本文解決了 Apache Hadoop 啟動時 DataNode 沒有啟動的問題,但是請注意這會刪除 HDFS 中原有的所有數據,如果原有的數據很重要請不要這樣做。其他的方法暫時還沒有發現,這個方法百試百靈,有其他的方法的小伙伴歡迎補充!

我是白鹿,一個不懈奮斗的程序猿。望本文能對你有所裨益,歡迎大家的一鍵三連!若有其他問題、建議或者補充可以留言在文章下方,感謝大家的支持!

》第 14 章——需求管理的原則和實踐 重點部分總結)

》第 15 章——變更管理 重點部分總結)

》第 16 章——需求鏈中的聯系鏈 重點部分總結)

》第 10 章——項目收尾 重點部分總結)

》第 9 章——項目監督與控制 重點部分總結)

整合 1:整體概述、目錄內容及實驗環境介紹)

)

調試?)

文檔類型說明)