一、 產品概述

1. 當前存儲的挑戰??

隨著云計算、物聯網、5G、大數據、人工智能等新技術的飛速發展,數據呈現爆發式增長,預計到2025年中國數據量將增長到48.6ZB,超過80%為非結構化數據。

同時,數字經濟正在成為我國經濟發展的新引擎,數據已經成為企業的核心生產要素,數據即價值。新技術新應用不斷產生急劇增長的海量數據,數據的價值越來越高,對存儲系統的可靠性、安全性、可用性、性能、成本、運維的要求也越來越高,給存儲系統提出了巨大的挑戰:

以上挑戰和剛需說明,新一代存儲系統不光要面向傳統的數據可靠性、服務可用性、性能等維度,超大存儲量、長期存儲經濟性、系統水平線性擴展性、可交付的運維等維度成為新的重點。

這驅使新一代存儲系統必然走向規模化、集成化、存算分離的分布式scale-out云存儲架構,提供可交付的簡潔易用的運維平臺,讓客戶自己負責運維,安心使用。

2. FOSS的特點??

大道云行對象存儲FOSS,是采用先進的分布式全閃架構的信創云存儲系統,設計為超大規模數據長期、可靠、綠色節能、高性能存取。

FOSS適用于包括廣電媒資、備份歸檔、遠程容災、視頻監控、人工智能、大數據分析、數據湖等大規模非結構化數據存取應用場景,特別是數據量大、吞吐高,成本敏感的需求。

| FOSS特點詳解 | |

| Share?Everything架構? | 存儲后端網絡share everything架構,支持NVMe-oF,支持分布式無狀態微服務安全訪問存儲。 |

| 信創存儲? | 全自主知識產權國產分布式全閃存儲軟件和國產閃存的結合。 |

| 全閃架構,超高性能,數據量,性能的水平線性擴展? | 亞毫秒級延遲,單zone-百PB級空間,百GB級吞吐,百萬級IOPS。 |

| 綠色節能? | 節能調度算法使得多數SSD的大部分時間處于低功耗狀態(單片SSD<0.5w)。 |

| 全閃優化設計使得SSD使用時間長,成本低? | 數據按時間聚合,采用全域GC和磨損平衡等設計,極大降低SSD寫放大,提高SSD使用壽命。實現大尺度QLC SSD的高密度使用,降低單位成本。 |

| 長期可靠 | 數據靜默錯誤保護;智能化的介質和數據的巡檢、健康掃描、Rebuild恢復。 對數據和介質長期可靠做了慎密的數據保護、監測、掃描、恢復、遷移等運維規劃。 |

3. FOSS的核心能力??

在線數據的性能和延遲,離線數據的規模和成本。

使用FOSS,意味著客戶可以將大部分數據以離線數據的成本保存到在線系統,數據長久在線。

二、 產品架構

1. 網絡架構??

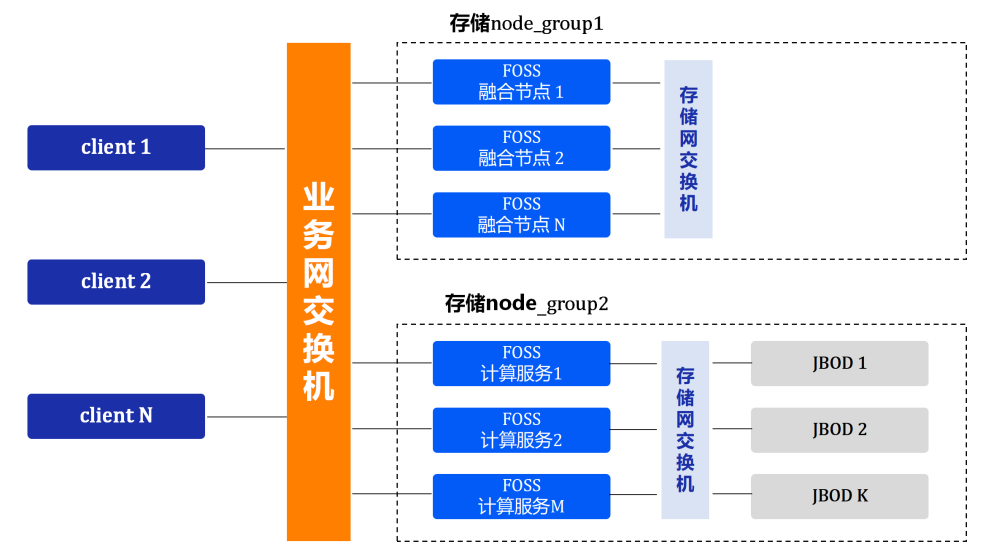

系統采用扁平的二層網絡,易于部署和管理,支持對存儲集群節點進行分組,支持跨組數據互訪。

- 業務網

業務網可以是IP/IB/RoCE;

每組業務網的計算節點都互通。

- 存儲后端網

存儲后端網可以是IP/IB/RoCE;

存儲后端網支持按分組進行擴展,不同分組之間存儲網不通,可以通過業務網進行轉發;

分組設計有利于存儲網絡簡單的水平擴展,而不增加組網的復雜度。

一個zone規模的上限,取決于業務網的規模,即計算節點總數;存儲網可任意水平擴展,但總規模會受限于連接存儲網的計算節點總數。

一般的,一個zone支持100GB的業務網,200個計算節點,20個存儲網分組(每分組10P存儲空間);則整個zone支持100GB帶寬,200PB存儲空間。

2. 軟件架構??

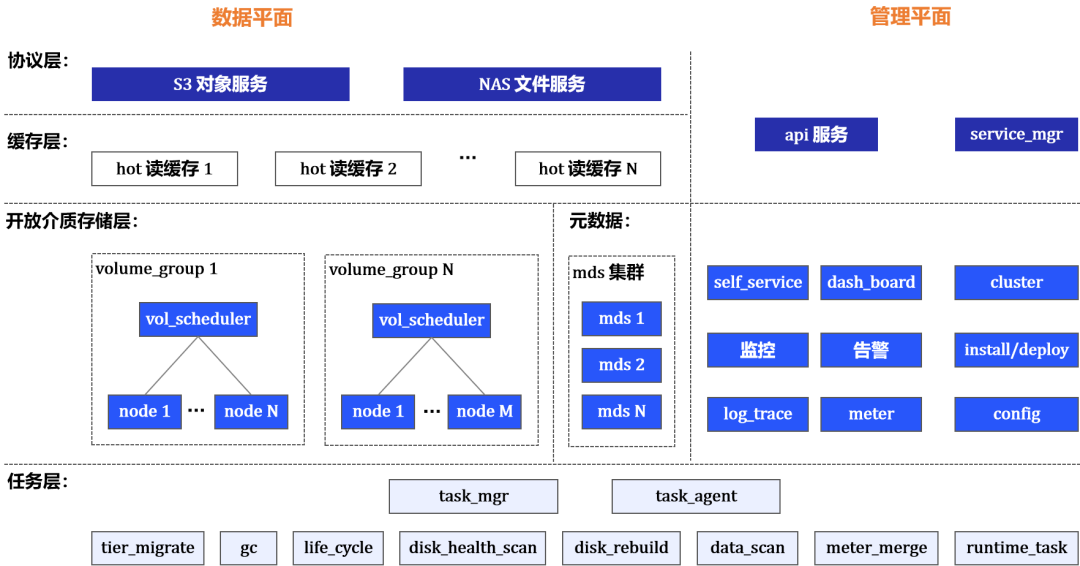

協議層

對外提供s3服務和nas服務。

緩存層?

數據分片通過讀緩存層降低延遲,滿足低讀延遲的場景需求。

開放介質存儲層?

-- volume

開放介質存儲(OpenMediaStorage - OMS)層將塊設備(disk)的trunk封裝為跨節點的、冗余算法(糾刪/副本)保護的volume,提供volume的裝配、分配和讀寫接口。

OMS層開放式的直接存取disk,支持:主機Local_disk、SAS/NVMe-oF enclosure disk、塊存儲系統的LUN(FC/iSCSI/NVMe-oF)。

-- volume_group

volume按分組進行管理、調度和使用。分組用于支持多租戶。

volume_group由調度器和node集群組成。

-- node

node代表了掛載的disk的集合,對應實體存儲節點主機disk組,或NVMe-oF 盤柜disk組,或塊存儲劃分的Lun組。

node作為disk的IO控制器,提供發現、掛載、訪問disk的接口。

-- 調度器負責volume裝配和分配

裝配:

- 按node類型樹進行類型分組

- 按空間平衡+擦寫次數平衡選擇node

分配:

- 按類型聚合

- 數據分片MVCC+基于租約的volume_range保護機制

元數據?

mds集群提供分布式元數據服務,支持最終一致性事務,在線線性擴展。

任務層?

包含GC、Disk_Rebuild、數據遷移、數據均衡、數據/介質健康掃描、生命周期、配額、計量歸并等任務。

任務通過管理器Task_mgr,分發到Task_agent分布式并行執行。

task_mgr進行任務策略配置、調度、資源使用控制。

Service_mgr?

服務部署、升級、配置,單例服務故障轉移,集群服務擴展等。

三、產品特性

1. 分布式元數據??

很多存儲系統采用無元數據服務架構,比如一致性Hash。無元數據服務架構在超大規模分布式系統中存在許多缺點:

-

無法在統一的邏輯上管理元數據,不支持事務,會導致很多一致性問題。

-

沒有元數據的范圍查詢能力,查詢范圍會放大到整個集群,導致海量對象場景下元數據列舉開銷大性能差。

-

rebalance過程復雜,要掃描所有需rebalance的數據進行處理并完成狀態轉換,且網絡故障、節點臨時離線和永久離線等會進一步增加rebalance復雜度。

FOSS采用分布式元數據服務架構:

-

元數據服務線性平滑,網絡故障和節點故障不影響服務的可用性

-

元數據三副本冗余

-

支持熱點消除(主鍵單調遞增的元數據,采用shard_bit打散)

-

支持高性能的事務聚合批處理(batch和scan)

-

低延遲(亞毫秒級)

依靠分布式元數據服務,FOSS簡潔高效的實現了單桶無限數量對象、快速對象列舉、volume調度、全域GC和磨損平衡等高級功能。

2. 存儲冷熱分層??

FOSS存儲分層設計的主旨,是為了同時滿足超高性能和超大容量需求。FOSS的數據存儲包括2層:

(熱)高性能層?

- 熱volume_group

- 讀緩存集群

高性能層滿足要求極低延遲的高性能場景。高并發寫入通過寫請求聚合提高IOPS;小文件的低延遲讀取,通過熱數據讀緩存優化。

通常,變冷的數據會遷移到大容量層。只需要高性能層的特例客戶,也可以獨立使用高性能層,不部署大容量層。

(冷)大容量層

- 冷volume_group

大容量層必須依賴高性能層存在。tier_migrate任務將高性能層的數據批量遷移到冷volume 。

批量遷移采用順序大IO寫入,使大尺度SSD可以得到優化使用。

3. 資源多租戶??

S3服務資源多租戶?

通過service_mgr配置租戶獨占的S3服務資源,為特定租戶建立專屬的s3_serv_group 。

通過service_mgr配置s3_serv_group和volume_group的映射關系。

存儲資源多租戶

bucket可以代表租戶的分類存儲空間,多租戶的空間管理通過bucket的存儲策略進行。

支持設置bucket的數據放置策略(對應的volume_group),比如可指定bucket放置到特定性能分類(SSD|HDD)的volume 。

4. 優秀的擴展性??

FOSS支持容量和性能的橫向線性擴展,元數據的橫向線性擴展,通過分布式元數據服務mds實現:

-

mds_kv集群的擴展

mds_kv采用全局字典序range方式進行key的sharding;支持在線增加kv節點,IOPS隨kv節點個數線性增長。

-

mds事務服務集群的擴展

mds事務服務集群,采用配置訂閱方式擴展;支持在線增加事務服務,IOPS隨事務服務個數線性增長。

數據存儲的橫向線性擴展,通過開放介質存儲(OpenMediaStorage-OMS)層實現:

-

存算分離的架構下,數據存儲的橫向擴展簡化為存儲后端網的橫向擴展。

-

存儲后端網按分組進行水平擴展,每個分組后端網獨立組網,擴展簡單。

增加volume_group中node,即增加了分組的存儲量和IOPS;當volume_group內的擴展到達上限后,可以通過新建volume_group進行擴展。

5. 綠色節能??

FOSS通過數據寫入volume分配算法和分類聚合算法,實現(冷)數據層的disk節能。

?volume分配算法

數據寫入分配volume時,在滿足性能吞吐需求的條件下,一段時間內分配的volume使用盡量少的同一批disk。(其他disk這段時間處于節能狀態,存儲規模越大,節能比例越高)

?分類聚合算法

應用按時間批量讀取數據的時候,因為應用寫入數據按時間聚合,讀關聯的disk和寫入時是相同的,同樣只是少數的一批disk。

四、產品愿景

以全閃綠色節能信創存儲的創新技術:

為客戶提供自運維的私有云存儲,應存盡存;

在企業存儲領域促進國產SSD對進口HDD的替代;

作為智能云平臺的存儲底座,助力數據處理的智能化,發掘數據的真正價值。

《FOSS全閃對象存儲技術白皮書》詳見官網大道云行 TaoCloud - 新一代全閃軟件定義存儲領導者 (taocloudx.com)

)

![[bug] 記錄version `GLIBCXX_3.4.29‘ not found 解決方法](http://pic.xiahunao.cn/[bug] 記錄version `GLIBCXX_3.4.29‘ not found 解決方法)

)

)