翻譯以機翻為主

原文目錄

前言

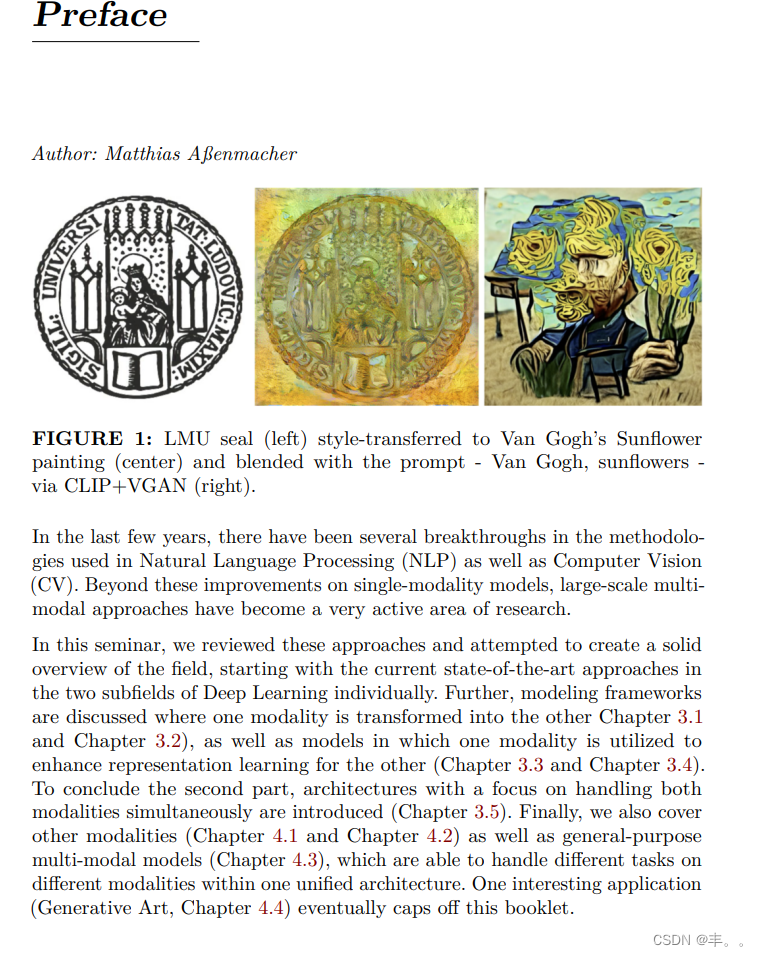

圖1:LMU印章(左)風格轉移到梵高的向日葵繪畫(中)并與提示混合 - 梵高,向日葵 -通過CLIP+VGAN(右)。在過去的幾年中,自然語言處理(NLP)和計算機視覺中使用的方法取得了一些突破。除了對單模態模型的這些改進之外,大規模多模態方法已成為一個非常活躍的研究領域。在本次研討會中,我們回顧了這些方法,并試圖創建一個堅實的該領域的概述,從當前最先進的方法分別是深度學習的兩個子領域。此外,建模框架討論一種模態轉換為另一種模態的地方 第 3.1 章和第3.2章),以及利用一種模式來加強對方的表征學習(第3.3章和第3.4章)。總結第二部分,體系結構側重于處理兩者同時介紹了各種模式(第3.5章)。最后,我們還介紹了其他模式(第4.1章和第4.2章)以及通用多模態模型(第4.3章),能夠處理不同的任務一個統一架構中的不同模式。一個有趣的應用“(生成藝術,第4.4章)最終完成了這本小冊子。

本書是大學教學實驗的結果。我們是受到克里斯托夫·莫爾納(Christoph Molnar)周圍的一群其他博士生的啟發,他們以這種形式舉辦了另一場關于可解釋機器學習的研討會。而不是讓每個學生在研討會論文上工作,這或多或少與其他學生隔離,我們希望促進學生之間的合作學生并使他們能夠產生一個有形的輸出(這不是寫的

將其余時間花在(數字)抽屜中)。在2022年夏季學期,一些統計學、數據科學和計算機科學專業的學生報名參加了我們的研討會題為“多模態深度學習”,并有(在啟動前會議)不知道他們報名了什么:寫了一整本書到學期末。我們受到舉辦研討會的考試規則的約束,但是否則,我們可能會偏離傳統格式。我們在幾個方面偏離了方式:

- 每個學生項目都是本小冊子的一章,內容鏈接到其他伴侶,因為主題。

- .我們給學生挑戰,而不是論文。挑戰是調查來自的特定有影響力的近期模型或方法NLP,計算機視覺或多模態學習領域。

- 我們設計的作品超越了研討會。

- 我們強調合作。學生寫了引言小組章節并相互審查單獨的文本。

摘要

人類有五種基本感官:聽覺、觸覺、嗅覺、味覺和視覺。

擁有這五種模式,我們能夠感知和理解我們周圍的世界。因此,“多模式”意味著組合不同的渠道同時了解我們周圍的信息。例如當幼兒學習“貓”這個詞時,他們會使用不同的方式說這個詞大聲說出來,指著貓,發出“喵喵”的聲音。使用人類學習過程作為榜樣,人工智能(AI)研究人員還可以嘗試結合不同的模式來訓練深度學習模型。安娜從表面上看,深度學習算法基于神經網絡經過訓練以優化一些目標,該目標通過所謂的損失函數。優化,即最小化損失,是通過稱為梯度下降的數值過程。因此,深度學習模型只能處理數字輸入,并且只能生成數字輸出。然而,在多模式任務中,我們經常遇到非結構化數據喜歡圖片或文字。因此,第一個主要問題是如何表示以數字方式輸入。關于多式聯運任務的第二個問題是如何正是為了結合不同的模式。例如,一個典型的任務可能是訓練深度學習模型以生成貓的圖片。首先計算機需要理解文本輸入“cat”,然后以某種方式理解將此信息轉換為特定圖像。因此,有必要識別文本輸入中的單詞與圖像輸出中像素之間的空間關系。什么可能很容易對于學齡前的幼兒來說,對計算機來說是一個巨大的挑戰。兩者都必須學習對包含含義和動物的外觀。現代深度學習的常見方法是生成嵌入,在某些數字上將貓表示為向量潛在空間。然而,為了實現這一目標,不同的方法和算法。

近年來已經開發了架構。本書給出了一個概述最先進的(SOTA)多模態深中使用的不同方法學習克服非結構化數據和組合帶來的挑戰不同模式的輸入。

小冊子大綱

由于多模態模型通常使用文本和圖像作為輸入或輸出,因此方法。自然語言處理(NLP)和計算機視覺(CV)作為第2章的基礎介紹。NLP領域的方法嘗試處理

文本數據,而CV處理圖像處理。關于NLP(第2.1小節),一個非常重要的概念是所謂的詞嵌入,如今,這是(幾乎)所有多模態深度學習的重要組成部分。架構。這一概念也為基于變壓器奠定了基礎像BERT(Devlin等人,2018a)這樣的模型取得了巨大的改進在幾個 NLP 任務中。特別是(自我)注意機制(Vaswani等人,2017a)的變壓器徹底改變了NLP模型,這就是為什么他們中的大多數依靠變壓器作為骨干。在計算機視覺中(第 2.2 小節)不同的網絡架構,即ResNet(He等人,2015),EfficientNet(Tan和Le,2019a),SimCLR(Chen等人,2020a)和BYOL(Grill等人,2020b),將推出。在這兩個領域,比較不同的方法及其在具有挑戰性的基準上的表現。為因此,第2章最后2.3小節對CV和自然語言處理。第二章(見3)側重于不同的多式聯運架構,涵蓋了文本和圖像如何組合的各種方式。所呈現的模型結合并推進了NLP和CV的不同方法。首先查看Img2Text任務(小節3.1),數據集Microsoft COCO對象識別(Lin等人,2014a)和網格記憶轉換器

圖像字幕(M2變壓器)(Cornia等人,2019)將被展示。相反,研究人員開發了基于生成圖片的方法短文本提示(第 3.2 小節)。完成此任務的第一個模型

是生成對抗網絡(GAN)(Goodfellow等人,2014b)和變分自動編碼器(VAE)(Kingma和Welling,2019)。這些方法近年來得到了改進,今天的SOTA變壓器架構和文本引導擴散模型,如 DALL-E(Ramesh 等人,2021a)和 GLIDE(尼科爾等人,2021a)取得了顯著的成果。另一個有趣的問題是利用圖像來支持語言模型的方式(第3.3小節)。這可以通過順序嵌入、更高級的接地嵌入來完成或者,再次,在變壓器內部。另一方面,也可以查看文本.

因為翻譯問題,本文變壓器一律代指transformer

支持 CV 模型,如 CLIP(Radford 等人,2021b)、ALIGN(Jia 等人,2021a)和佛羅倫薩(Yuan 等人,2021)(第 3.4 小節)。他們使用粉底模型意味著重用模型(例如 DALL-E 2 中的 CLIP)以及將文本與圖像連接起來的對比損失。此外,零射擊使無需昂貴的微調即可對新的和看不見的數據進行分類。尤其是用于圖像的開源架構 CLIP(Radford 等人,2021b)分類和世代在去年引起了很多關注。最后第二章,一些處理文本和圖像的進一步架構同時引入(第3.5小節)。例如,Data2Vec 使用言語、視覺和語言的學習方法相同,并以這種方式旨在找到一種通用方法來處理一個體系結構中的不同模式。此外,VilBert(Lu等人,2019a)擴展了流行的BERT架構。通過實現協同注意來處理圖像和文本作為輸入。這方法也用于谷歌的 Deepmind 火烈鳥(Alayrac 等人,2022 年)。在此外,火烈鳥旨在用一種視覺語言處理多項任務通過少鏡頭學習和凍結預先訓練的視覺和語言進行建模

型。在最后一章(見4)中,介紹了也能夠處理的方法文本和圖像以外的形式,例如視頻、語音或表格數據。這里的總體目標是找到一個基于以下挑戰而不是模式。因此,需要處理問題多模態融合和對齊,并決定是使用連接還是協調代表(第4.1小節)。此外,我們更詳細地介紹關于如何準確組合結構化和非結構化數據(小節)4.2). 因此,近年來發展起來的不同融合策略將是提出。本書通過生存分析中的兩個用例來說明這一點。和經濟學。除此之外,另一個有趣的研究問題是如何

在一個所謂的多用途模型中處理不同的任務(小節 4.3),例如它旨在由谷歌研究人員(Barham 等人,2022 年)在他們的“途徑”模式。最后但并非最不重要的一點是,我們展示了一個示例性應用程序藝術場景中的多模態深度學習,其中圖像生成模型像 DALL-E(拉梅什等人,2021a)是用于在該地區創作藝術品生成藝術(第4.4小節)

介紹模式

作者:杰姆·阿庫斯、弗拉達納·賈科維奇、克里斯托弗·本杰明·馬夸特

主管:馬蒂亞斯·阿森馬赫

自然語言處理(NLP)已經存在了大約50年,但是它比以往任何時候都更加重要。在以下方面取得了多項突破這個機器學習分支,涉及口語和書面語言。例如,學習單詞的內部表示是其中之一過去十年取得更大進展。詞嵌入(Mikolov et al. (2013a),Bojanowski et al. (2016))使之成為可能,并允許開發人員編碼單詞作為捕獲其基礎語義內容的密集向量。在此方式,相似的單詞在低維中彼此靠近嵌入功能空間。編碼器-解碼器解決了另一個重要挑戰(也稱為序列到序列)架構Sutskever等人(2014),其中可以將輸入序列映射到不同長度的輸出序列。它們對于機器翻譯、視頻等復雜任務特別有用字幕或問答。這種方法做出最少的假設在序列結構上可以處理不同的詞序并活躍,以及被動語態。一個絕對重要的最先進的技術是Attention Bahdanau等人。(2014),它使模型能夠像人類一樣主動轉移注意力做。它允許一次遵循一個想法,同時抑制信息與任務無關。因此,它已被證明顯著提高機器翻譯等任務的性能。通過給解碼器訪問直接查看源頭,避免了瓶頸和

同時,它提供了通往遙遠狀態的快捷方式,從而有助于梯度消失問題。最新的序列數據建模之一技術是變形金剛(Vaswani等人(2017b)),它完全基于。注意,不必按順序處理輸入數據(如 RNN)。因此,深度學習模型在記憶上下文誘導方面更好。在長序列中較早。它是目前NLP的主導范式,并且甚至可以更好地利用 GPU,因為它可以執行并行操作。變壓器架構,如BERT(Devlin等人,2018b),T5(Raffel等人,2019a)或GPT-3(Brown等人,2020)在大型語料庫上進行預訓練,并且可以針對特定語言任務進行微調。他們有能力生成故事、詩歌、代碼等等。在上述的幫助下。

)

)