為什么80%的碼農都做不了架構師?>>> ??

本文由碼農場同步,最新版本請查看原文:http://www.hankcs.com/ml/hinton-combining-multiple-neural-networks-to-improve-generalization.html

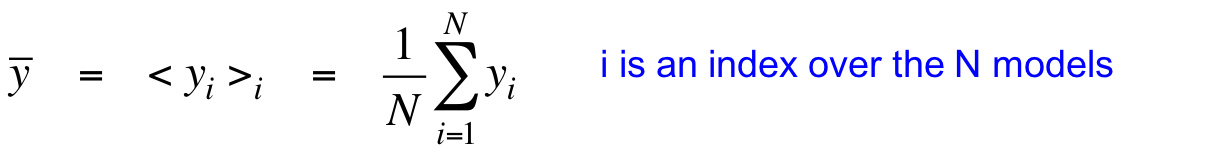

這節課講了為什么要綜合多個模型,好處與原理、具體做法等。講解了貝葉斯學習中的神經網絡模型混合、馬爾科夫蒙特卡洛方法,以及從新角度闡釋更高效的Dropout。綜合網絡:偏置方差均衡訓練數據少,容易過擬合。綜合多個模型可以防止過擬合,特別是當模型做出的預測差別很大的時候。對回歸來講,平方誤差可以分解為偏置與方差兩項。偏置由模型過于簡單帶來,方差由模型過于復雜帶來。方差項之所以稱為方差,是因為再來一個同分布的訓練集,因為采樣誤差的存在,模型擬合的結果會不一樣,于是產生方差。通過平均多個模型,可以降低方差。這些被平...

繼續閱讀:碼農場 ? Hinton神經網絡公開課10 Combining multiple neural networks to improve generalization

原文鏈接:http://www.hankcs.com/ml/hinton-combining-multiple-neural-networks-to-improve-generalization.html

感謝閱讀本文,歡迎 查看原文或訪問 碼農場 獲取更多內容

![matlab simplify,[求助]Matlab2016b里沒有simple函數](http://pic.xiahunao.cn/matlab simplify,[求助]Matlab2016b里沒有simple函數)

具體解釋)