文章目錄

- TriFormer: A Multi-modal Transformer Framework For Mild Cognitive Impairment Conversion Prediction

- 摘要

- 本文方法

- 實驗結果

- SwIPE: Efficient and Robust Medical Image Segmentation with Implicit Patch Embeddings

- 摘要

- 本文方法

- 實驗結果

TriFormer: A Multi-modal Transformer Framework For Mild Cognitive Impairment Conversion Prediction

摘要

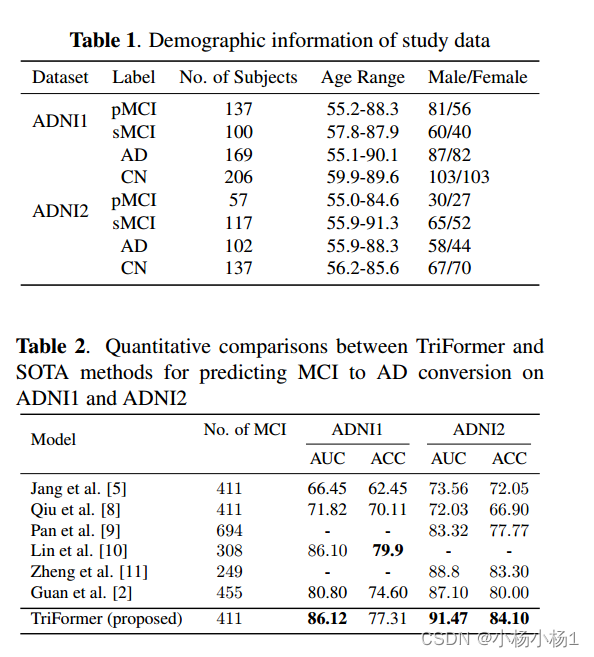

輕度認知障礙(MCI)轉化為阿爾茨海默病(AD)的預測對于早期治療以預防或減緩AD的進展非常重要。為了準確預測MCI向穩定MCI或漸進式MCI的轉換,我們提出了TriFormer,這是一種基于Transformer的新型框架,具有三個專用Transformer來整合多模態數據。

- 圖像Transformer從醫學掃描中提取多視圖圖像特征

- 臨床Transformer嵌入和關聯多模態臨床數據

- 模態融合Transformer,基于融合圖像和臨床Transformer的輸出產生準確的預測

本文方法

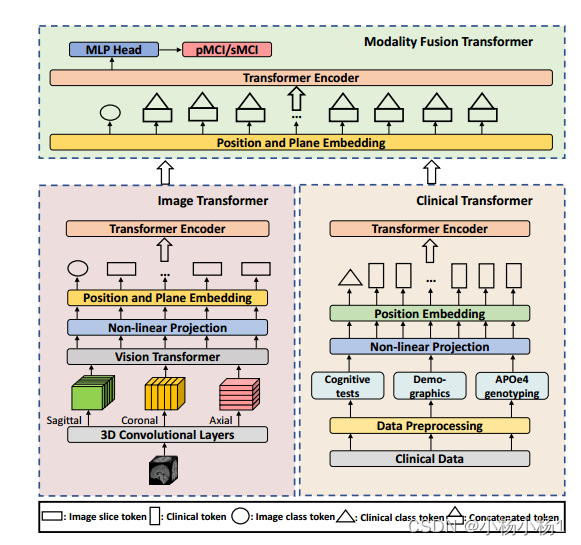

左邊的圖像Transformer使用ViT從MRI中提取多視圖圖像特征。右邊的臨床Transformer研究不同臨床數據之間的相關性。

圖像切片標記與臨床分類標記相連接,并作為模態融合轉換器的輸入,模態融合轉換器結合提取的多模態特征來執行更準確的MCI轉換預測。

實驗結果

SwIPE: Efficient and Robust Medical Image Segmentation with Implicit Patch Embeddings

摘要

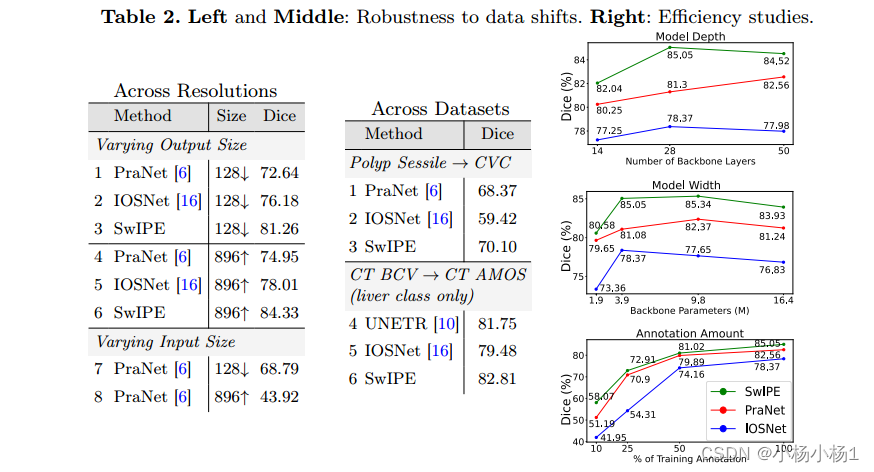

現代醫學圖像分割方法主要使用patch掩模形式的離散表示來學習特征并生成預測。雖然有效,但這種模式在空間上缺乏靈活性,難以適用于高分辨率圖像,并且缺乏對物體形狀的直接理解。為了解決這些限制,最近的一些研究利用隱式神經表征(INRs)來學習分割的連續表征。然而,這些方法往往直接采用為三維形狀重建而設計的部件。更重要的是,這些公式也被限制在基于點或全局的上下文中,分別缺乏上下文理解或局部細粒度的細節,這兩者都是準確分割的關鍵。

為了解決這個問題,我們提出了一種新穎的方法,SwIPE(隱式斑塊嵌入分割),它利用inr的優勢,在patch水平(而不是在點水平或圖像水平)預測形狀,從而實現準確的局部邊界劃定和全局形狀一致性。

本文方法

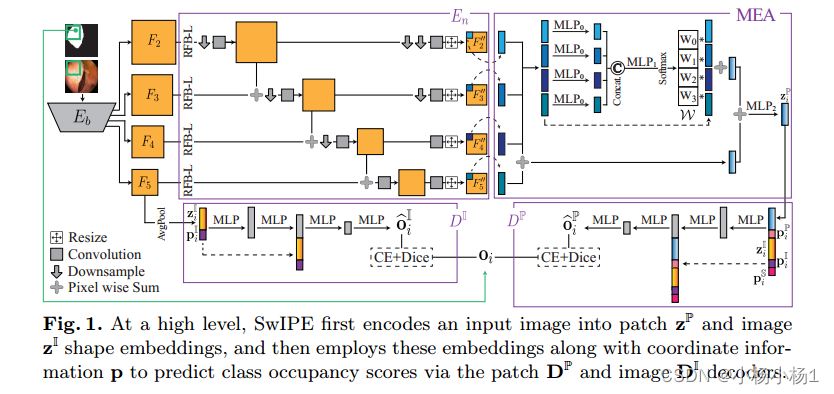

在高層次上,SwIPE首先將輸入圖像編碼為patch和圖像形狀embedding,然后使用這些embedding以及坐標信息P通過patch DP和圖像解碼器預測類占用分數

實驗結果

iptables開放指定端口開放指定端口)

面向對象技術)