CNN

第一周:

title: edge detection example

卷積核在邊緣檢測中的應用,可解釋,卷積核的設計可以找到像素列突變的位置

把人為選擇的卷積核參數,改為學習參數,可以學到更多的特征

?

title: padding

n * n圖片,k*k卷積核,輸出圖片是( n - k + 1) *?( n - k + 1)

padding補零,保持圖像尺寸

?

title:?Strided Convolutions

步長可調

信號處理的卷積,要先把卷積核沿兩個軸反轉,神經網絡里面所稱的卷積沒有這一步,實際上是卷積核和信號的互相關,

反轉使卷積運算保持了結合律的特性

?

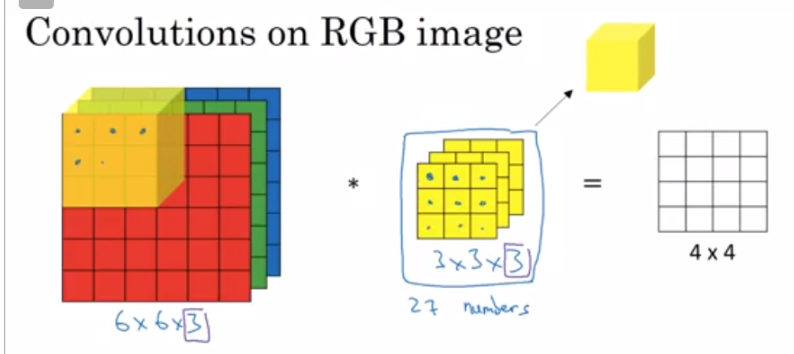

title:?Convolutions Over Volume

對于三維的信號,卷積核也要三維

三維的在對應位置相乘

存在多個卷積核的時候,就把結果疊在一起(假如維度一樣,同一層應該是必須一樣的

?

title:One Layer of a Convolutional Network

可以加bias,加非線性函數relu之類的

cnn的參數個數和卷積核的大小以及數量有關,但是和圖像大小無關,能控制參數的多少

?

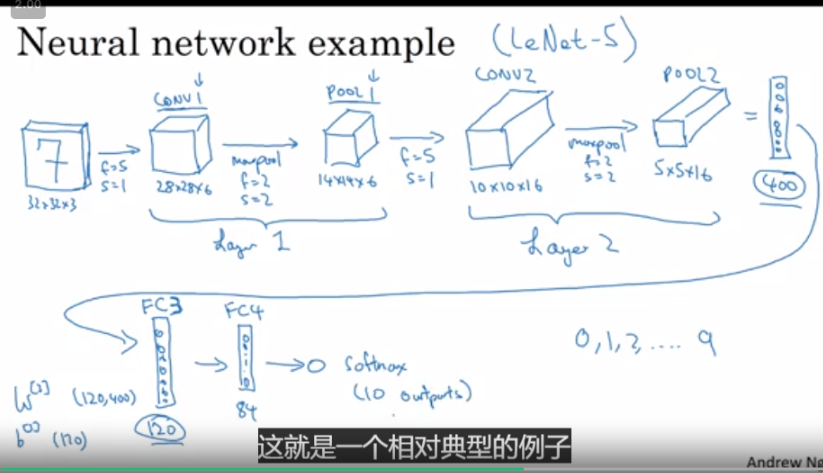

title:Simple Convolutional Network Example

注意到一層的輸出的深度,和這層的卷積核的數量有關,卷積核越多,深度越大,最后如果沒有padding,我們的圖像在長寬會變小,在深度(厚度)會很深

在cnn層之后會有池化層,全連接層,如果是分類問題

?

title:?Pooling Layers

max pooling, 用區域里的最大值,代表這塊區域,相當于把矩陣的尺寸壓縮了,有參數f,所劃分的最小塊區域的大小,stride,移動步長

pooling的解釋還挺強行的吧,算了算了

pooling有超參數,沒有學習參數

average pooling, 區域里的平均值

一般卷積層后面都跟著池化層

?

title: why cnn

cnn的優勢:

參數共享,一個卷積核里的參數應用到了所有的像素(信號)上

稀疏性

![Spring Data JPA例子[基于Spring Boot、Mysql]](http://pic.xiahunao.cn/Spring Data JPA例子[基于Spring Boot、Mysql])

-- Packaging CSS(打包css))

![[Hadoop in China 2011] 中興:NoSQL應用現狀及電信業務實踐](http://pic.xiahunao.cn/[Hadoop in China 2011] 中興:NoSQL應用現狀及電信業務實踐)

——使用Java通用配置模板方法模式)

)

——GUI編程)

)

上禁用Aero)