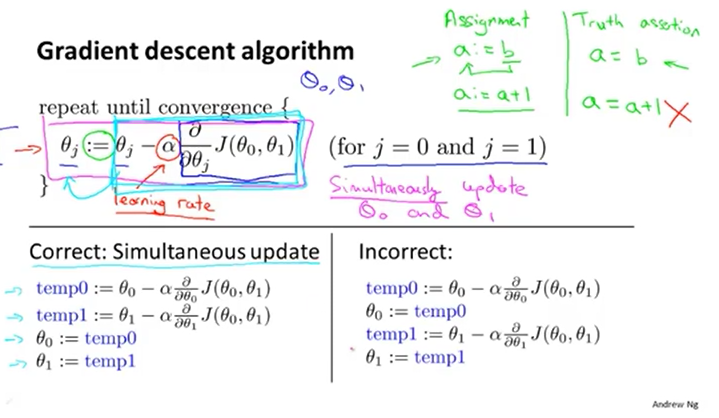

?梯度更新是要同時更新,如下圖所示:θ0和θ1同時更新,而不是更新完一個后再更新另一個。

?

?

?

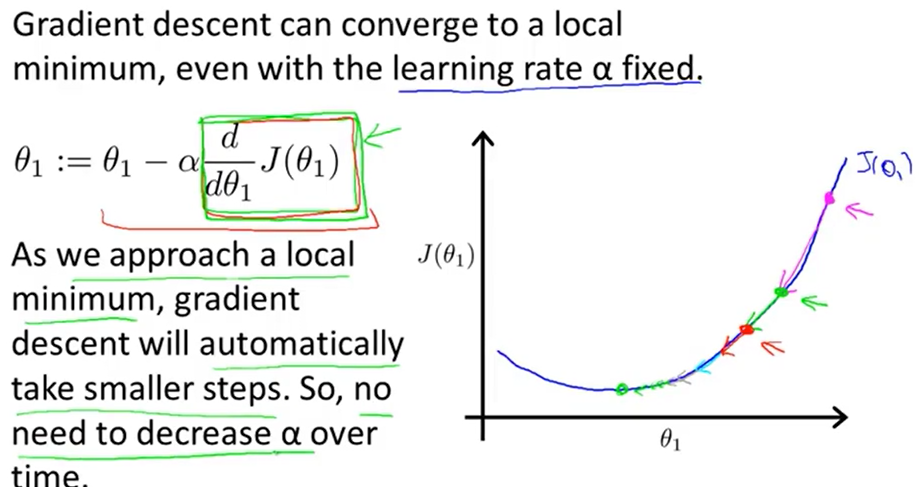

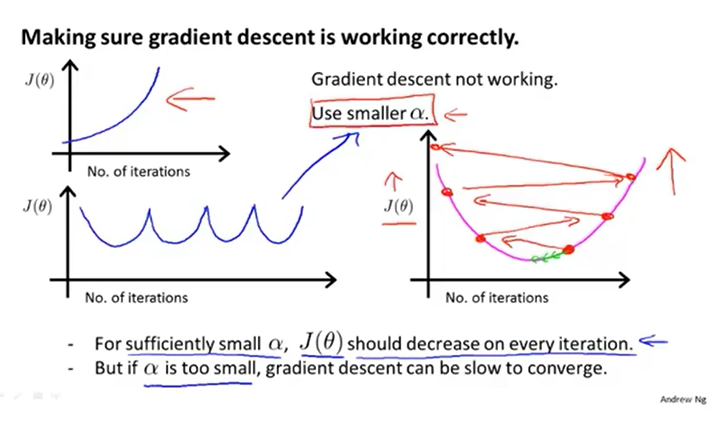

學習率α過小,梯度下降較慢,訓練時間增長。若學習率α過大,梯度下降會越過最低點,難以得到最優的結果,導致難以收斂或發散。

?

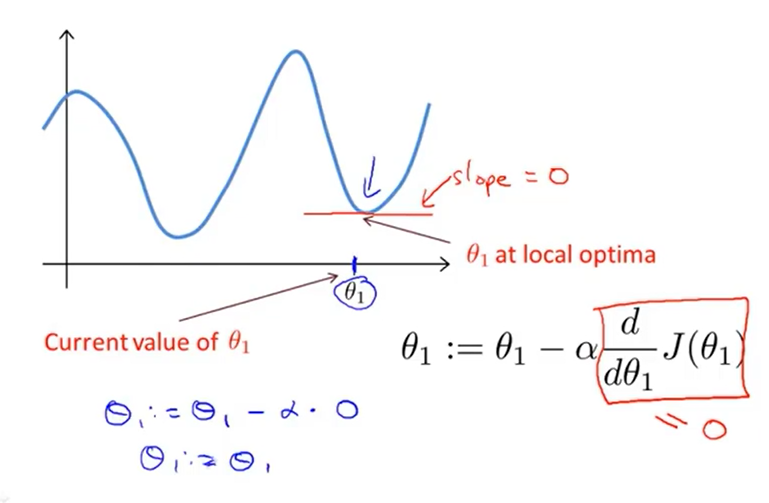

如果參數值已是局部最優,進行梯度下降計算時導數是0,梯度下降不會作任何操作,參數不改變

?

?

在梯度下過程中無需修改學習率,因為在接近局部最有點時導數項會變小,梯度下降的步幅也會隨之比變小。

?

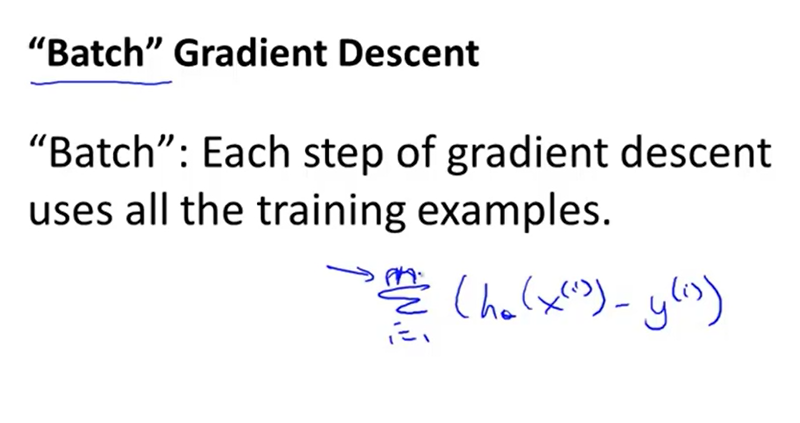

梯度下降中batch:指計算一次梯度下降就使用全部的訓練集數據

mini batch :指計算一次梯度下降時使用了一小部分訓練集數據

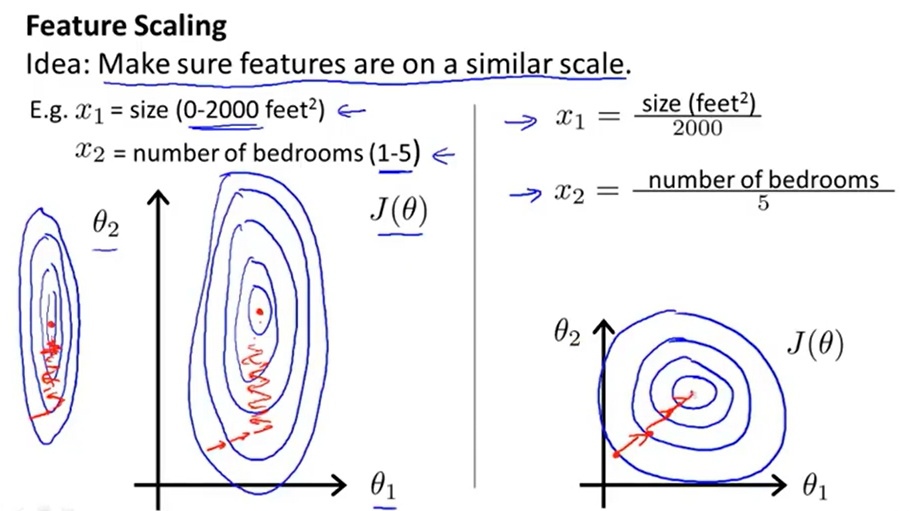

多元特征的梯度下降時,進行特征縮放,可將梯度下降的速度提高,通常將特征的取值縮放至大約-1到1之間

?

?使用小的學習率,一般0.001,0.003,0.01,0.03,0.1,0.3,1等

?

)

第四章存儲體系)

javaScript 篇)

)

打印調試信息無法顯示)

)

)