本文來自DataLearnerAI官方網站:如何提高大模型在超長上下文的表現?Claude實驗表明加一句prompt立即提升效果~ | 數據學習者官方網站(Datalearner) https://www.datalearner.com/blog/1051701947131881

https://www.datalearner.com/blog/1051701947131881

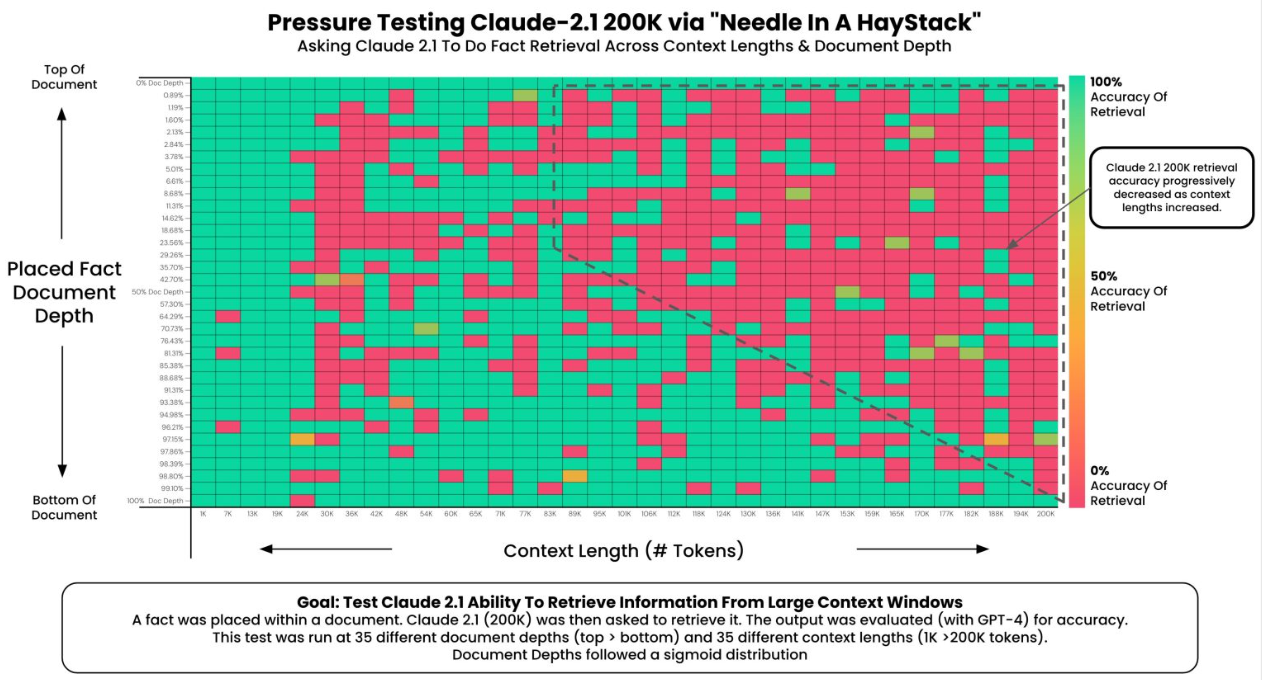

Claude 2.1版本的模型上下文長度最高拓展到200K,也是目前商用領域上下文長度支持最長的模型之一。但是,在模型發布不久之后,有人測試發現Claude 2.1模型在超過20K之后效果下降明顯。但是Anthropic官方發布了一個說明解釋這不是Claude模型本身在超長上下文的真實原因,主要是模型拒絕回答一些與文章主體不符的內容,實際中只需要一句prompt即可提高性能,將模型在超長上下文的水平準確率從27%提高到98%。

- Claude2.1的超長上下文水平簡介

- 模型不愿意回答與文本不相干的內容

- 總結

Claude2.1的超長上下文水平簡介

此前,有用戶通過在超長上下文中注入一段特別的句子讓模型回答用來測試大模型在超長上下文條件的表現(具體測試參考:GPT-4-Turbo的128K長度上下文性能如何?超過73K Tokens的數據支持依然不太好!)。

Claude-2.1-200K推出之后,作者做了同樣的測試,發現Claude-2.1表現非常差:

可以看到,當文檔長度超過20K之后,表現就非常差,與Anthropic官方的說法差別很大。

而今天,Anthropic官方發布了一個博客解釋,這個不是因為Claude模型能力不行,而是測試的方式不太好。

模型不愿意回答與文本不相干的內容

為了減少錯誤和避免提出無依據的聲明,Claude 2.1被訓練成在沒有足夠信息支持回答時不回答問題。這意味著如果文檔沒有提供足夠的信息來明確回答一個問題,模型可能會選擇不作回答。模型的訓練數據可能包括減少不準確性的特定任務。如果模型在訓練過程中接收到避免錯誤和不準確聲明的強烈信號,它可能會在實際應用中表現出更多的謹慎。進而導致上述情況出現。

而進一步的,Anthropic發現可以通過簡單的prompt提示就可以提高模型不愿意回答不相關內容的效果,即讓模型回答問題之前,加上一句“Here is the most relevant sentence in the context:”即可大幅提升模型回答效果,改進模型不愿意回答不相關內容的水平。

)

)

擴展函數和運算符重載)

五種最新算法(SWO、COA、LSO、GRO、LO)求解無人機路徑規劃MATLAB)

)

![[足式機器人]Part2 Dr. CAN學習筆記-數學基礎Ch0-5Laplace Transform of Convolution卷積的拉普拉斯變換](http://pic.xiahunao.cn/[足式機器人]Part2 Dr. CAN學習筆記-數學基礎Ch0-5Laplace Transform of Convolution卷積的拉普拉斯變換)