前言

? ? ? ? ? ? ? ? 現實強化學習任務面臨的狀態空間往往是連續的,無窮多個。

這里主要針對這種連續的狀態空間處理。后面DQN 也是這種處理思路。

目錄:

? ?1: 原理

? ?2: 梯度更新

? ?3: target 和 預測值

? ?4? ? ?流程

一 原理

? ? ? ?強化學習最重要的是得到?值函數,或者動作-狀態值函數,

? 根據值函數可以得到最優策略。

? ?當狀態空間為連續的時候,表達為狀態的線性函數

? ? ?

? ? ?x:狀態向量

? ??: 向量參數

? ? ? ? 我們希望通過上面公式學得的值函數盡可能接近真實的,近似度經常用最小二乘誤差度量

? ?

??? 表示由策略采樣得到的狀態上的期望

二? 梯度更新

? ? ?為了使得誤差最小,采用梯度下降法,對誤差求梯度導數

? ? ??

? ? ?于是可得到對于單個樣本的更新規則

? ? ?

三 預測值 和? target?

? ? ?我們并不知道策略的真實值函數?,可以借助時序差分學習,

基于??用當前估計的值函數替代真實的值函數,

?則

? ?

? ? ? ?

? ? ? ?在時序差分學習中,需要 狀態-動作函數以獲取策略,這里一種簡單的做法

是令?作用于狀態和動作的聯合向量上,例如給狀態向量增加一維用于存放

動作編號,,另一種做法是對動作變量a 進行one-hot 編碼,再合并到x.

?

? ?訓練的時候:

? ? ?預測值:?

? ? ?target:? ?

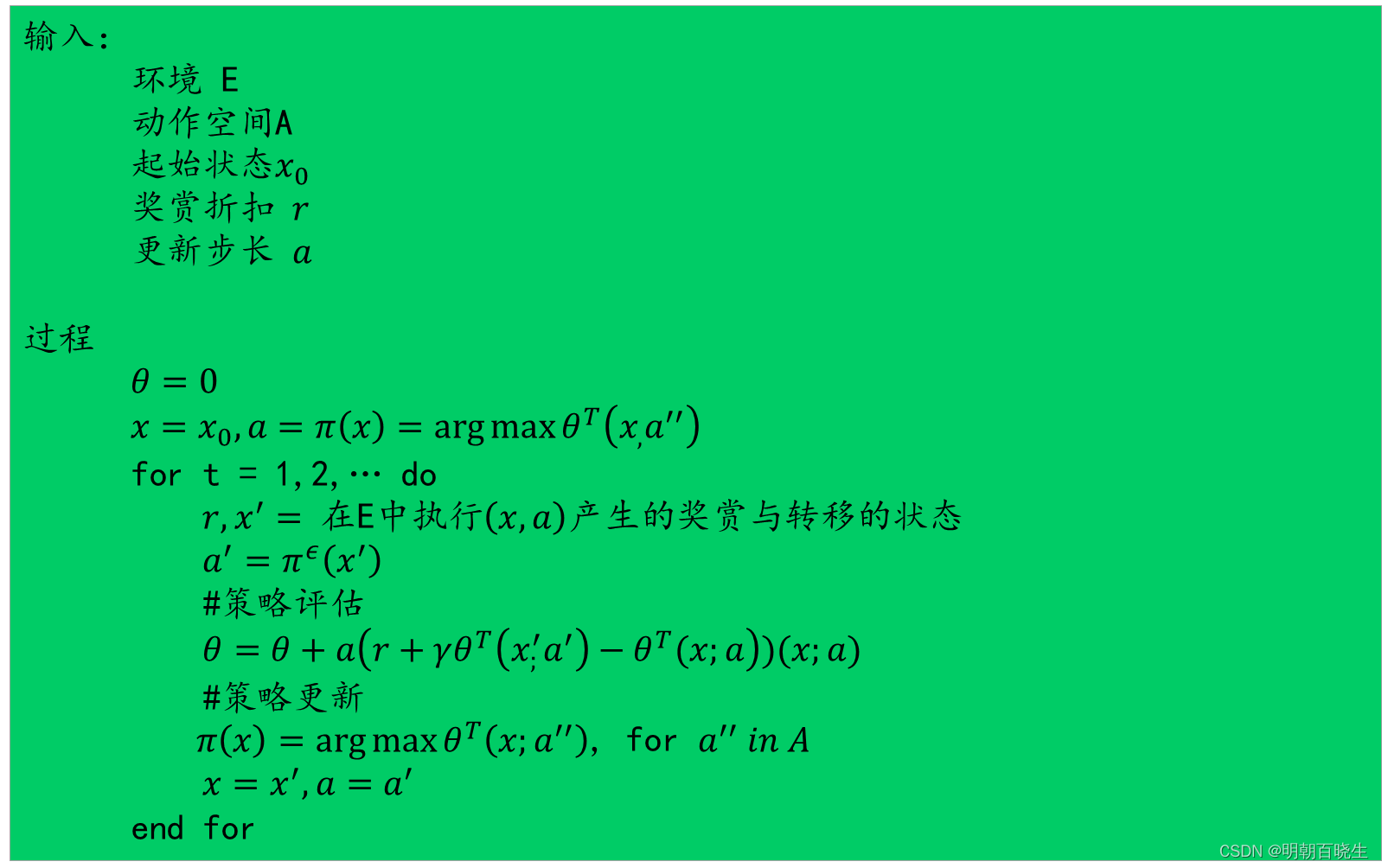

四? 流程

? ?

?

? ?

)

向下偏移)

銷售出庫審核-v))

Centos7下搭建Android開發環境及Android真機調試)

)

)