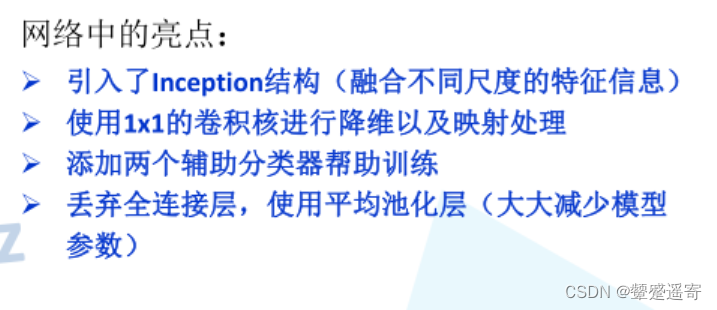

一、亮點

AlexNet、VGG都只有一個輸出層。googlenet有三個(其中兩個是輔助分類層)

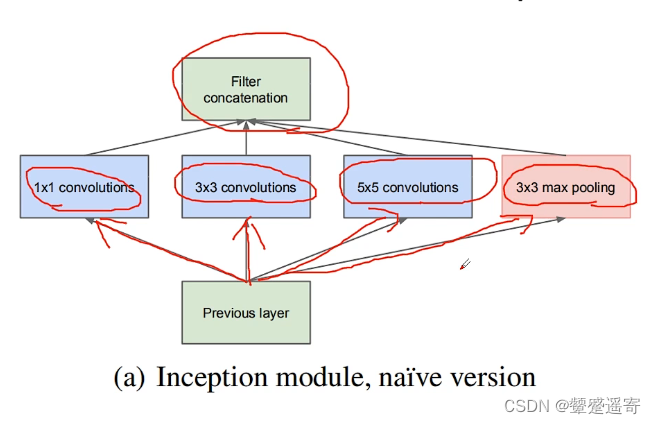

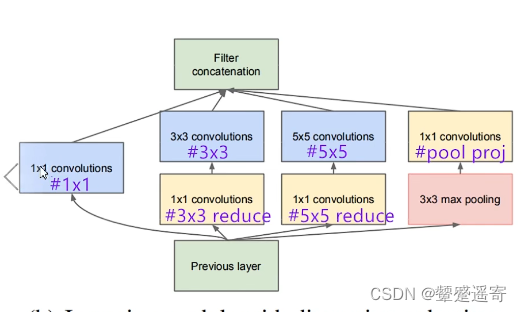

二、先看看Inception結構

1、Inception

之前的網絡:

AlexNet、VGG都是串行結構

Inception:

并行結構

上一層的輸出同時傳入四個并行結構:

得到四個特征矩陣

而后按深度進行拼接、得到輸出層

注意:每一個分支所得到的特征矩陣必須高緯度和寬維度相同

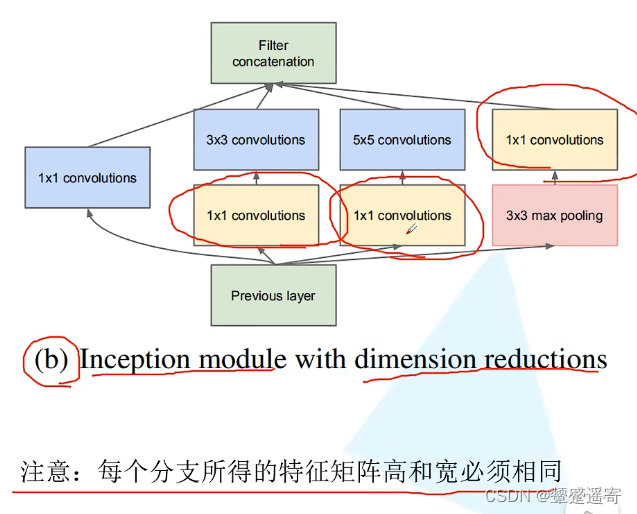

2、Inception+降維

多了三個1×1的卷積層

起到降維作用

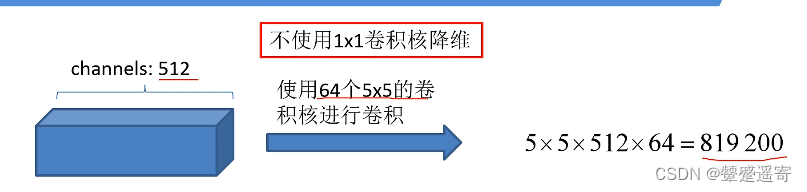

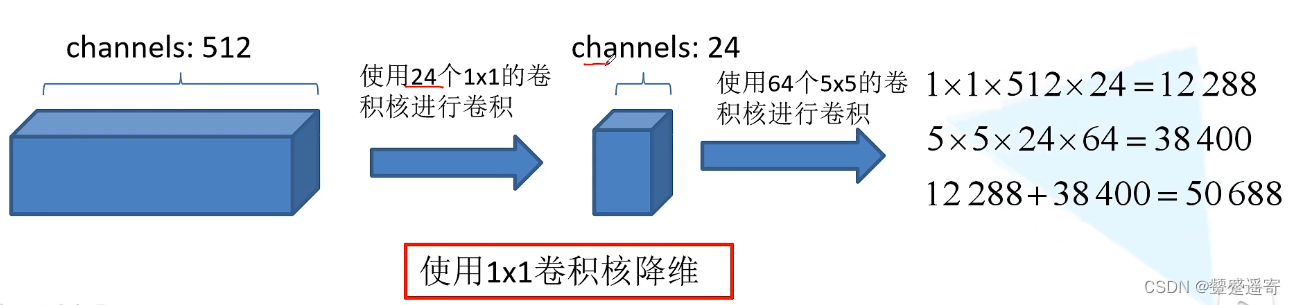

3、1×1的降維作用:

不使用1×1卷積核降維:參數計算量

使用1×1降維計算量:

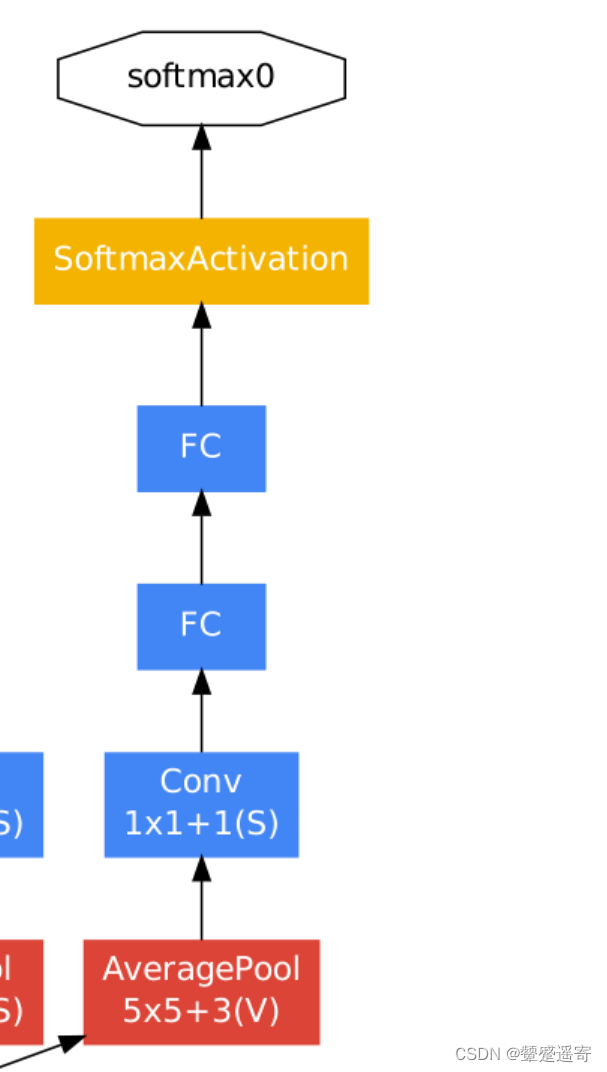

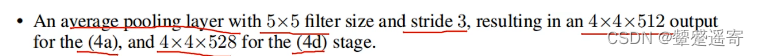

4、輔助分類器

第一層:

平均池化下采樣

池化核大小5×5、步長為3、

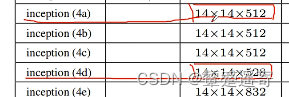

兩個分類器分別來自4a和4d。長寬一樣但深度不同一個512、一個528.

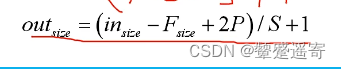

根據計算公式

其中輸入為14、池化核大小為5、padding為0

步長為3

得結果=14

因為池化不改變深度,所以輸出為14×14×512

第二層

使用128個卷積核大小為1×1進行降維、并使用ReLU

第三層

采用節點個數為1024的全連接層、同樣使用ReLU。

第四層

使用drop out 以70%的比例隨機失活神經元

而后全連接層預測1000個類別( 因為ImageNet有1000個類別)

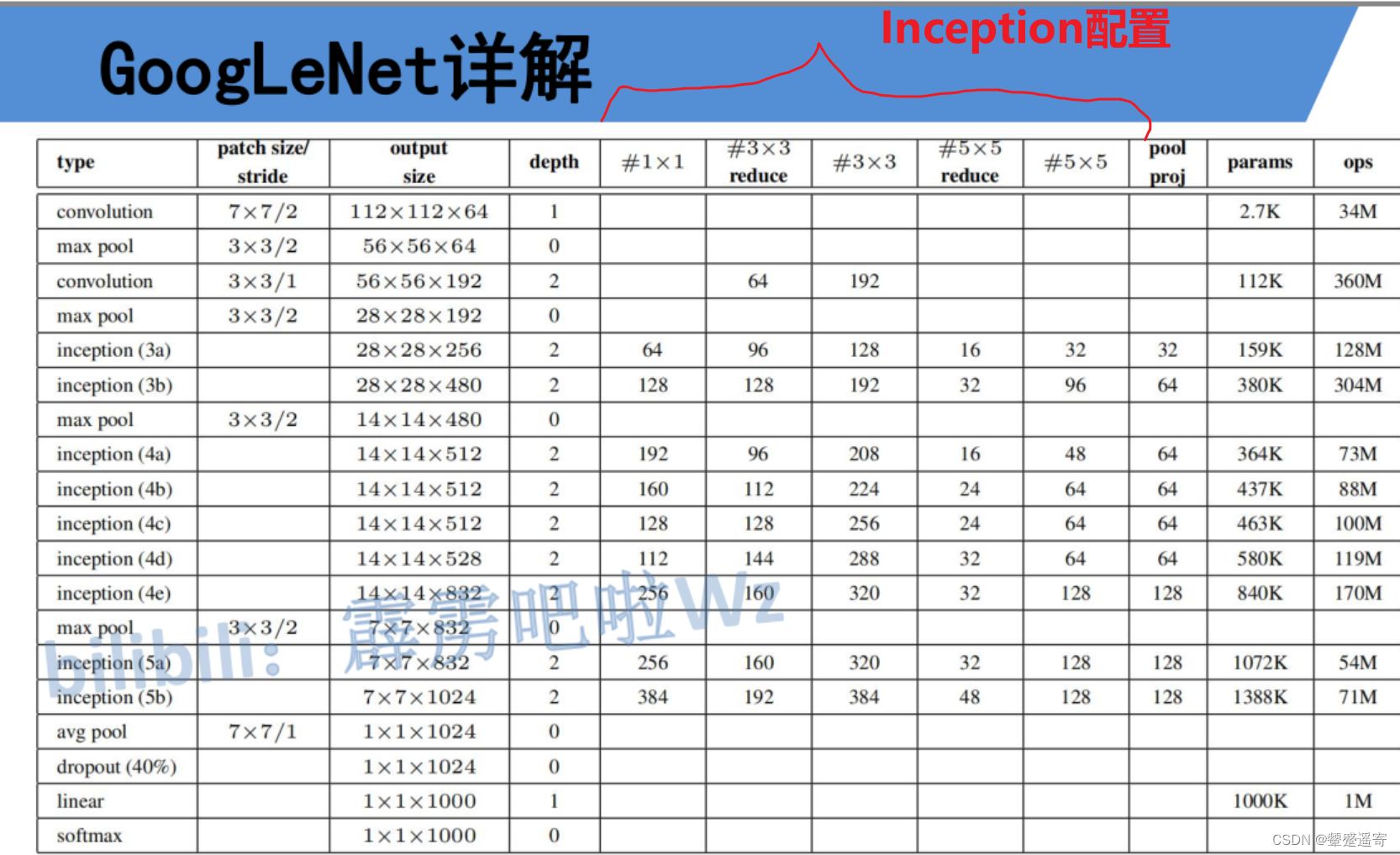

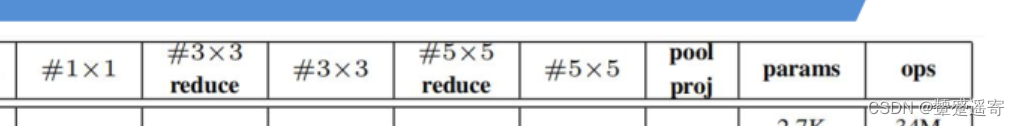

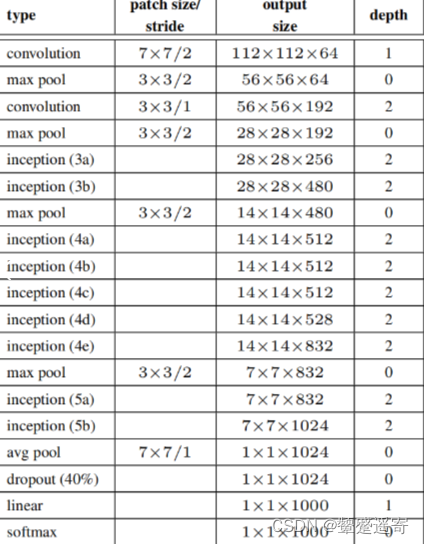

三、看googleNet詳表

#n×n reduce代表 在n×n卷積層之前

加入一個降維處理的1×1卷積

對照 下圖;

我們看到輸入先是經過7×7/2的卷積、3×3/2的池化后

進入一個1×1的卷積和3×3的卷積

因此depth寫了2

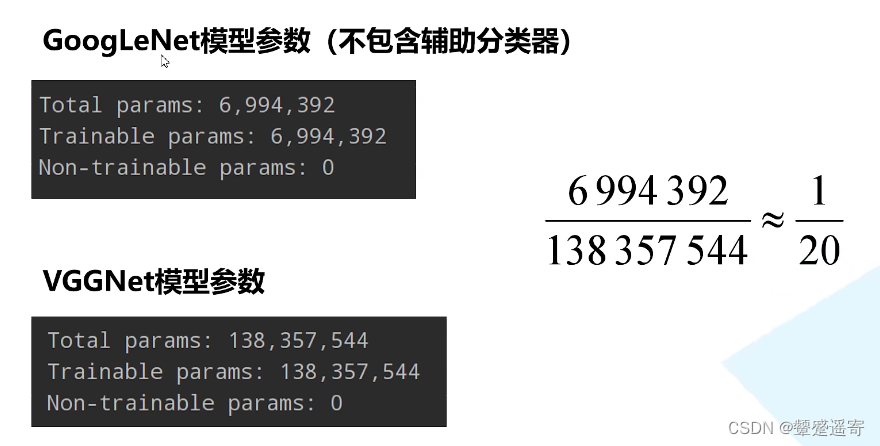

四、參數

模型參數少、準確率高

但是搭建太復雜了。

參考:https://blog.csdn.net/m0_37867091/article/details/107404735

模式)

)

)

)

)

-進程終止)